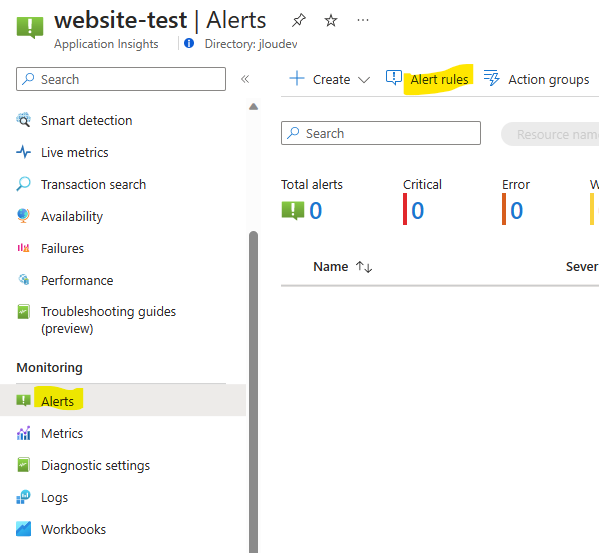

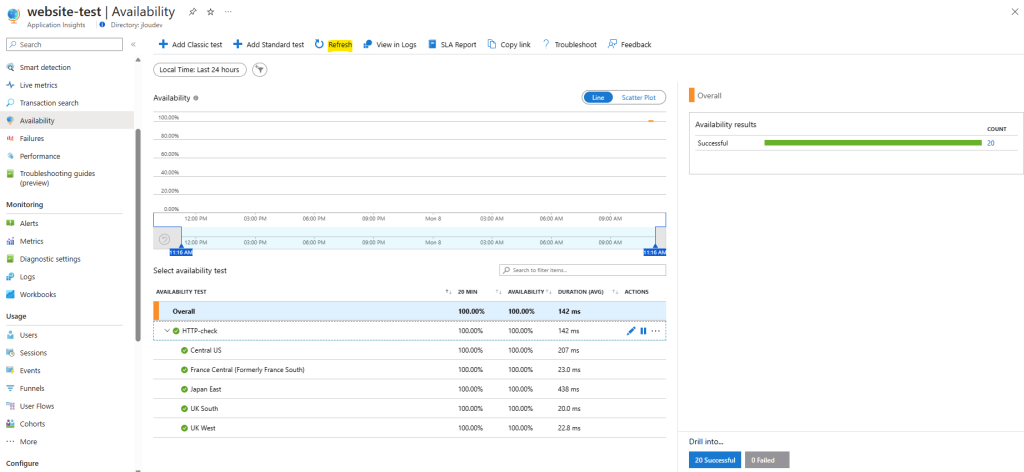

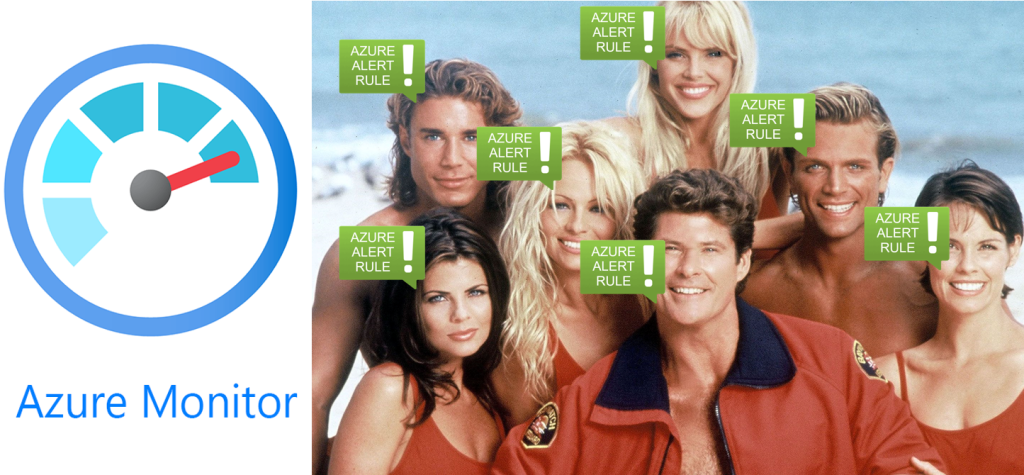

Nombreuses sont les applications critiques et, comme souvent, les équipes IT ont besoin de remontées d’alertes ou de notifications pour résoudre les interruptions de services le plus rapidement possible quand cela se produit. Mais chaque système ou application ne peuvent à eux seul être leur propre système d’alertes. C’est ici qu’intervient Azure Monitor.

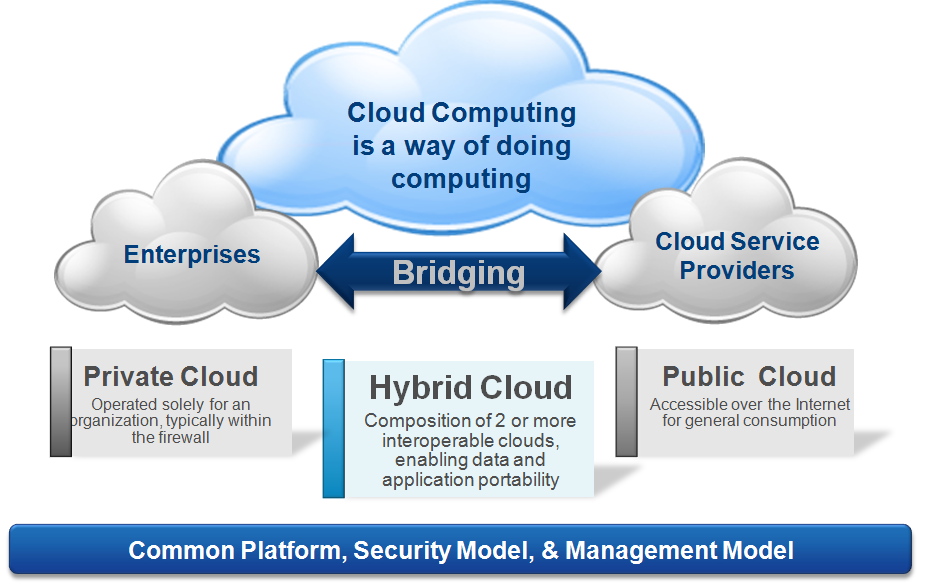

Azure Monitor est une solution de monitoring complète qui permet de collecter et d’analyser des données de télémétrie en vue d’y répondre, à partir de vos environnements cloud et locaux.

Azure Monitor collecte et agrège les données de chaque couche et composant de votre système sur plusieurs abonnements et locataires Azure et non-Azure.

Microsoft Learn

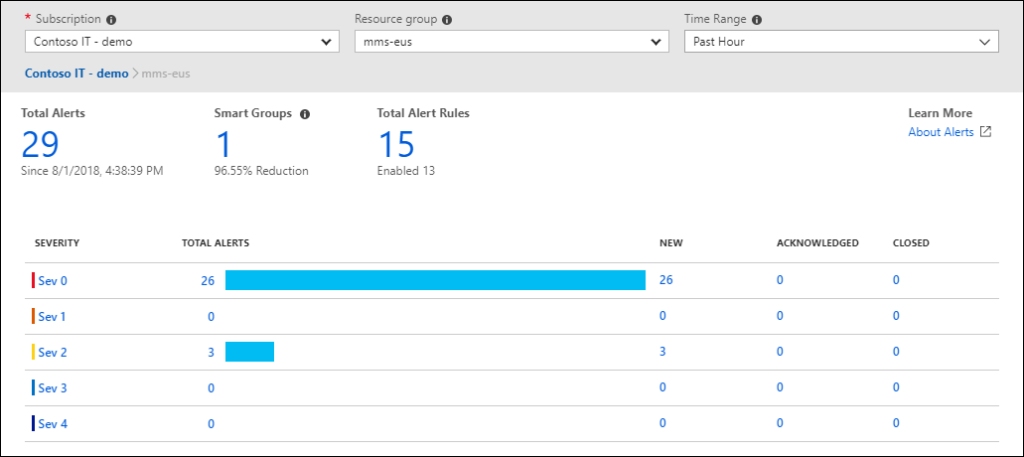

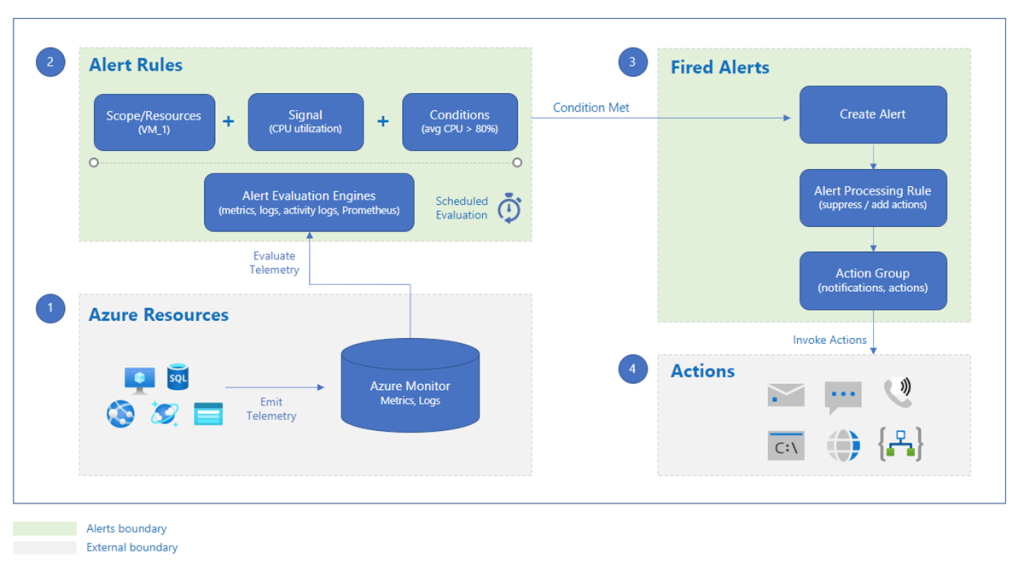

Azure Monitor intègre aussi des règles d’alerte afin de prévenir les personnes concernées de données dépassants certains seuils ou lors d’évènements majeurs :

S’appuyer sur Azure Monitor pour constituer des mécanismes d’alertes, pour les environnements Cloud ou sur site, est une approche pertinente est simplifiera grandement la chaîne des actions correctives qui s’en suit.

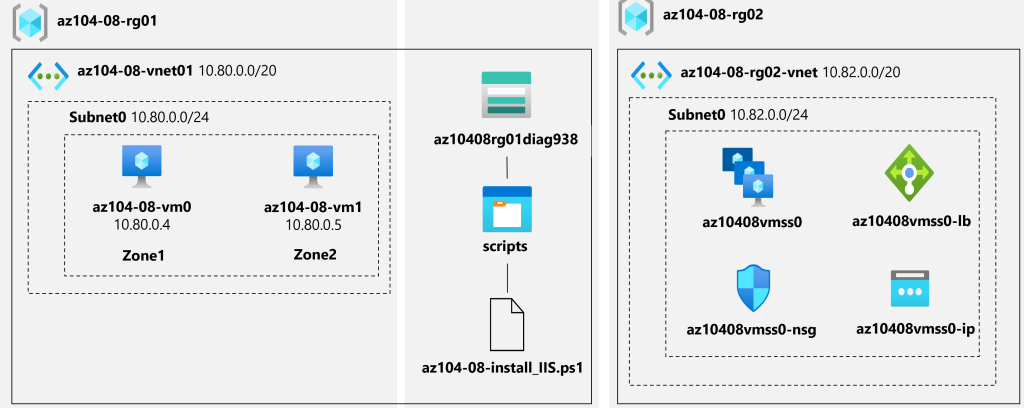

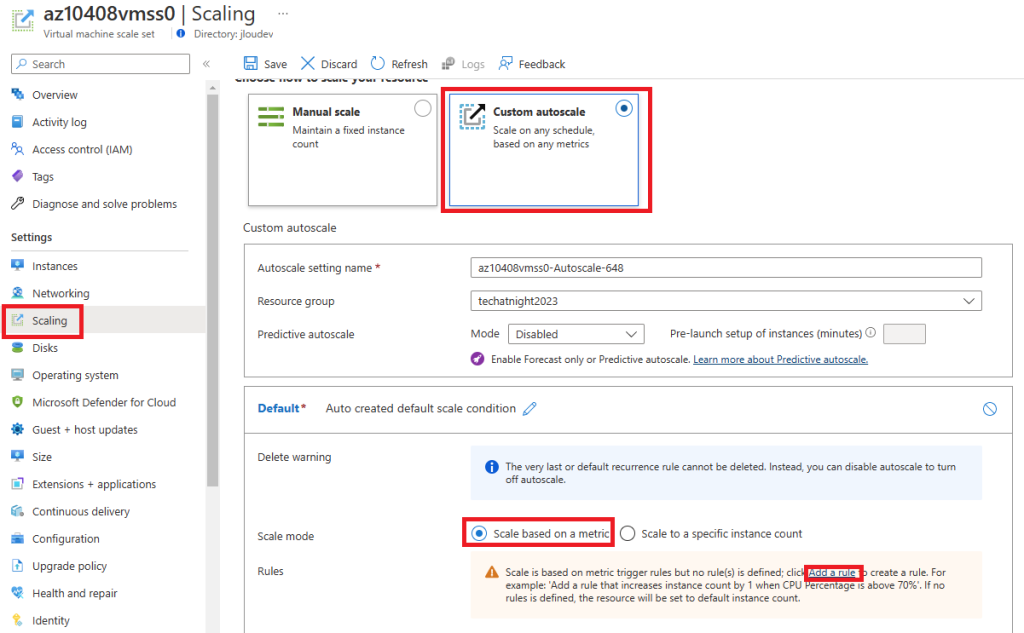

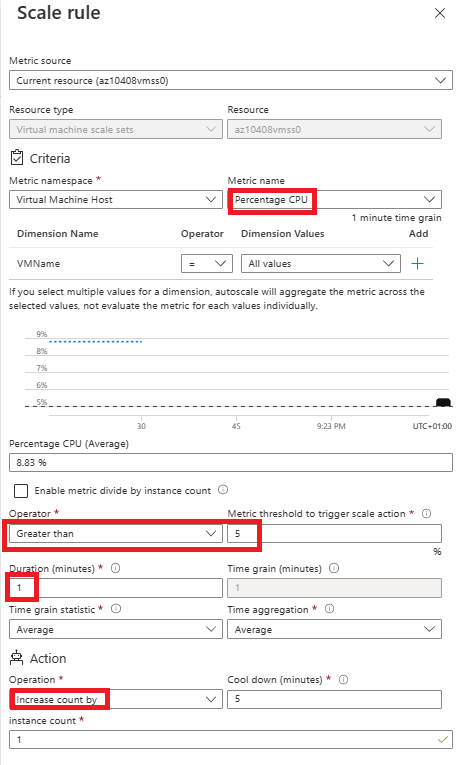

Afin de tester les règles d’alerte d’Azure Monitor sur un cas concret, nous allons créer une machine virtuelle, dans laquelle nous configurons une petite tâche planifiée Windows.

La non-exécution périodique de la tâche planifiée Windows sera le vecteur d’alerte dans Azure Monitor :

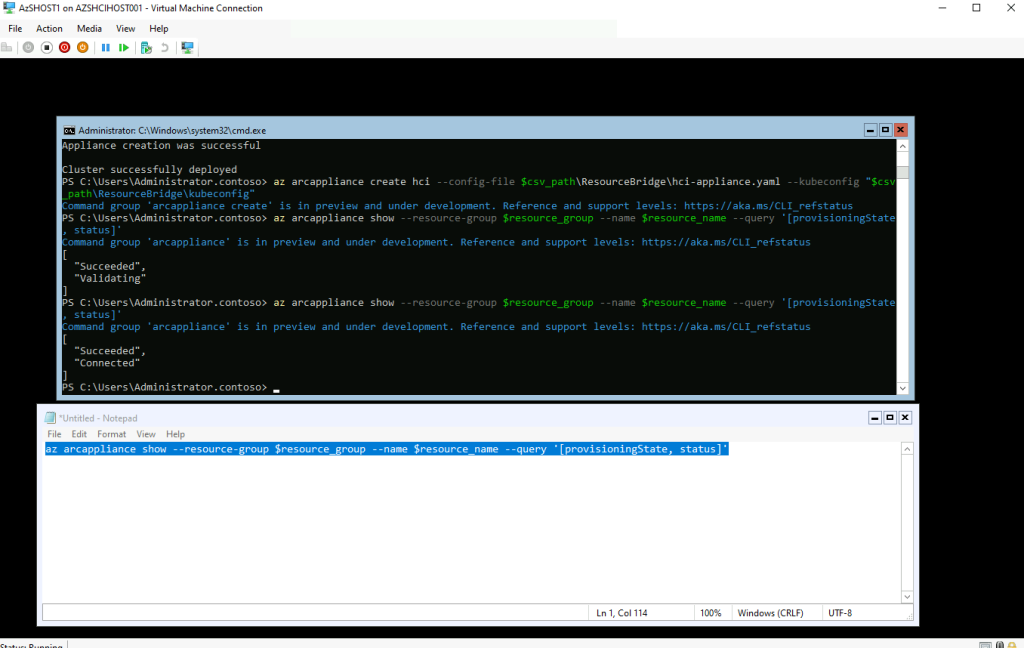

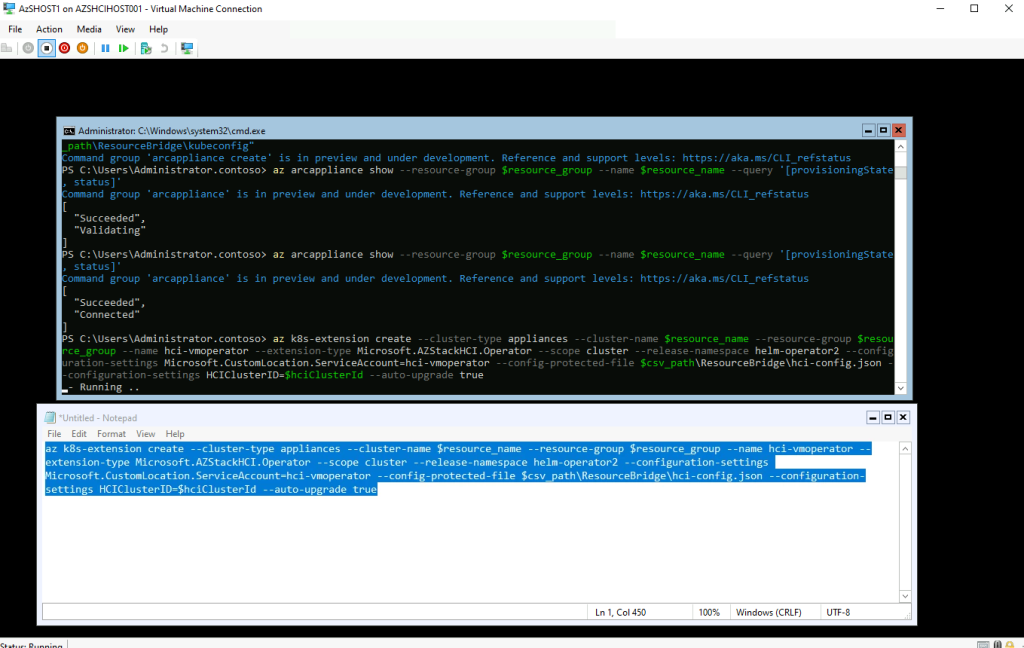

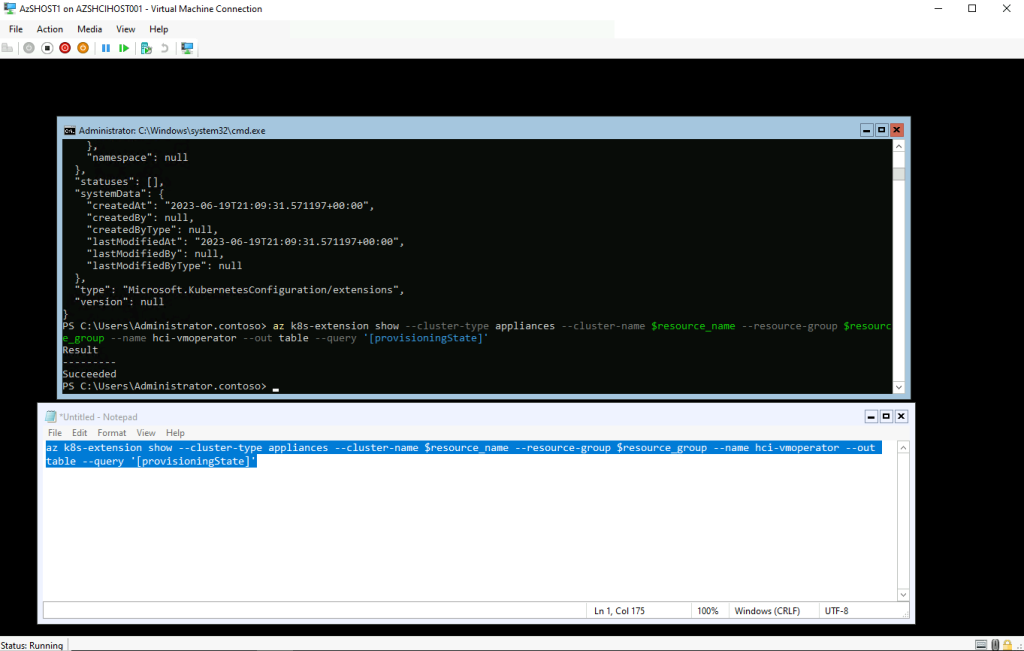

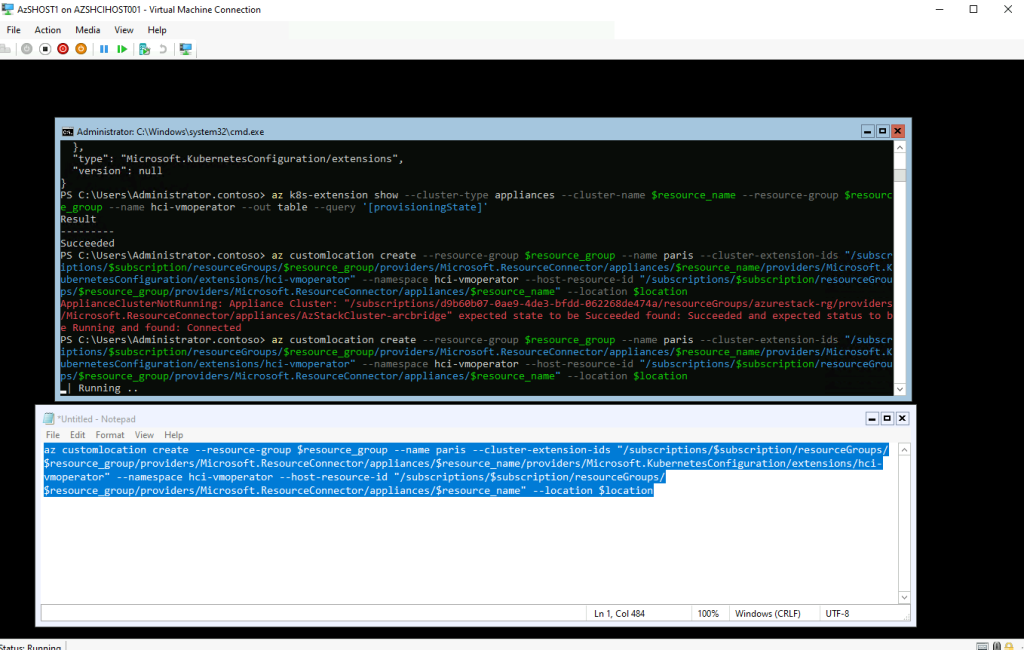

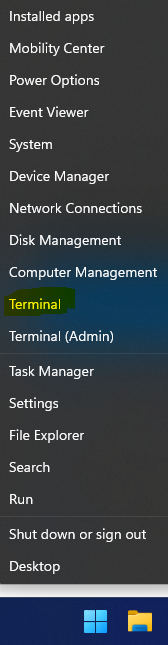

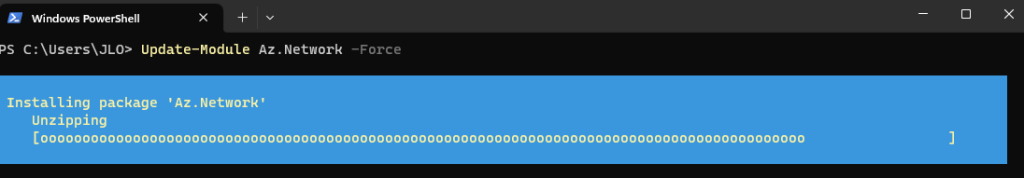

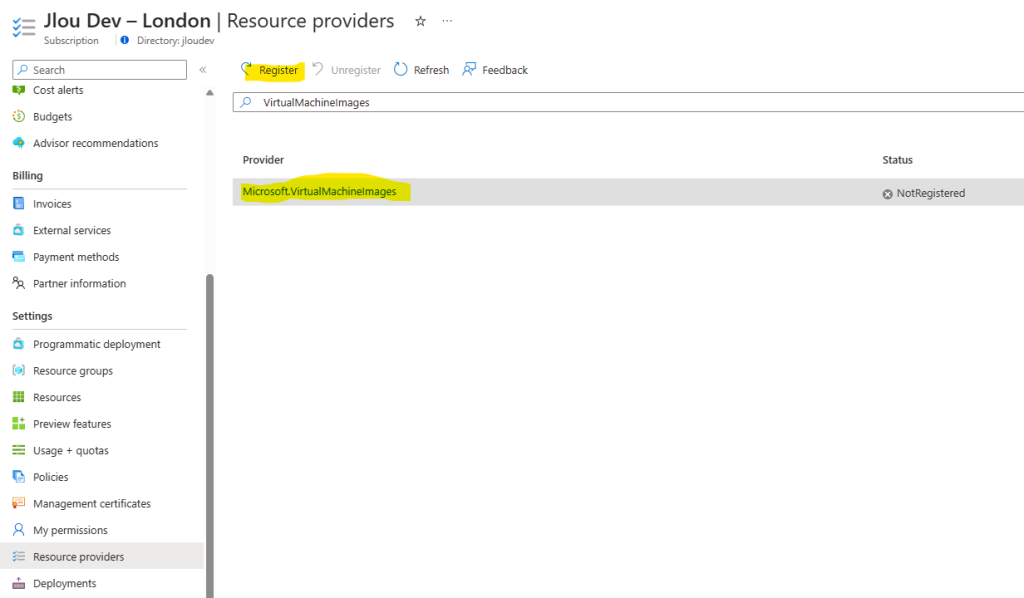

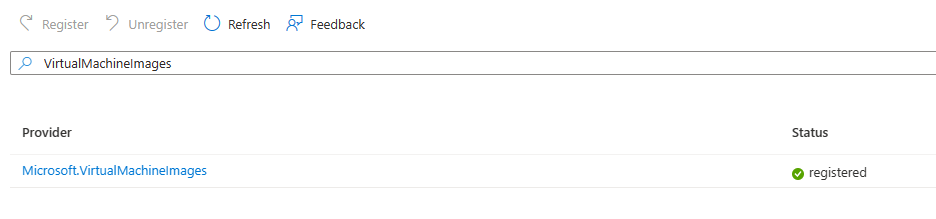

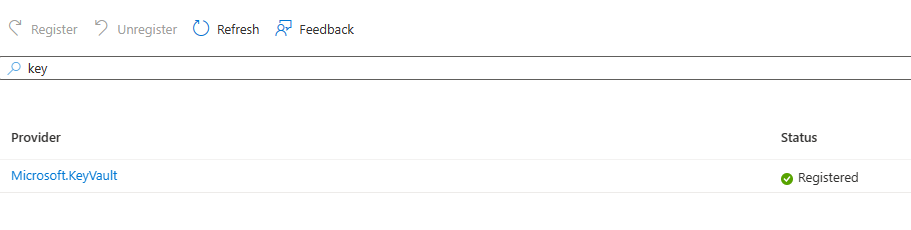

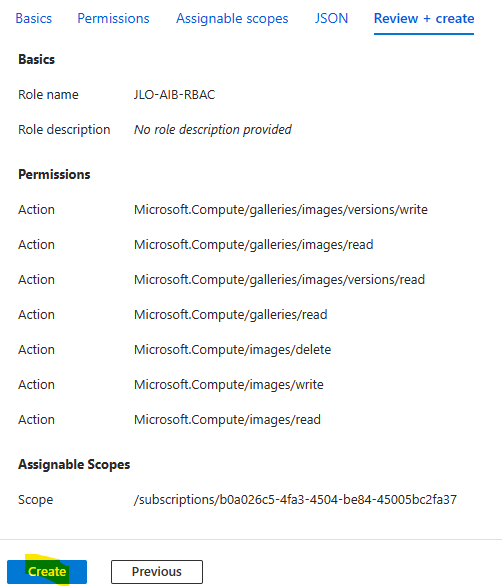

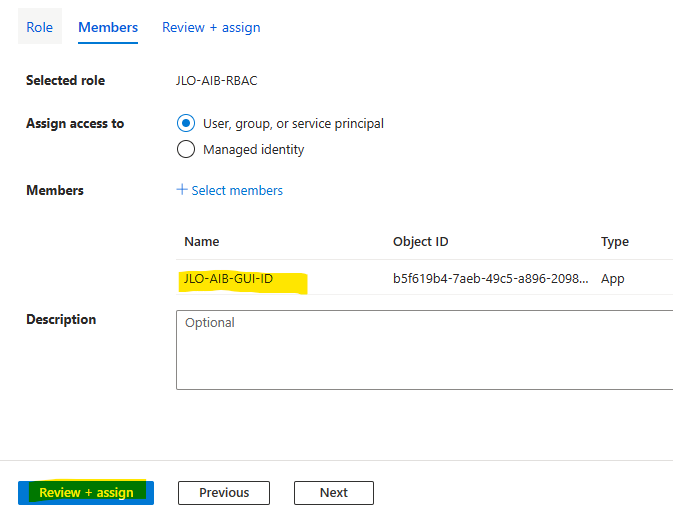

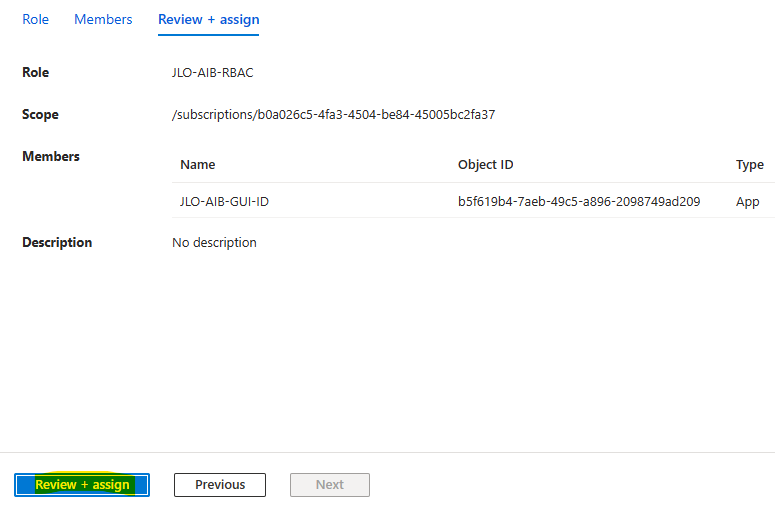

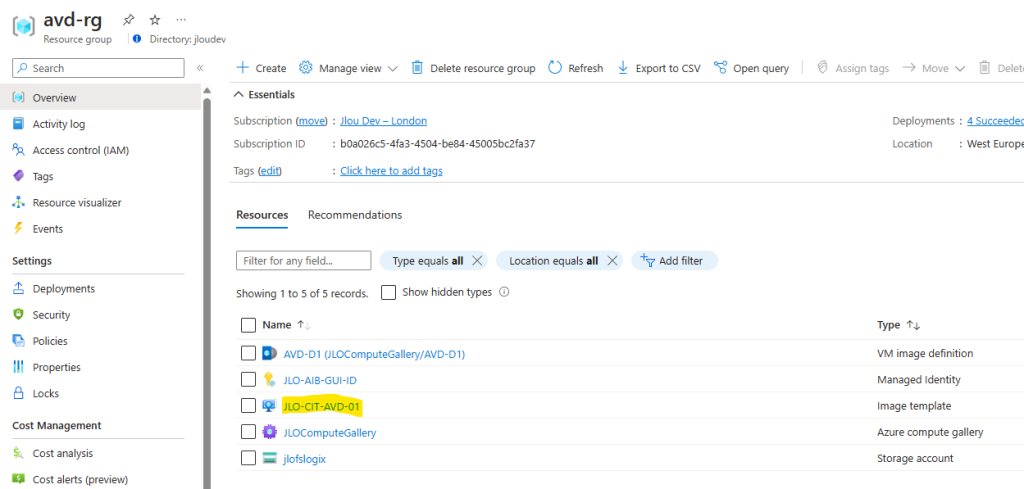

- Etape 0 – Rappel des prérequis

- Etape I – Déployez une machine virtuelle Azure

- Etape II – Configurez une tâche planifiée Windows

- Etape III – Paramétrez la remontée de journaux Windows

- Etape IV – Testez votre remontée grâce à Azure KQL

- Etape V – Créez votre alerte sur Azure Monitor

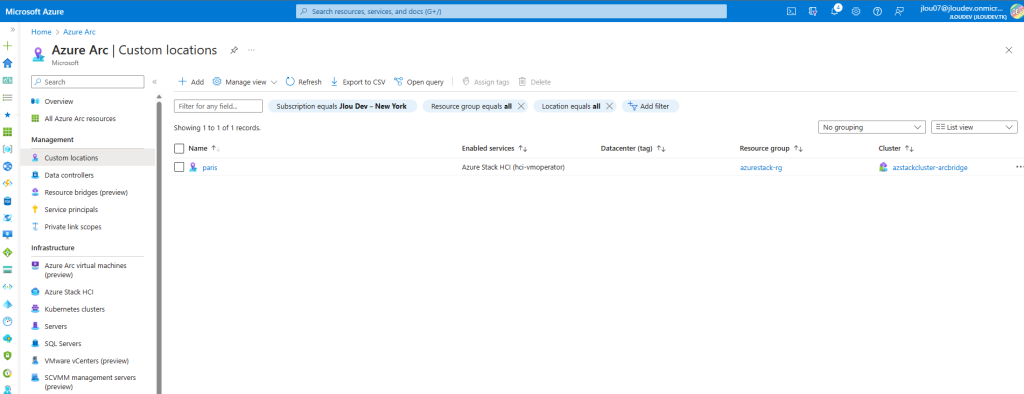

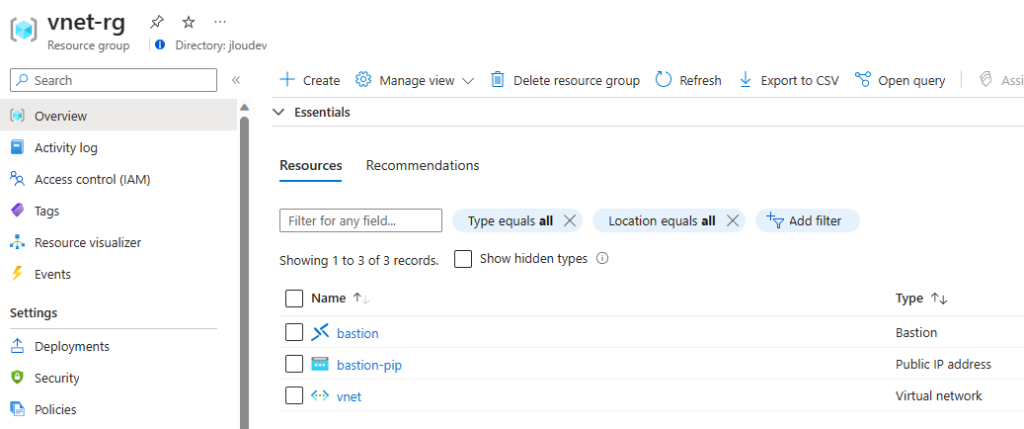

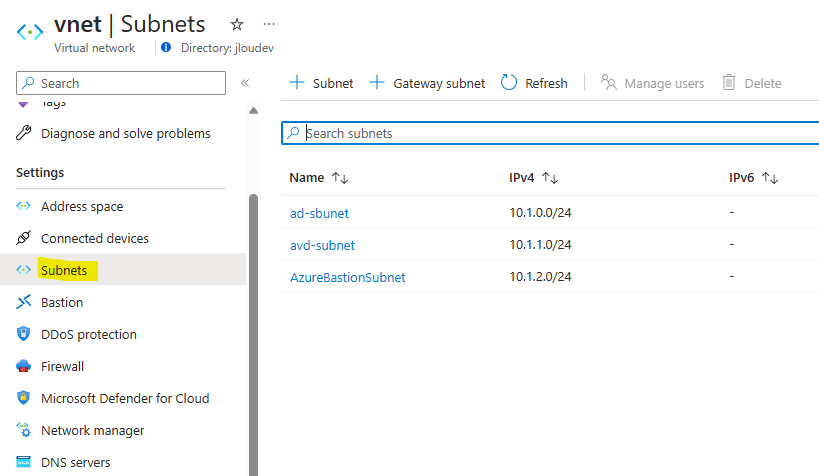

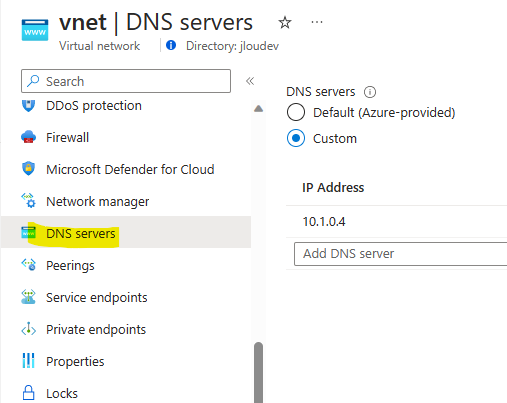

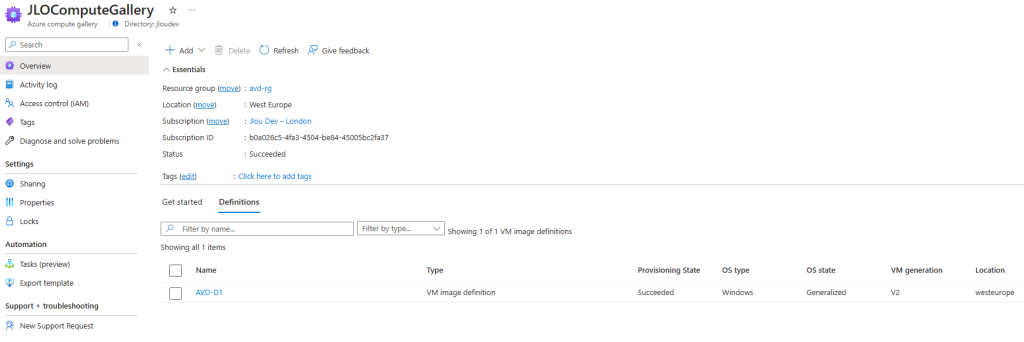

Etape 0 – Rappel des prérequis :

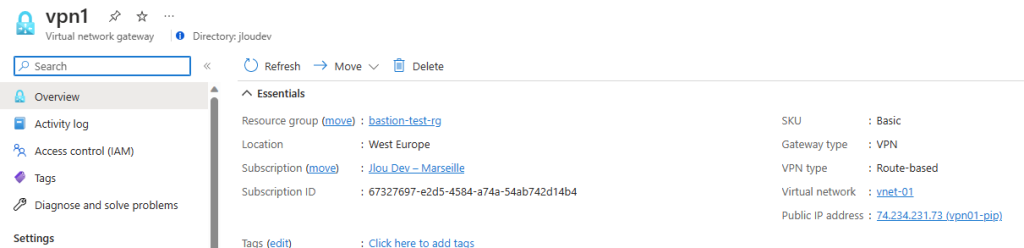

Pour réaliser cet exercice sur les règles d’alerte d’Azure Monitor, il vous faudra disposer de :

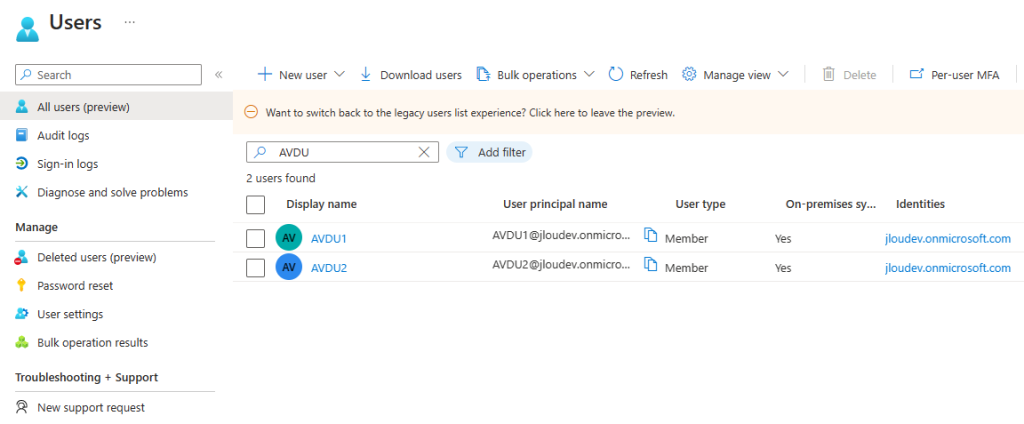

- Un tenant Microsoft

- Une souscription Azure valide

La source de notre alerte sera directement configurée sur une machine virtuelle Azure.

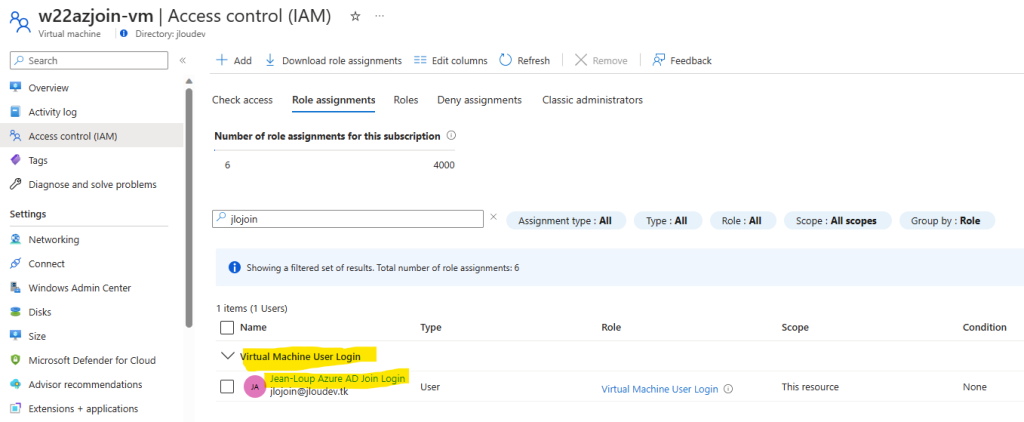

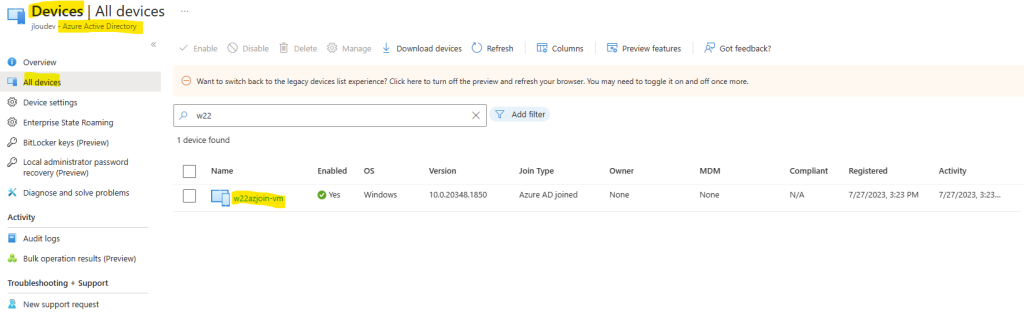

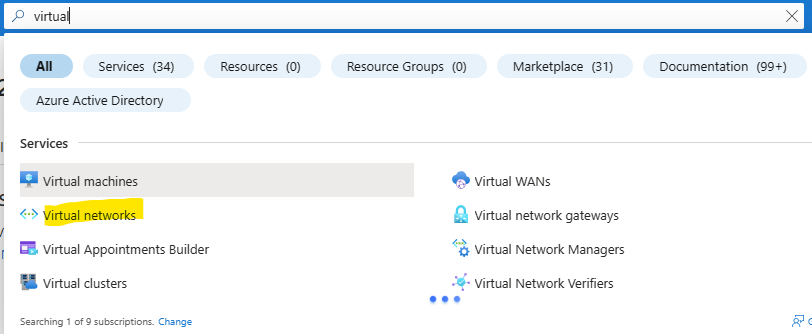

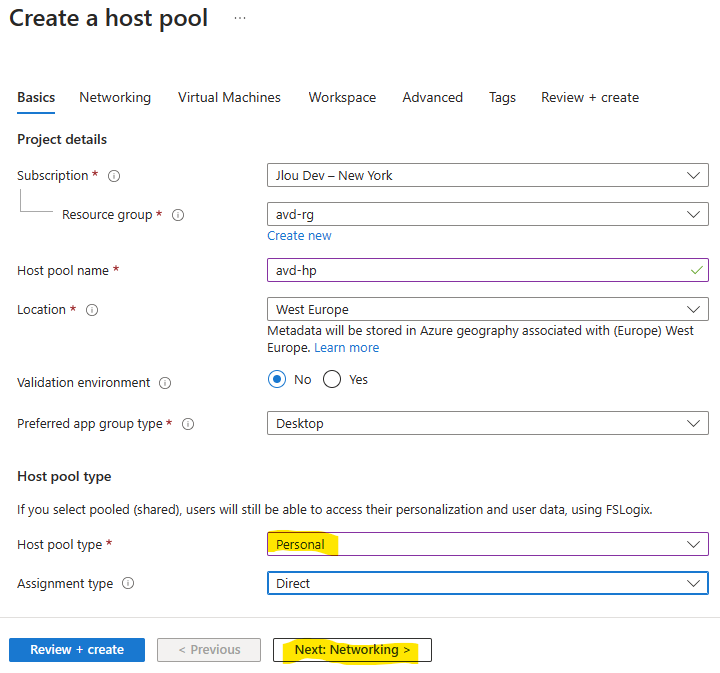

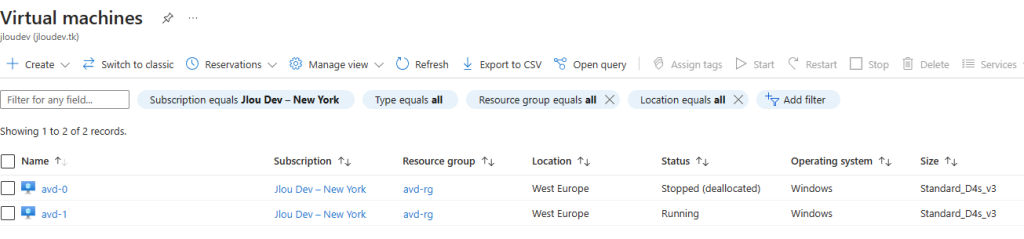

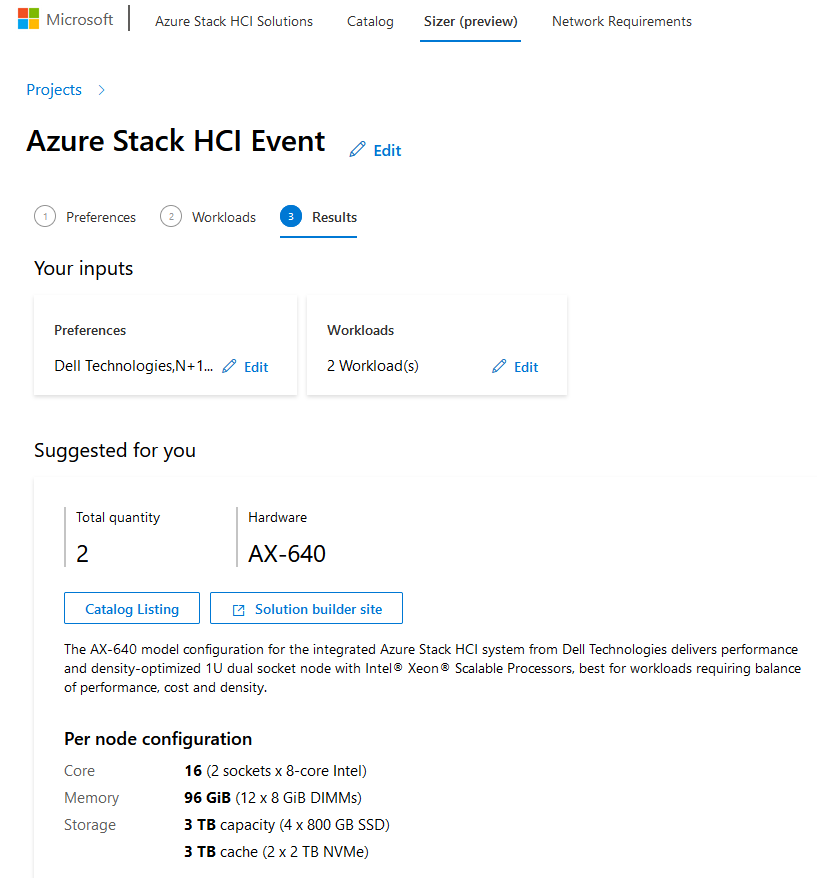

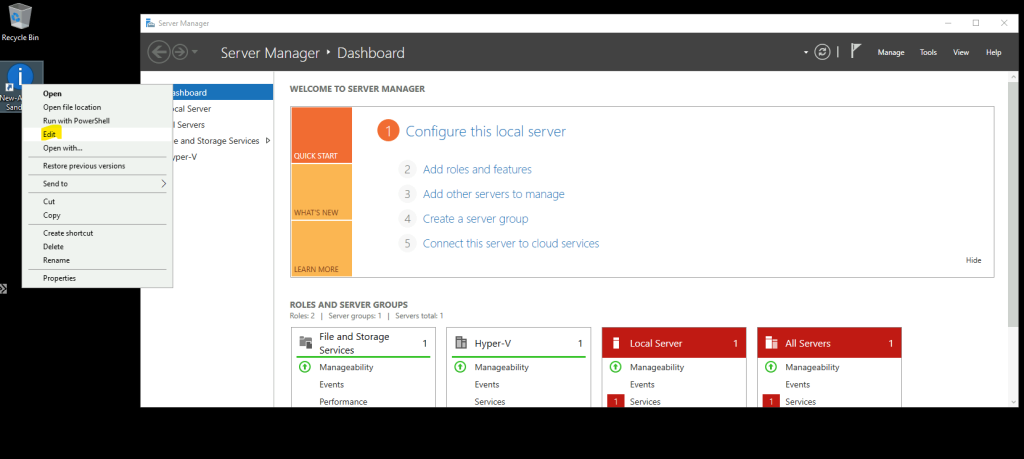

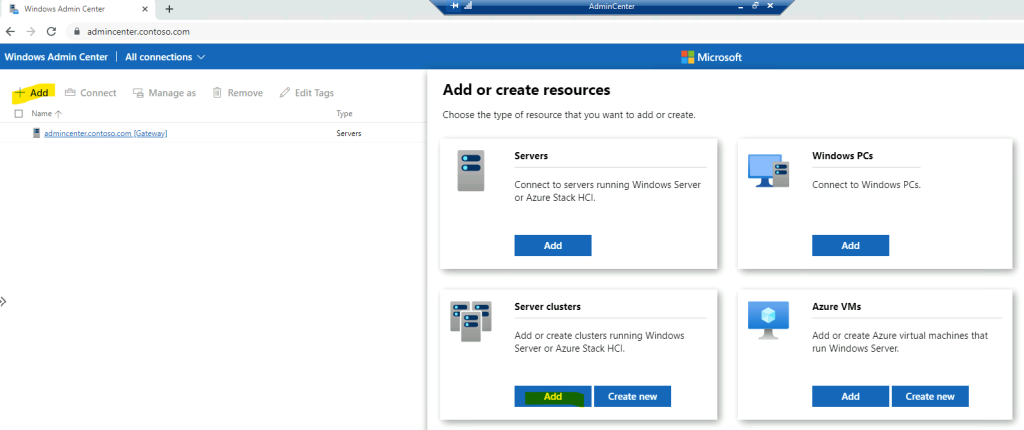

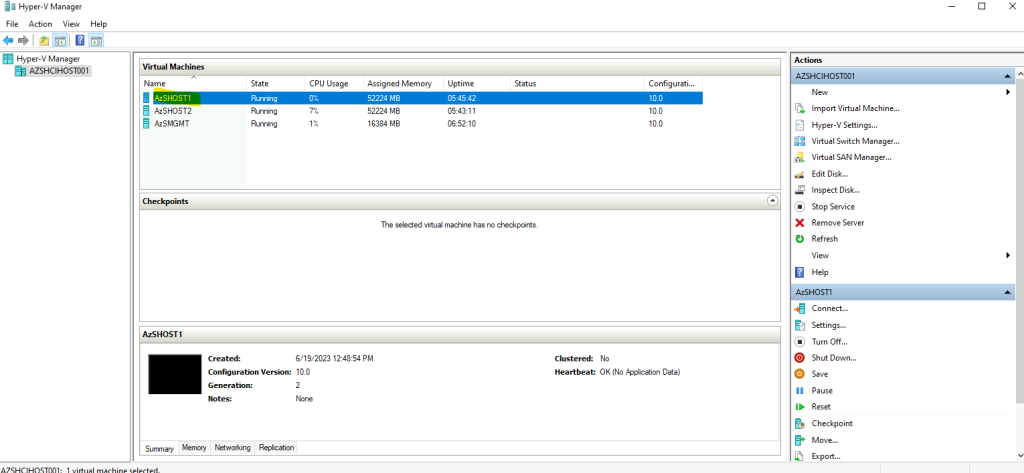

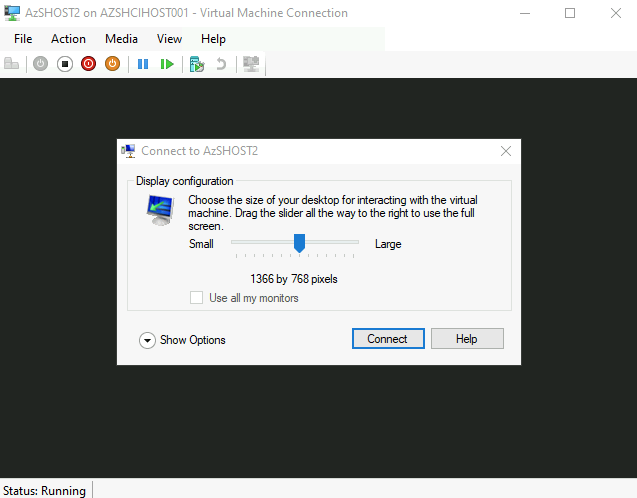

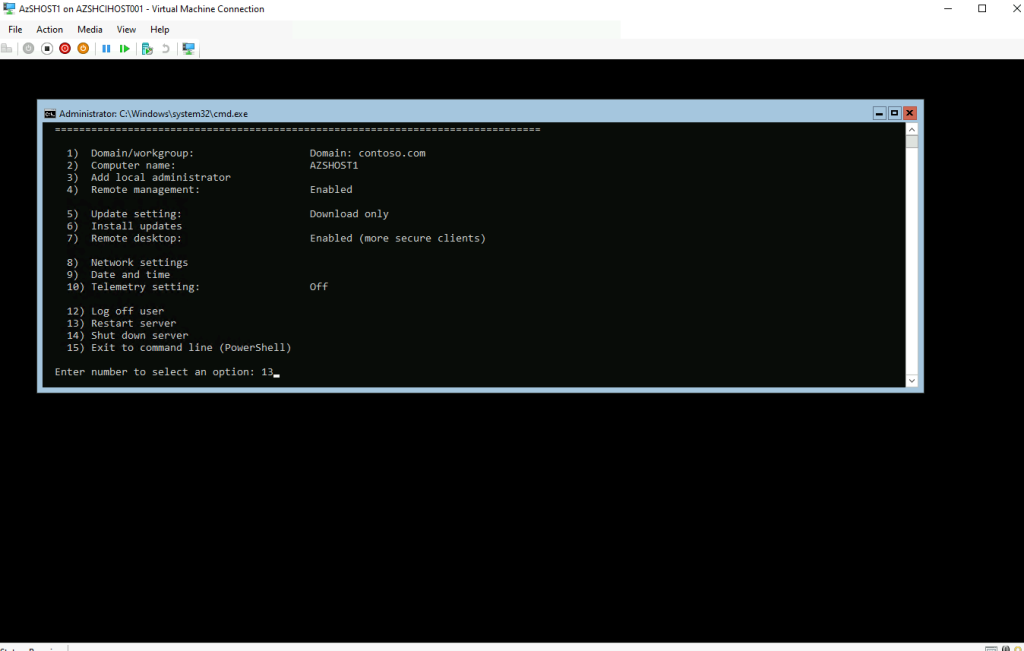

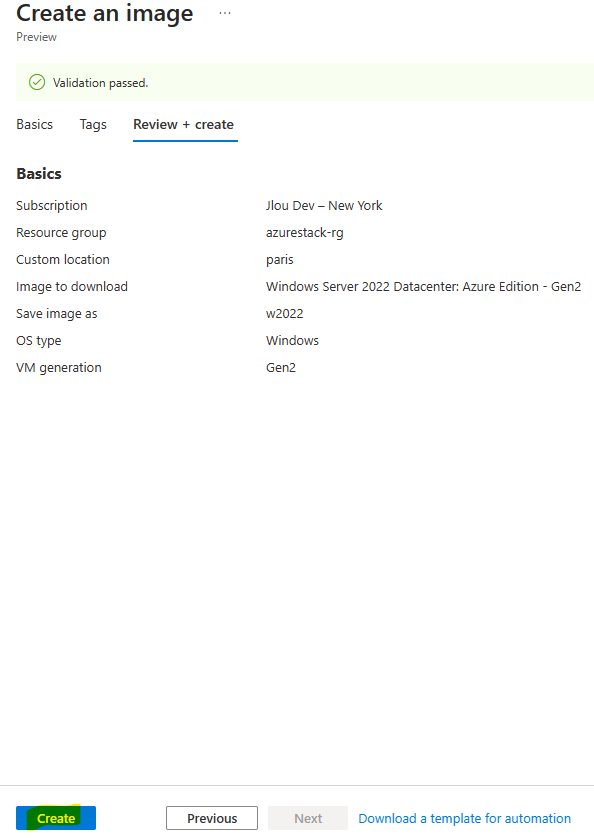

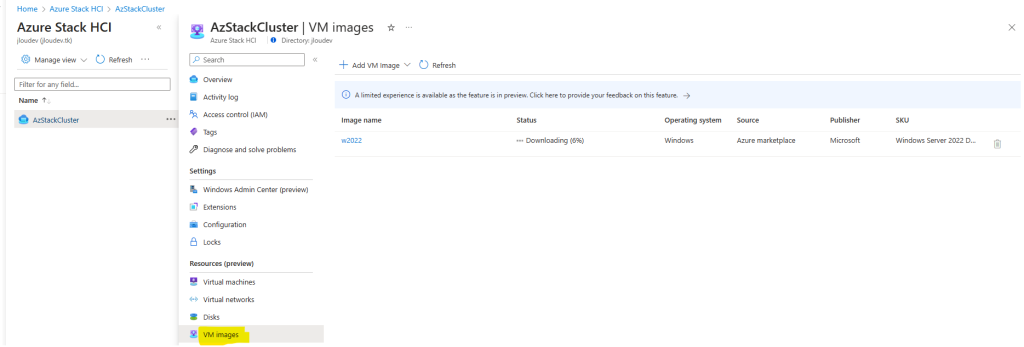

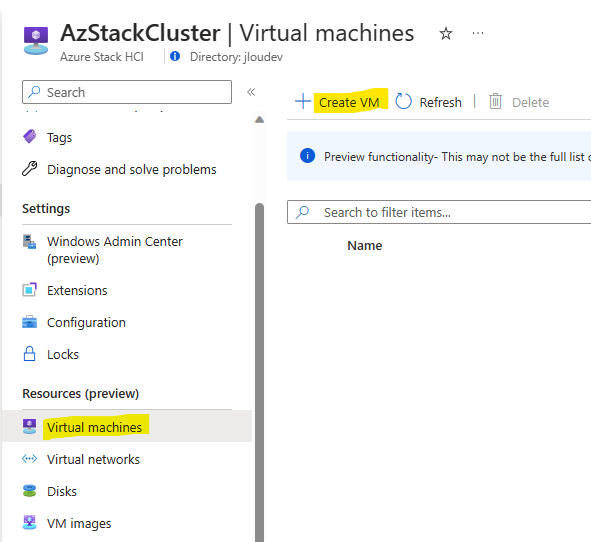

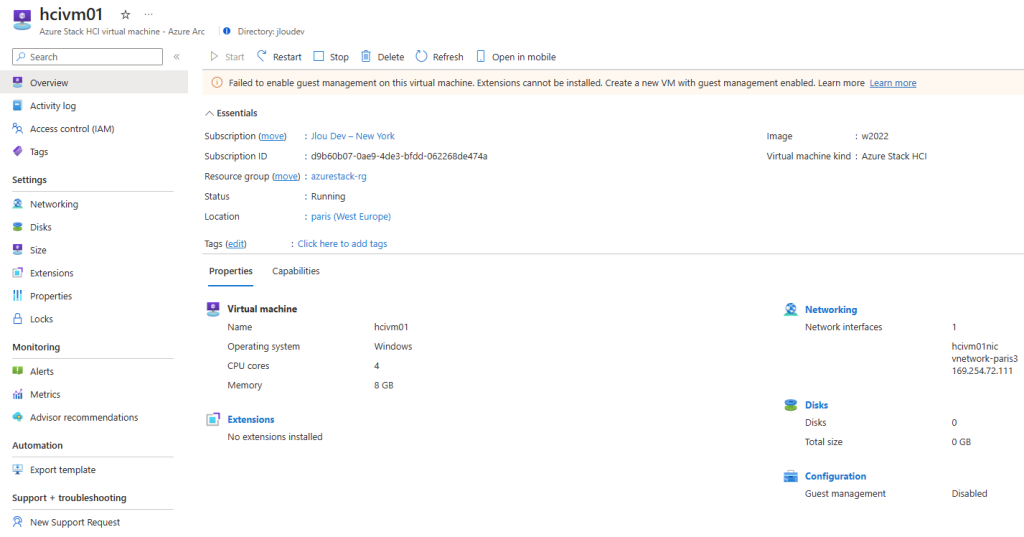

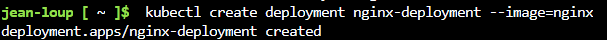

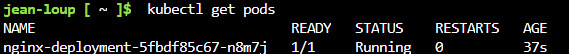

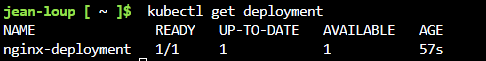

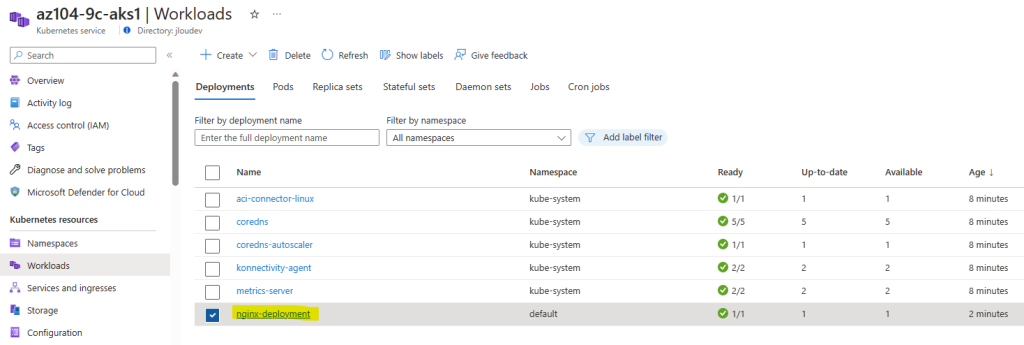

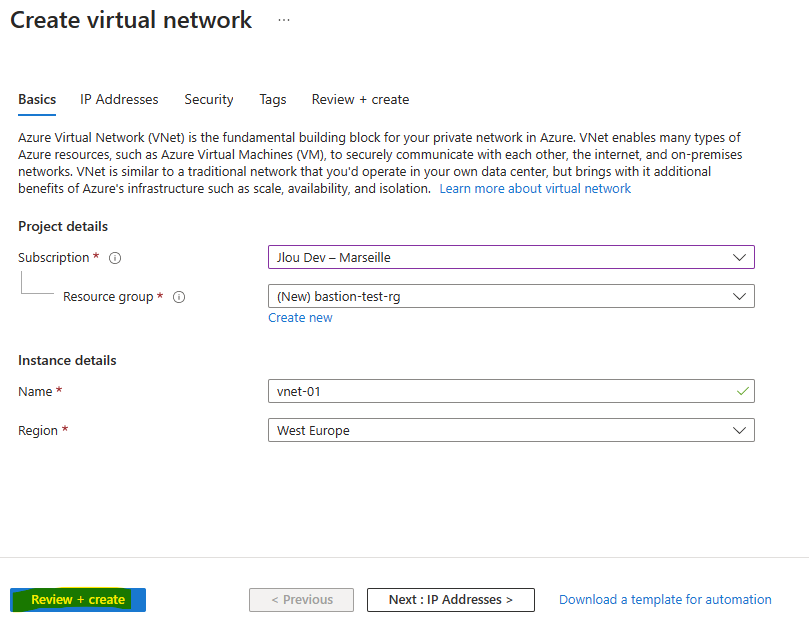

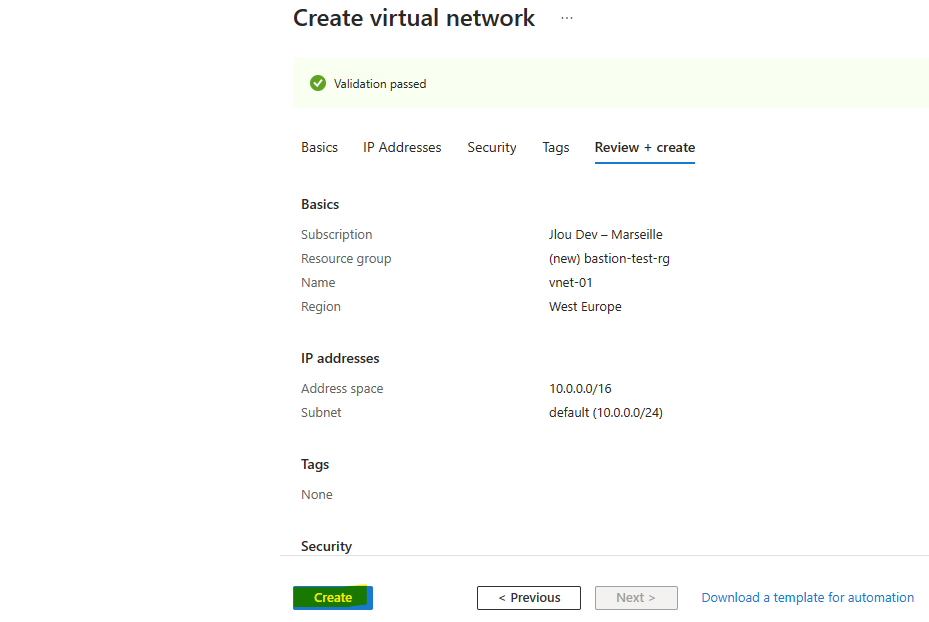

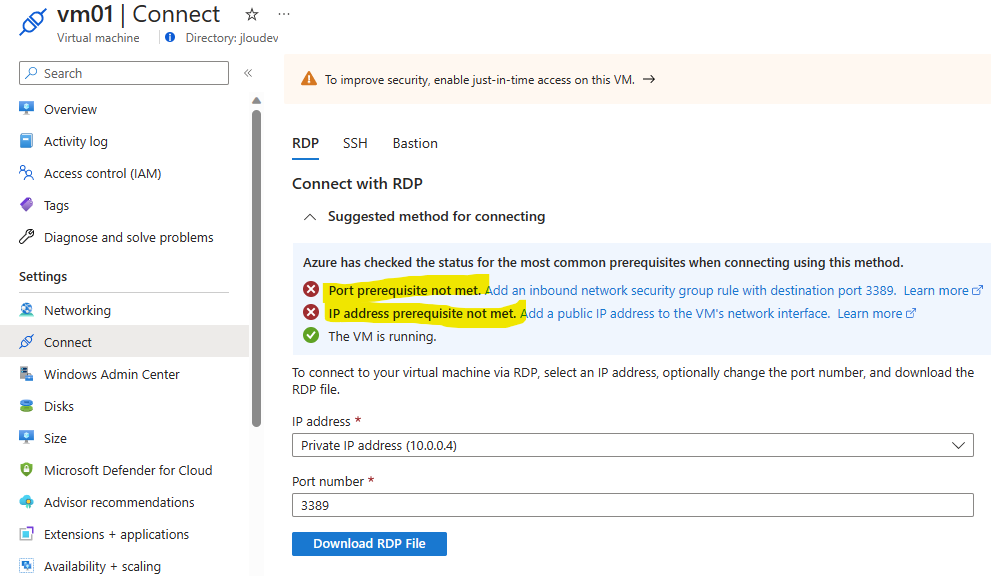

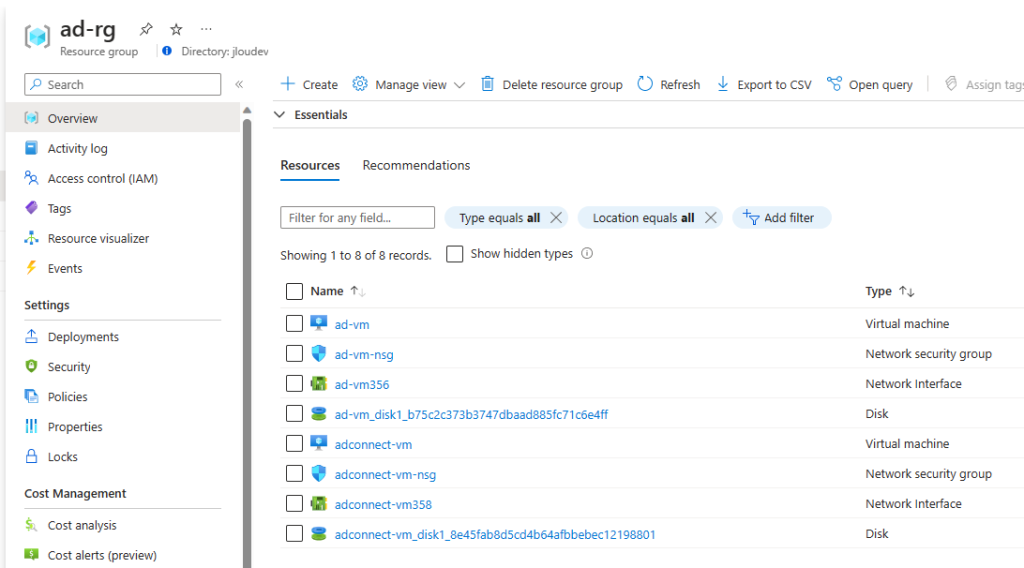

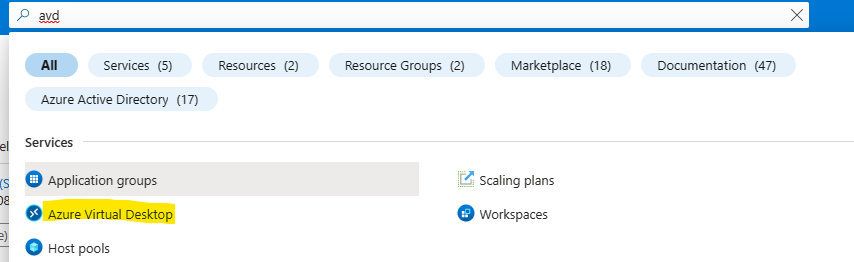

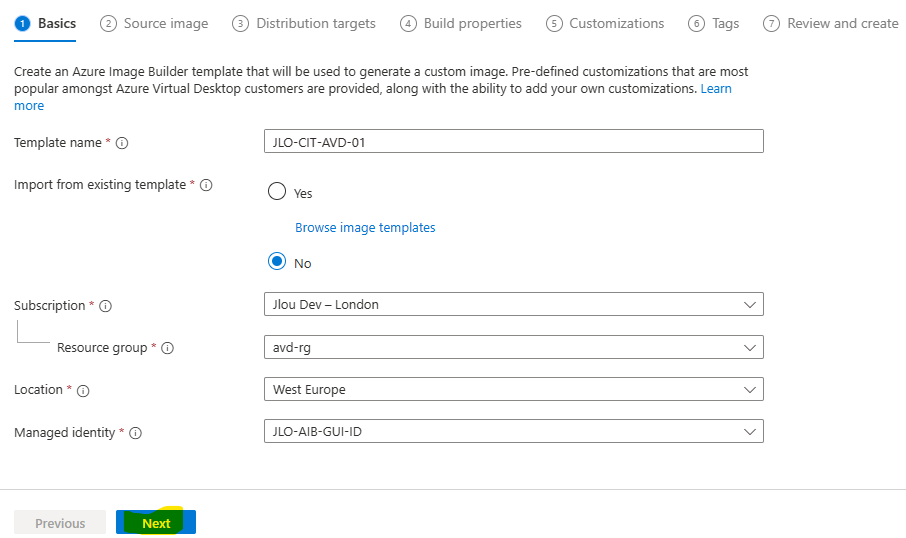

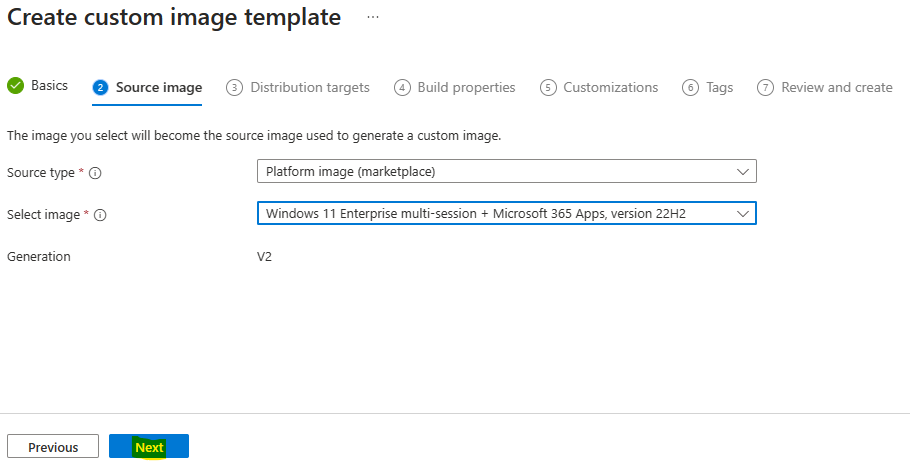

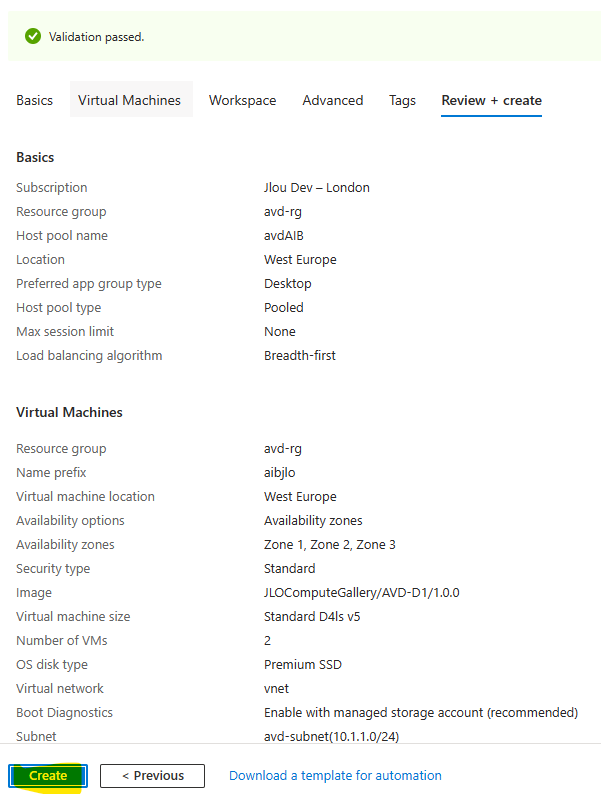

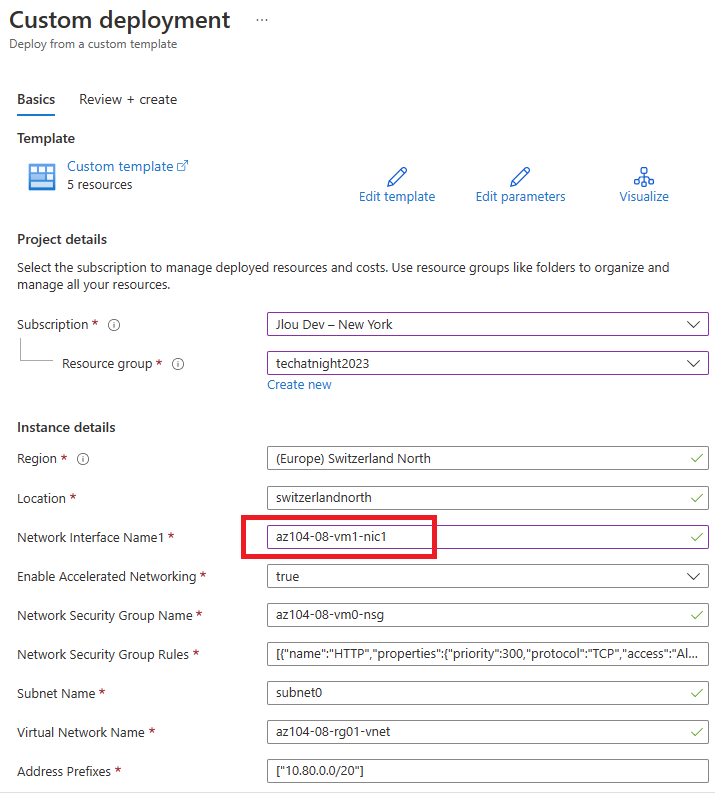

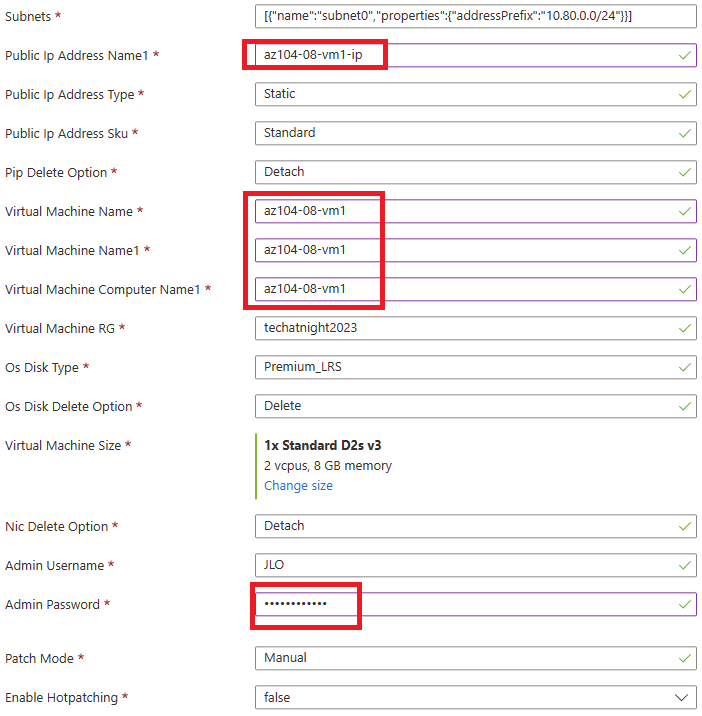

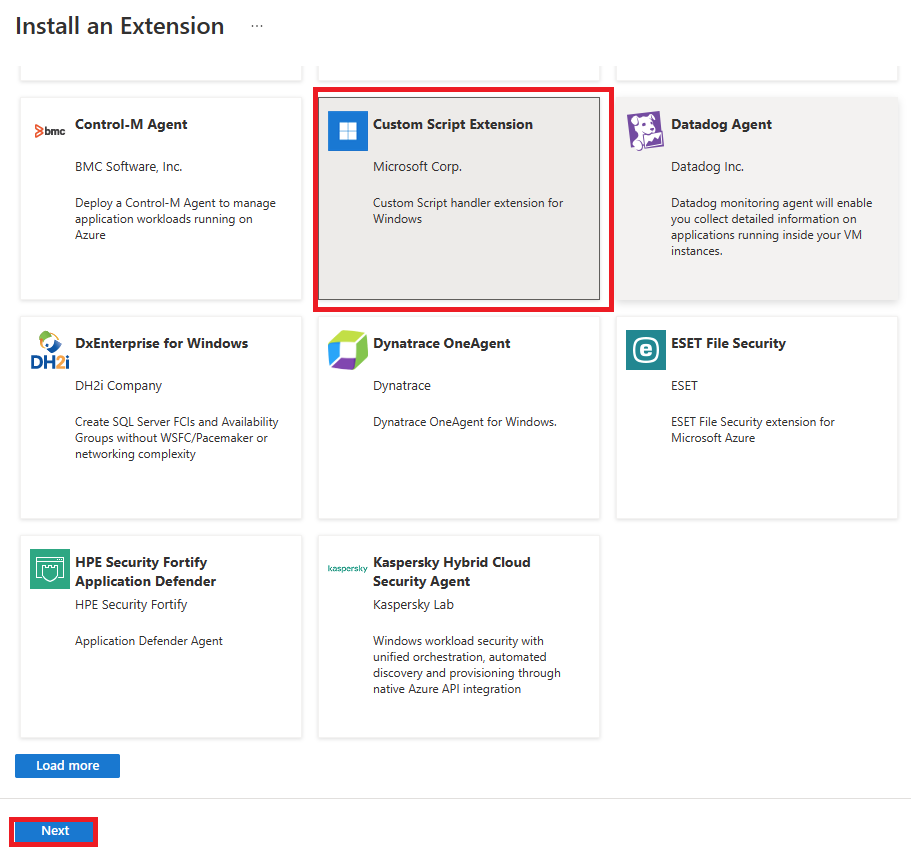

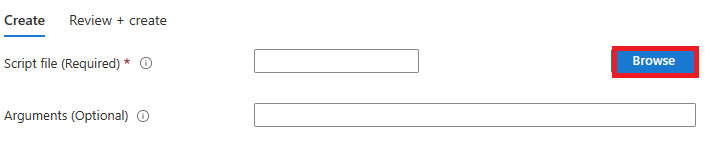

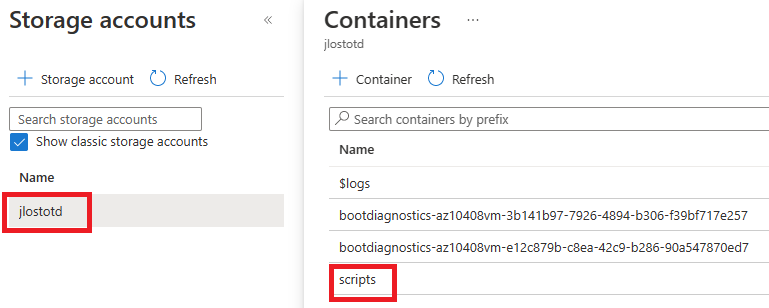

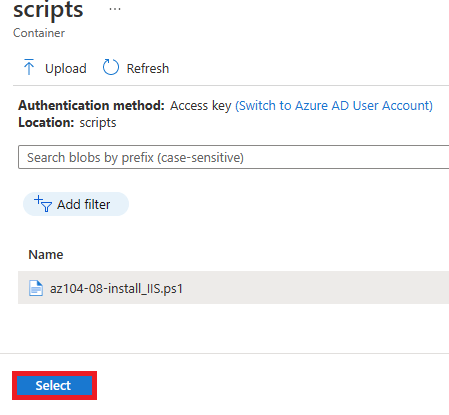

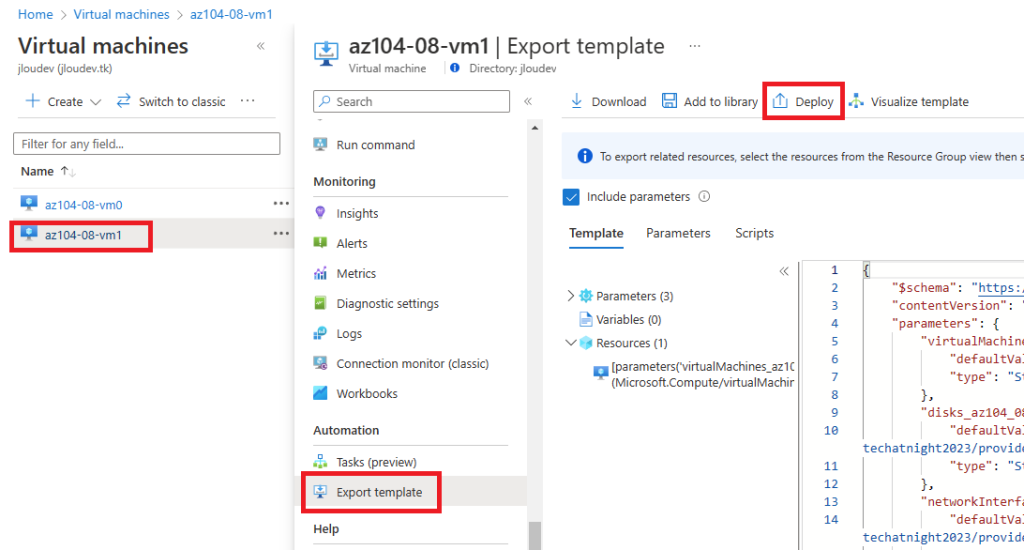

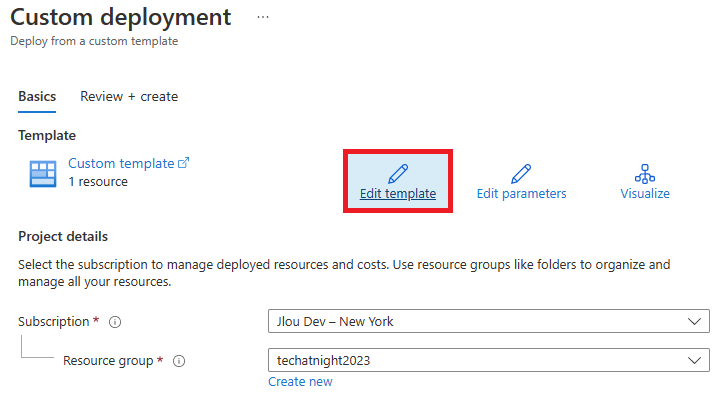

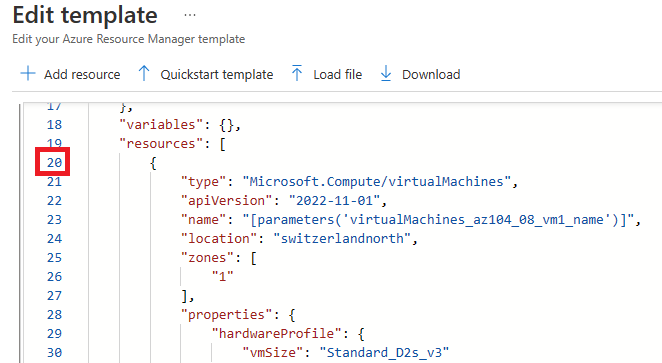

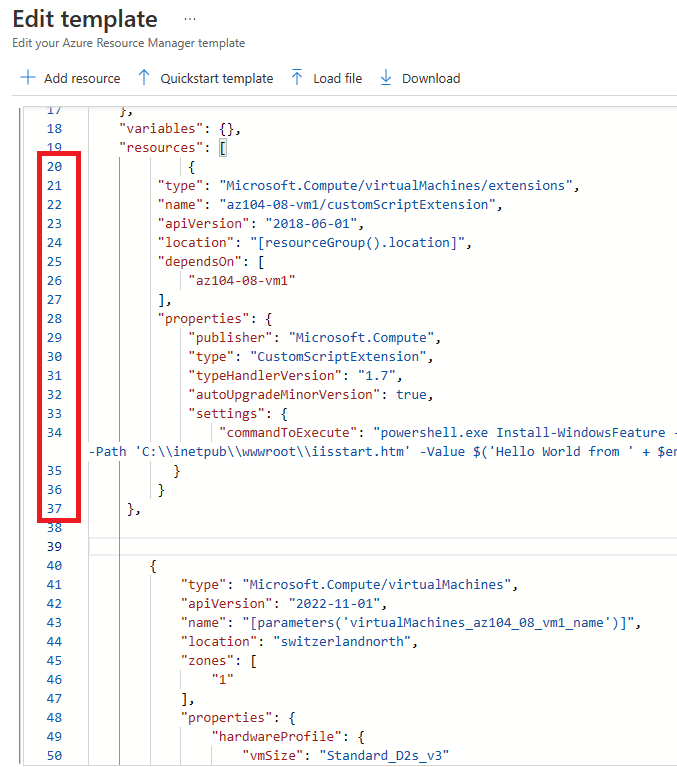

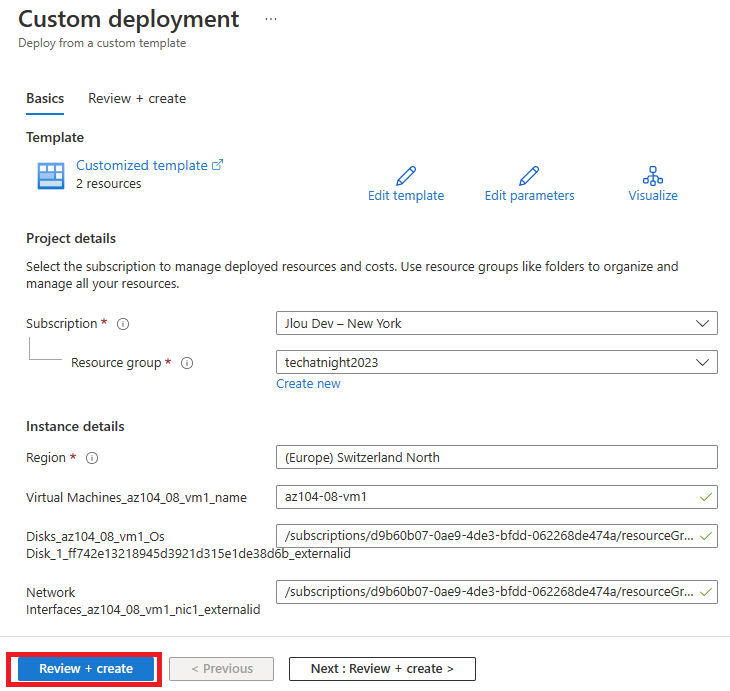

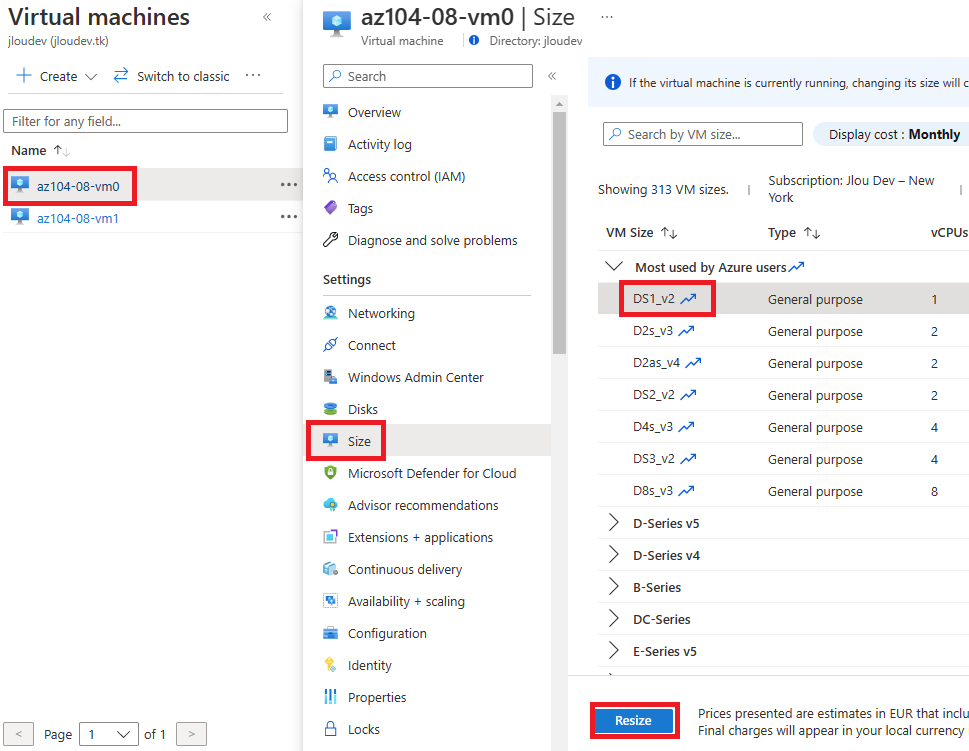

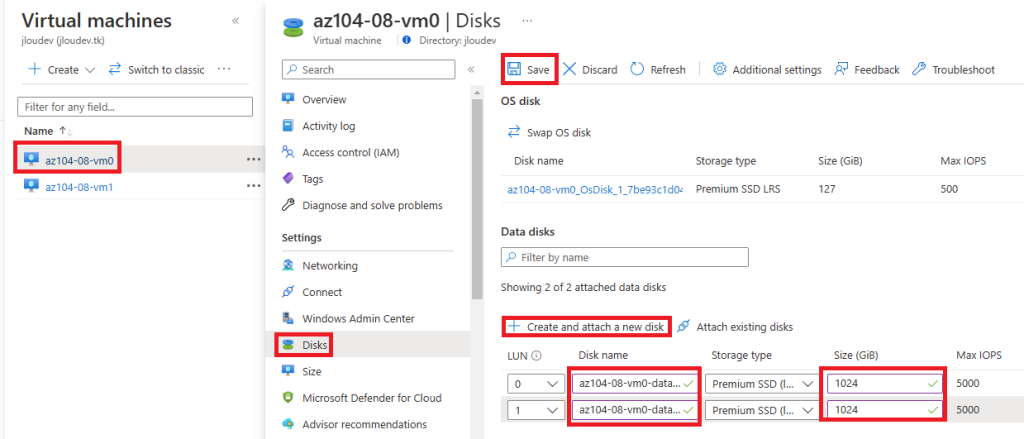

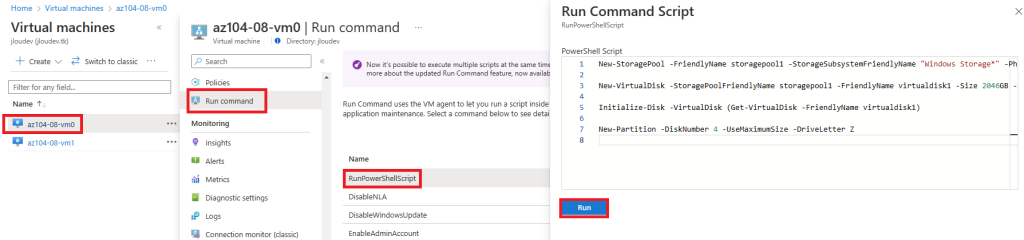

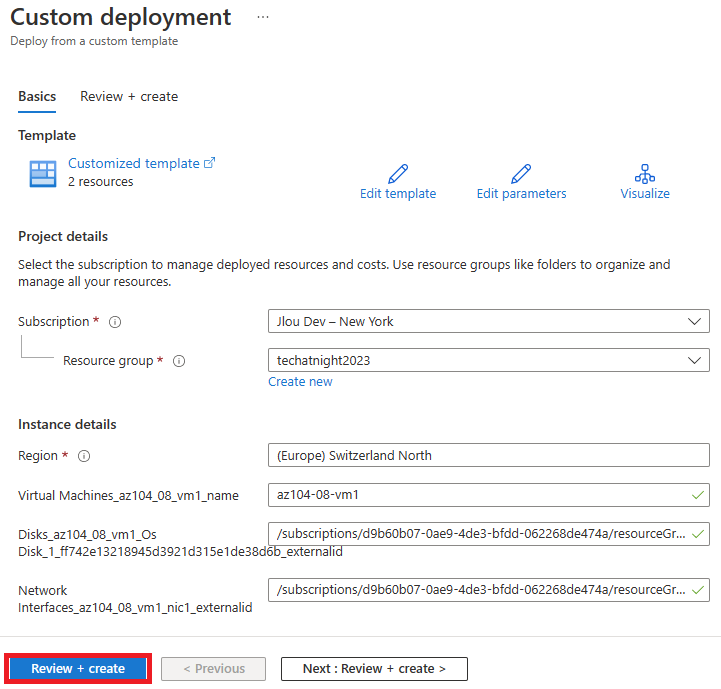

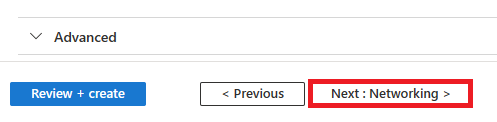

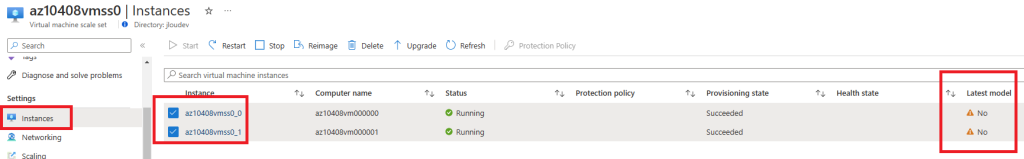

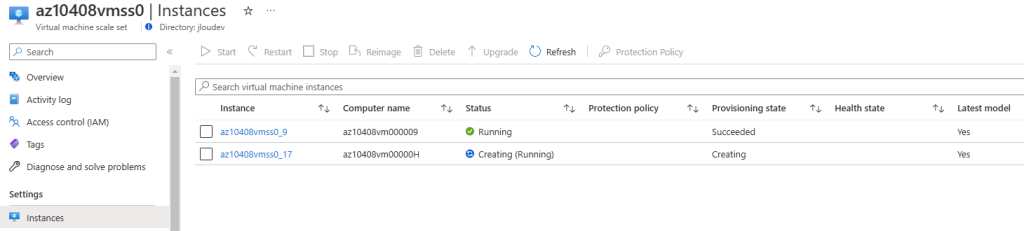

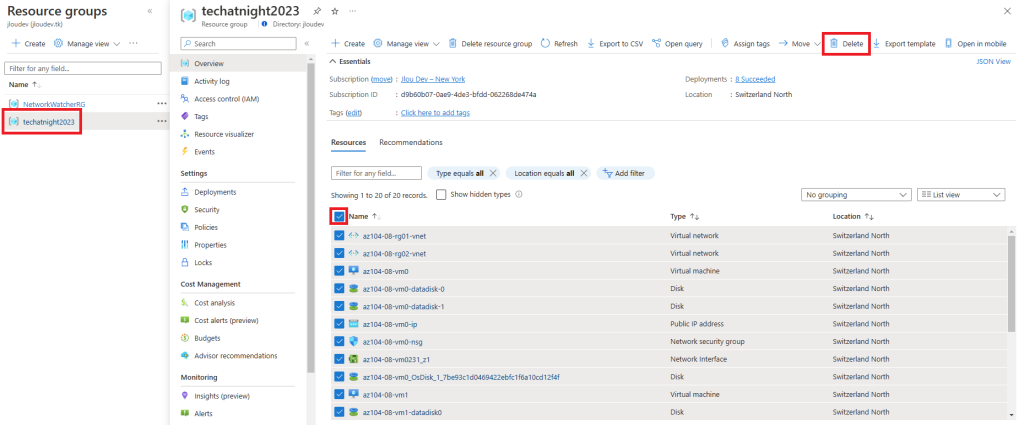

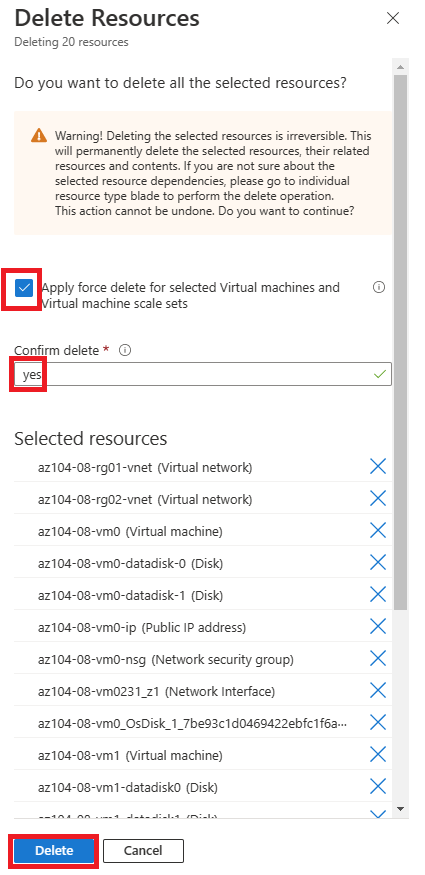

Etape I – Déployez une machine virtuelle Azure :

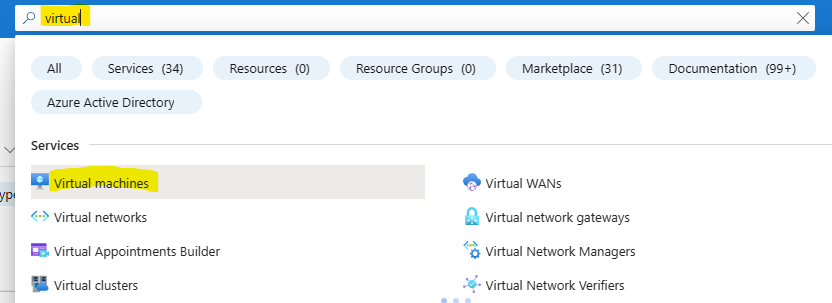

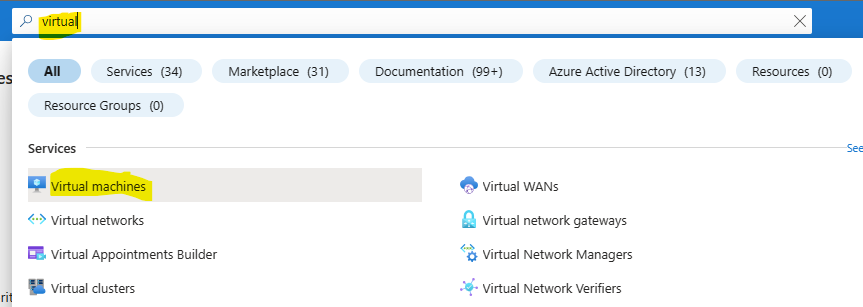

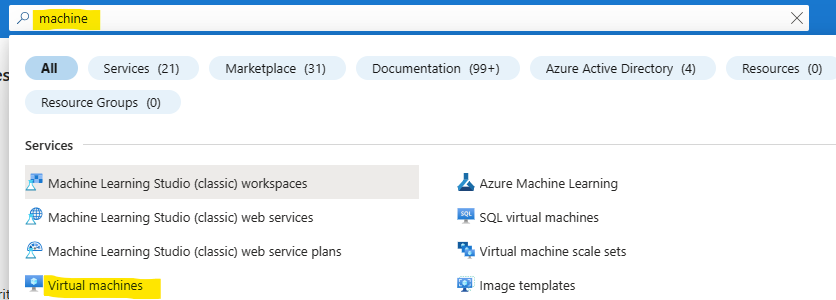

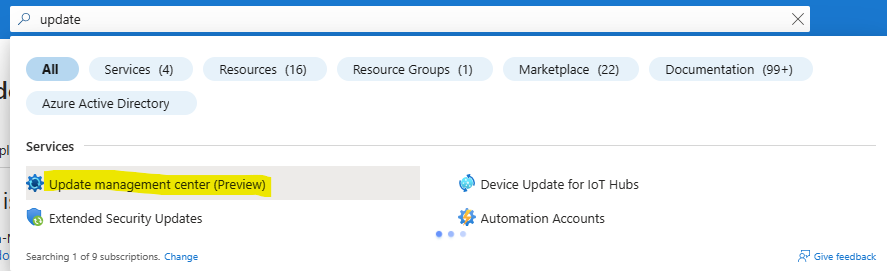

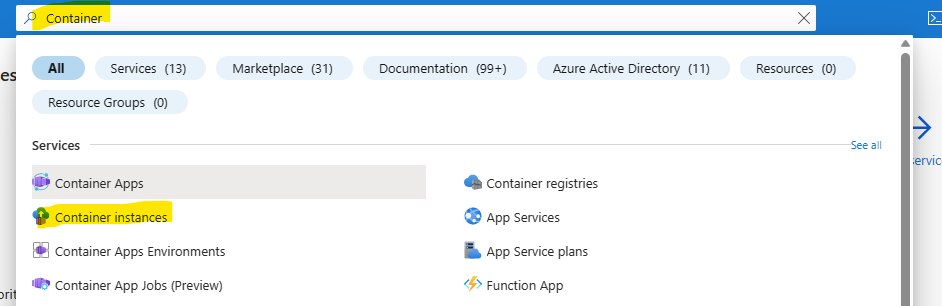

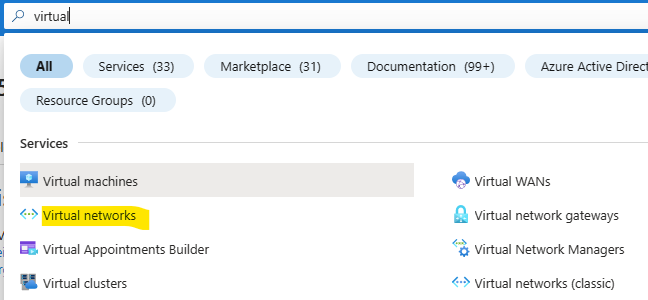

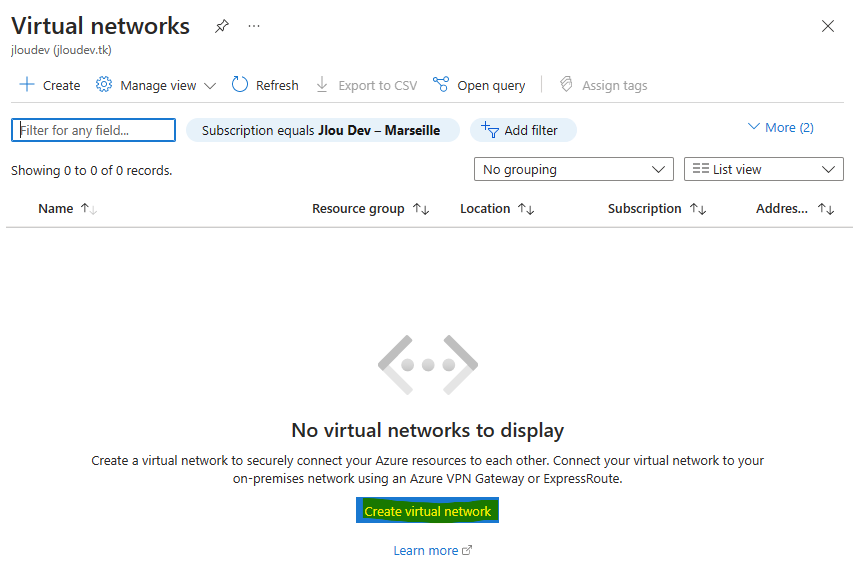

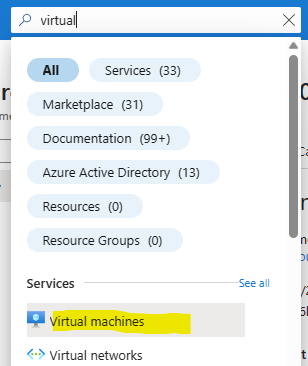

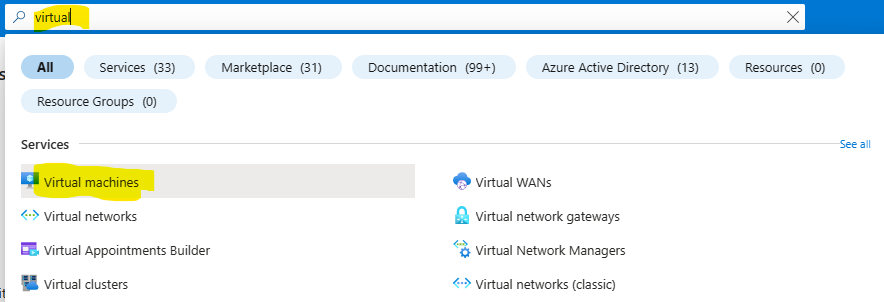

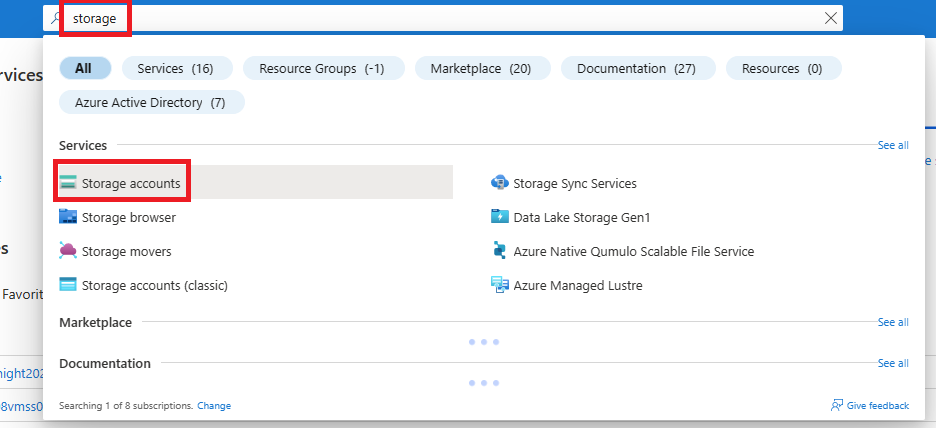

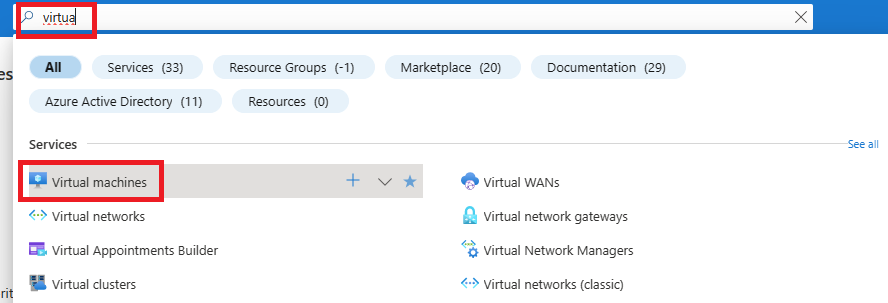

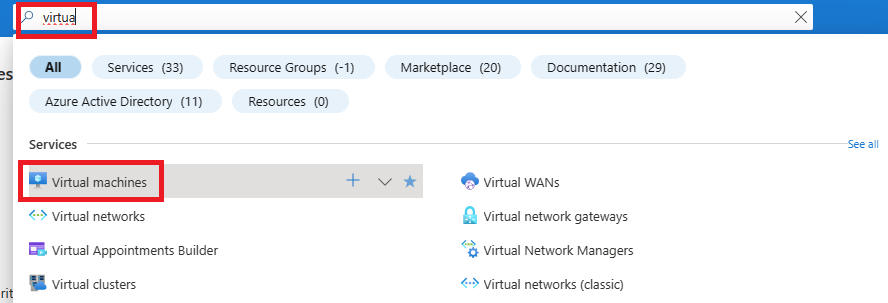

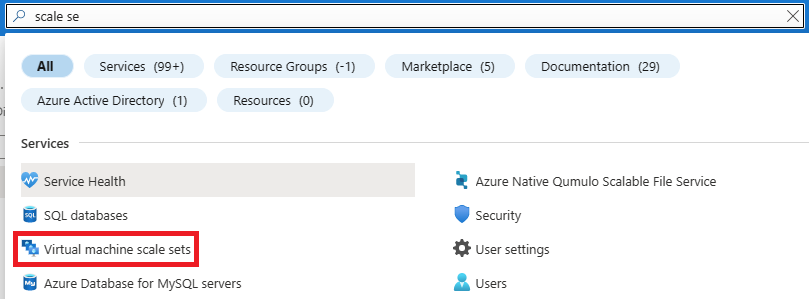

Commencez par déployer une VM. Pour cela, rendez-vous sur le portail d’Azure et utilisez la barre de recherche :

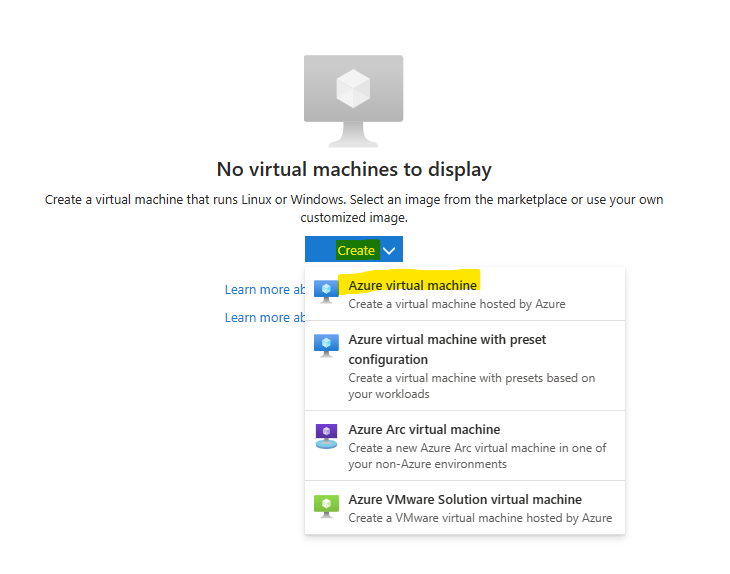

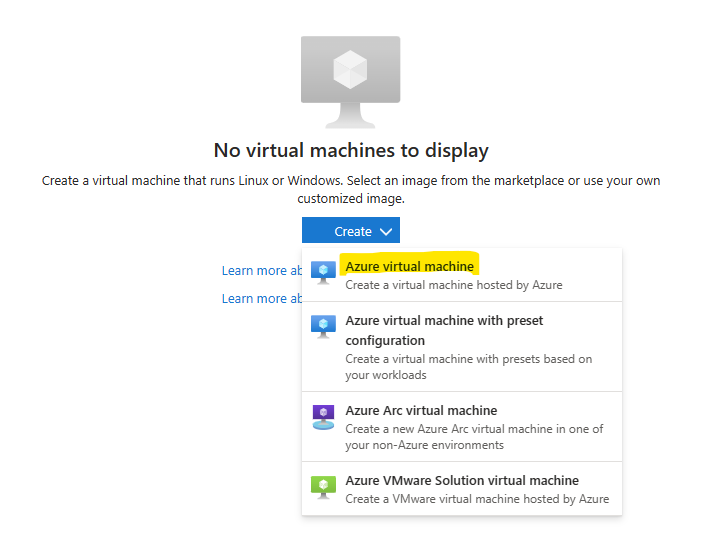

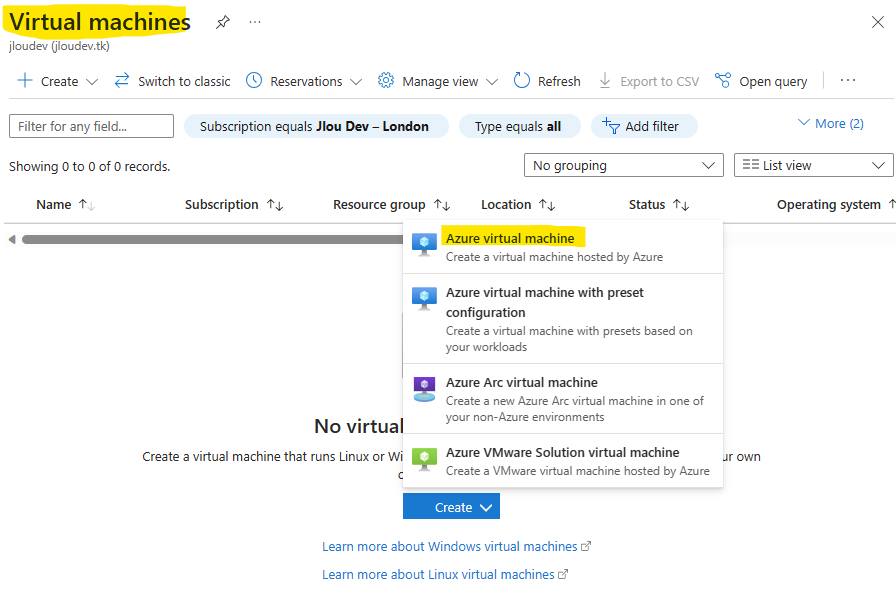

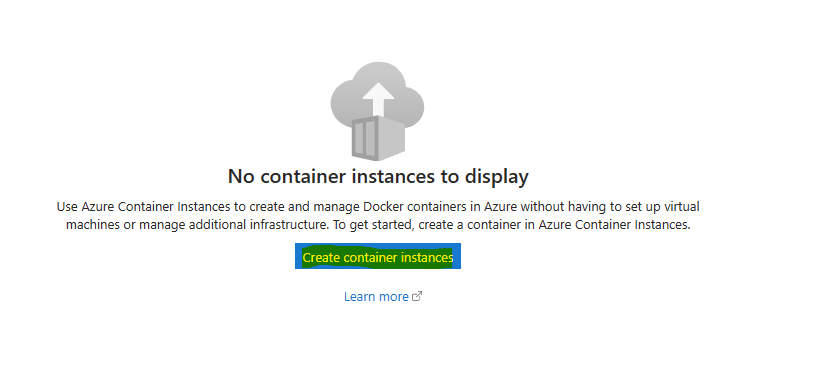

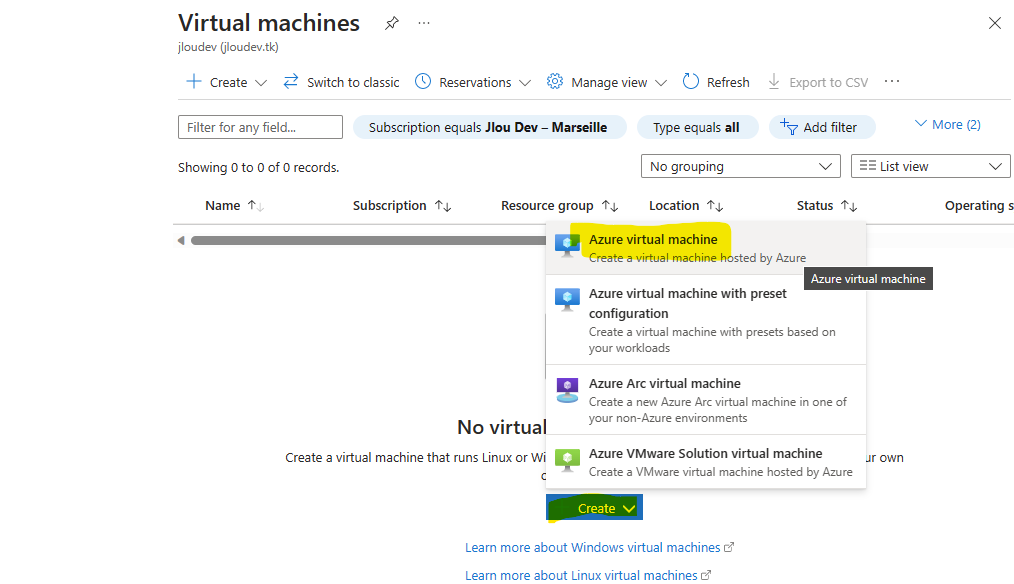

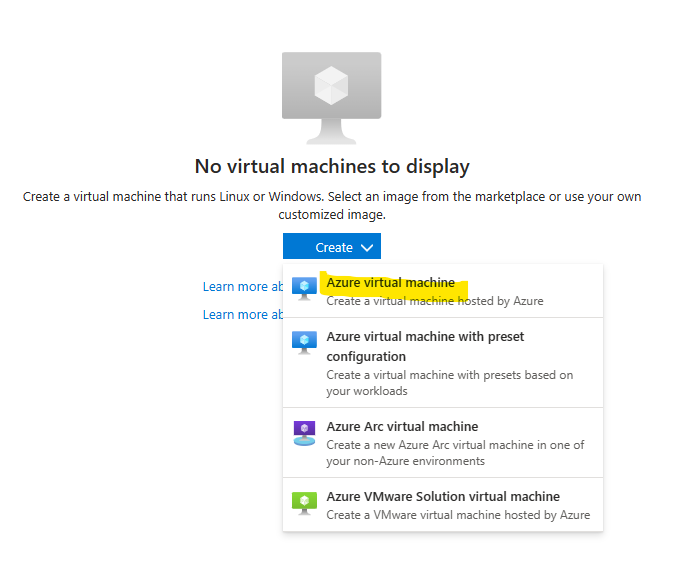

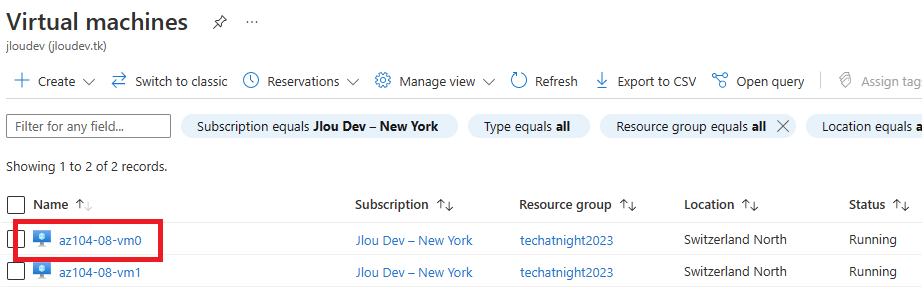

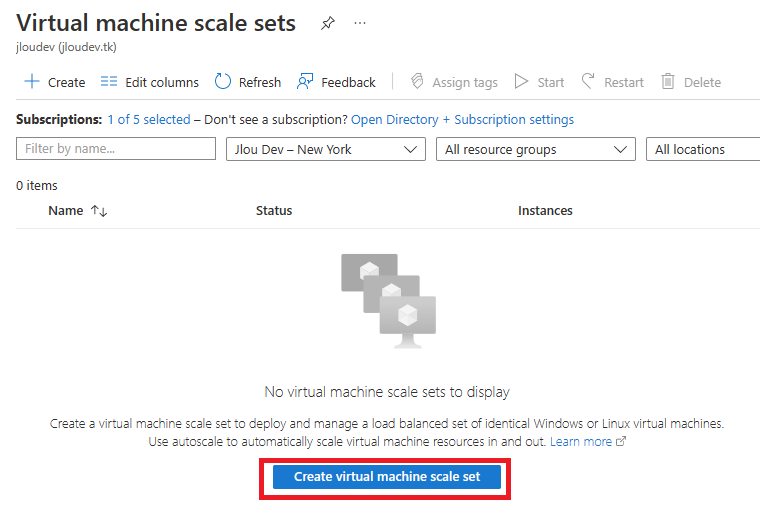

Cliquez-ici pour créer votre première machine virtuelle Azure :

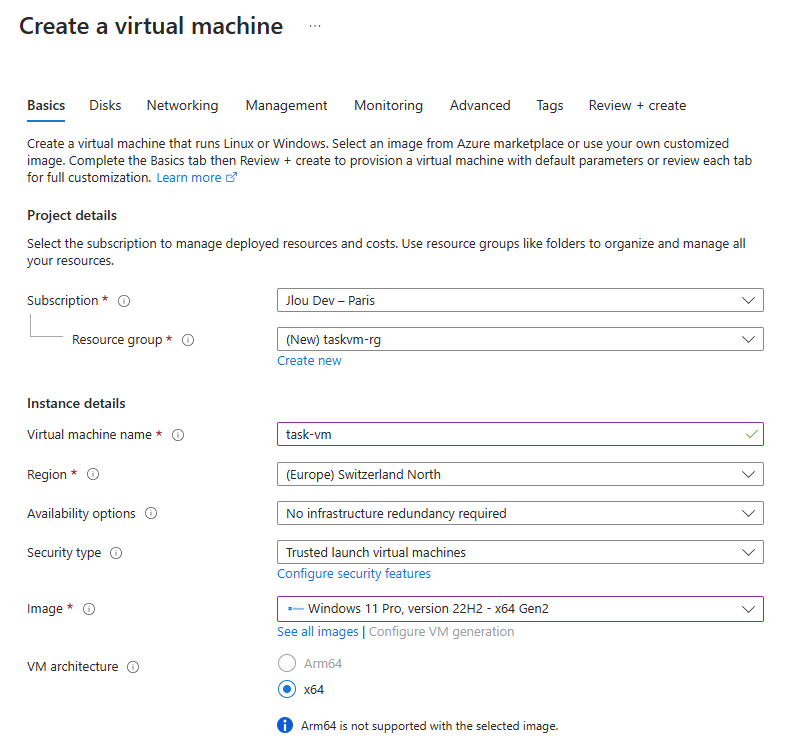

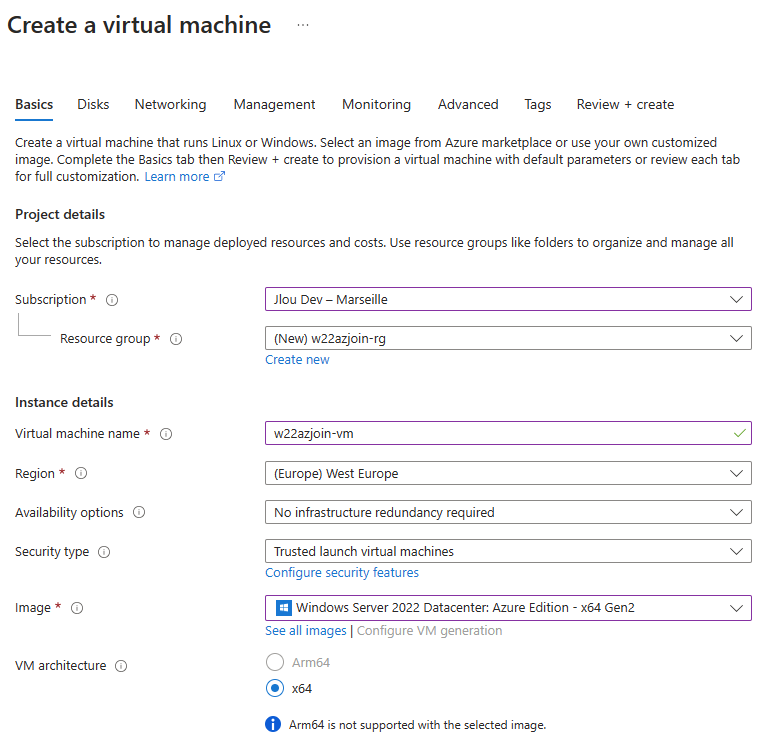

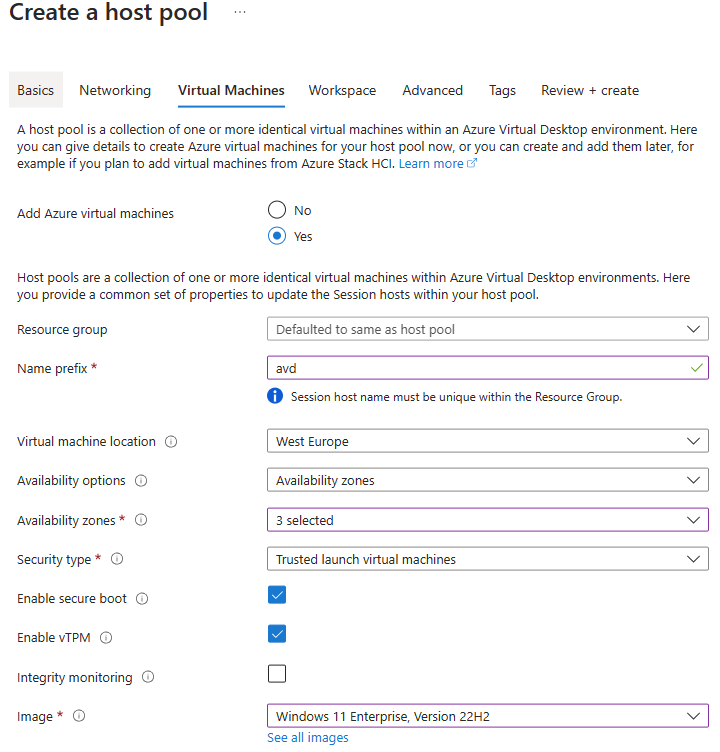

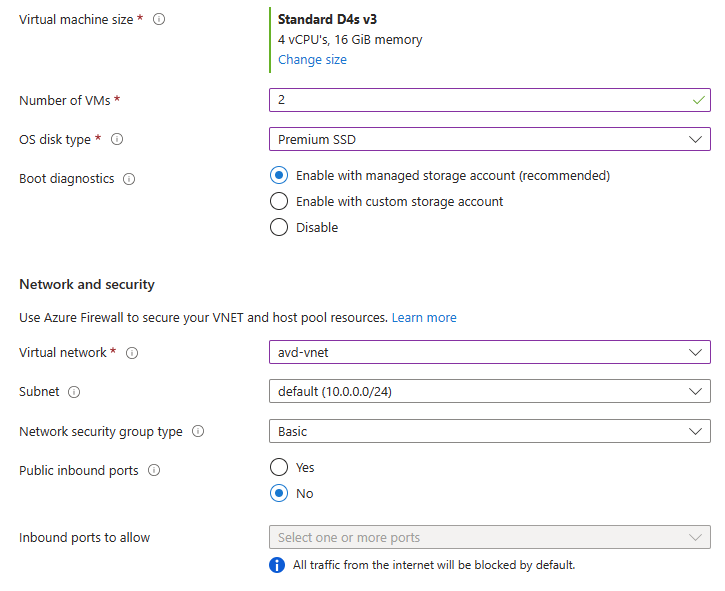

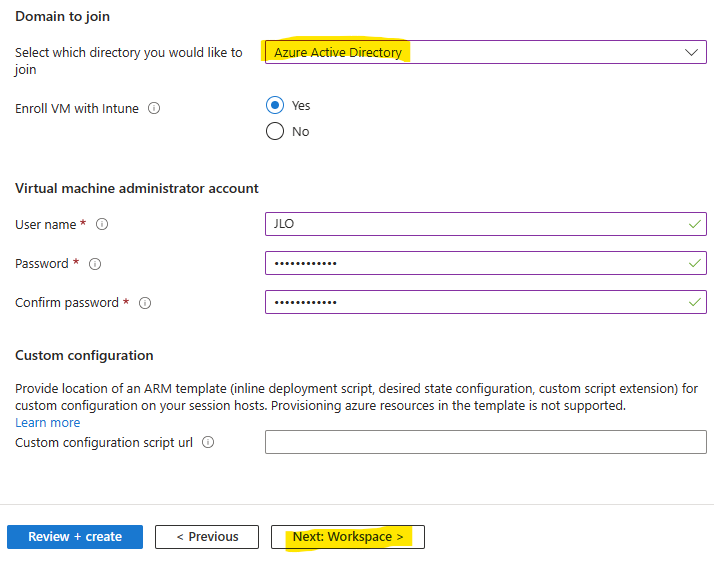

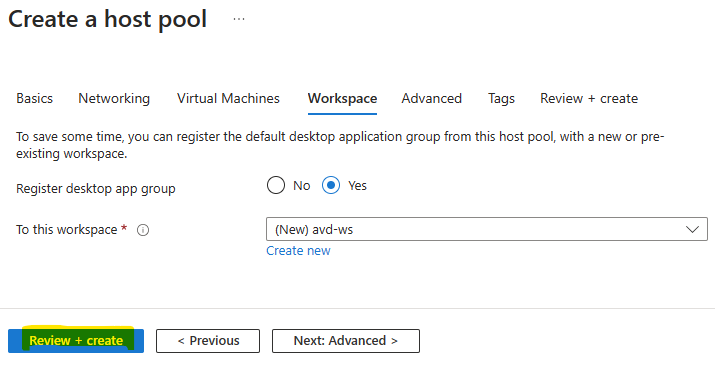

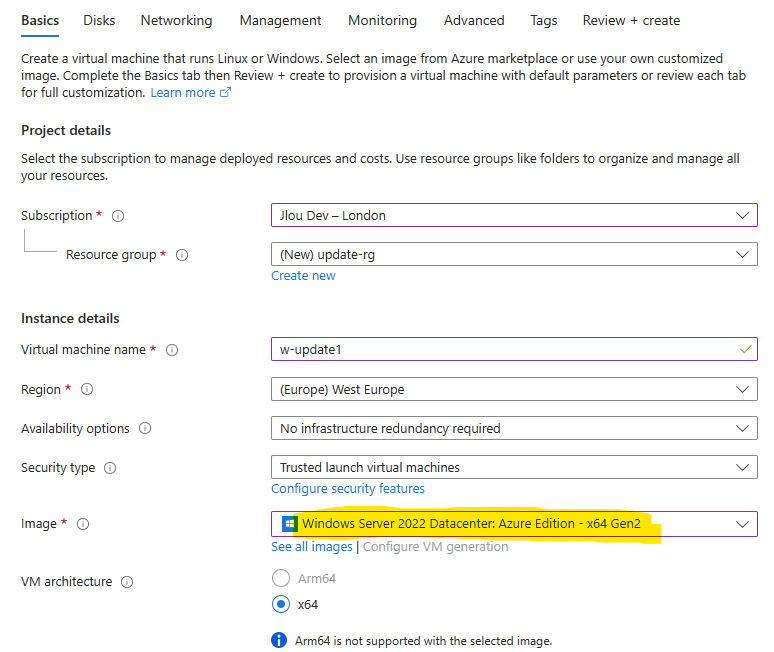

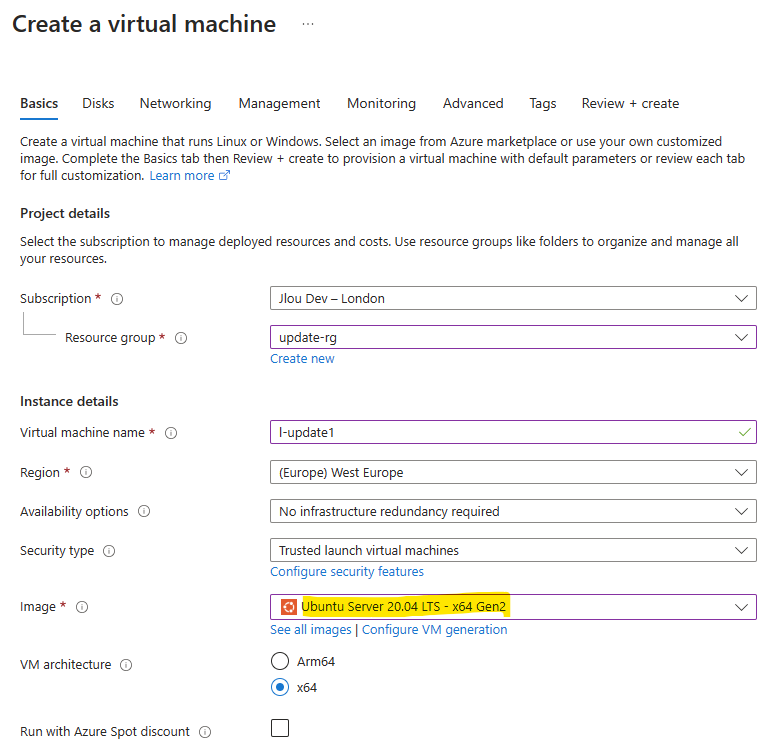

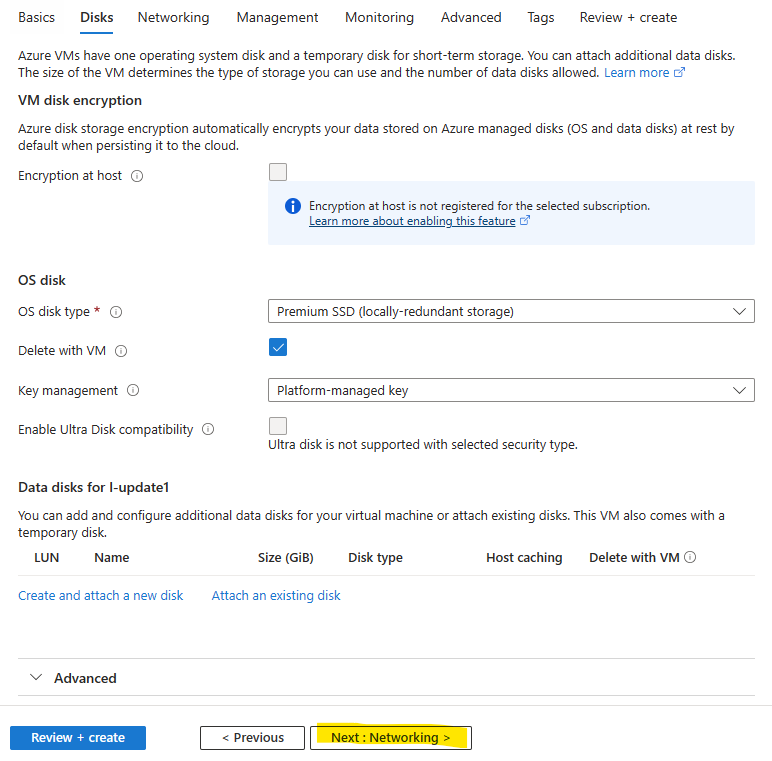

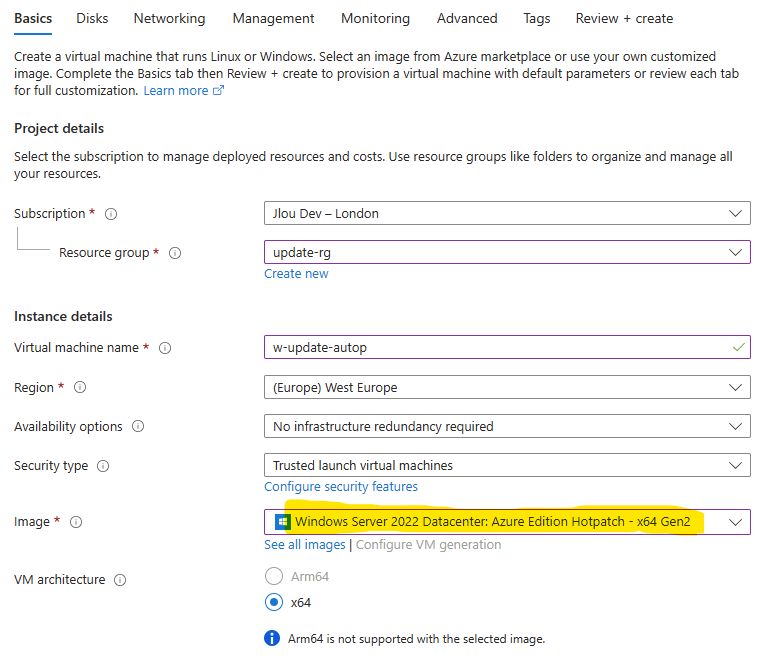

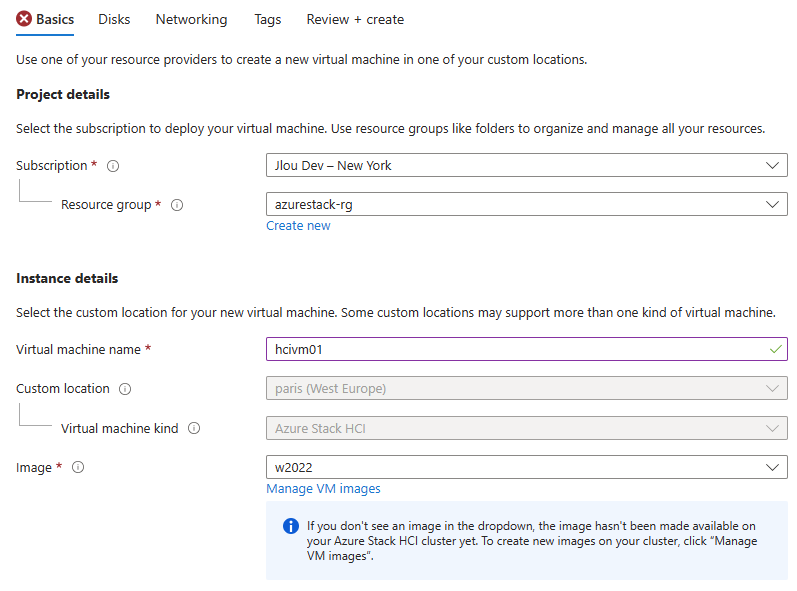

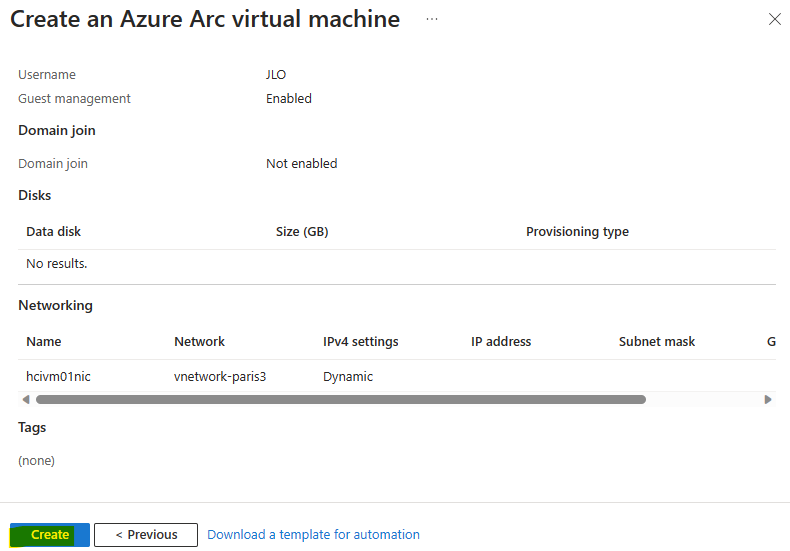

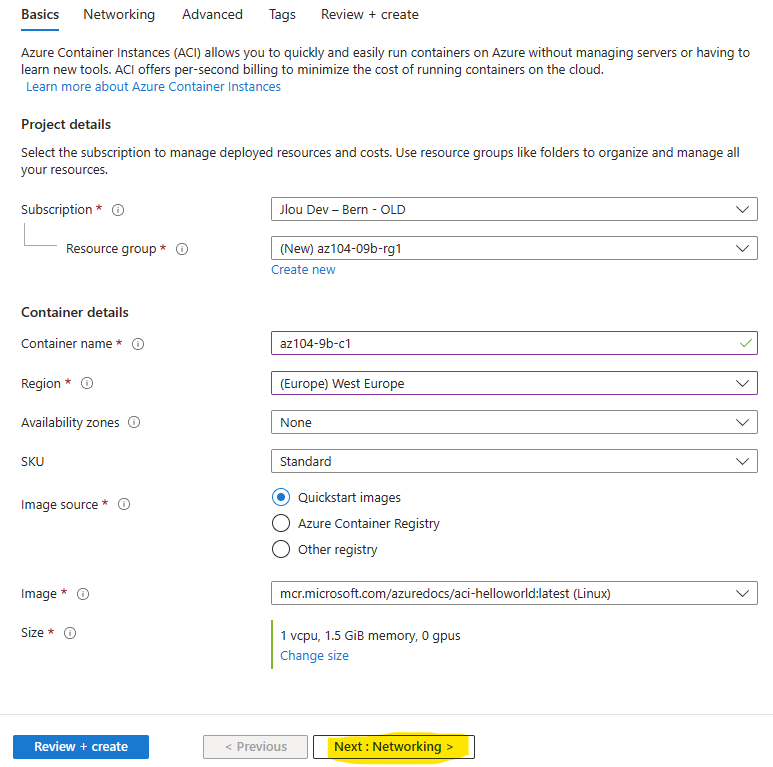

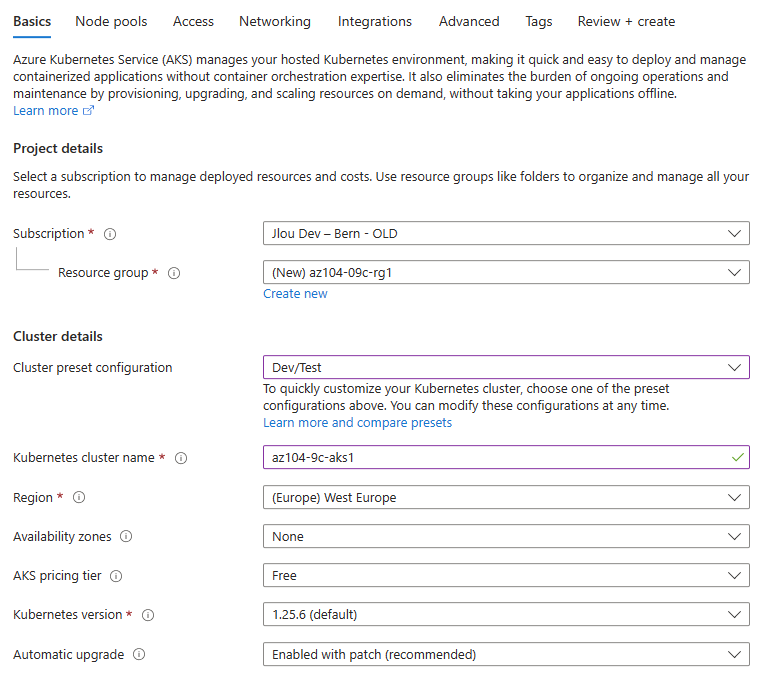

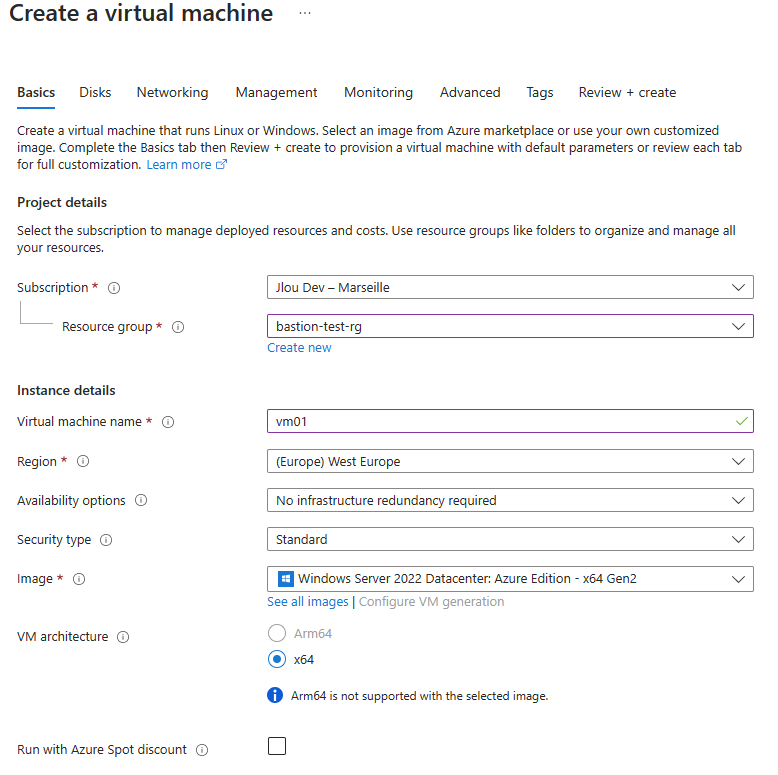

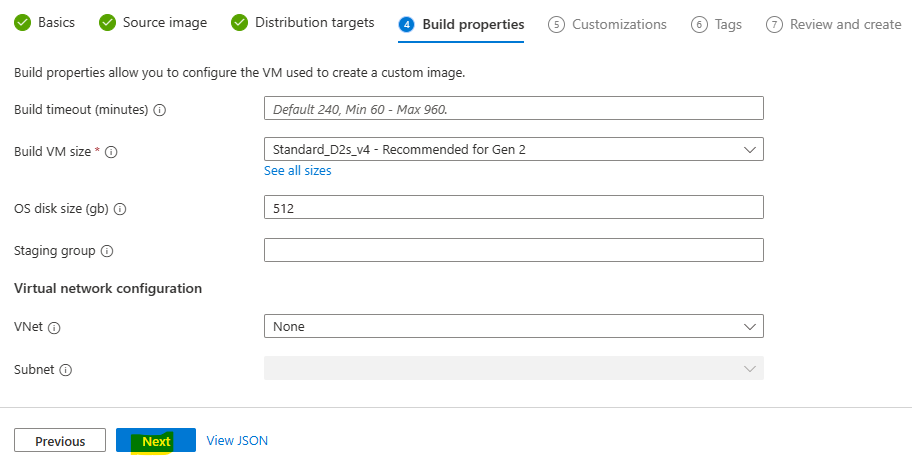

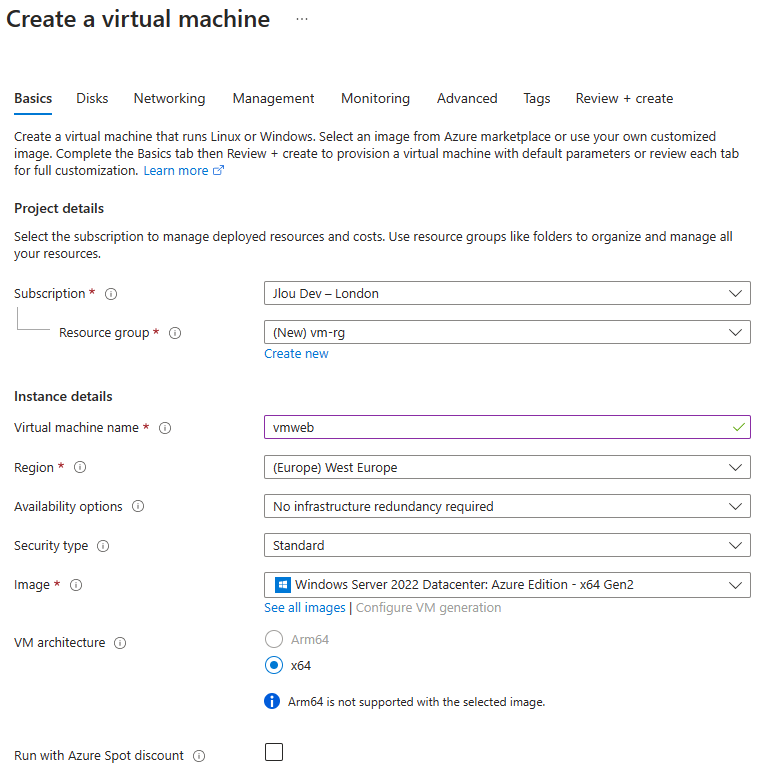

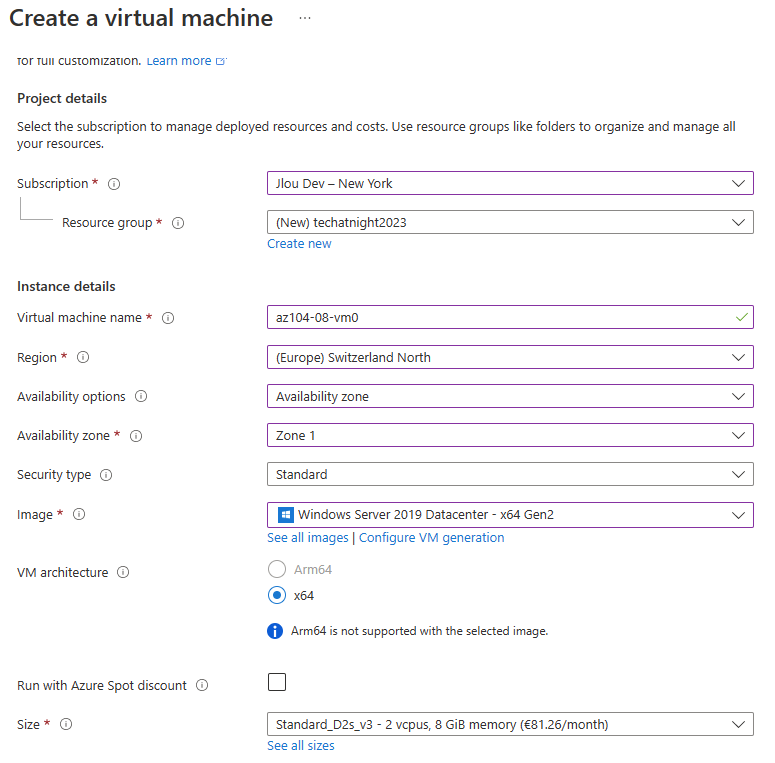

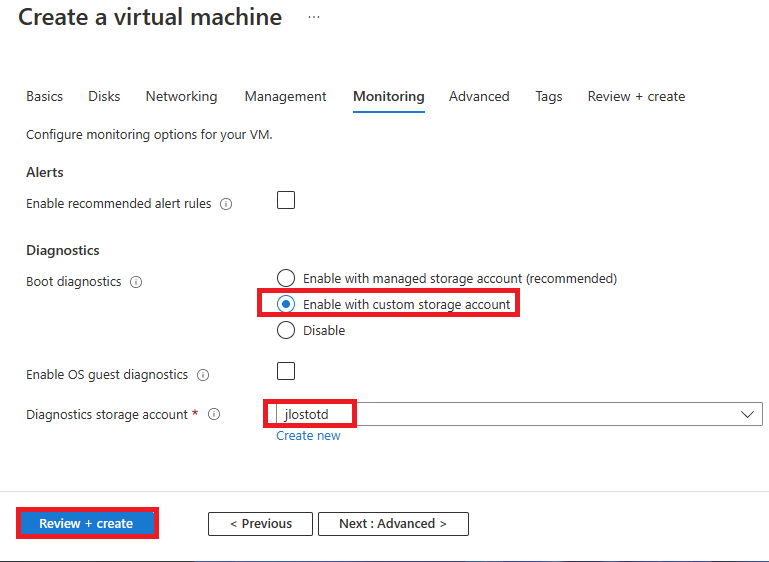

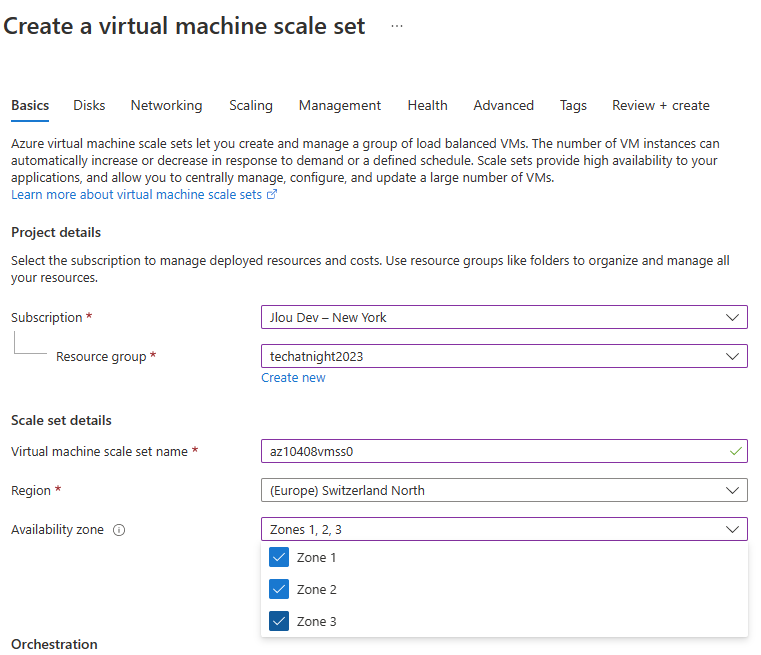

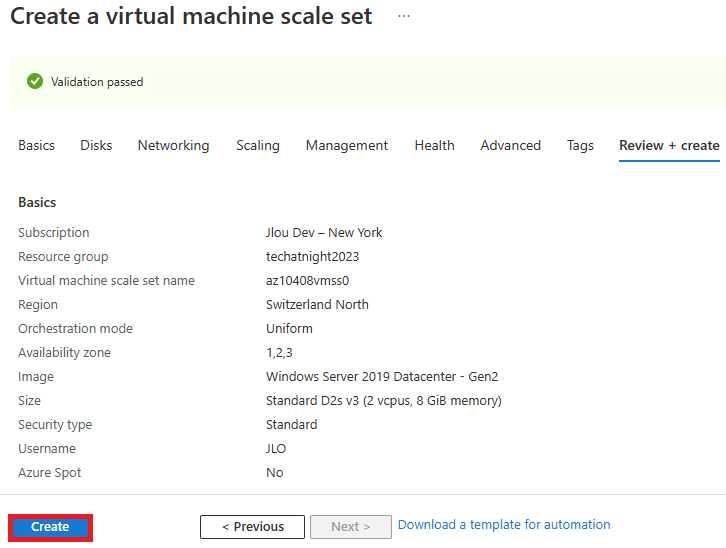

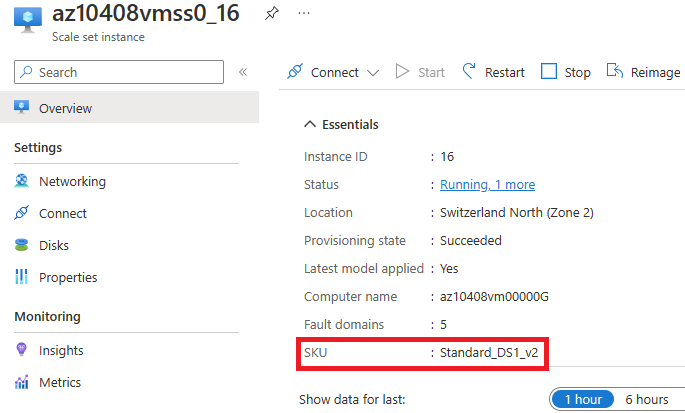

Renseignez les informations de base relatives à votre VM :

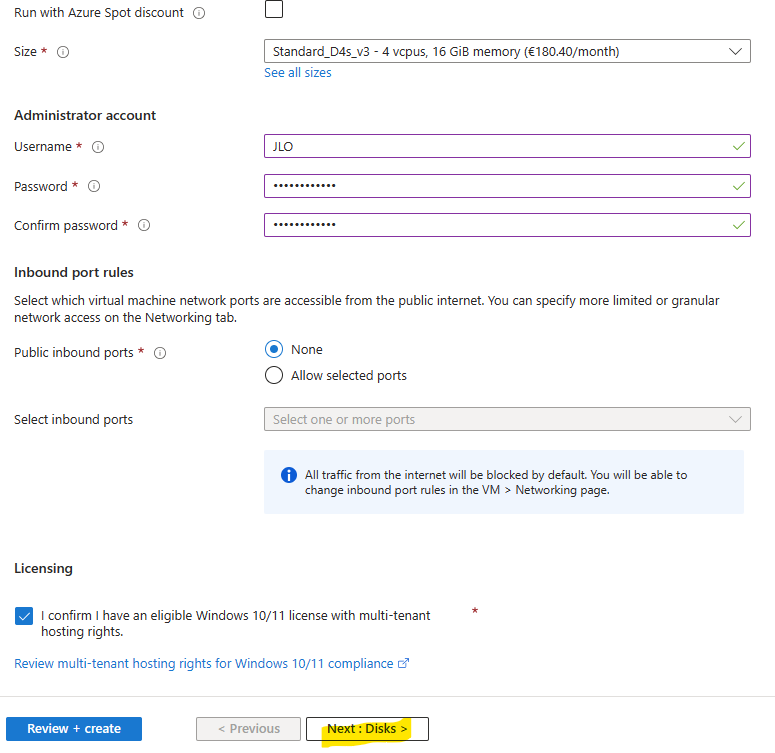

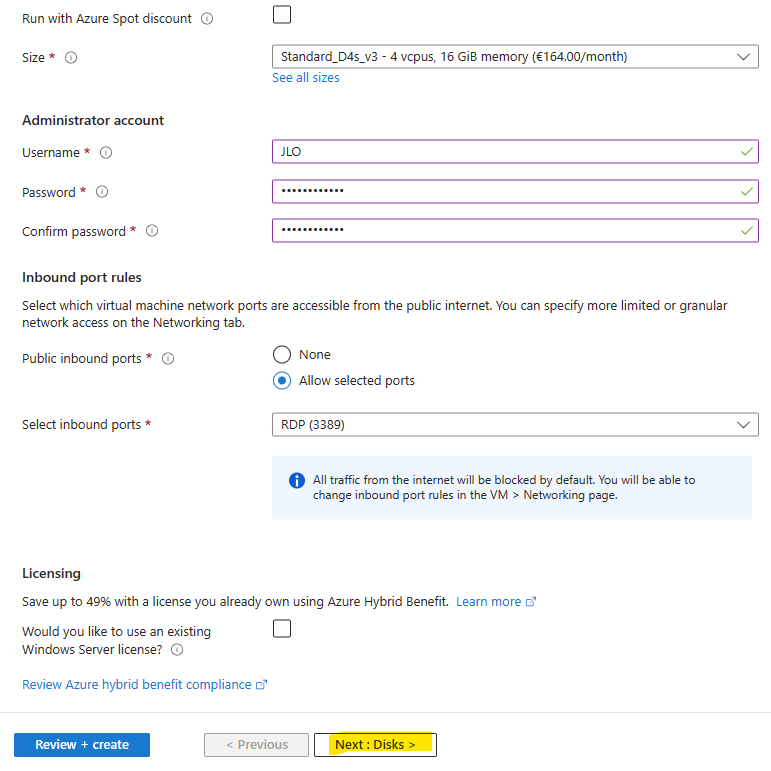

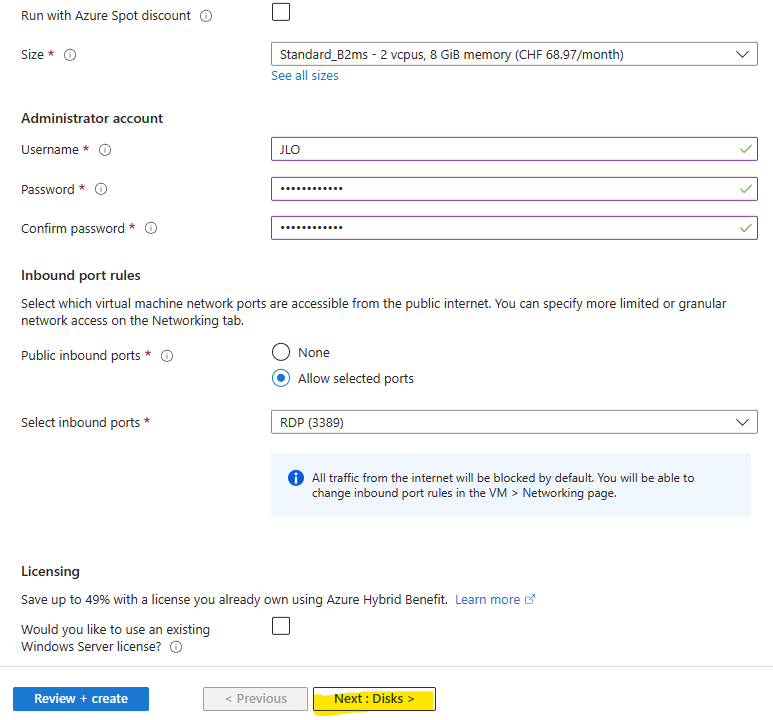

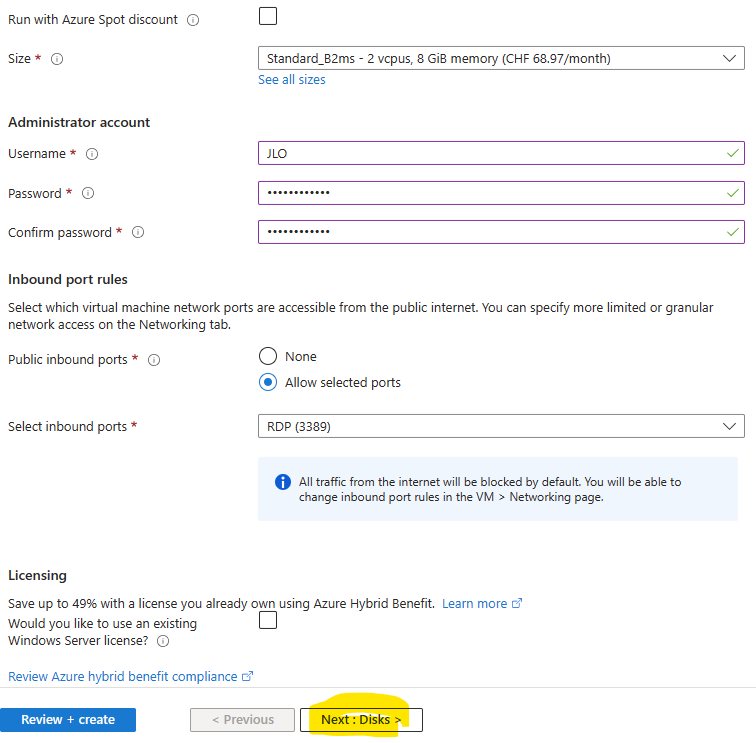

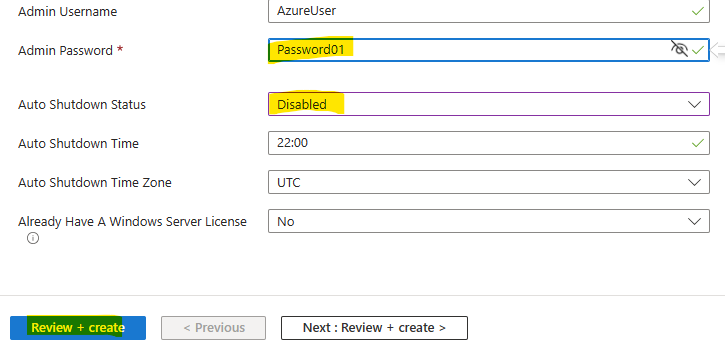

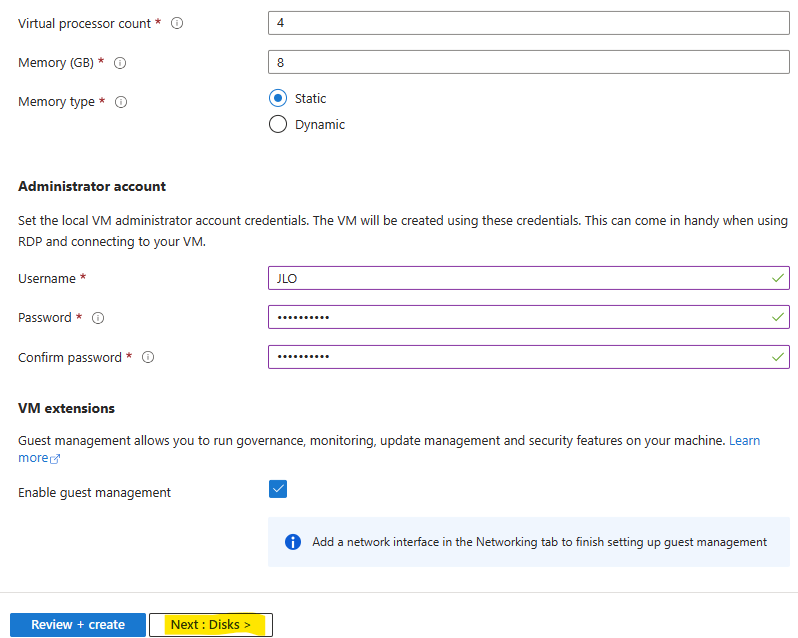

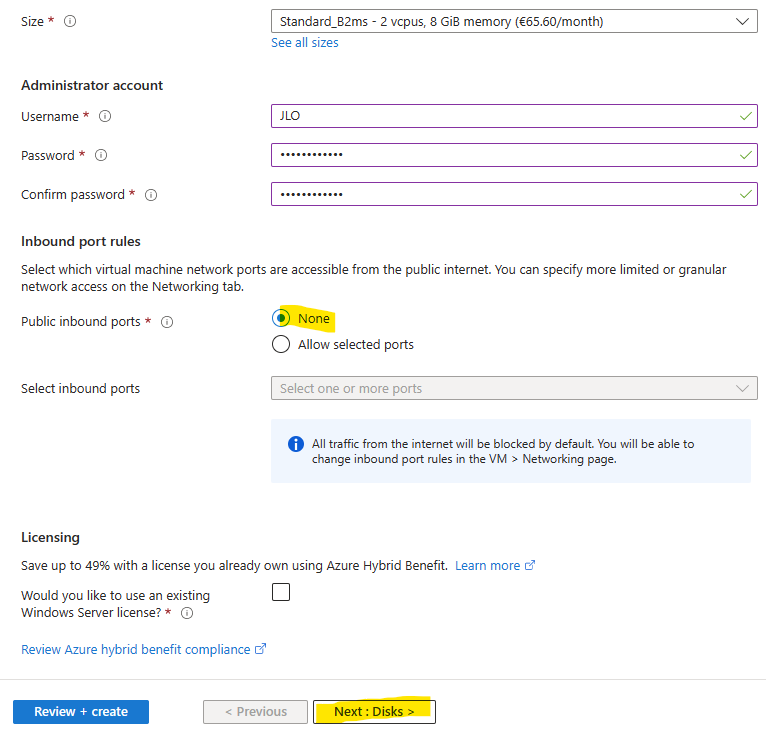

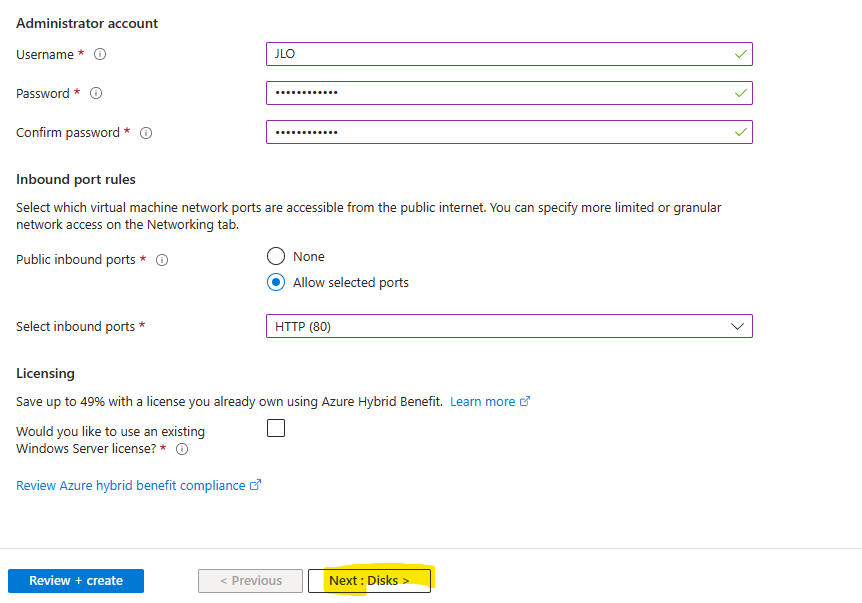

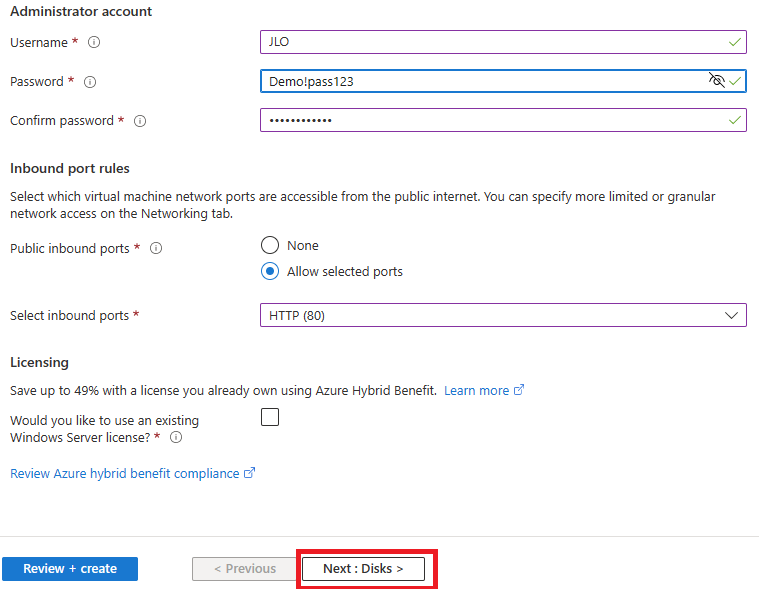

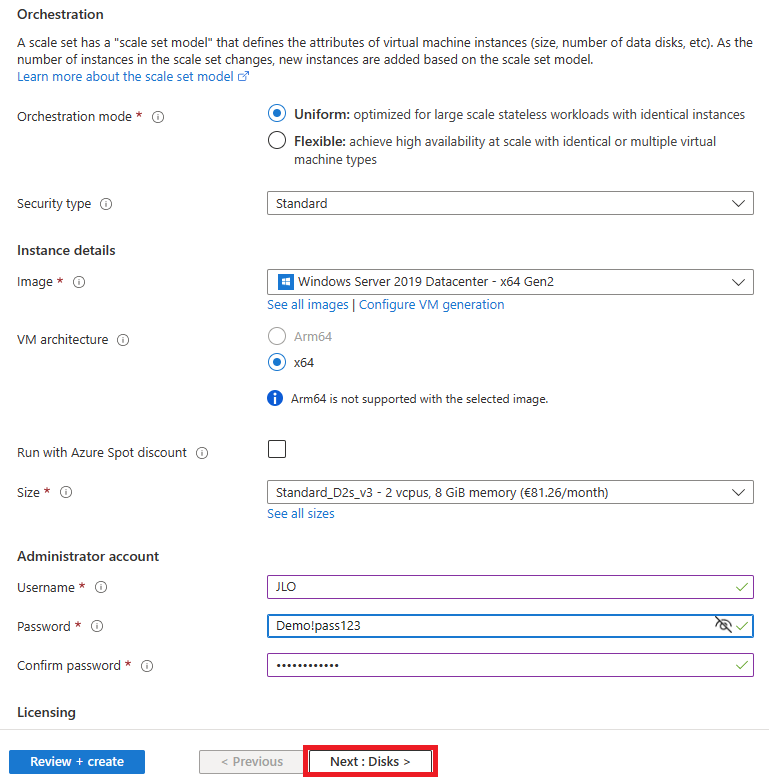

Définissez un compte administrateur local, puis cliquez sur Suivant :

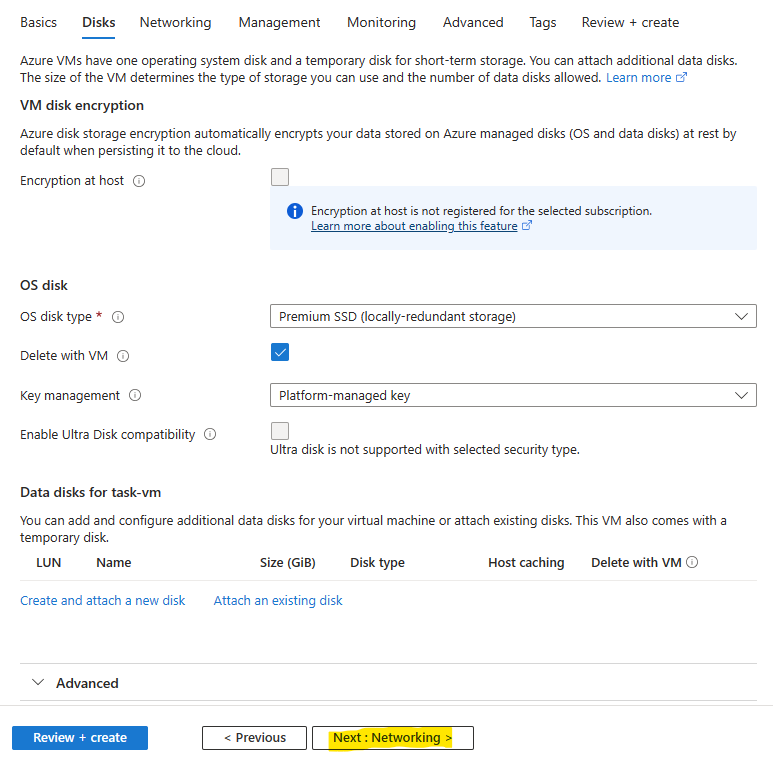

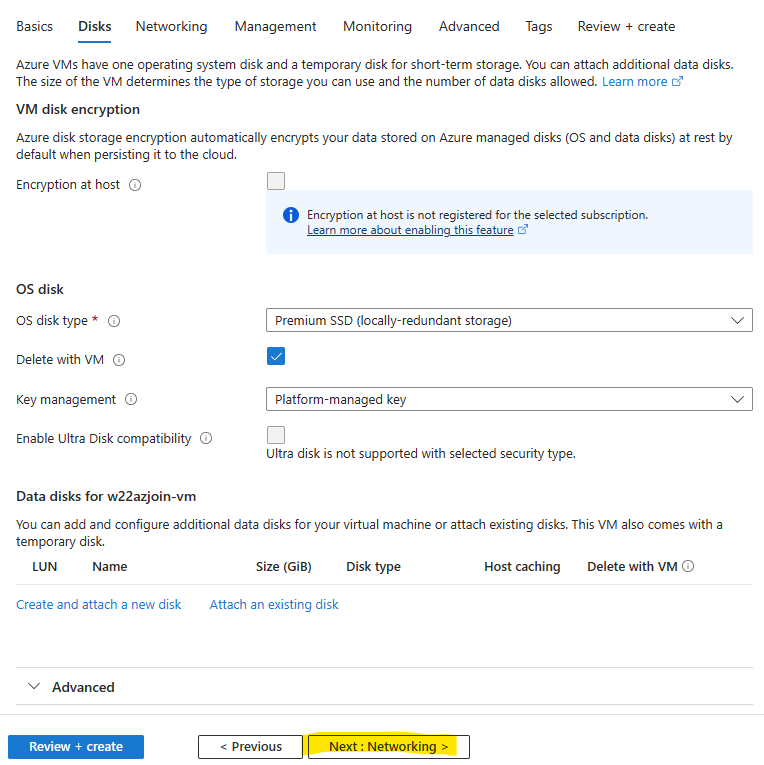

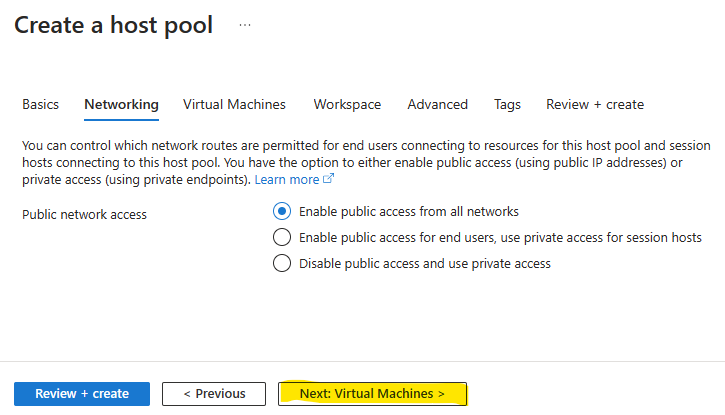

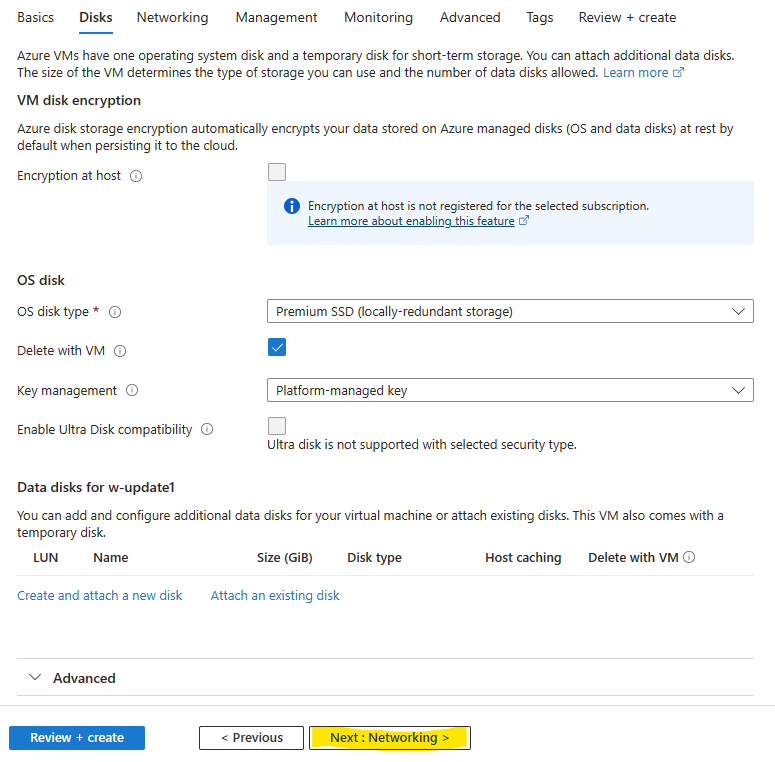

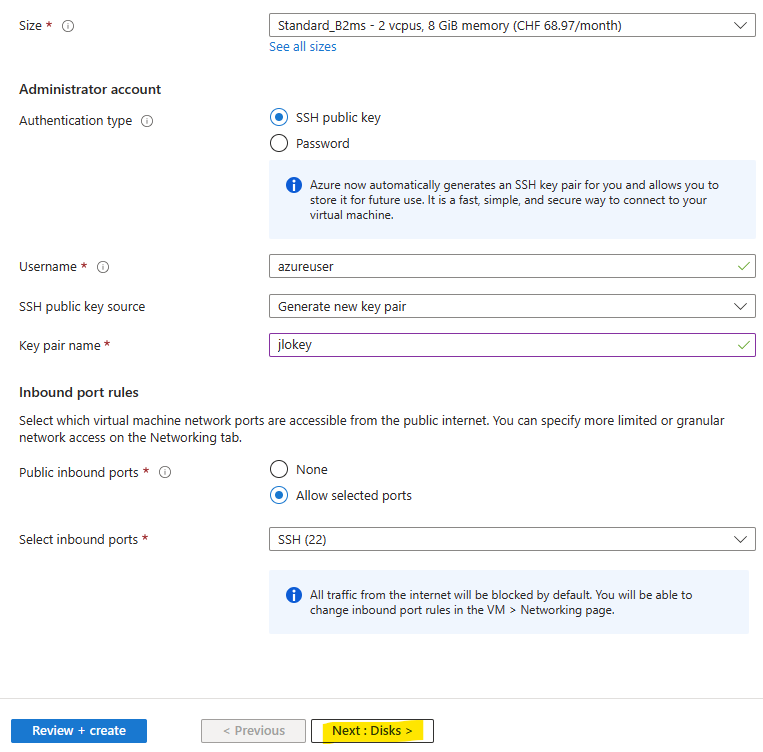

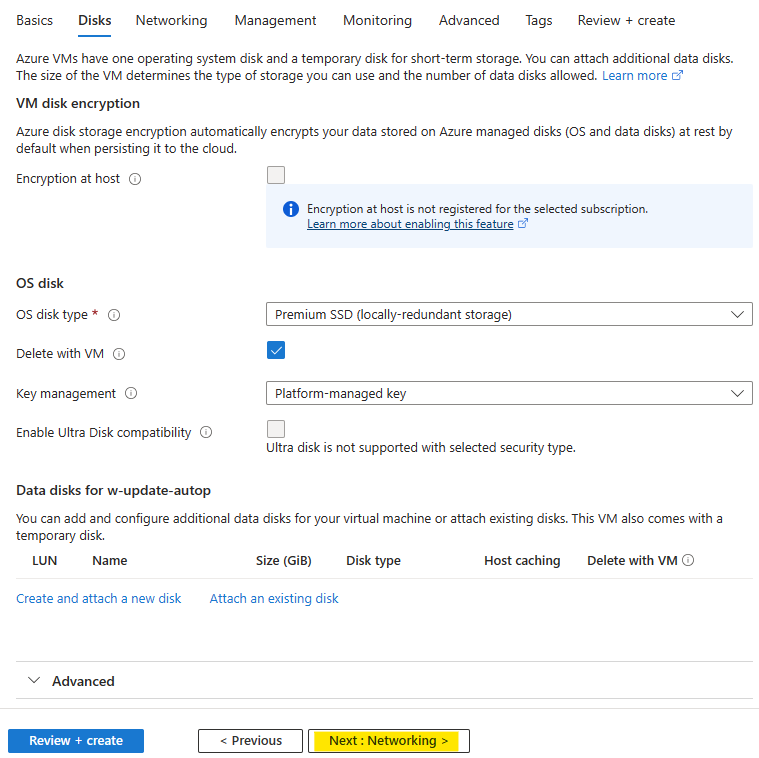

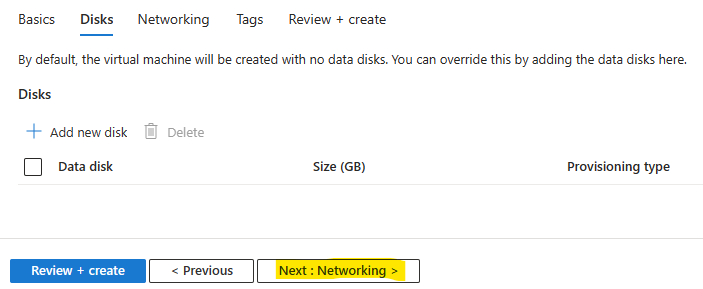

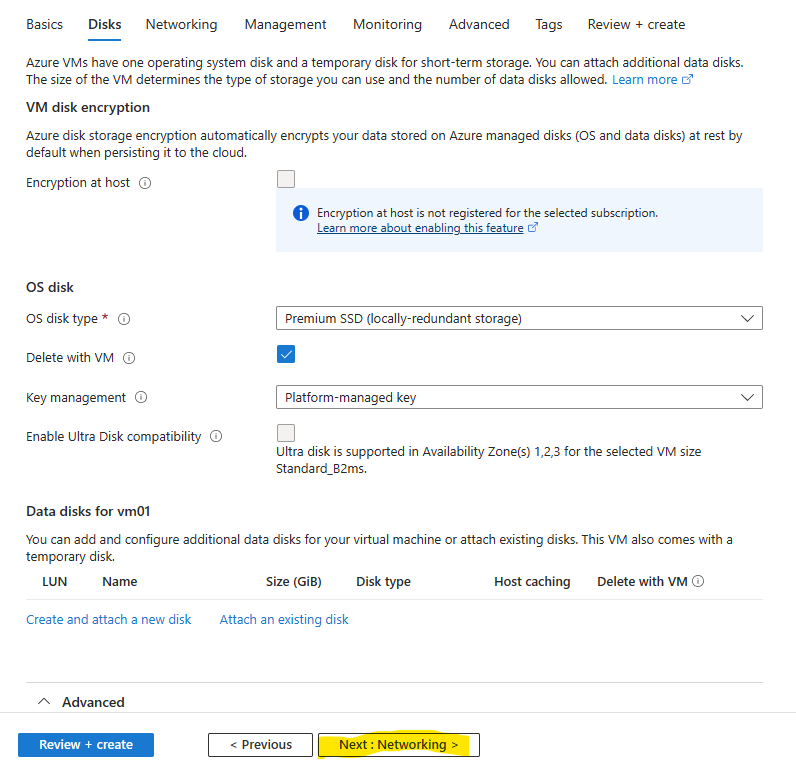

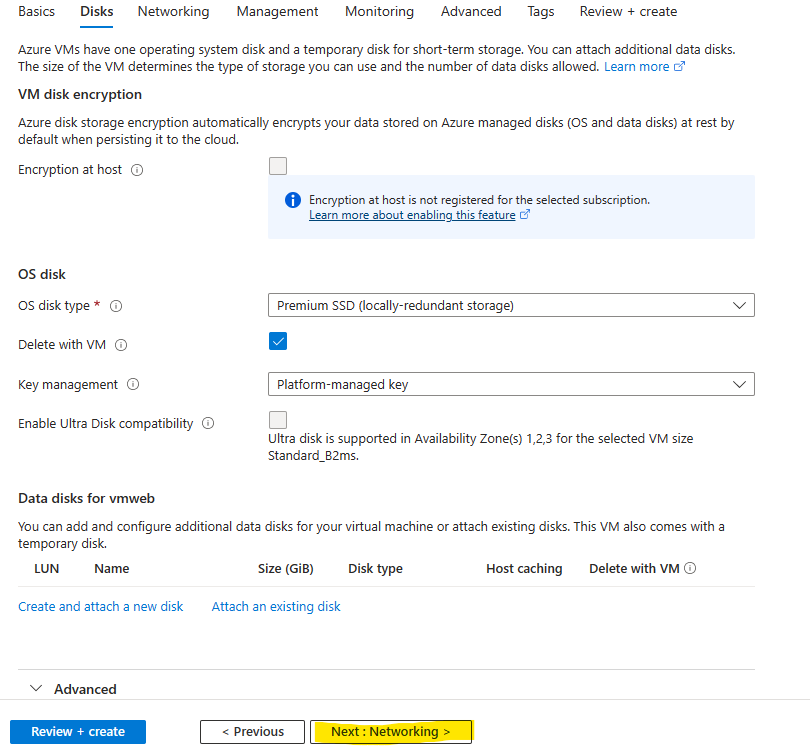

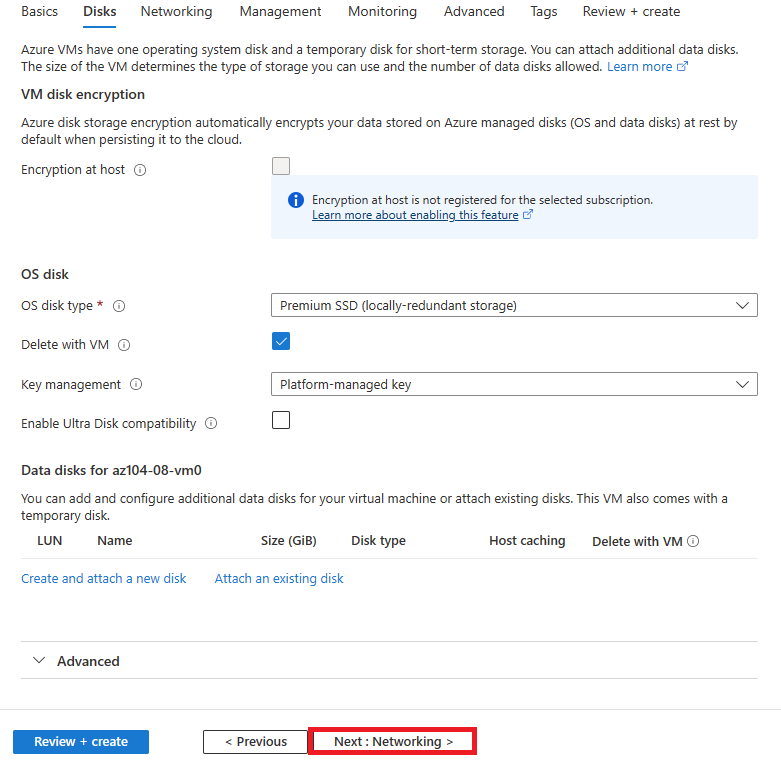

Aucune modification n’est à faire sur cet onglet, cliquez sur Suivant :

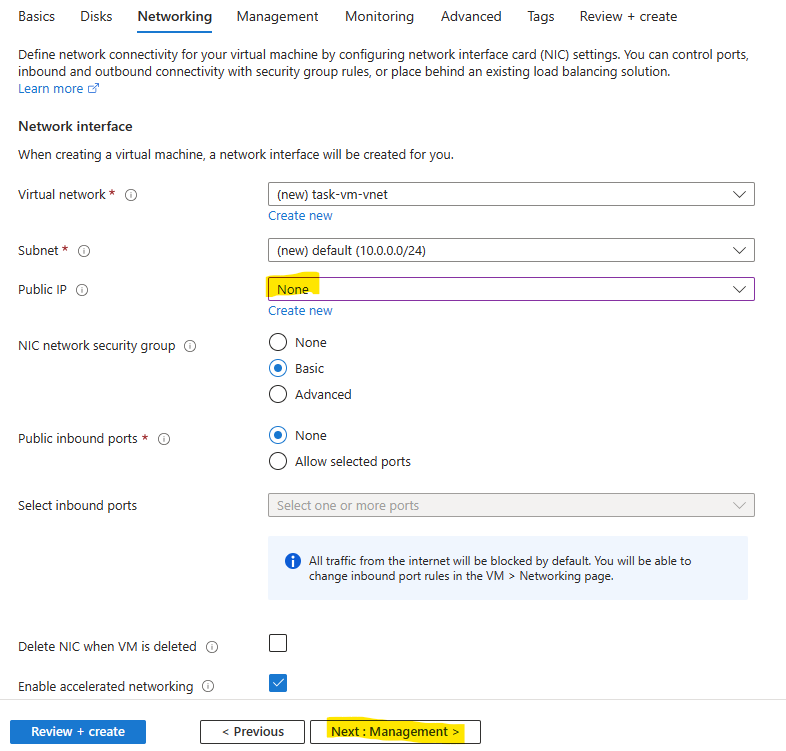

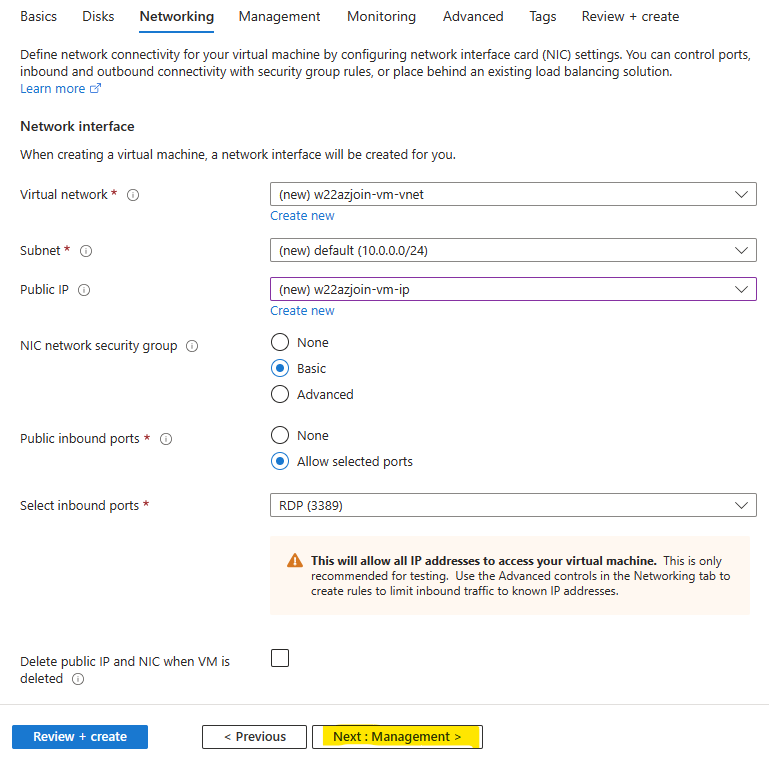

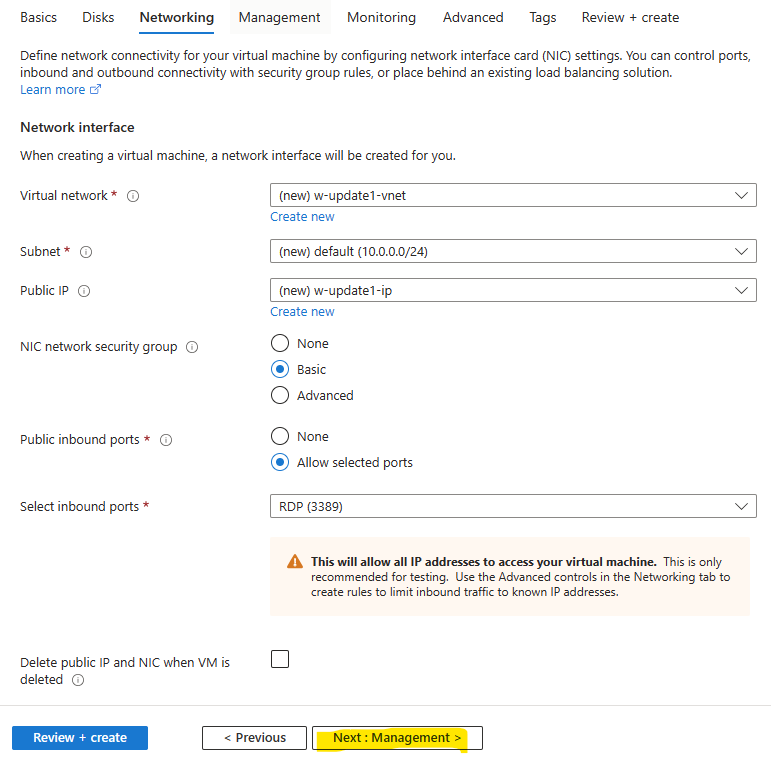

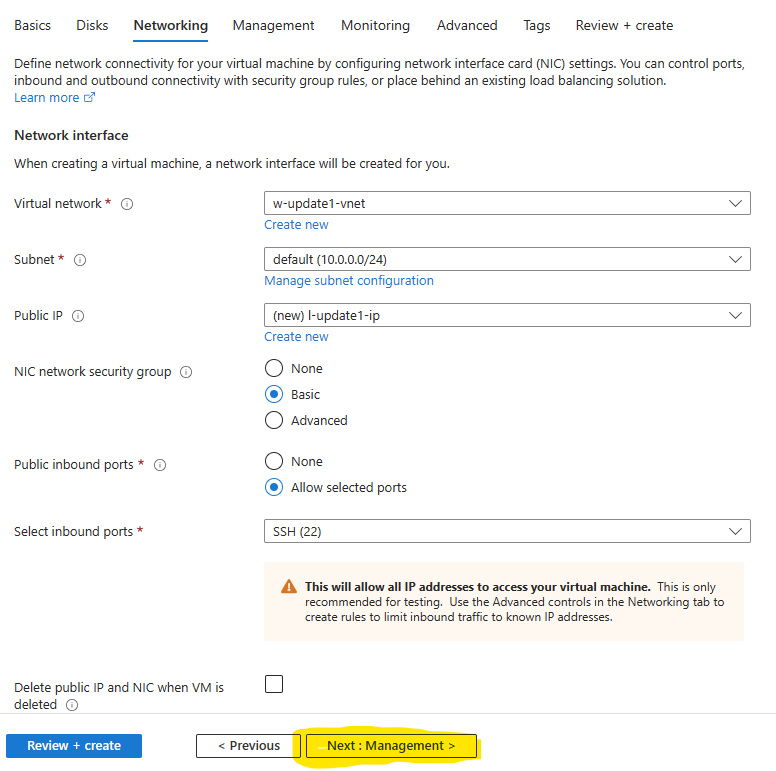

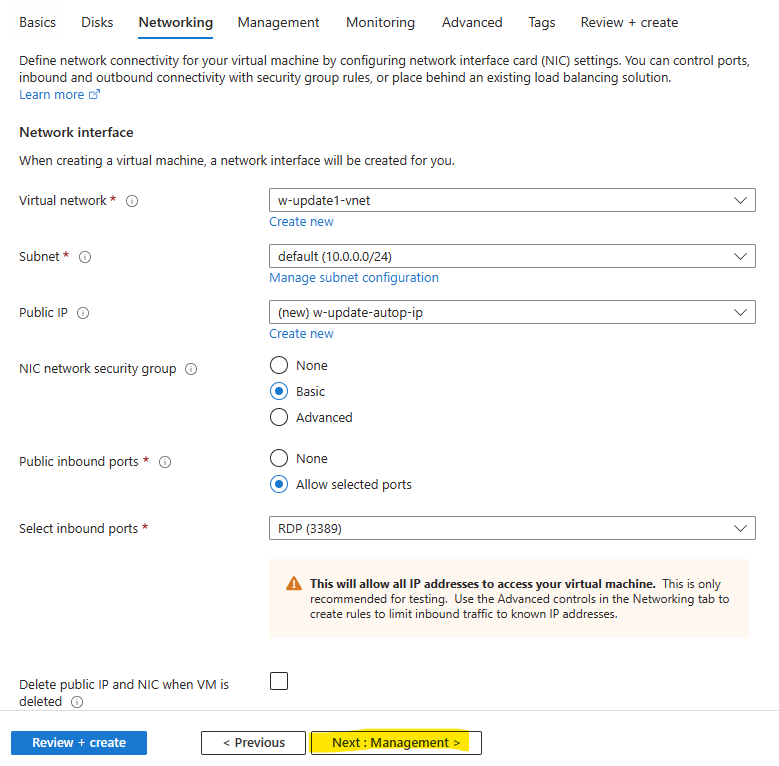

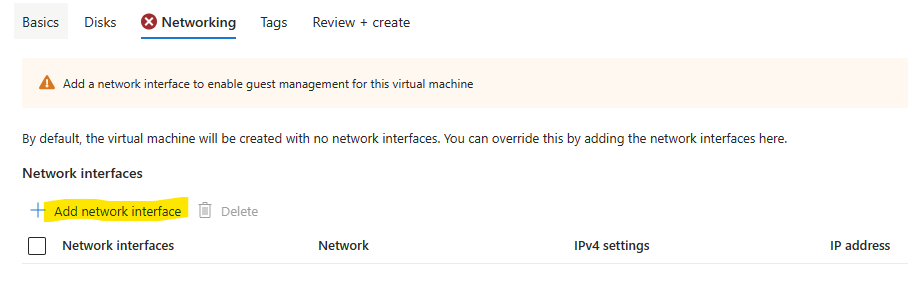

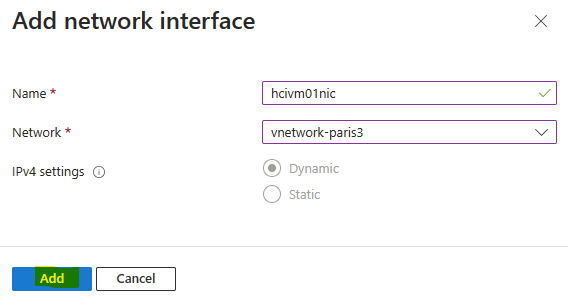

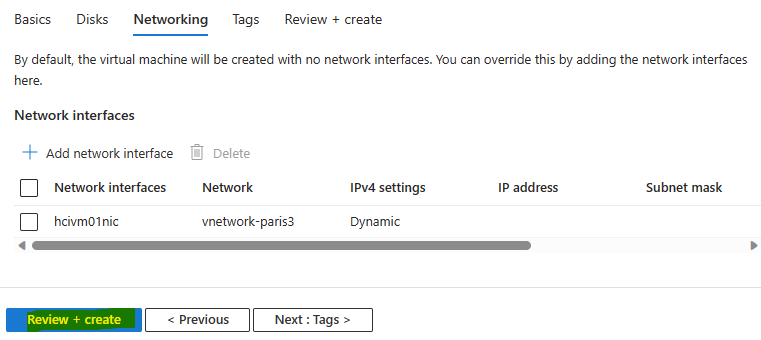

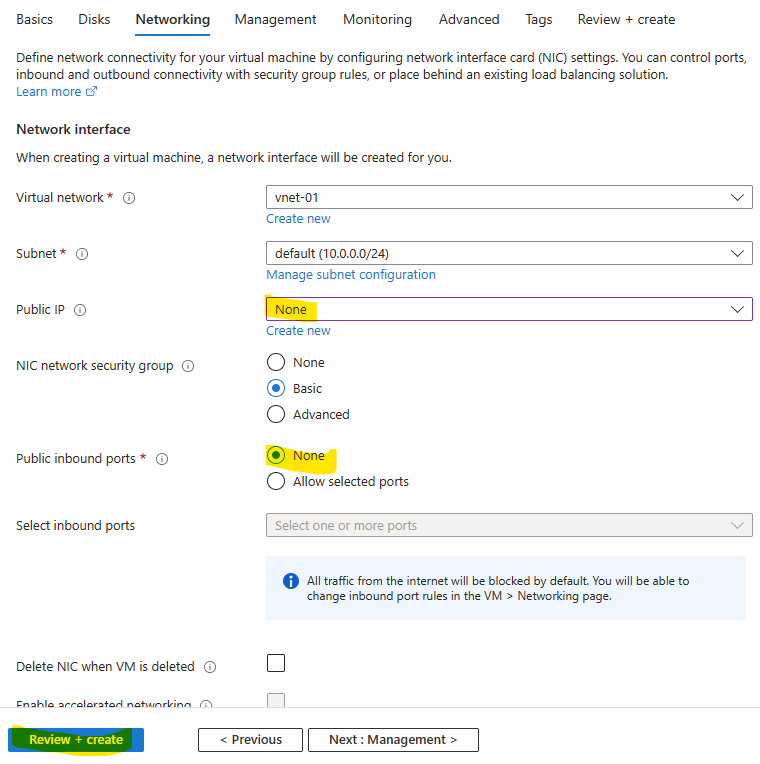

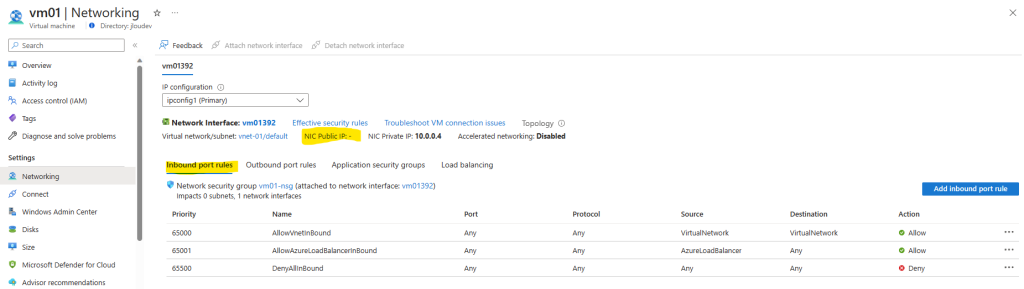

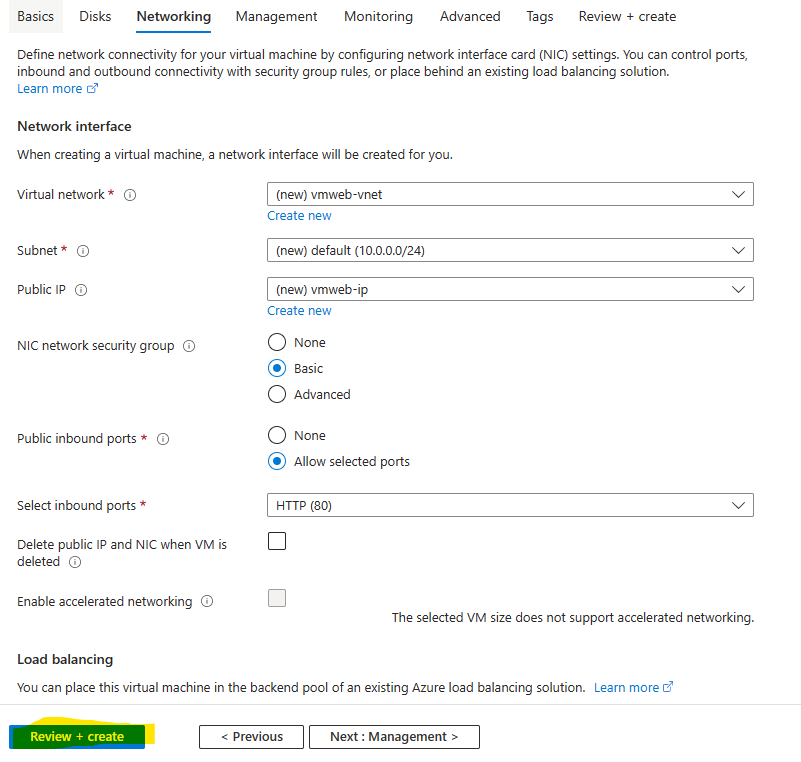

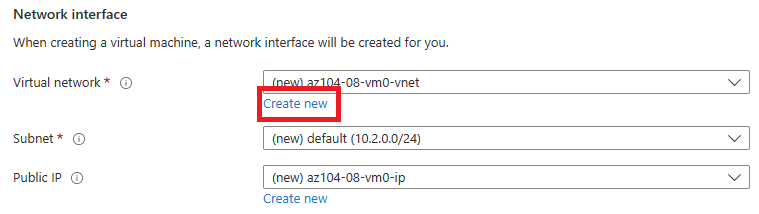

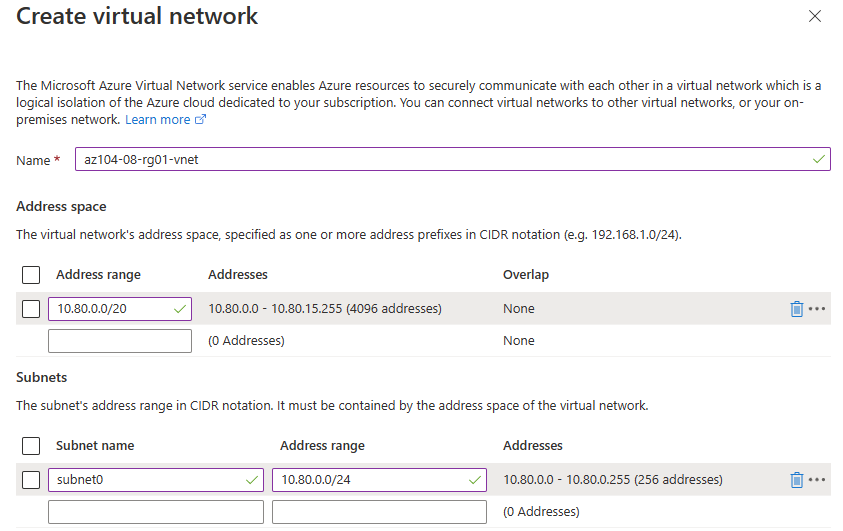

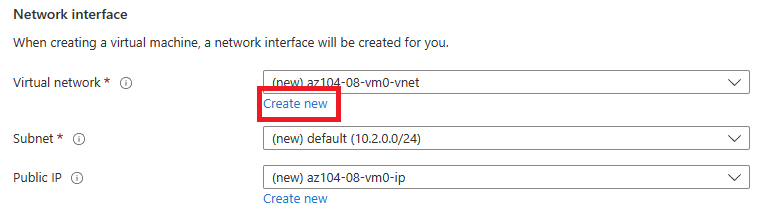

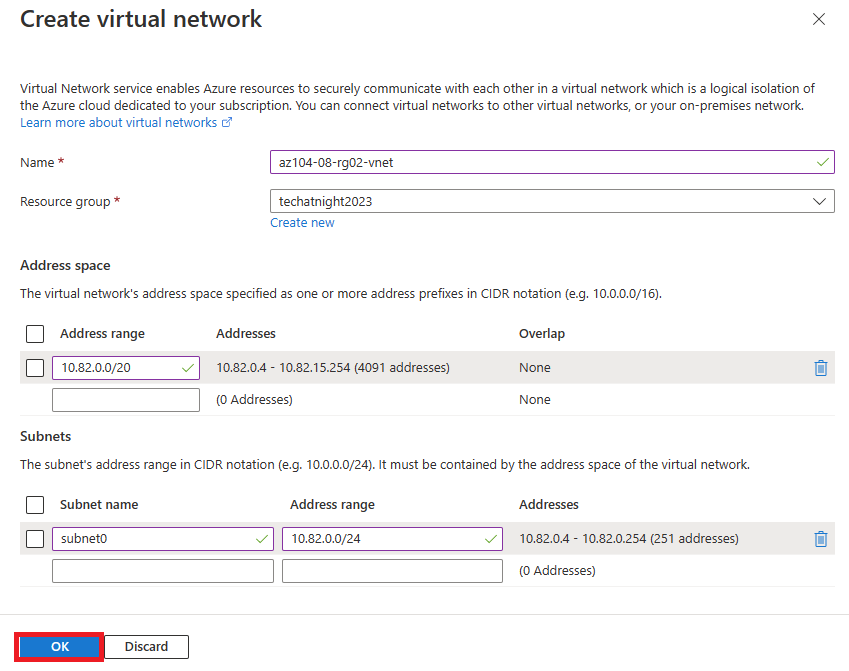

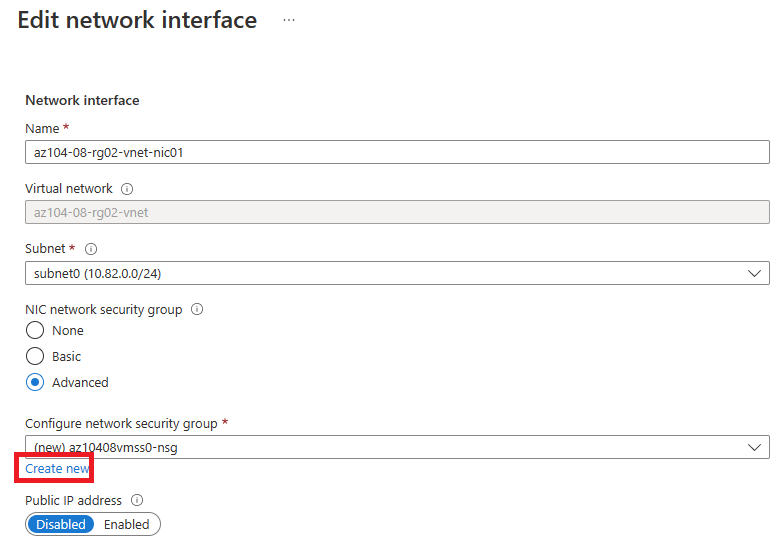

Retirez l’adresse IP publique, puis cliquez sur Suivant :

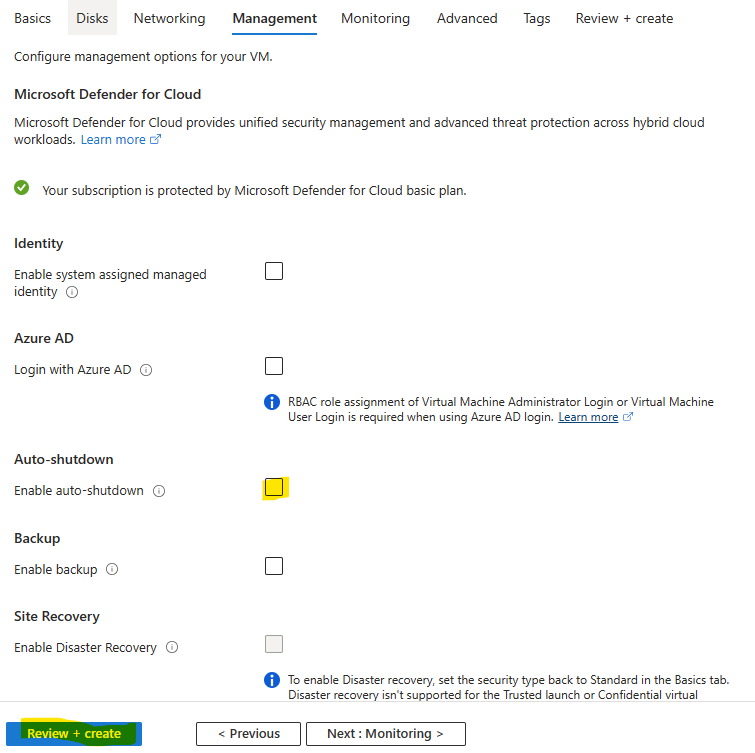

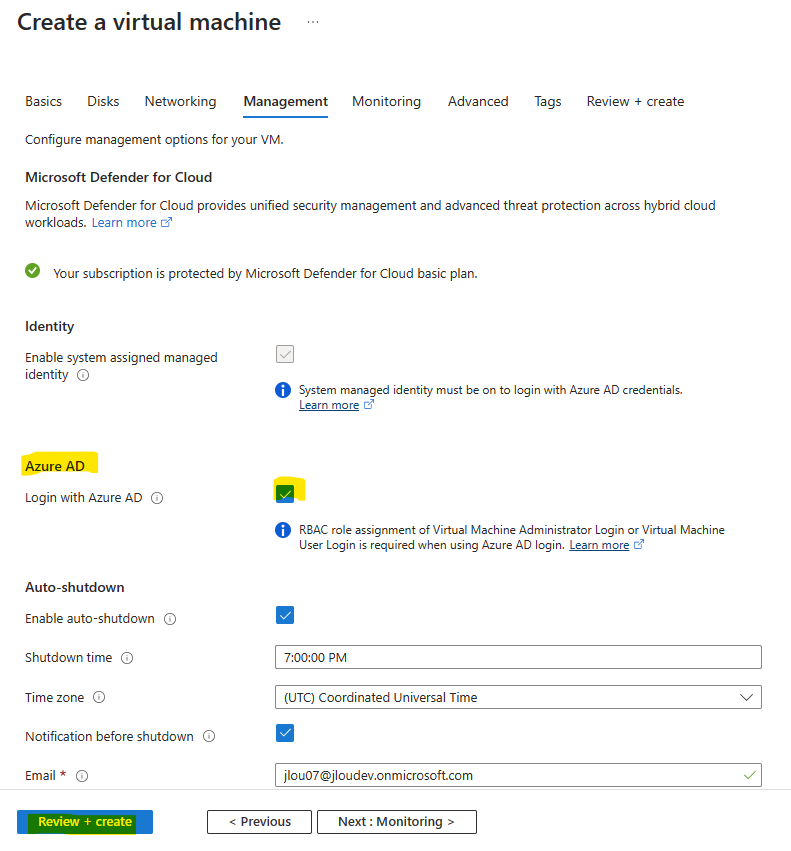

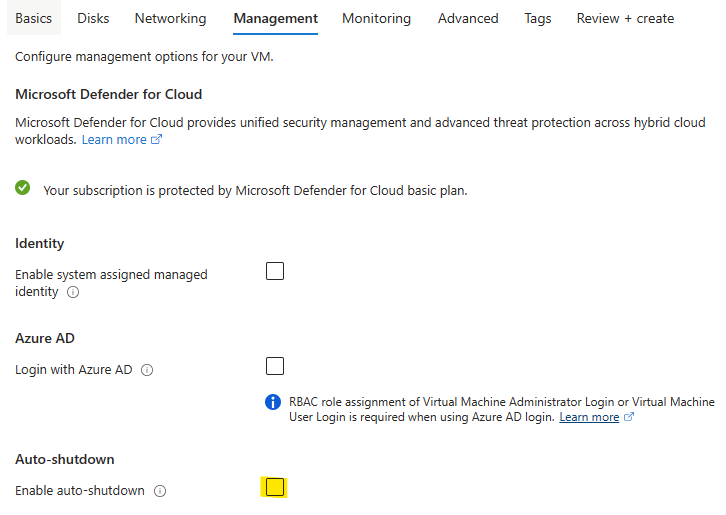

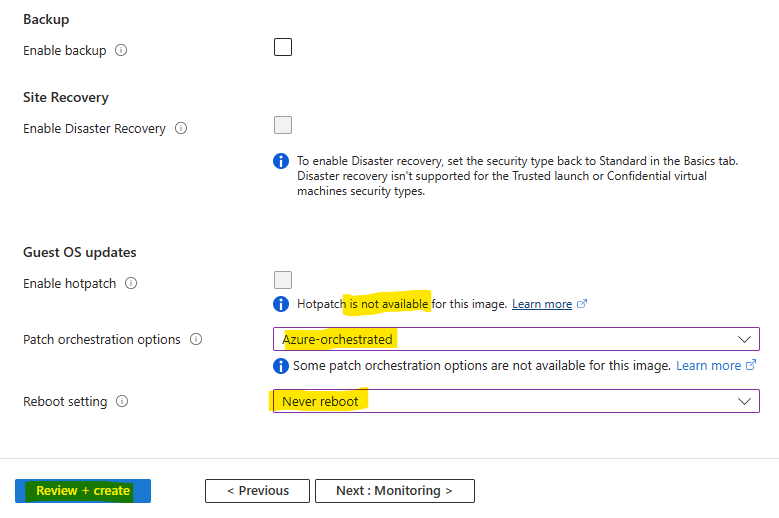

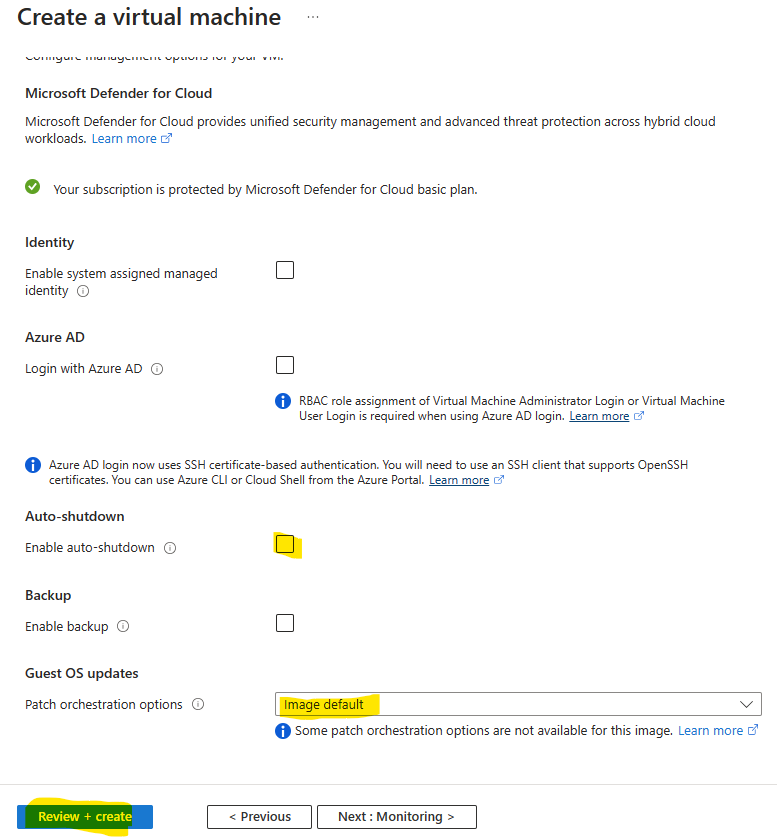

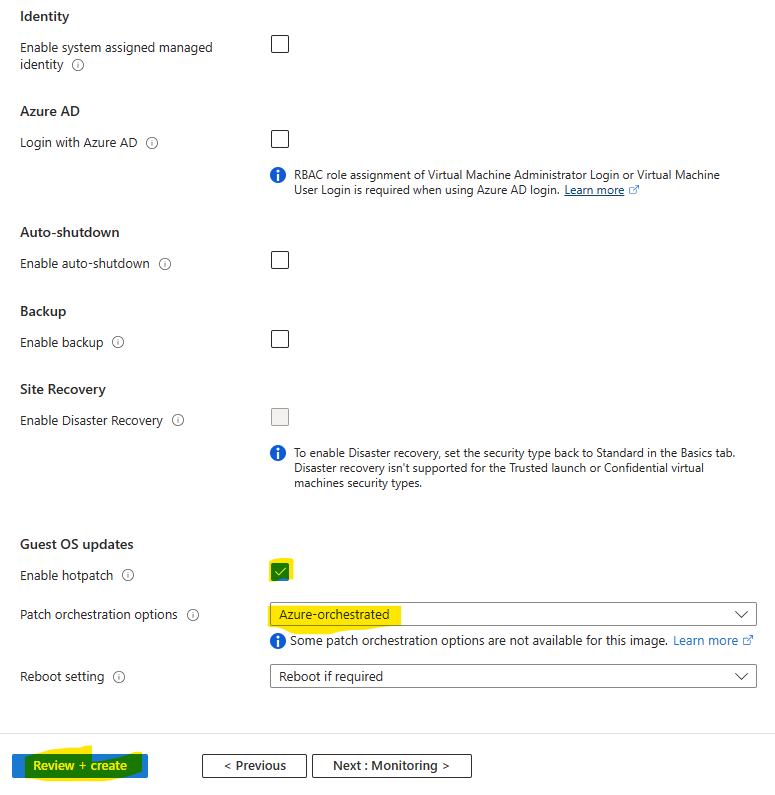

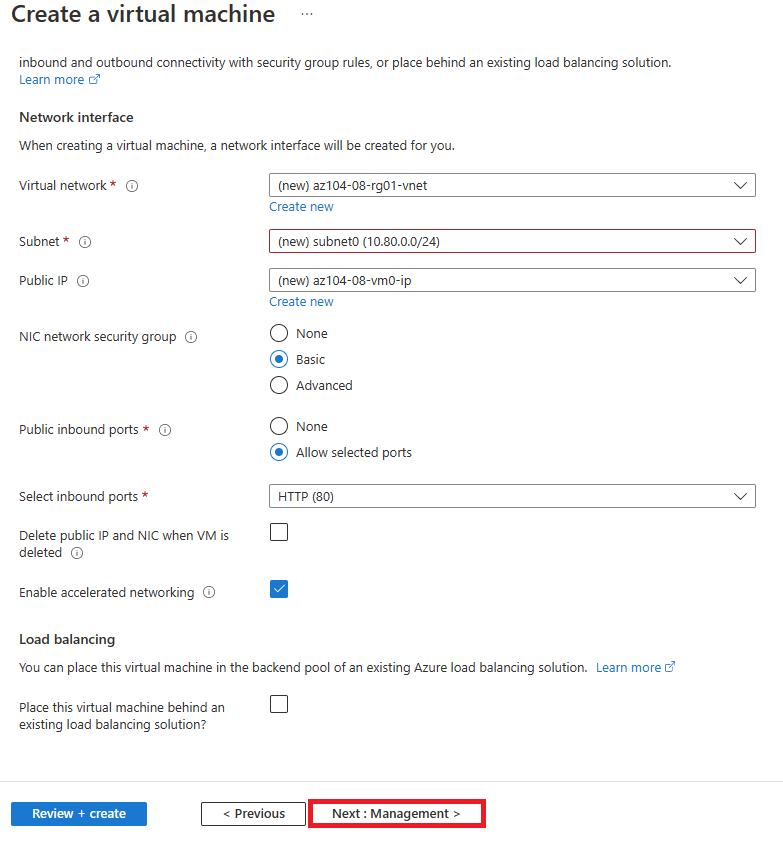

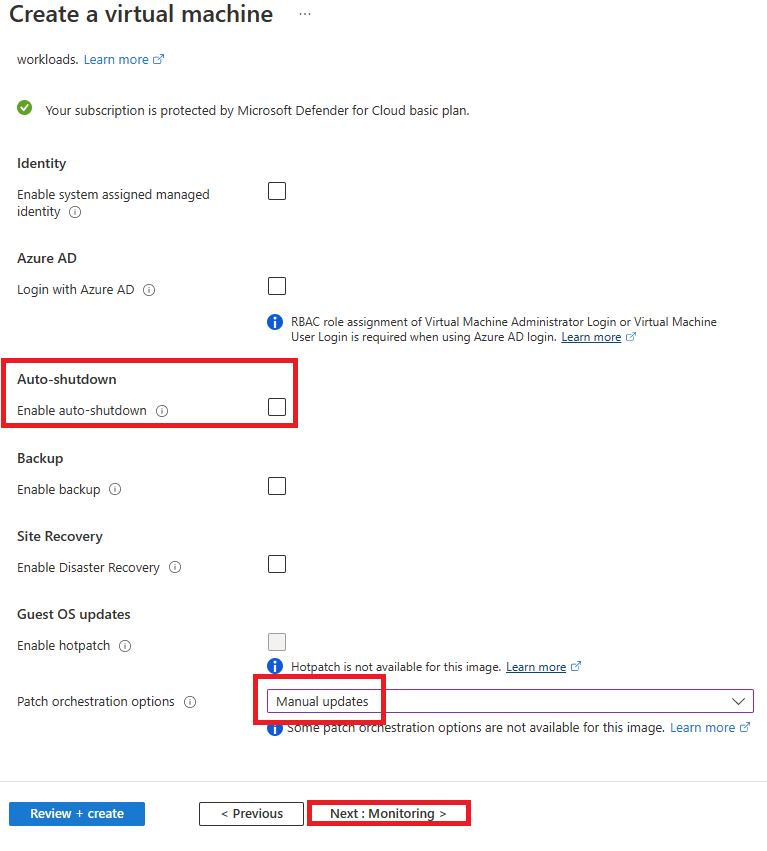

Décochez l’extinction automatique de la machine virtuelle, puis lancez la validation Azure :

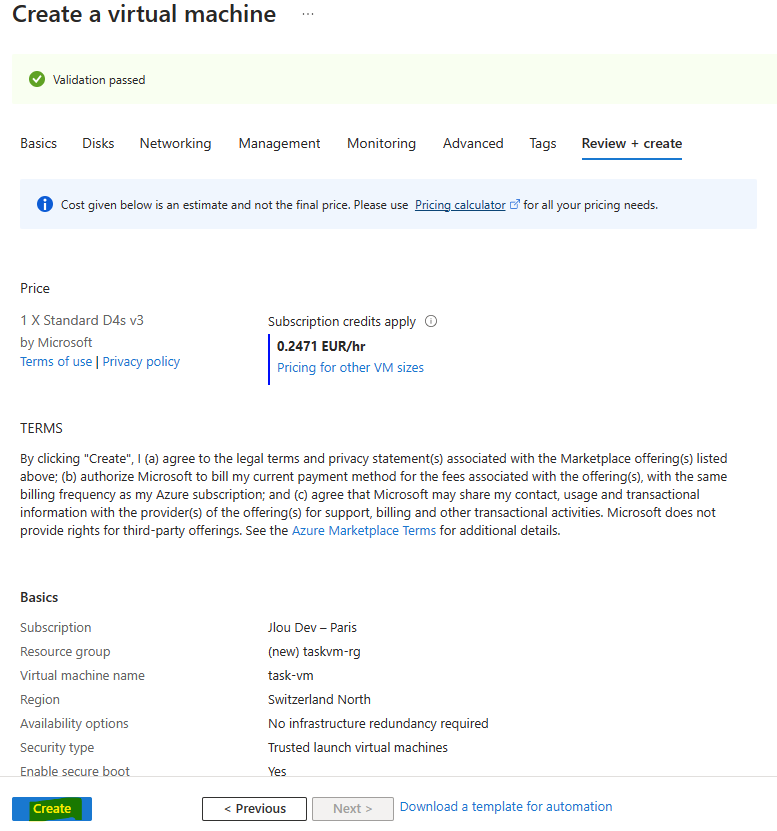

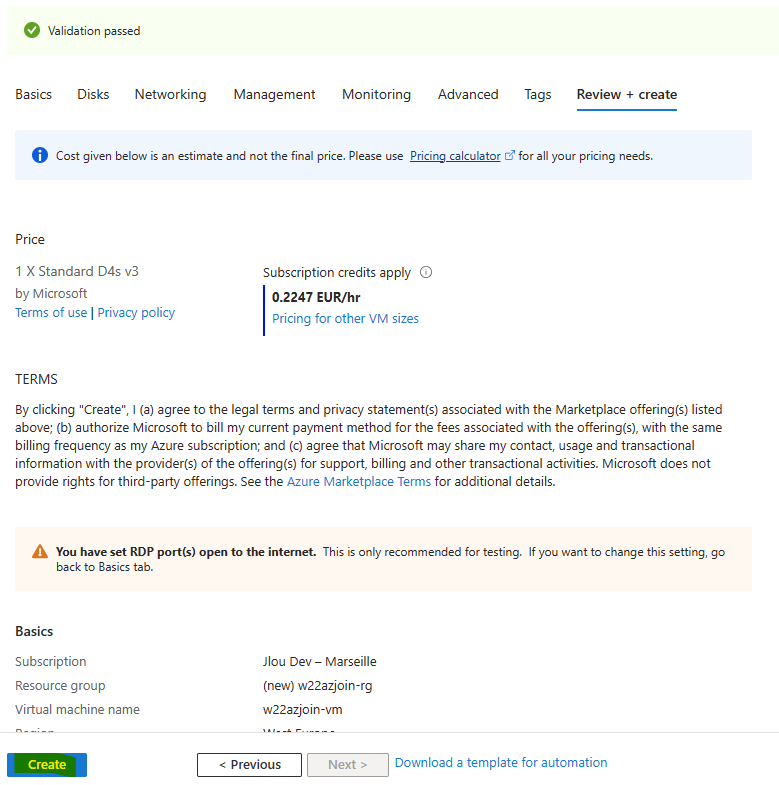

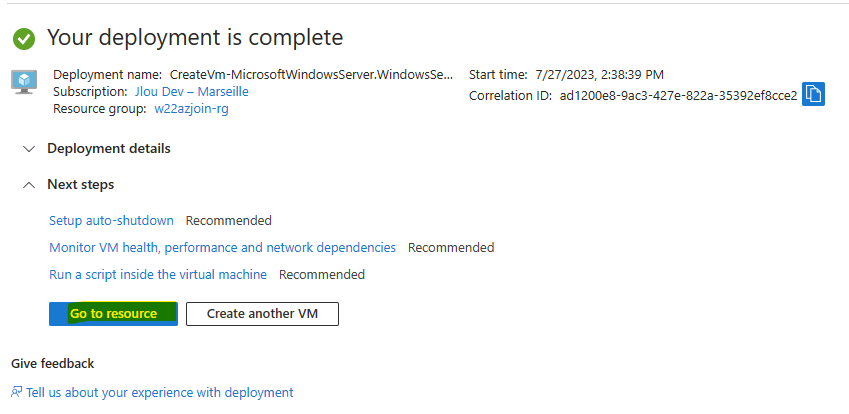

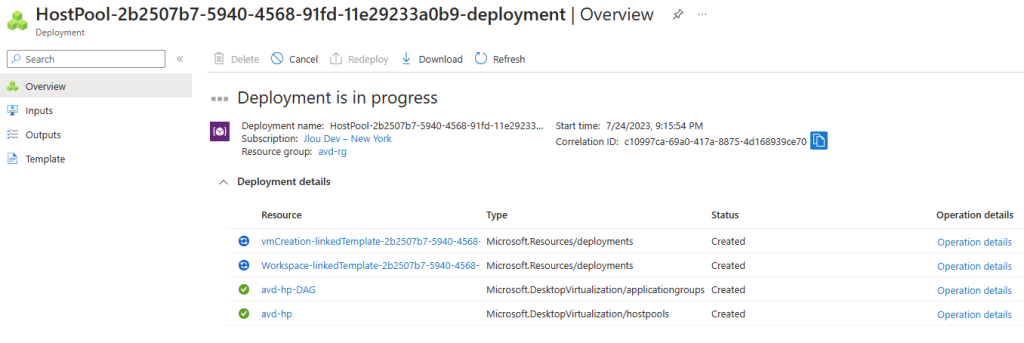

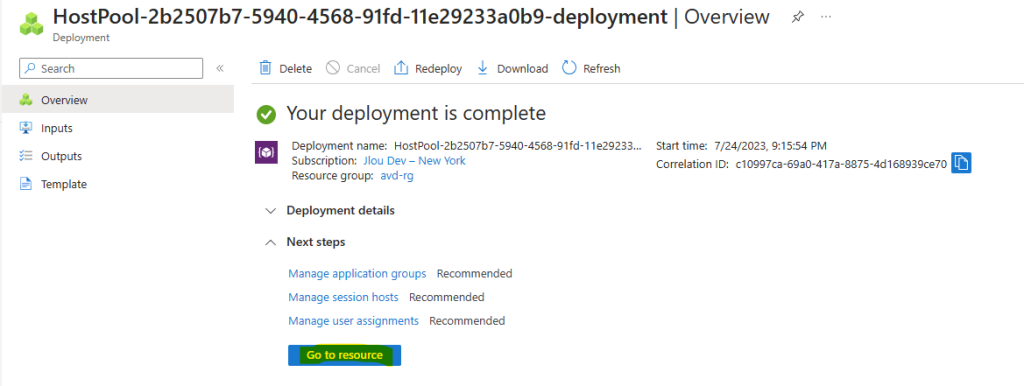

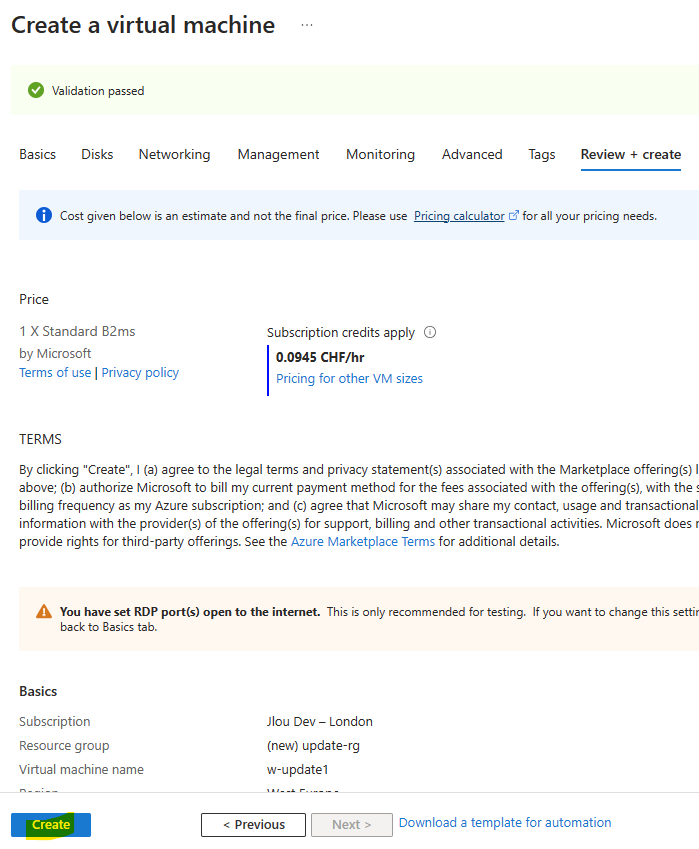

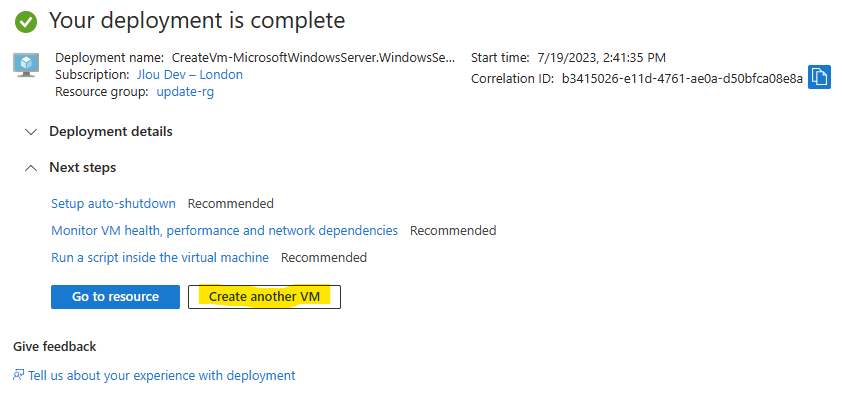

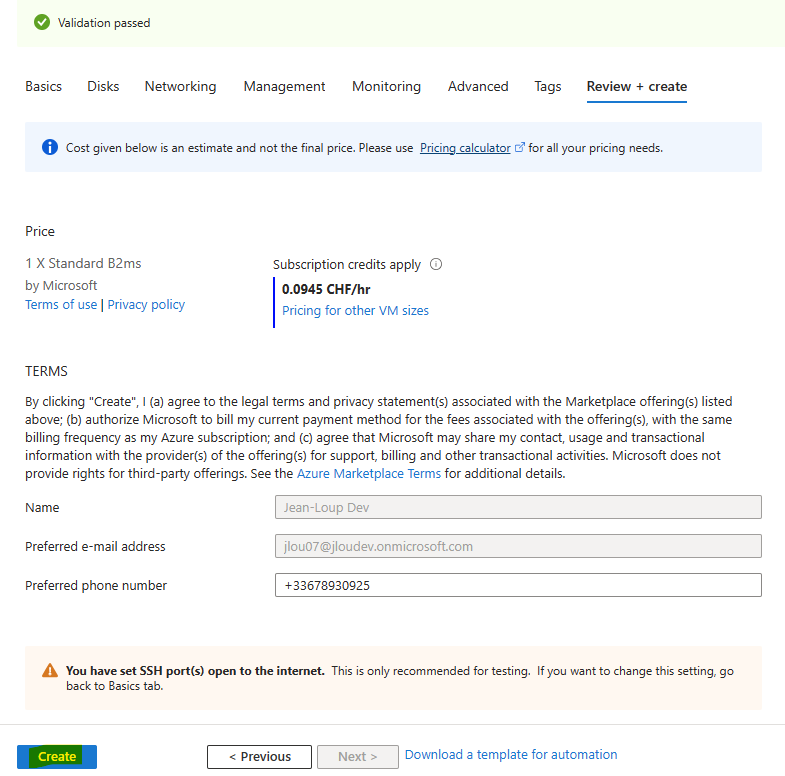

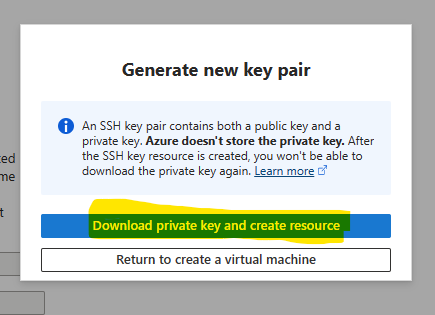

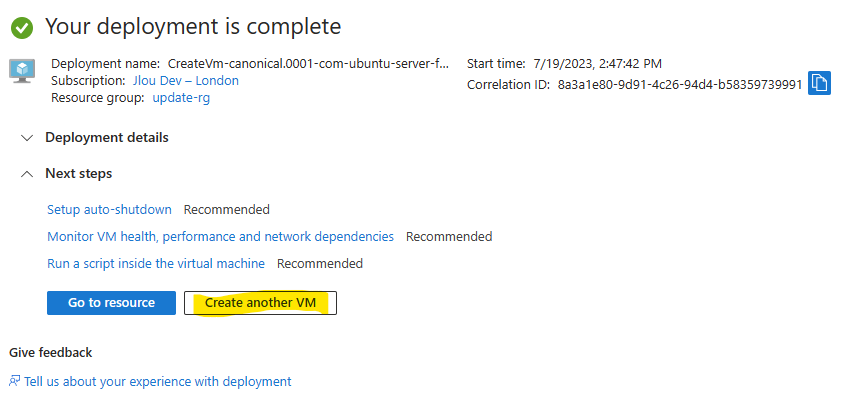

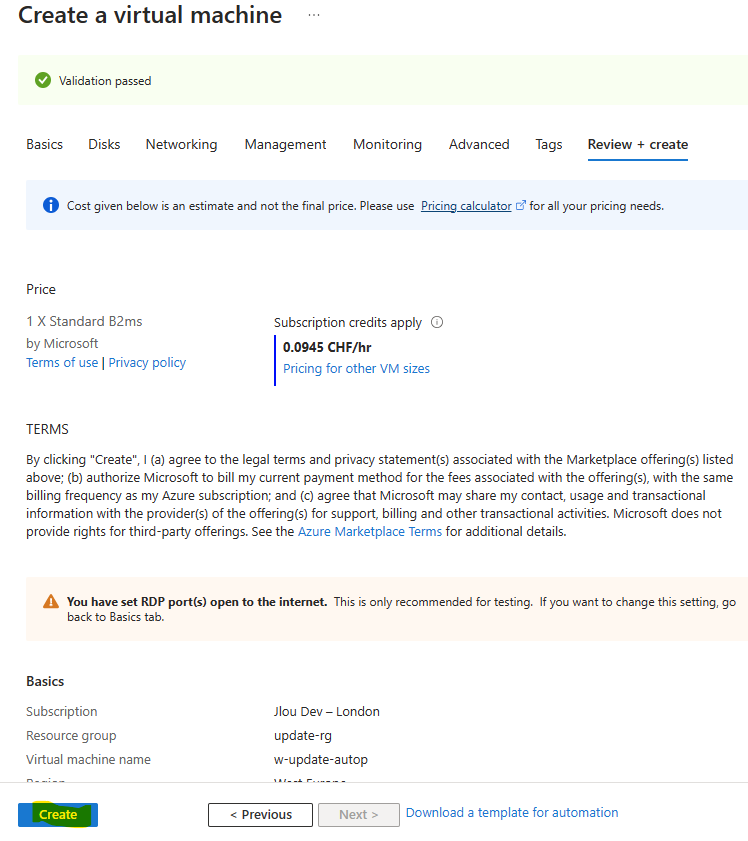

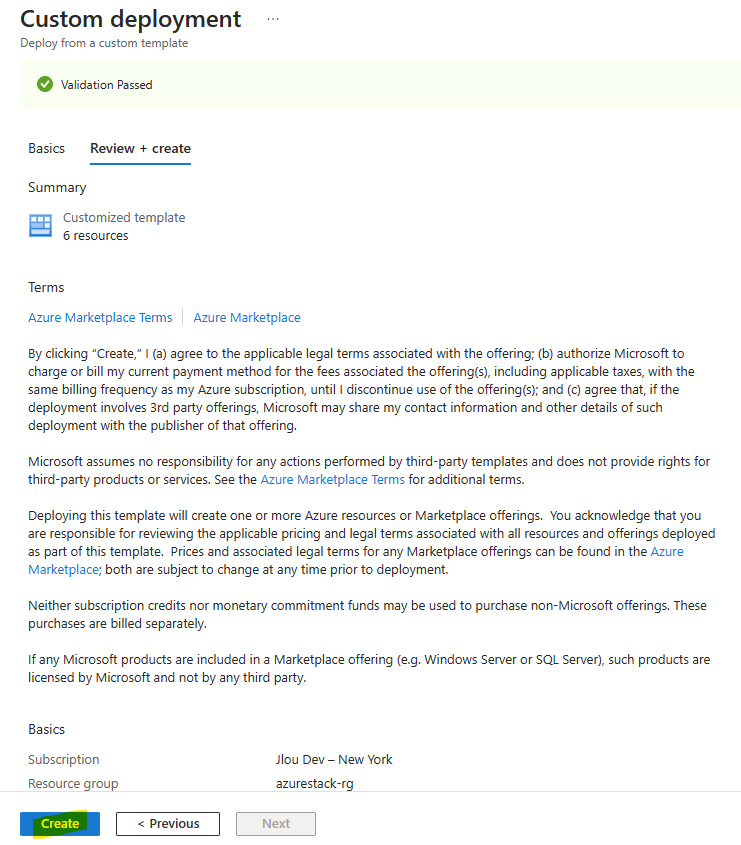

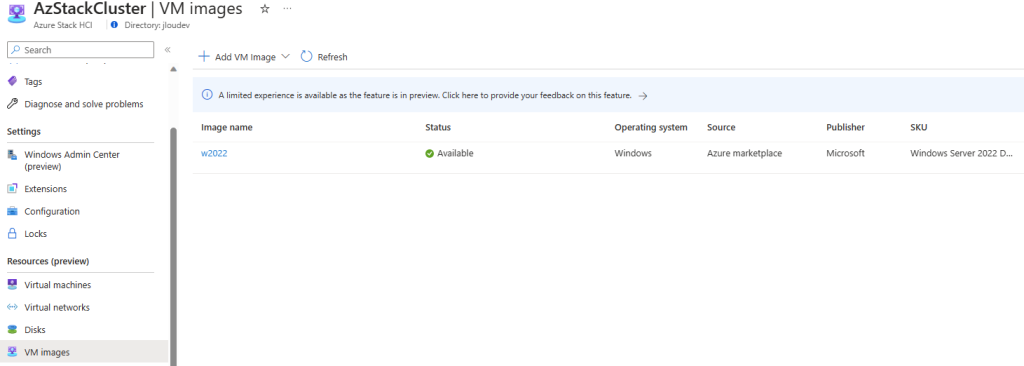

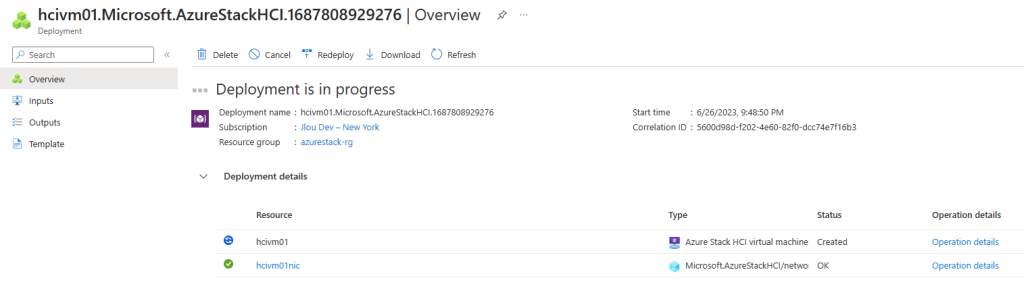

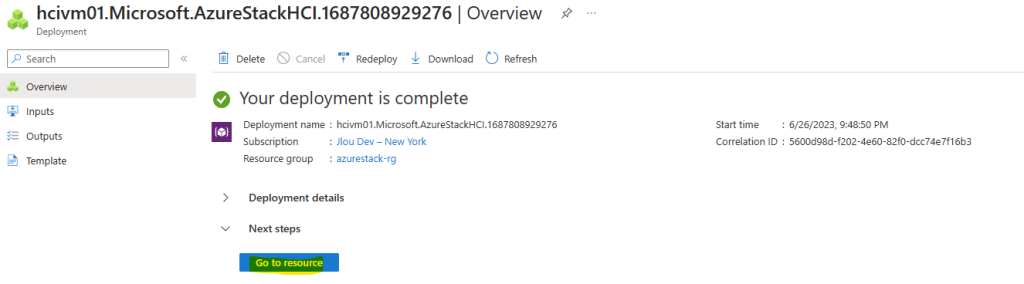

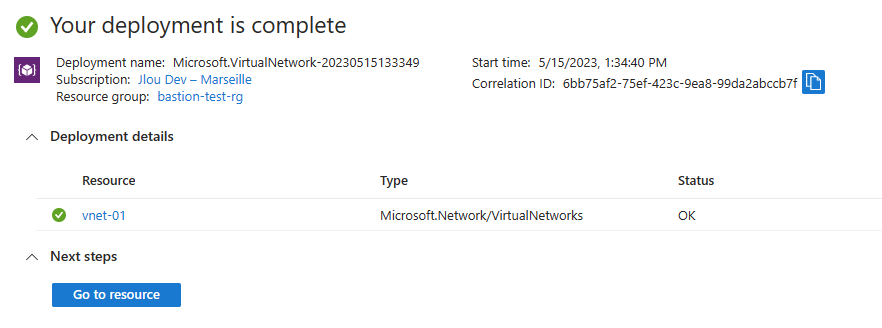

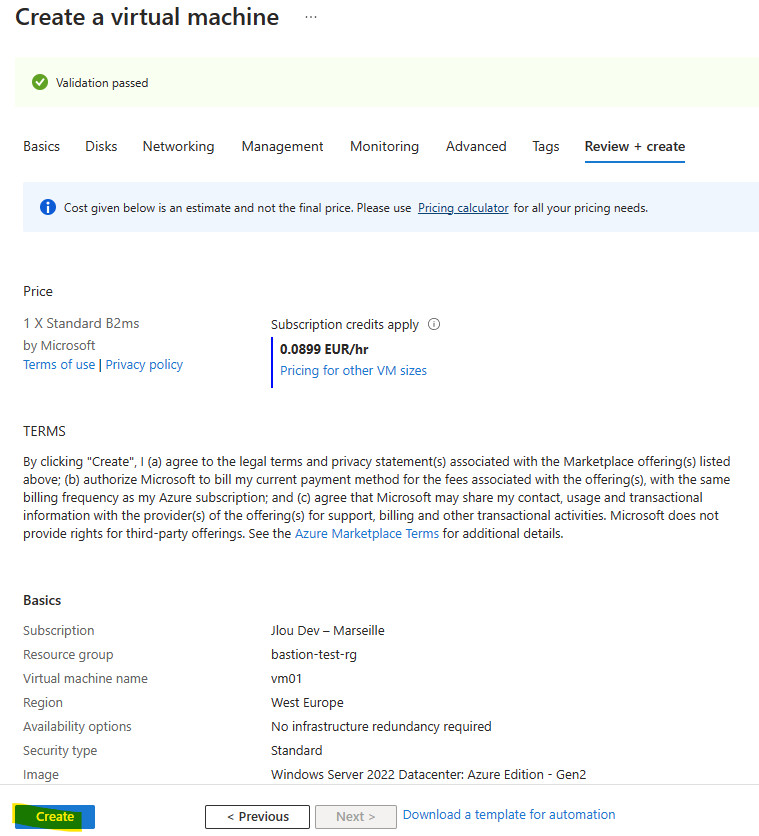

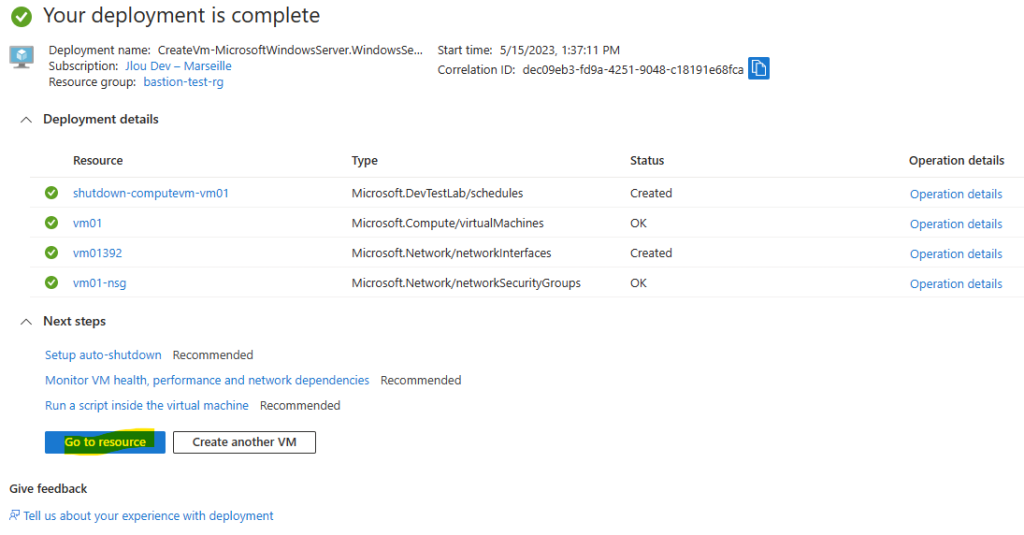

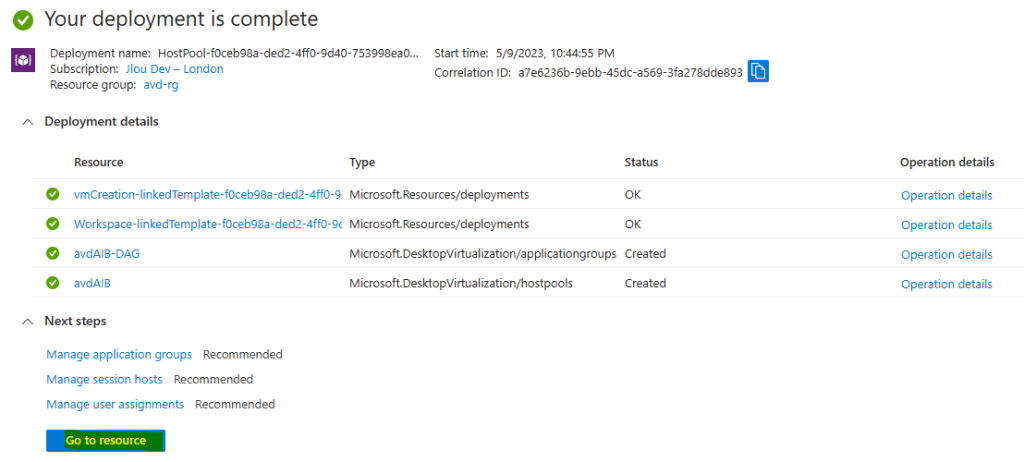

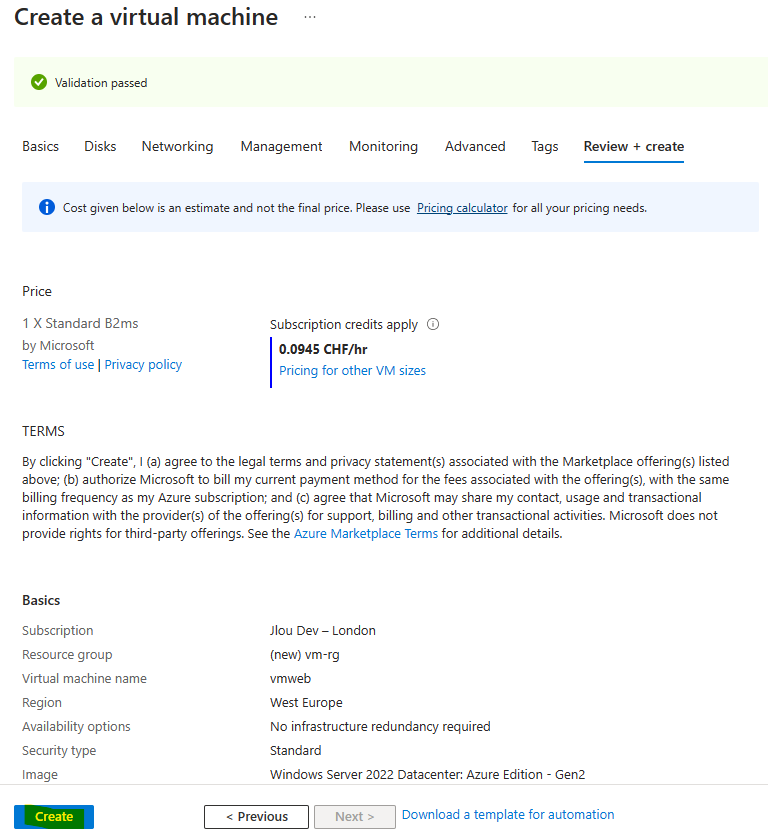

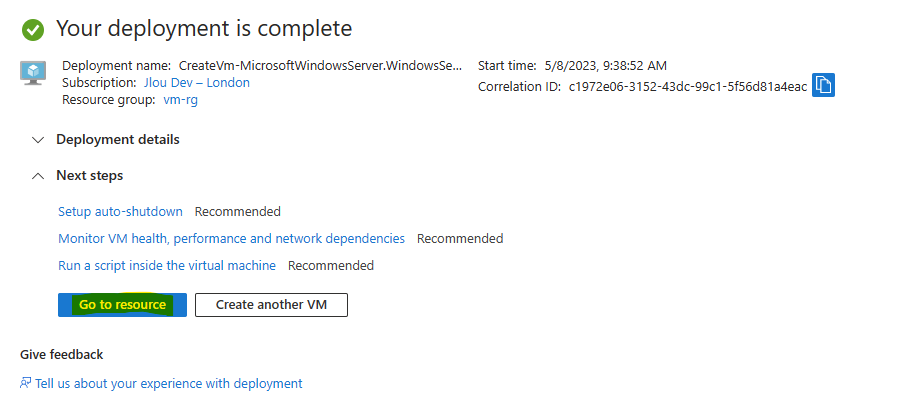

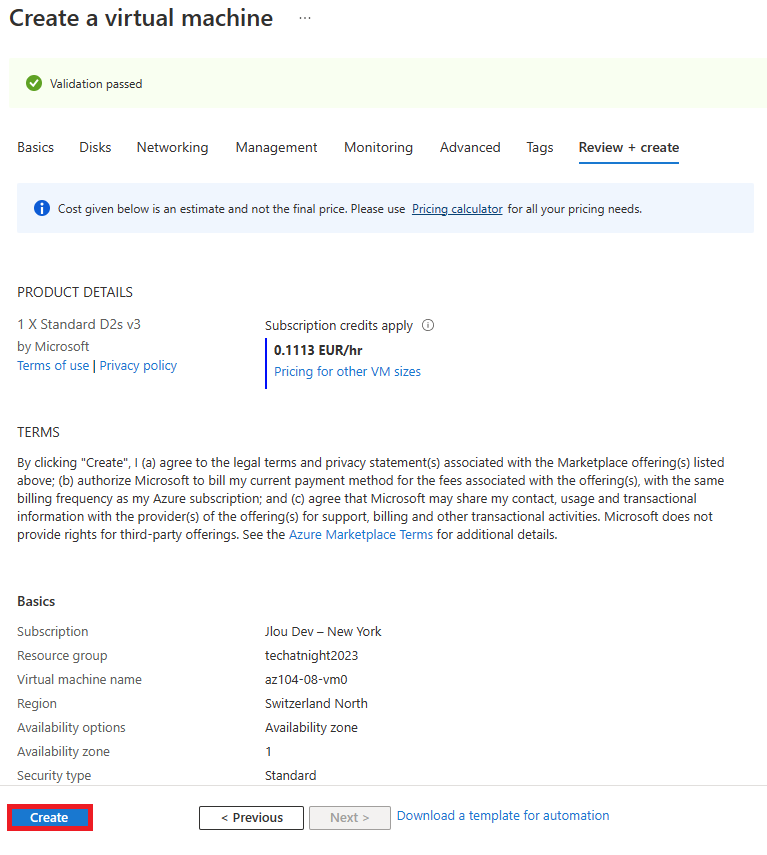

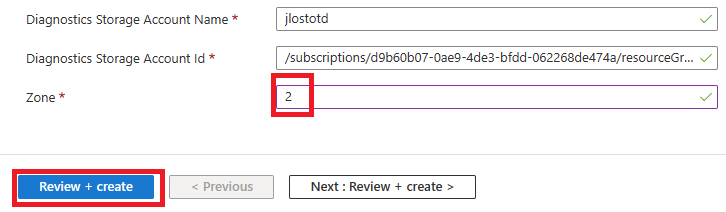

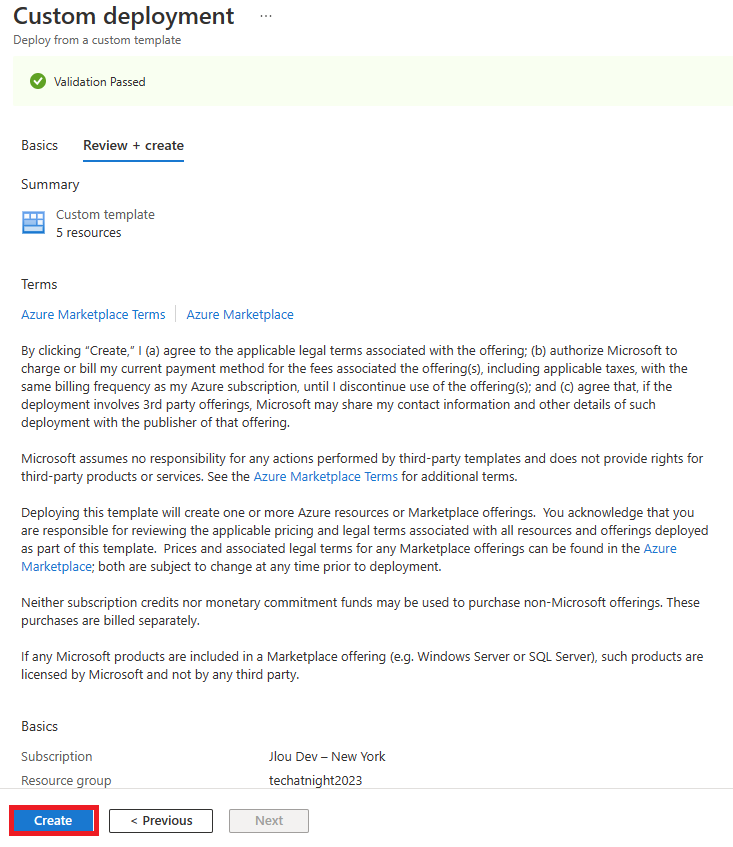

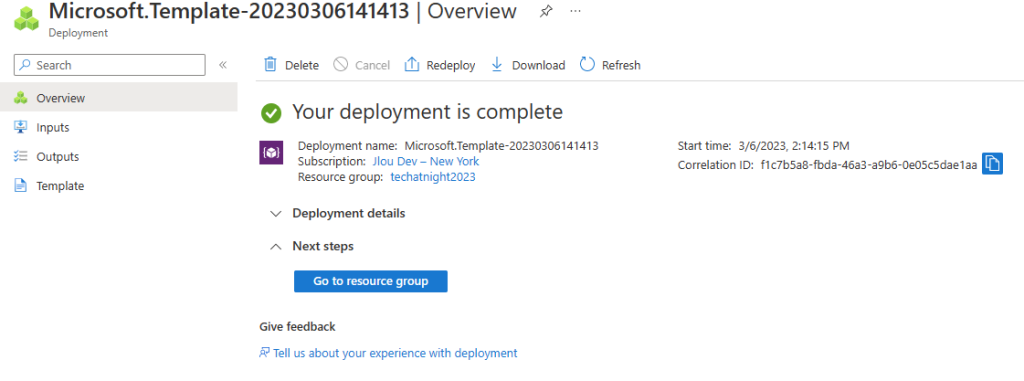

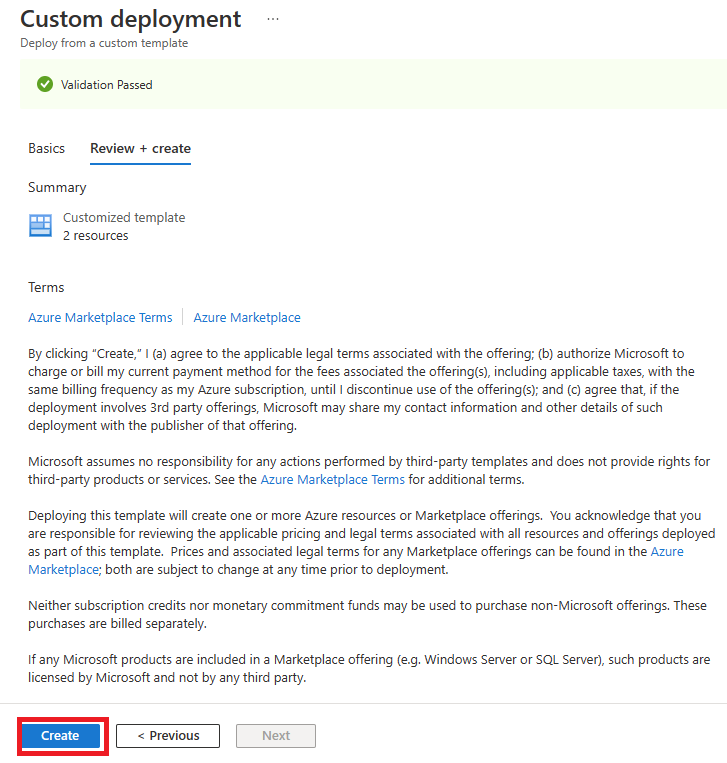

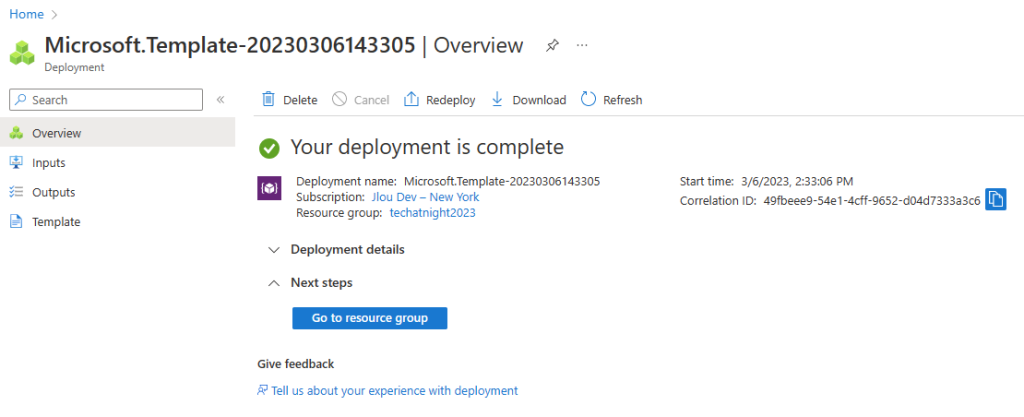

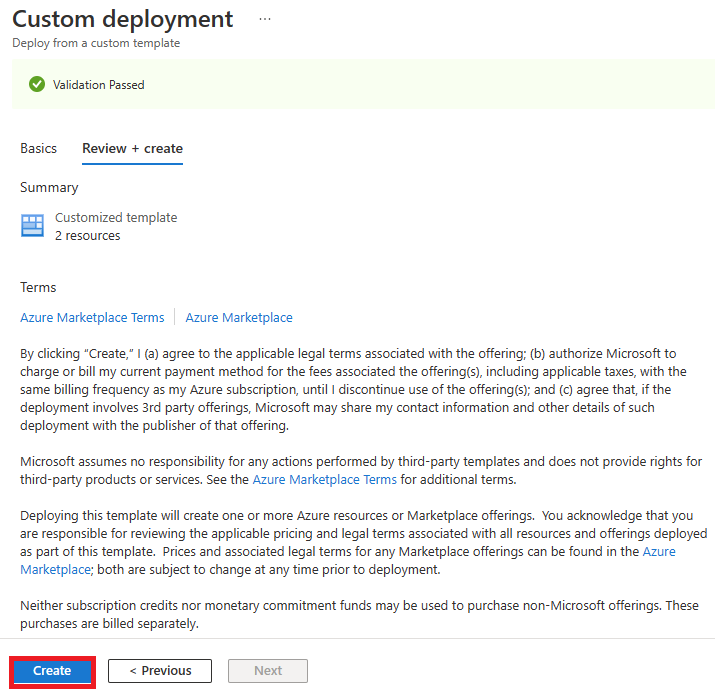

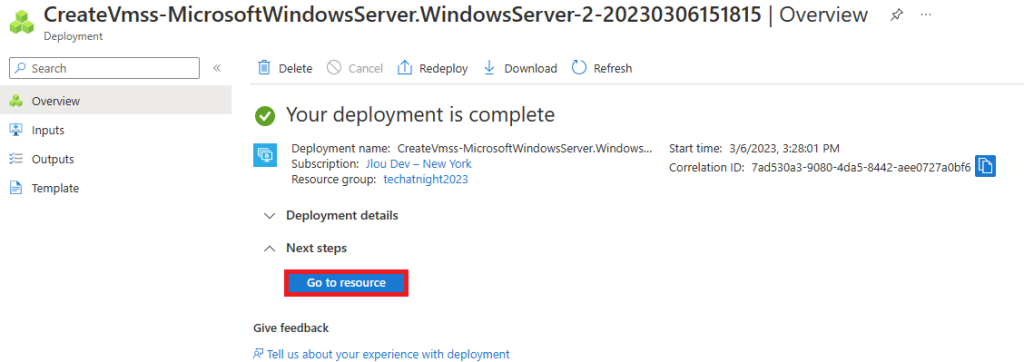

Une fois la validation Azure réussie, lancez la création des ressources puis attendez environ 3 minutes :

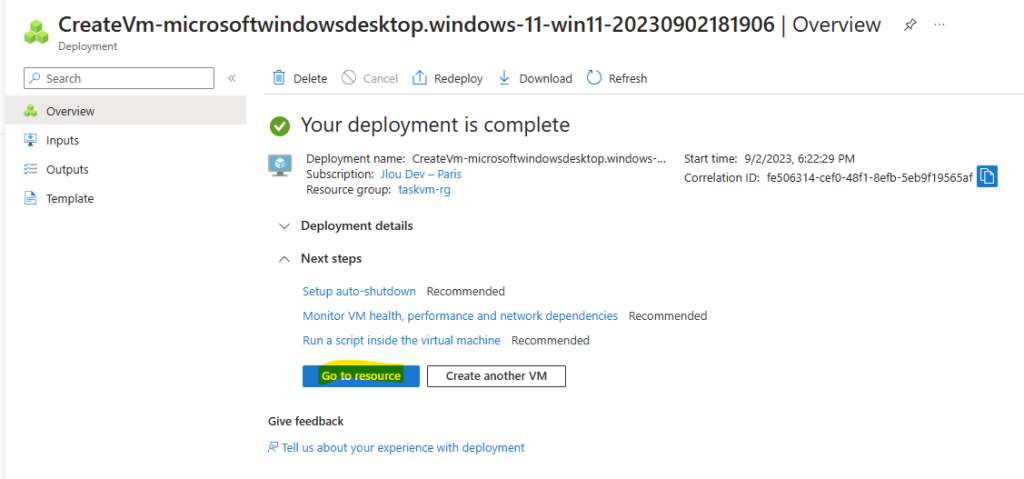

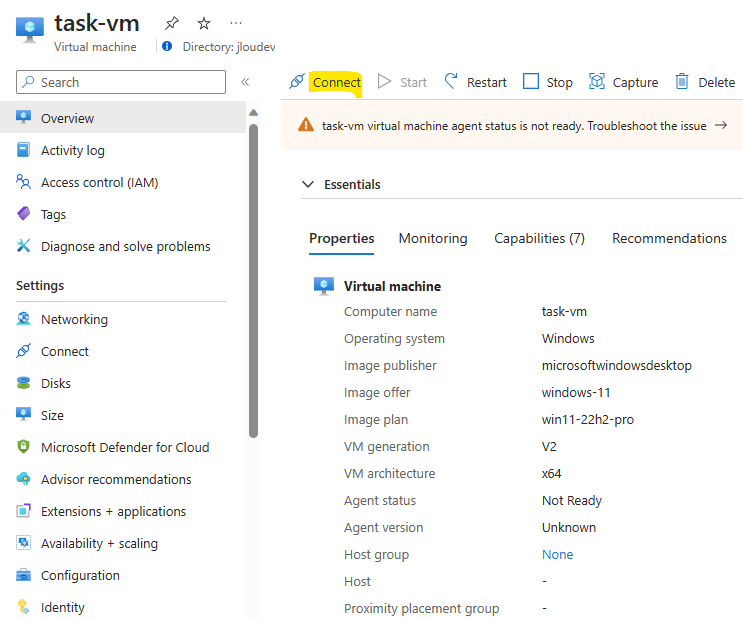

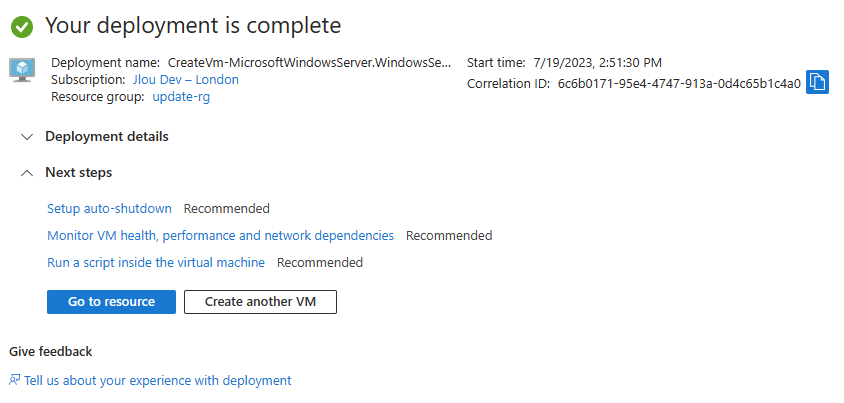

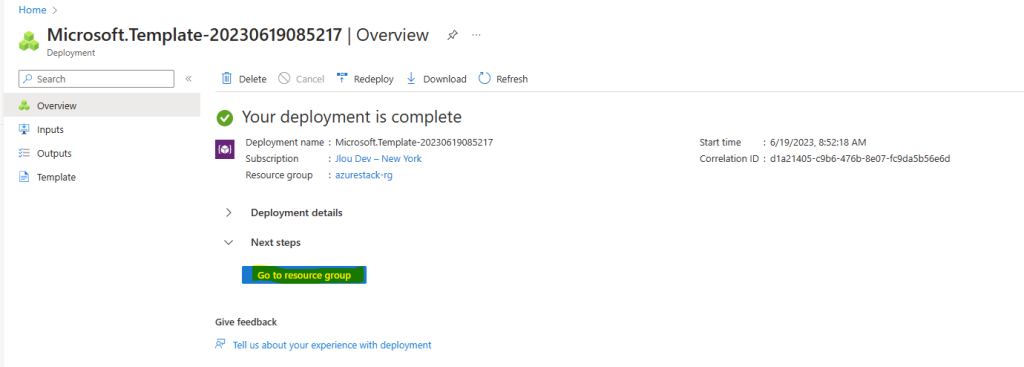

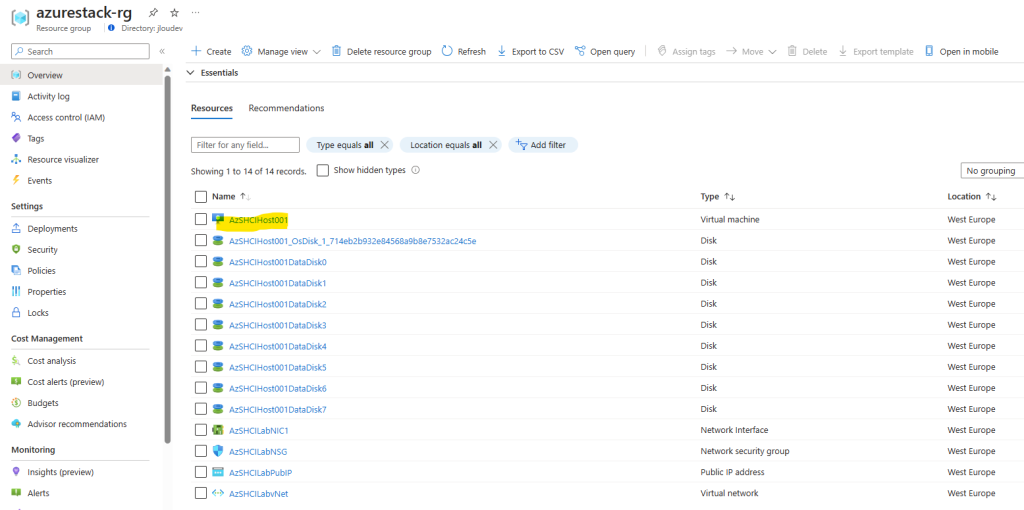

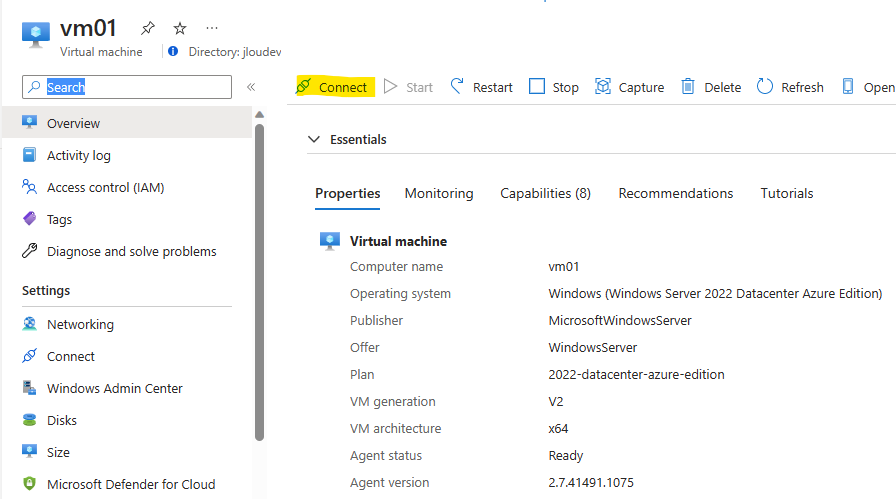

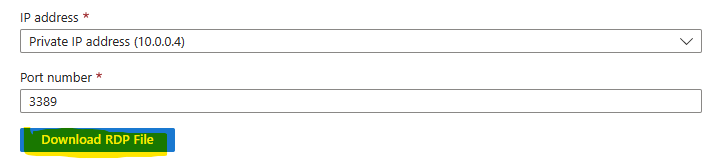

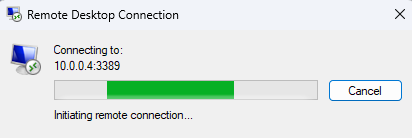

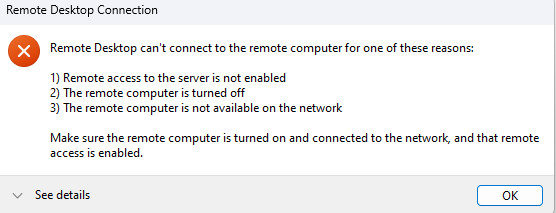

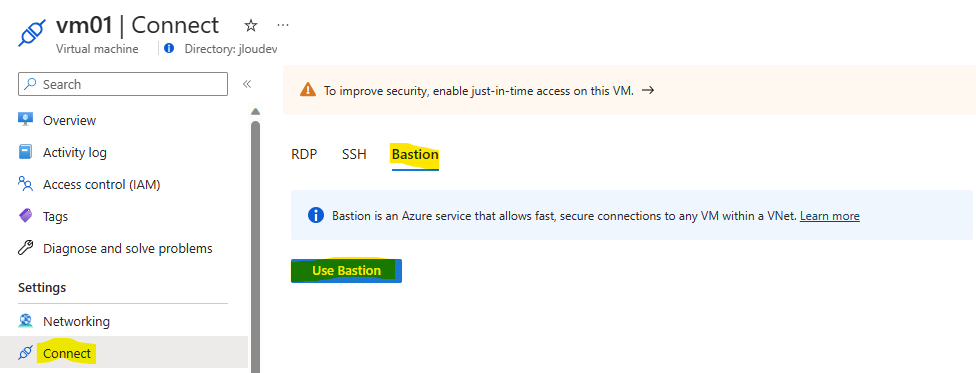

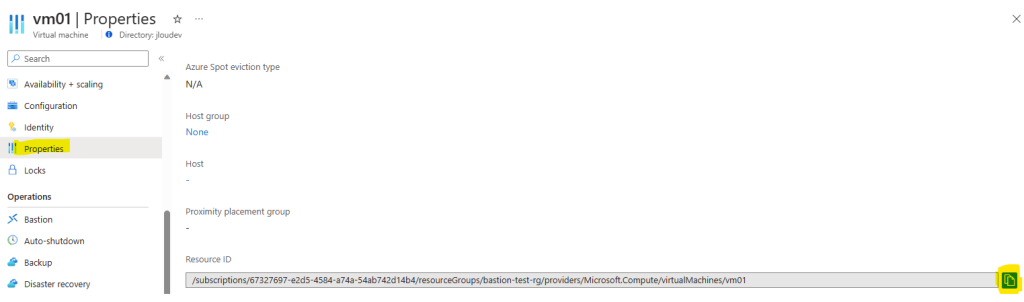

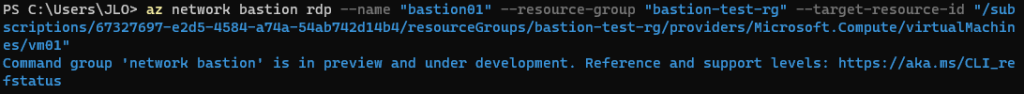

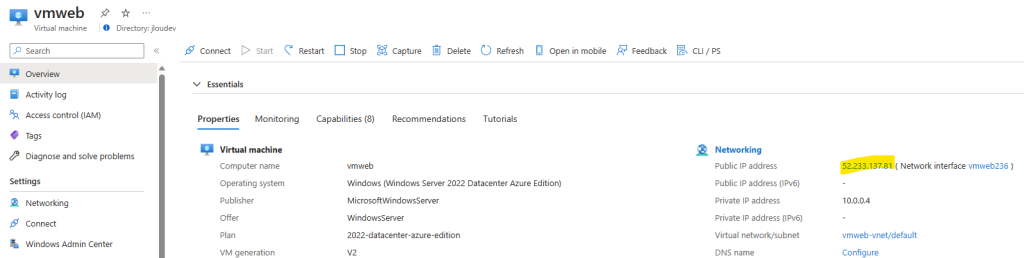

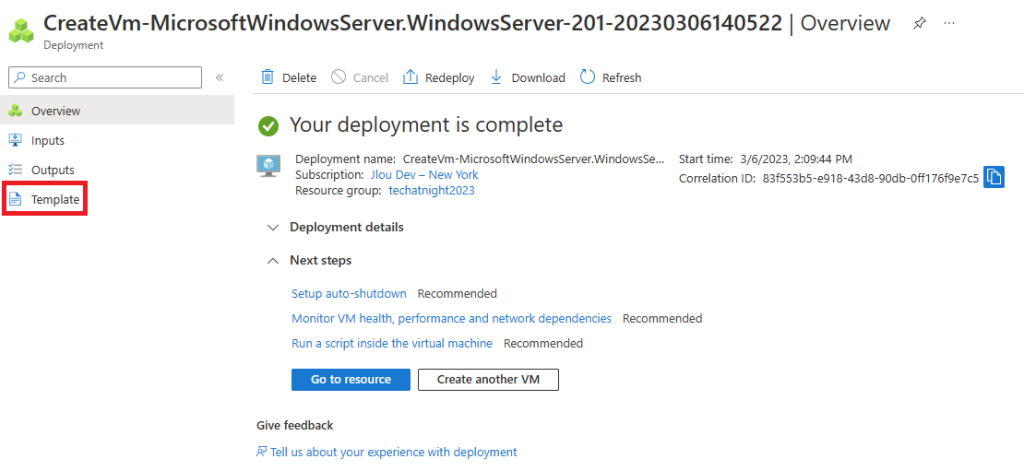

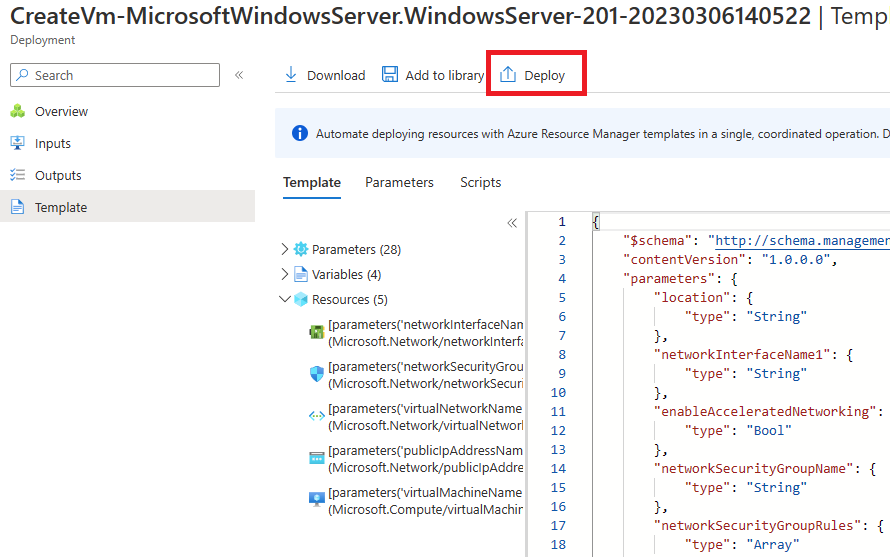

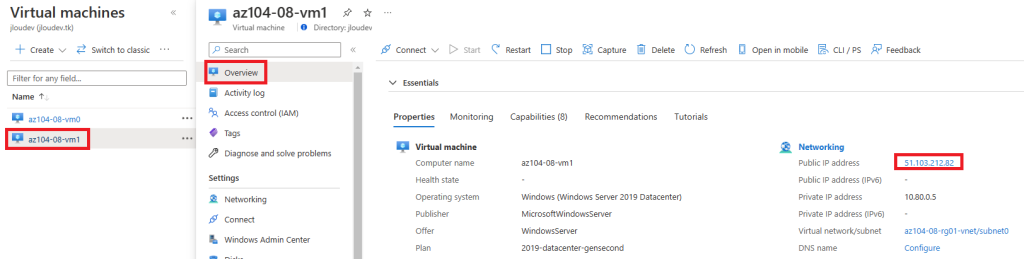

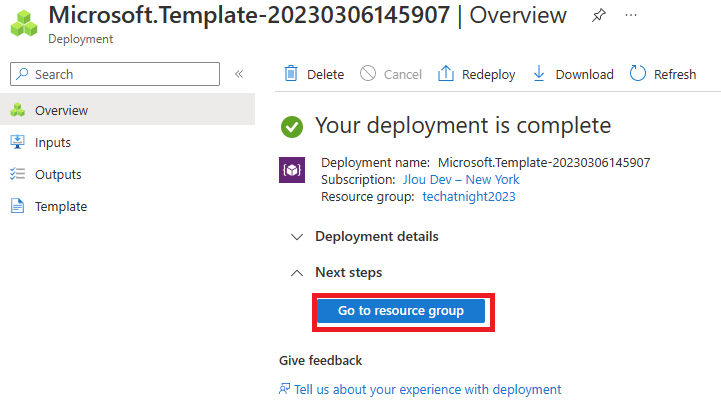

Une fois le déploiement terminé, cliquez-ici pour vous connecter à la VM :

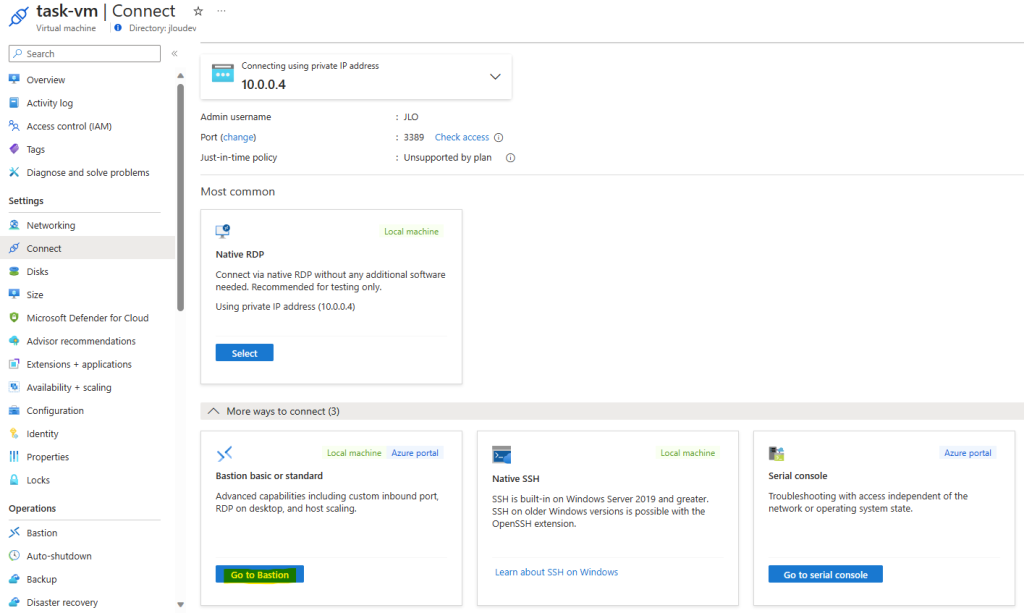

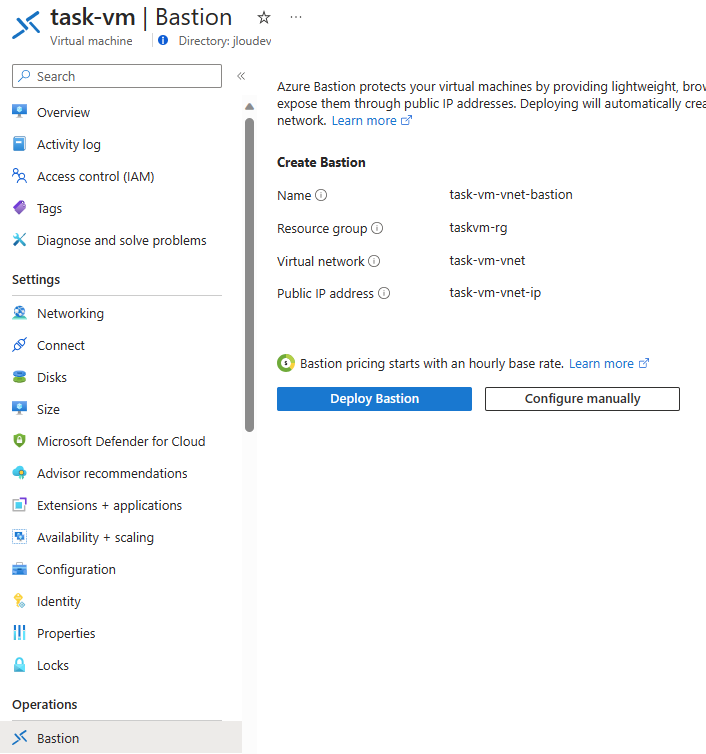

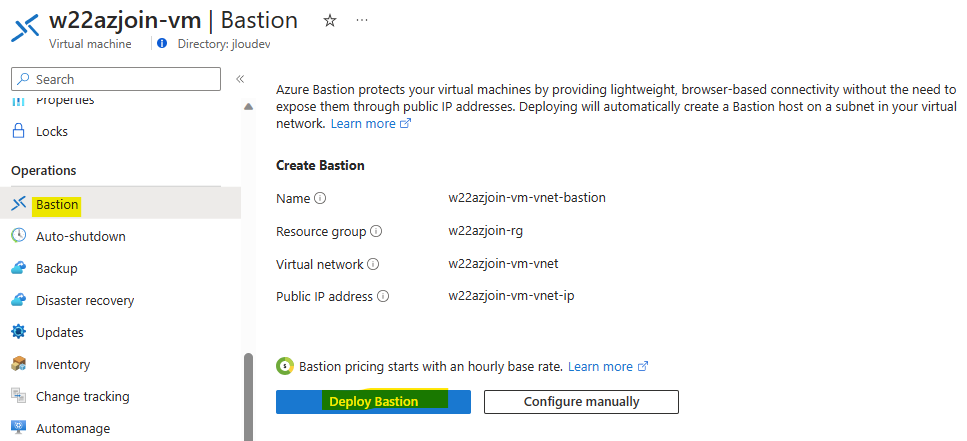

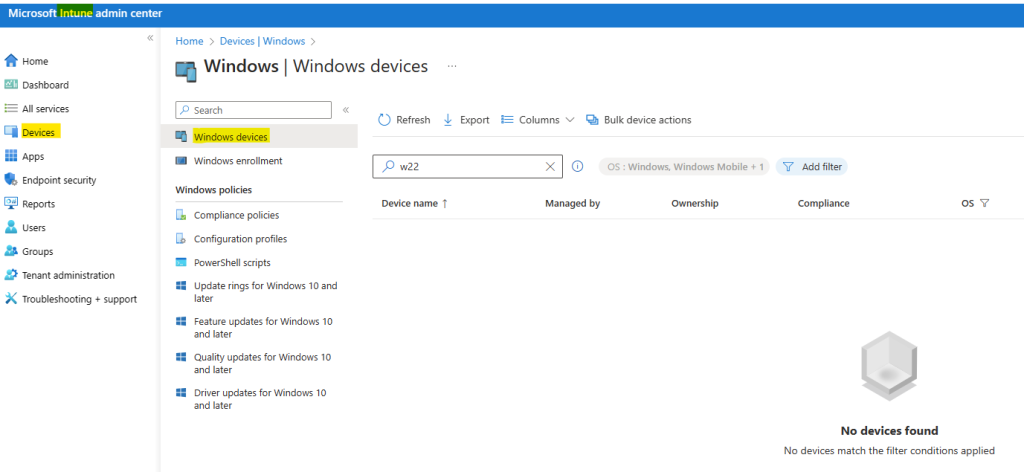

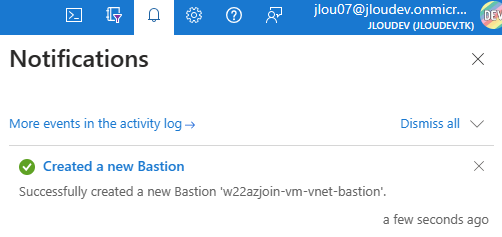

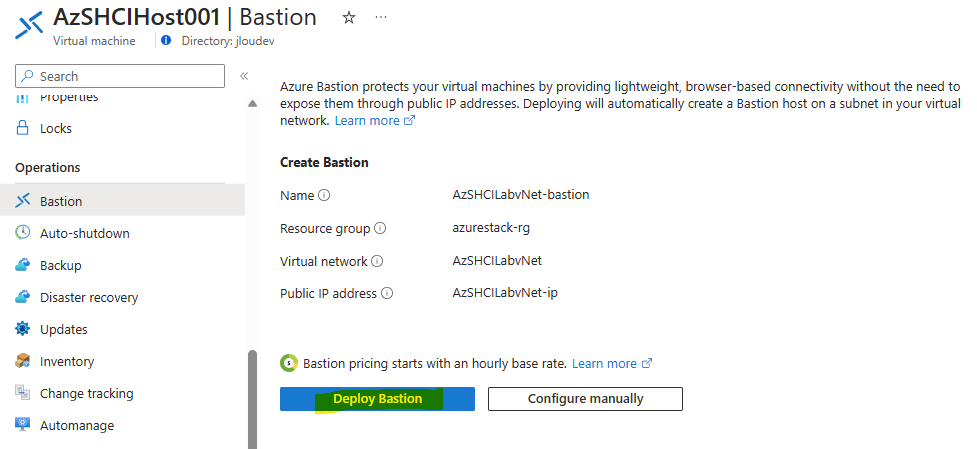

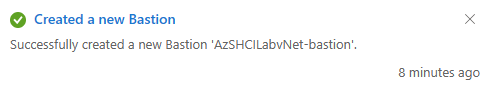

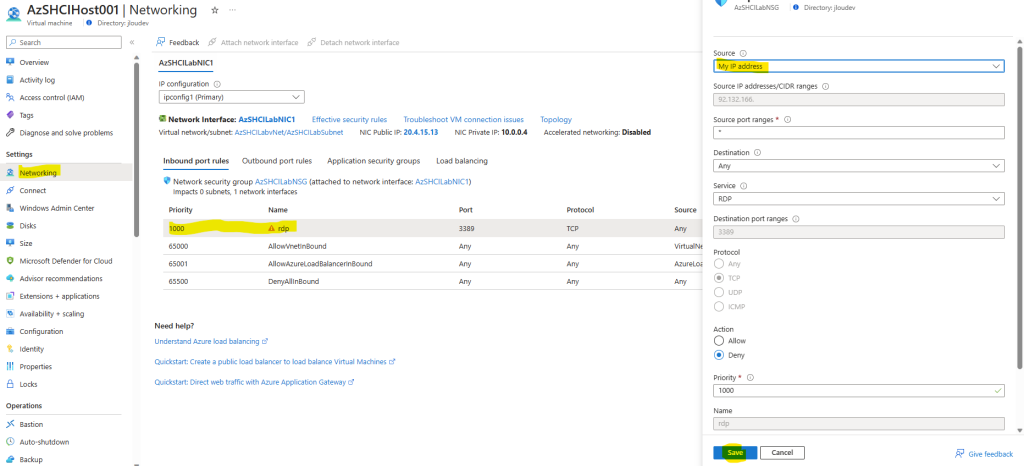

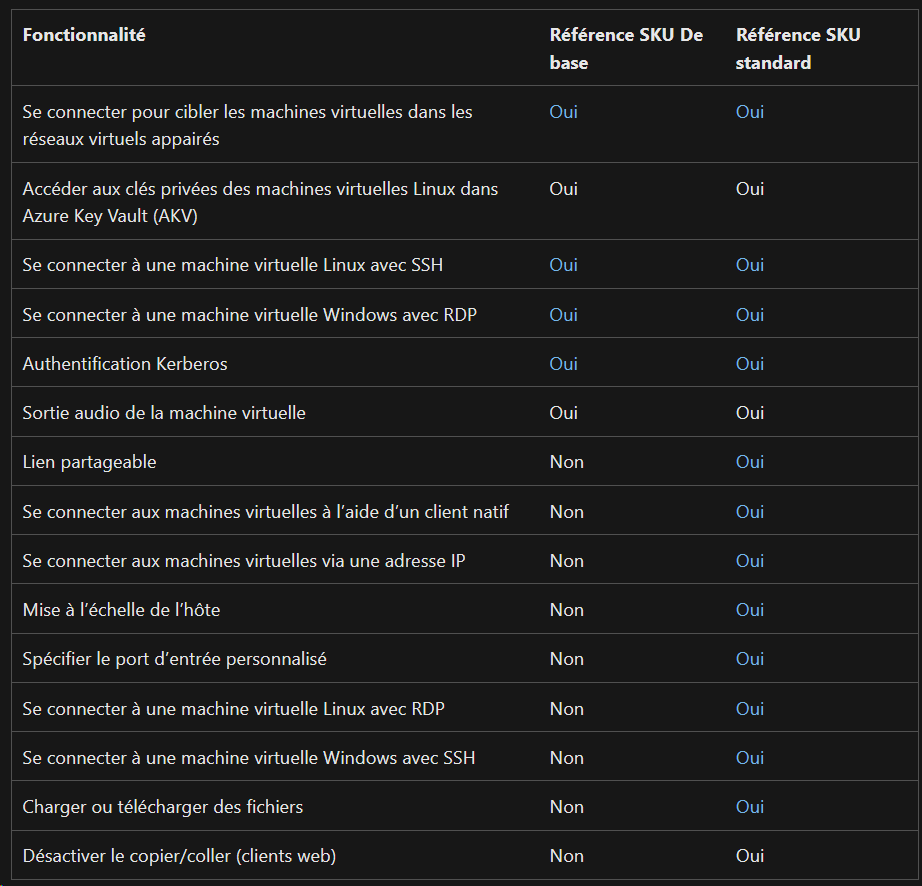

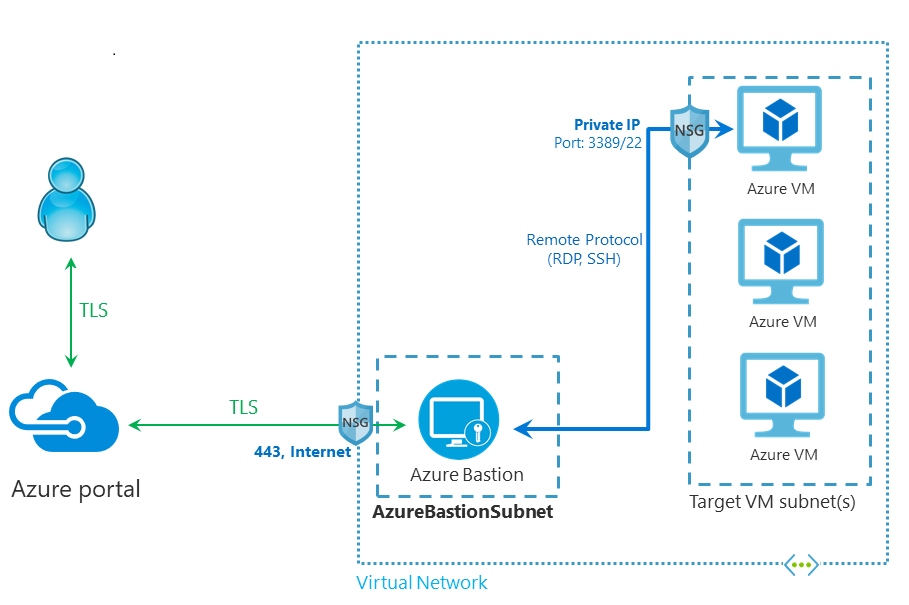

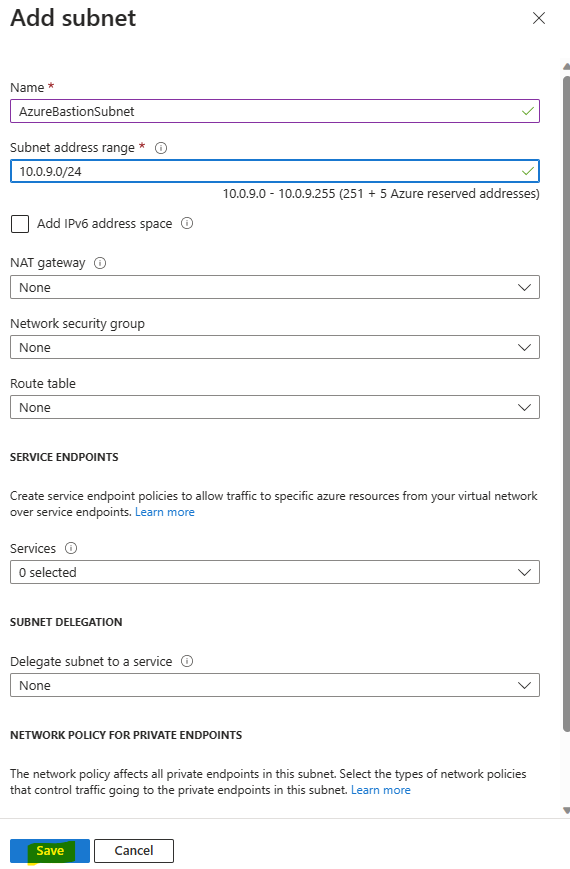

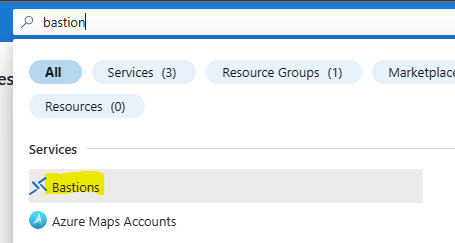

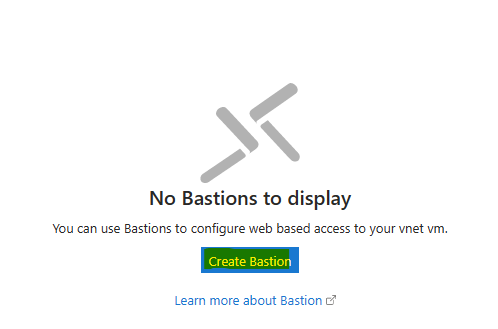

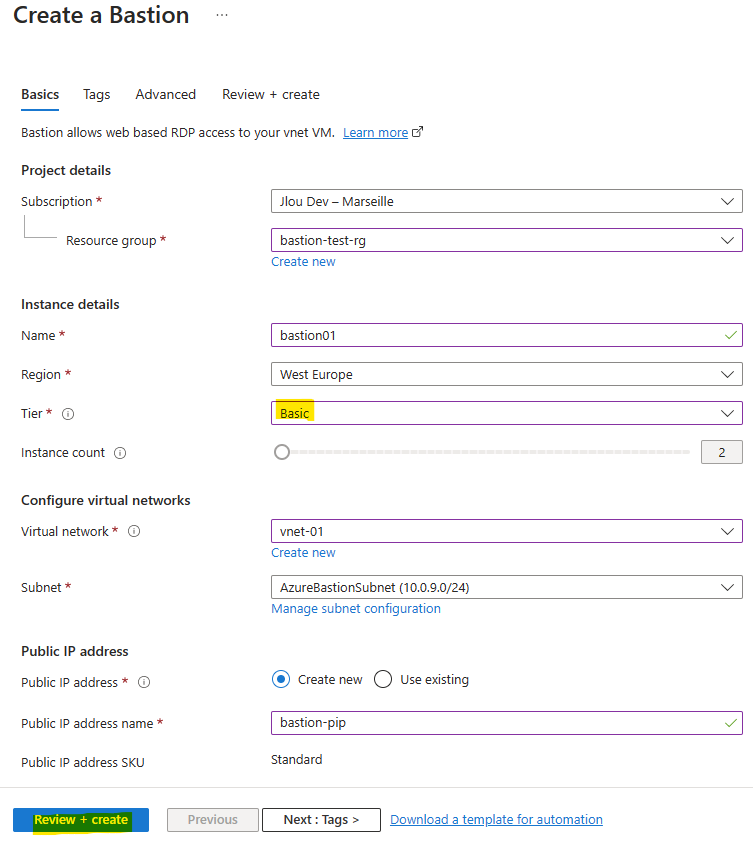

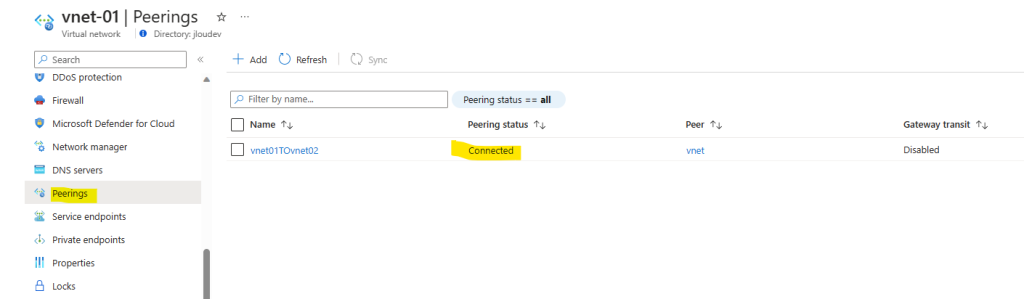

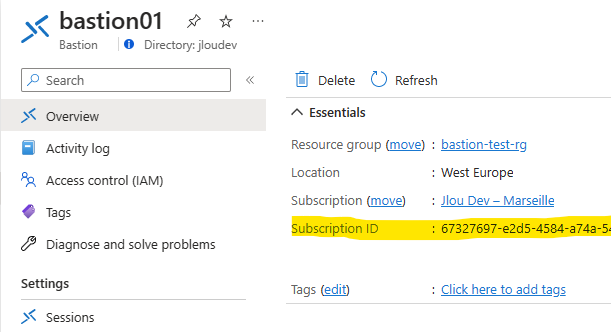

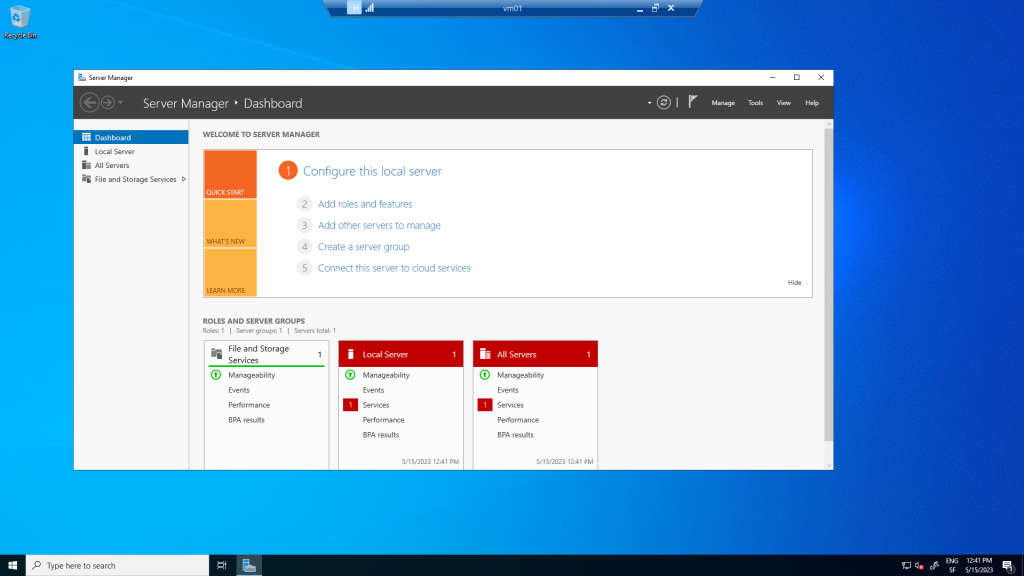

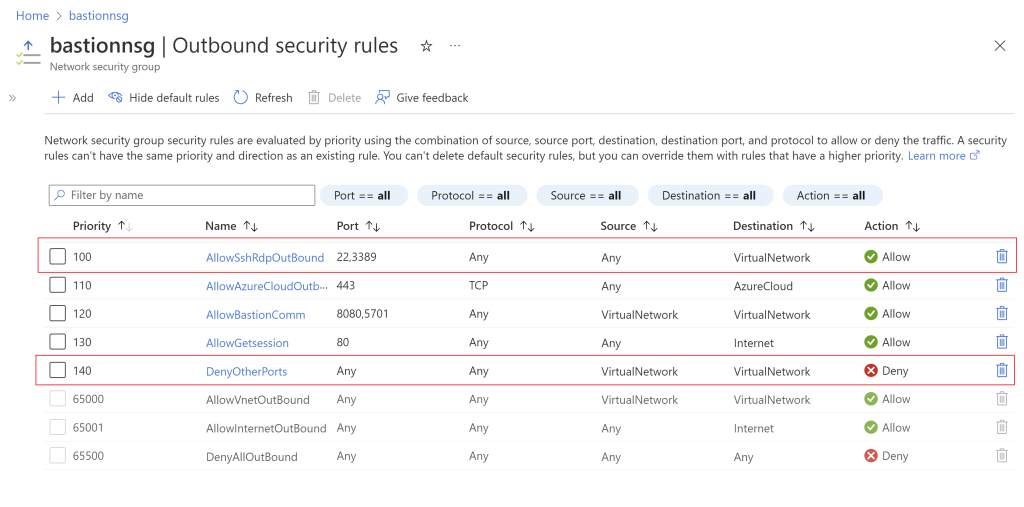

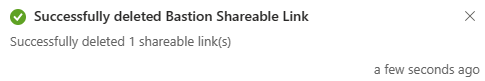

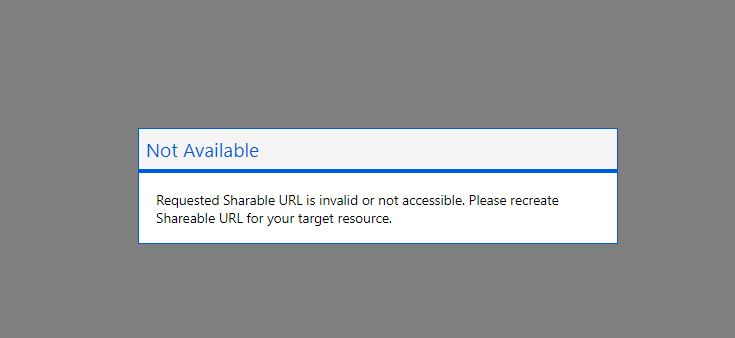

Cliquez sur le bouton suivant pour déployer le service Azure Bastion :

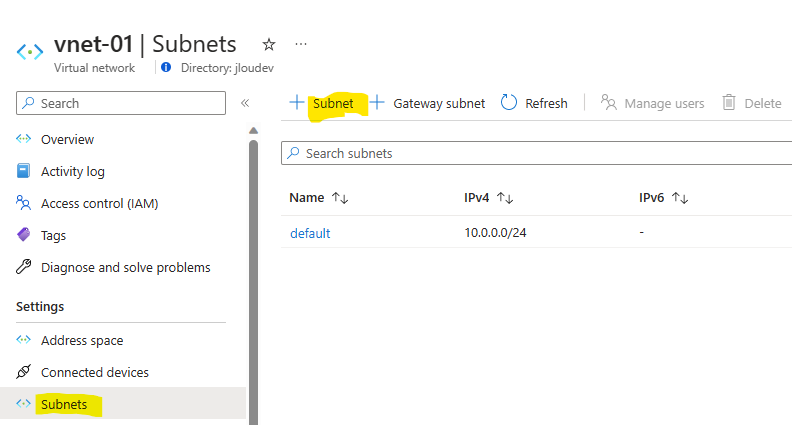

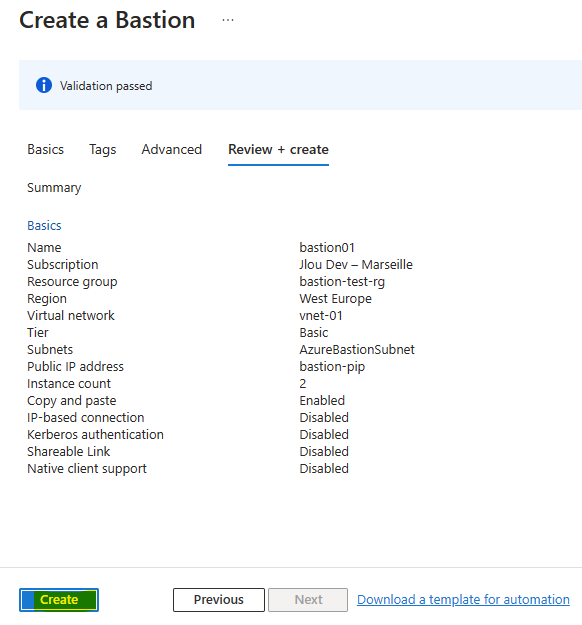

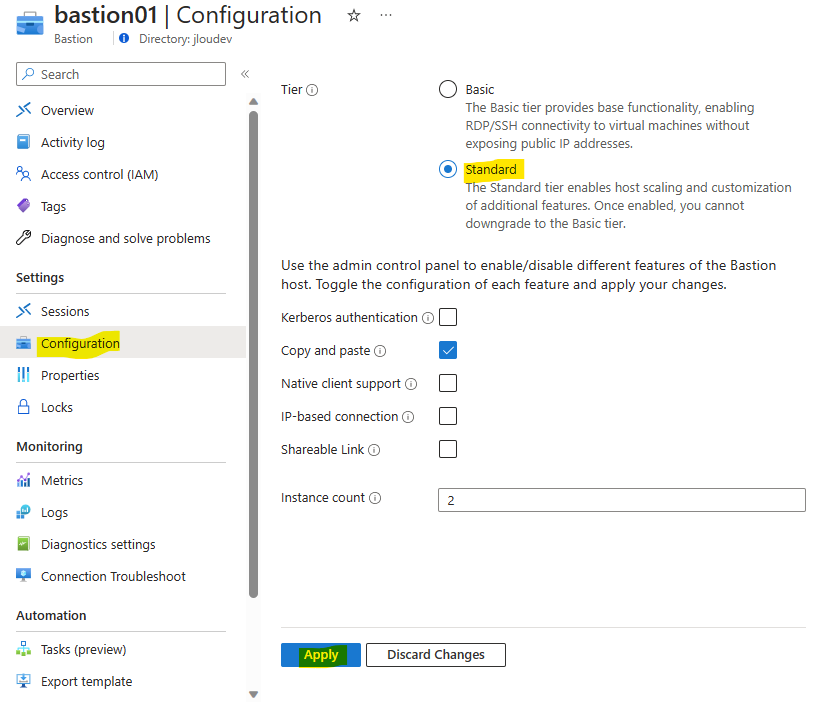

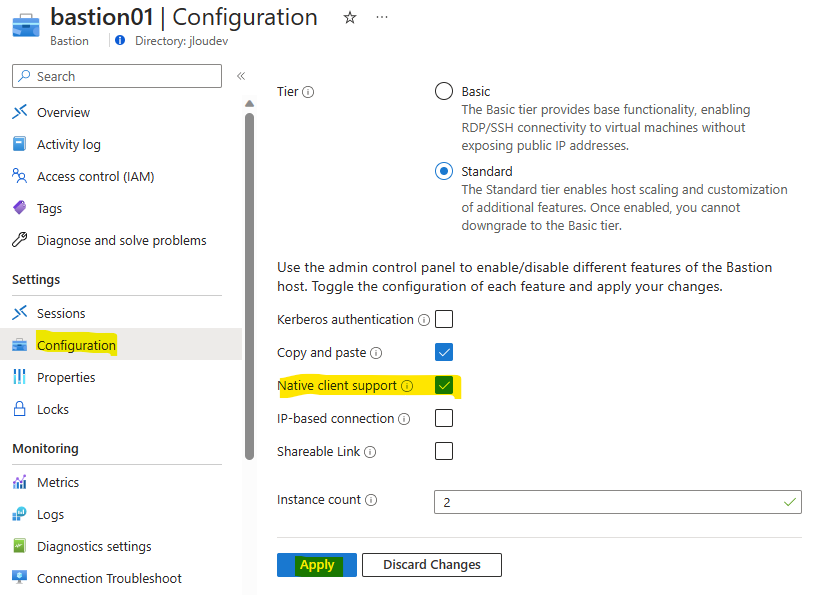

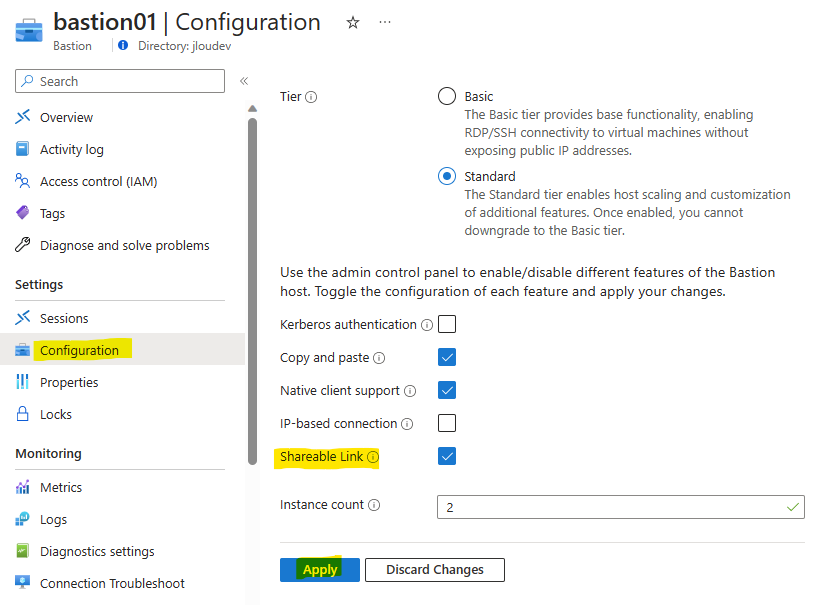

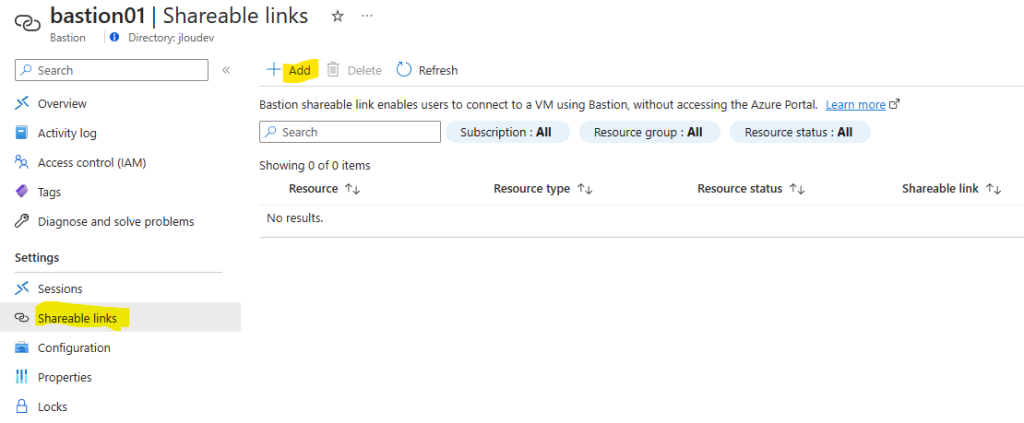

Cliquez-ici pour configurer Azure Bastion :

Cliquez sur le bouton suivant pour déployer automatiquement le service Azure Bastion :

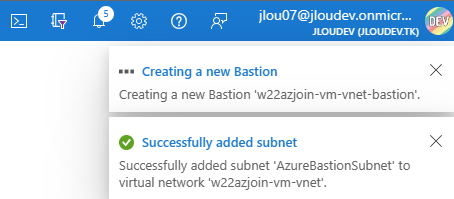

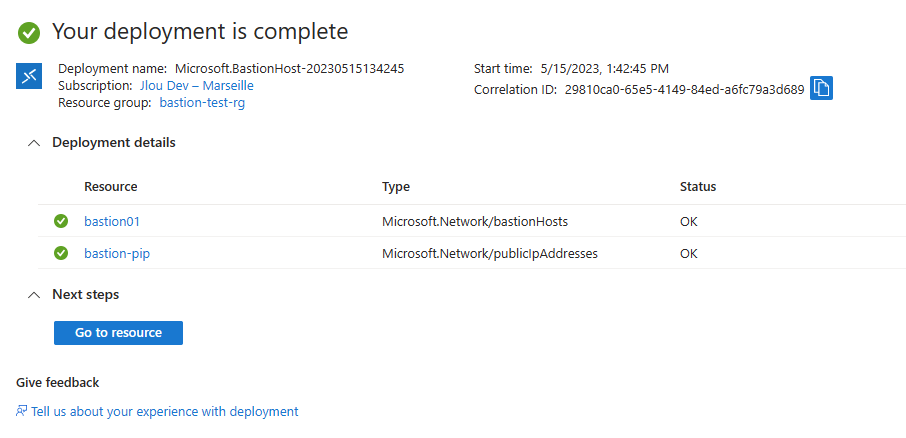

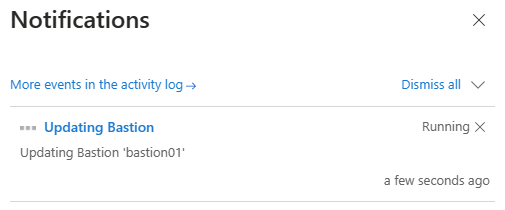

Attendez qu’Azure Bastion soit déployé pour continuer cet exercice.

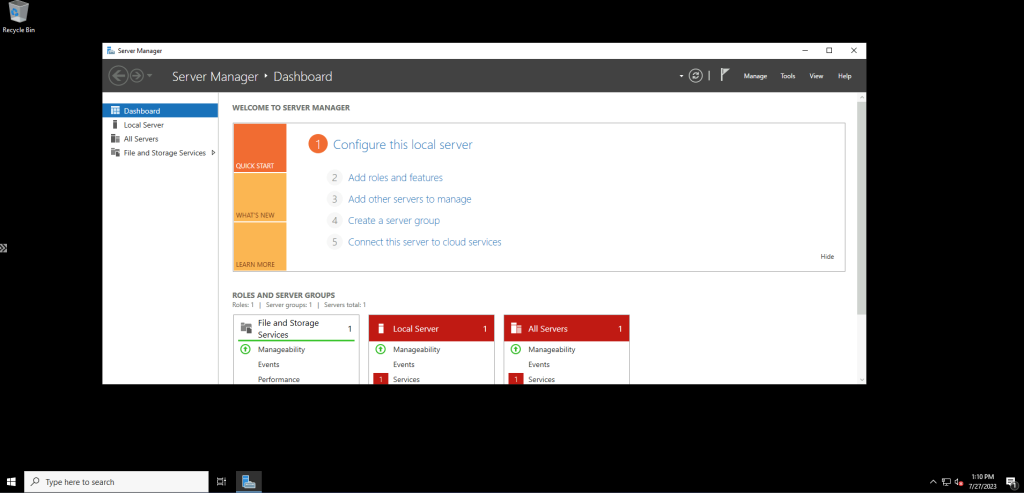

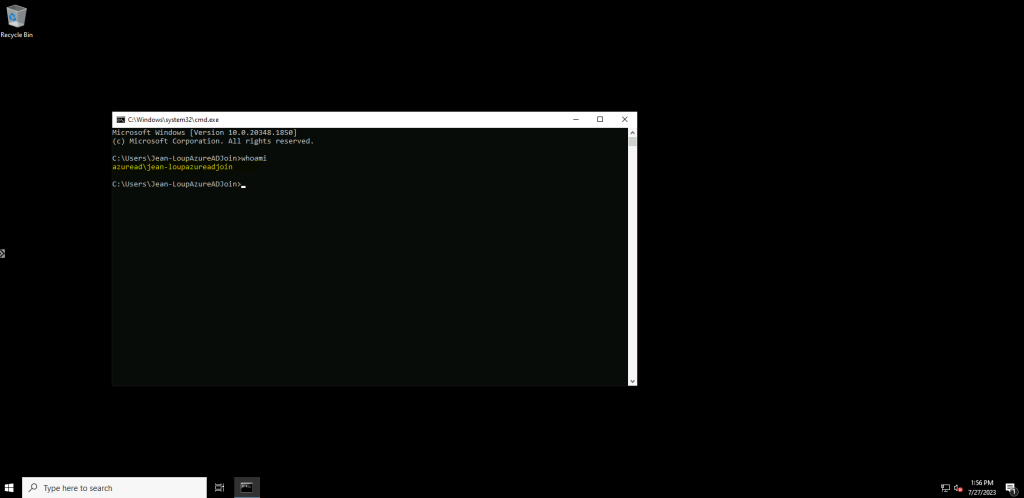

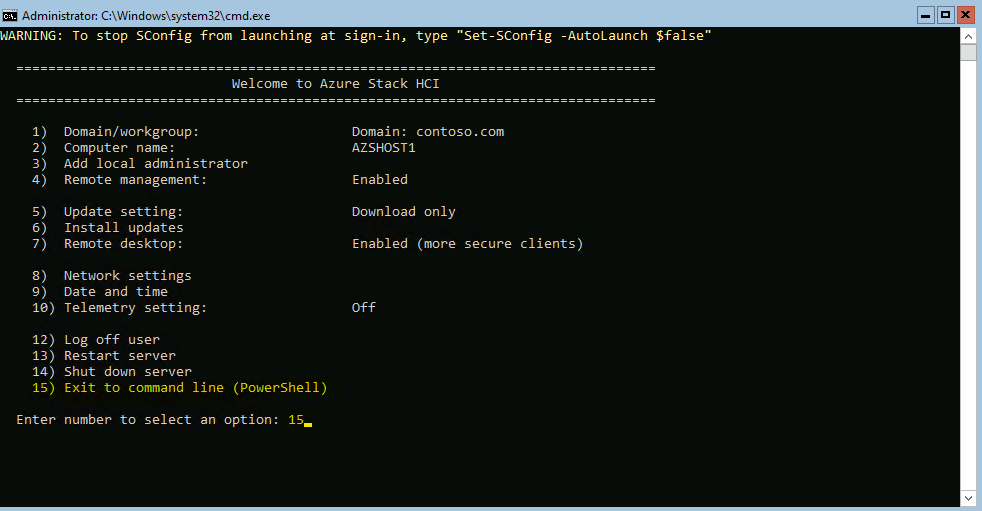

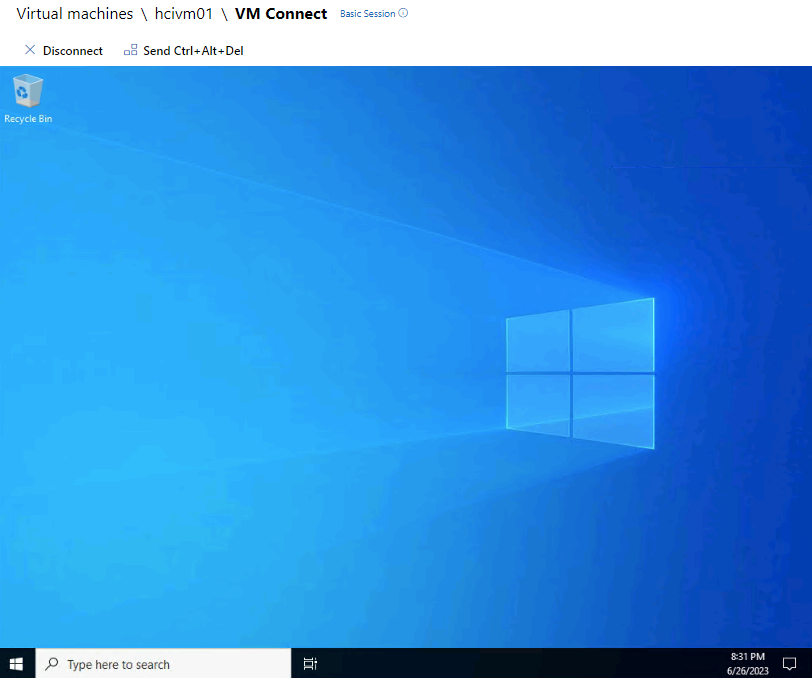

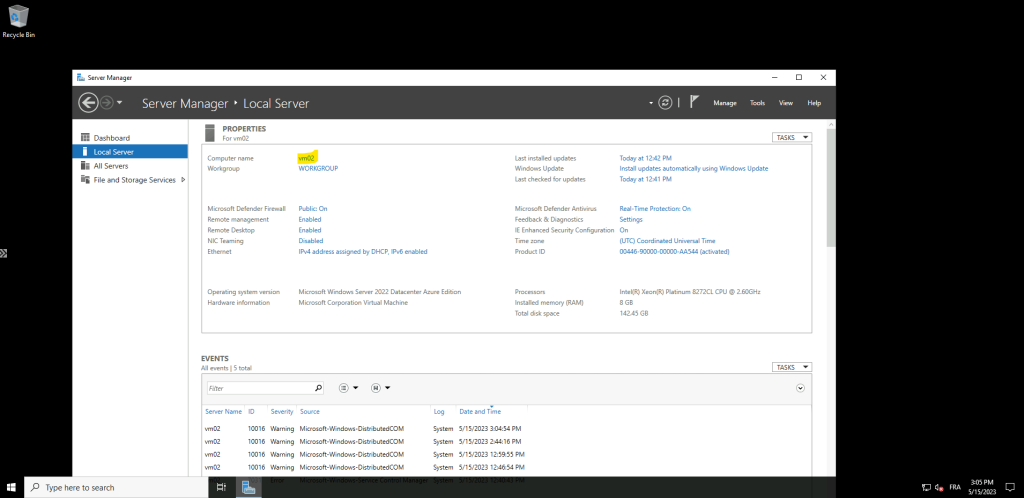

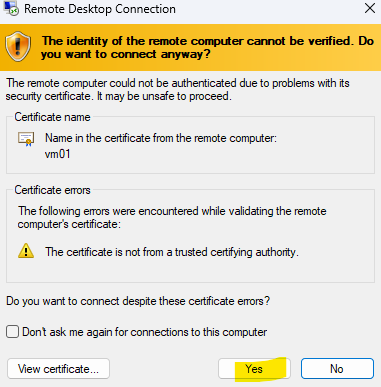

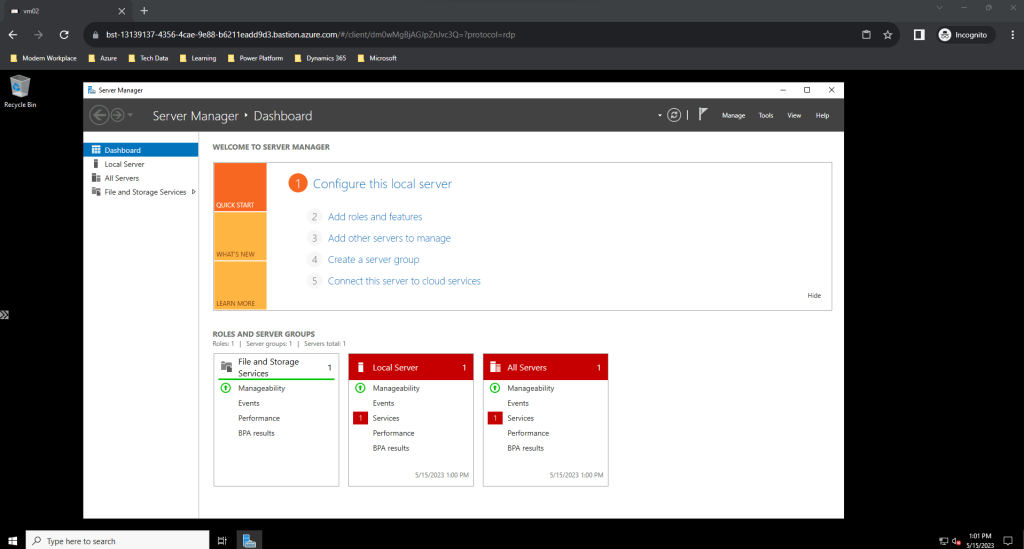

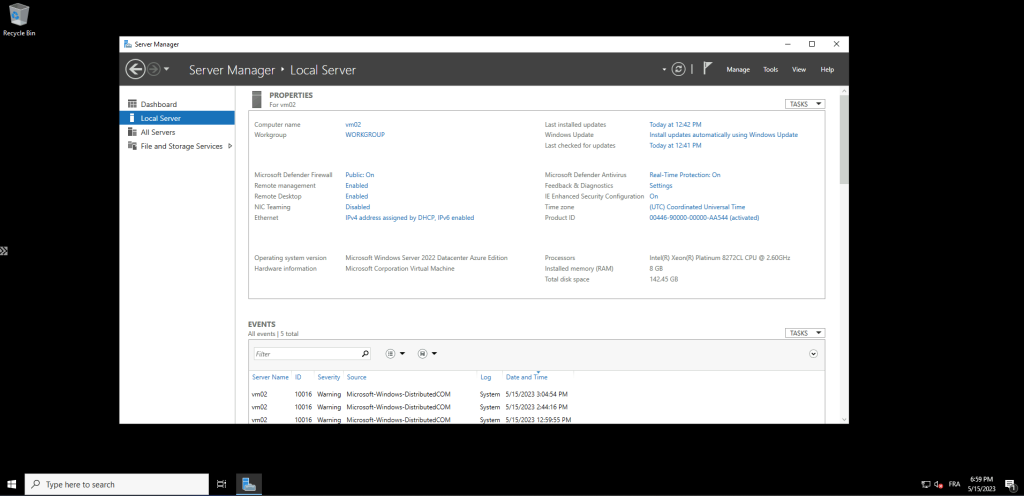

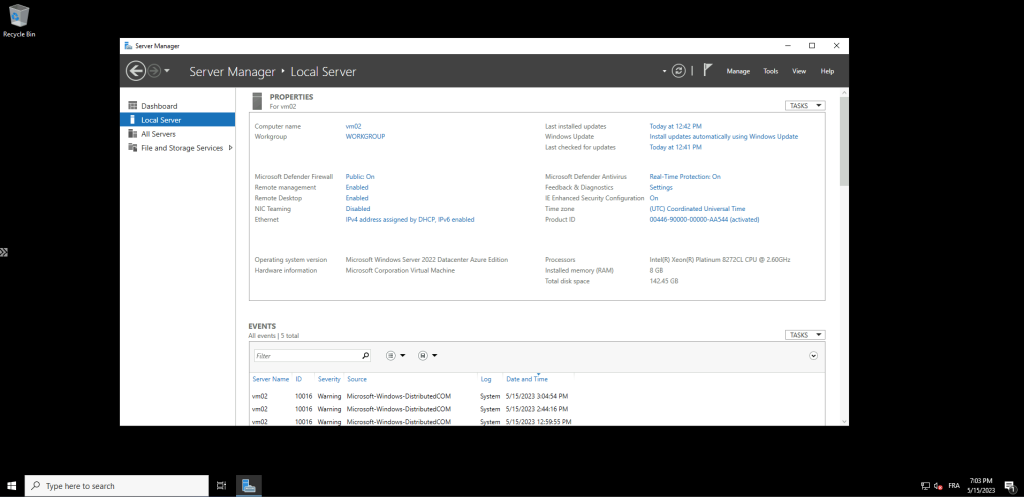

Notre machine virtuelle est maintenant déployée et est accessible. Nous allons maintenant nous y connecter afin de configurer une tâche planifiée via le planificateur de tâches Windows.

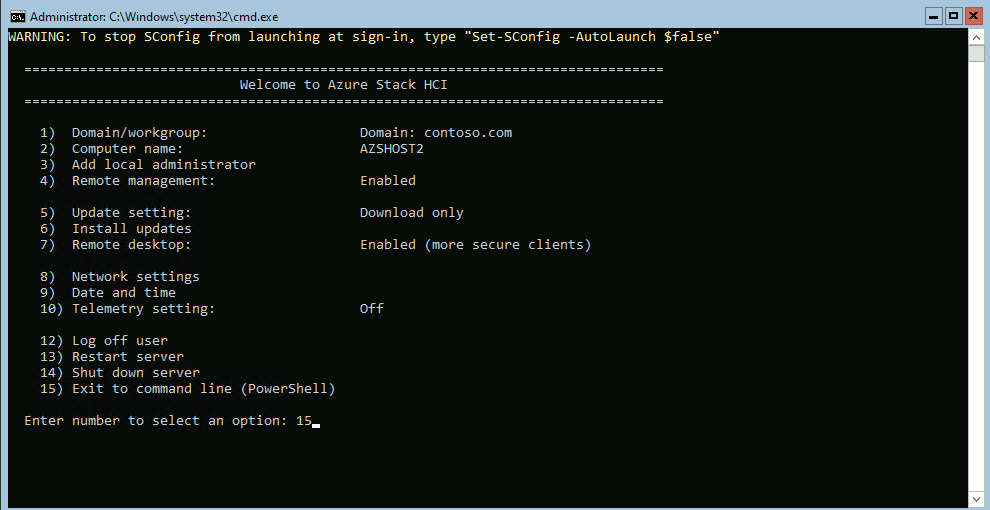

Etape II – Configurez une tâche planifiée Windows :

Cette action basique va nous montrer comment une tâche planifiée exécutée localement va remonter des informations visibles directement depuis Azure Monitor.

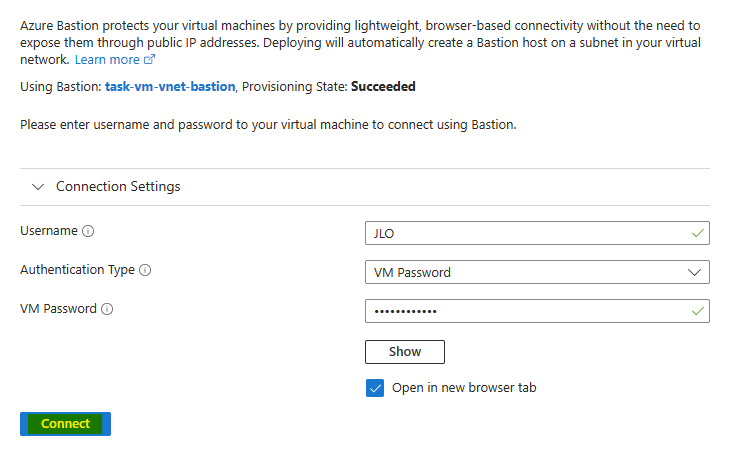

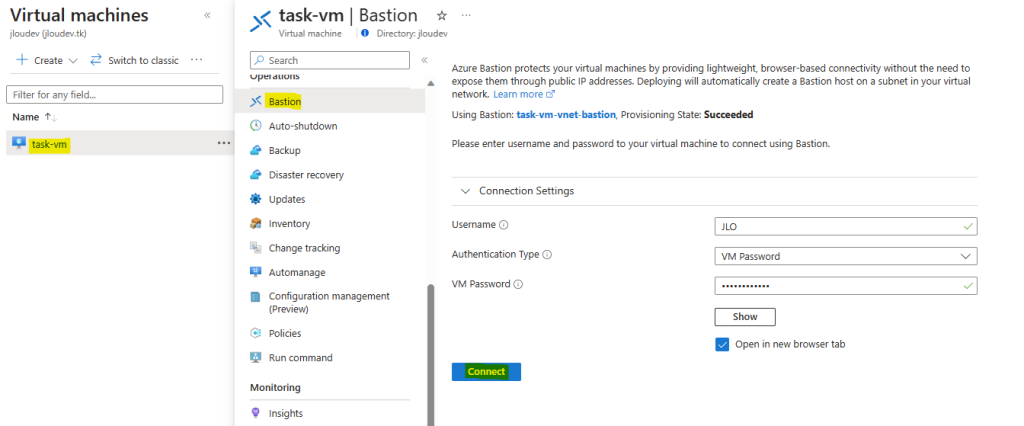

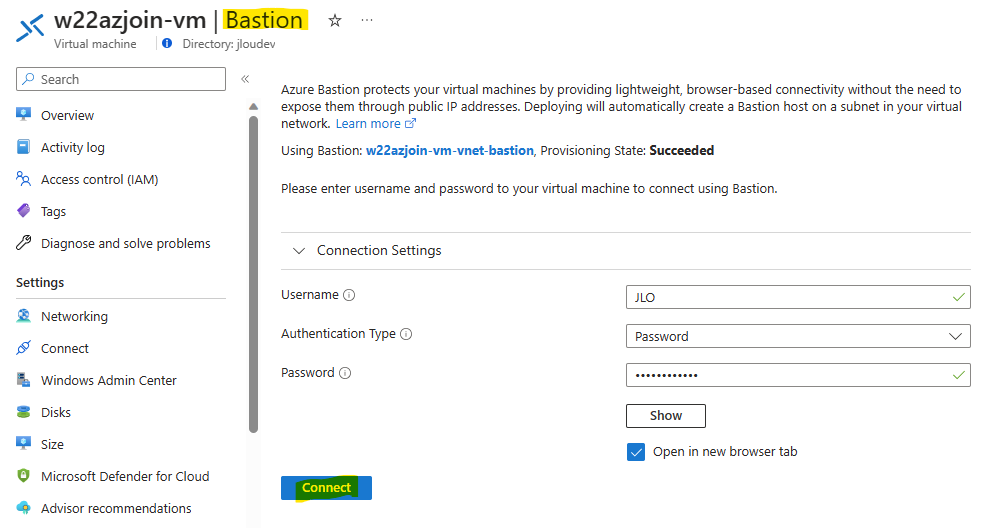

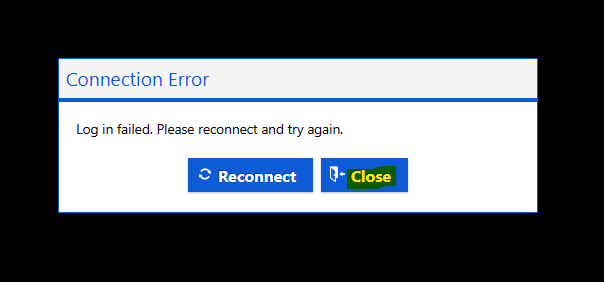

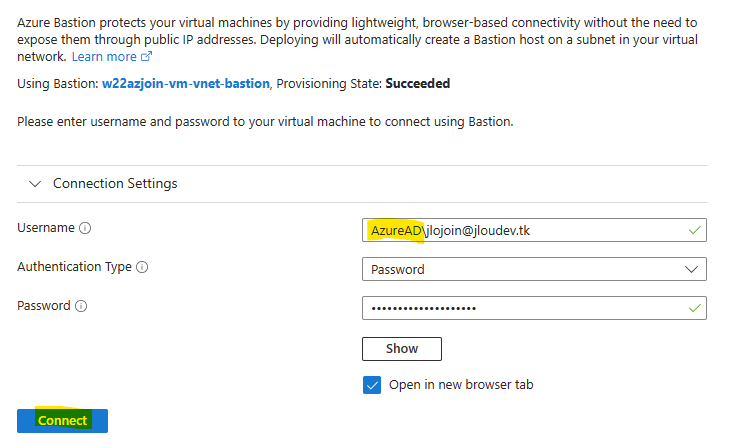

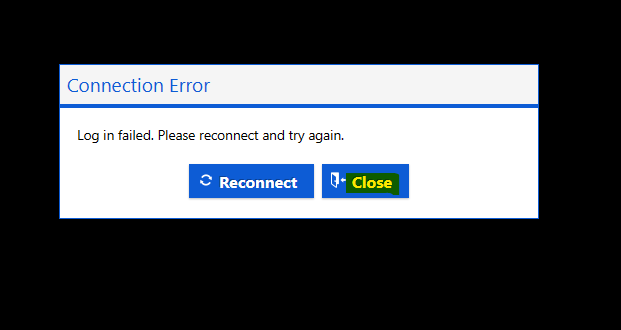

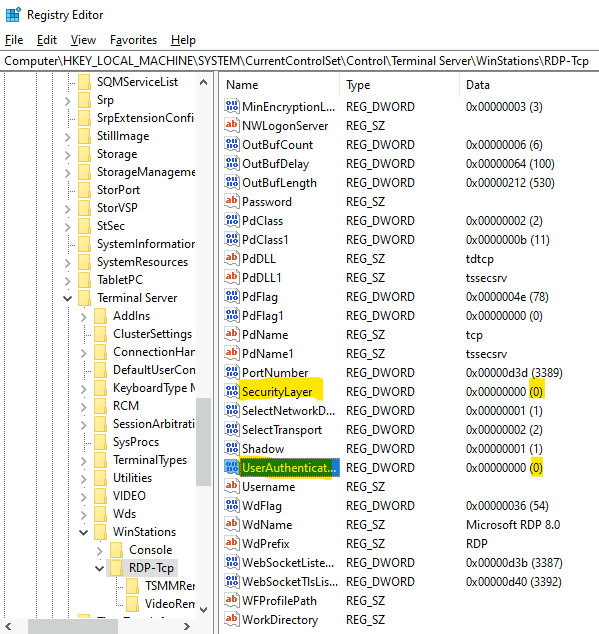

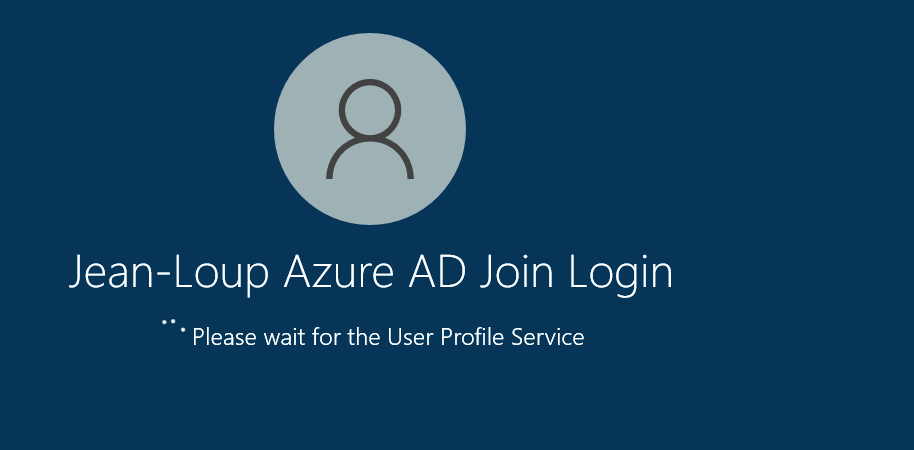

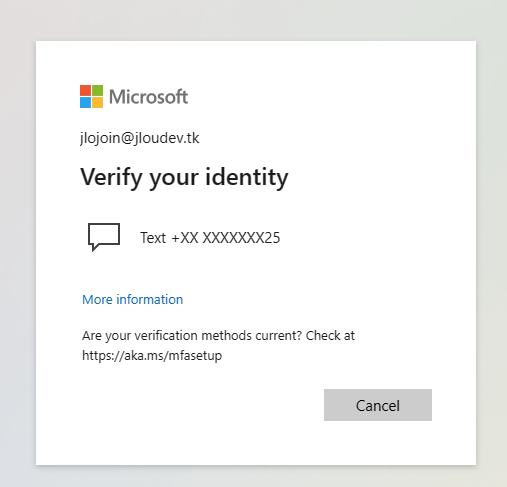

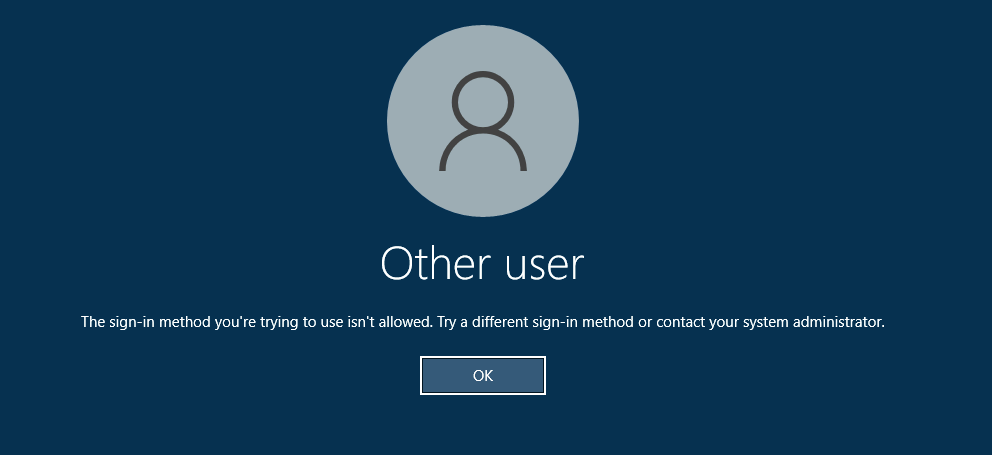

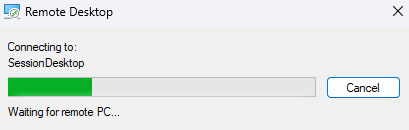

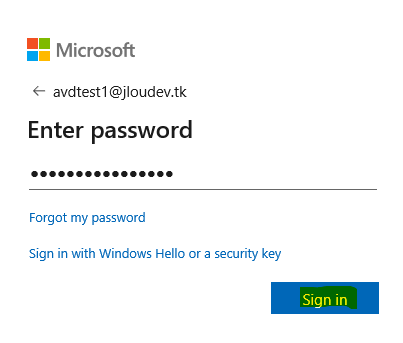

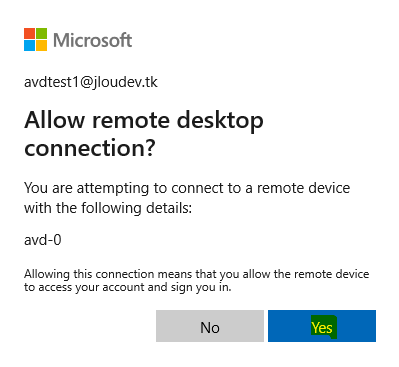

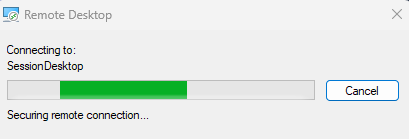

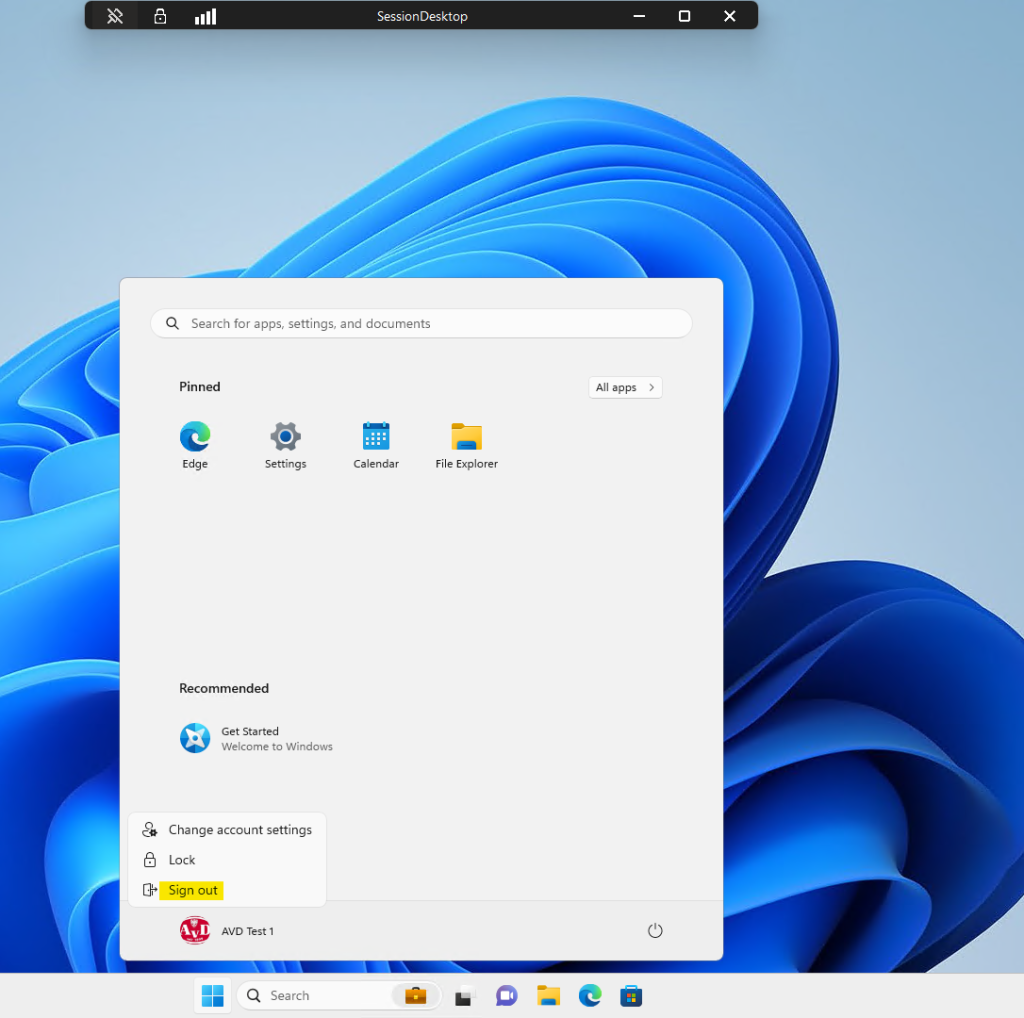

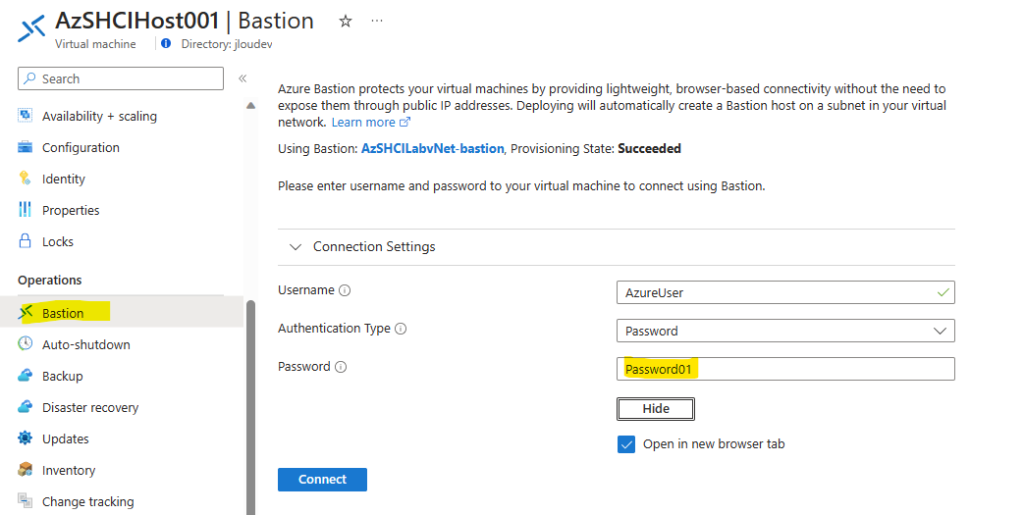

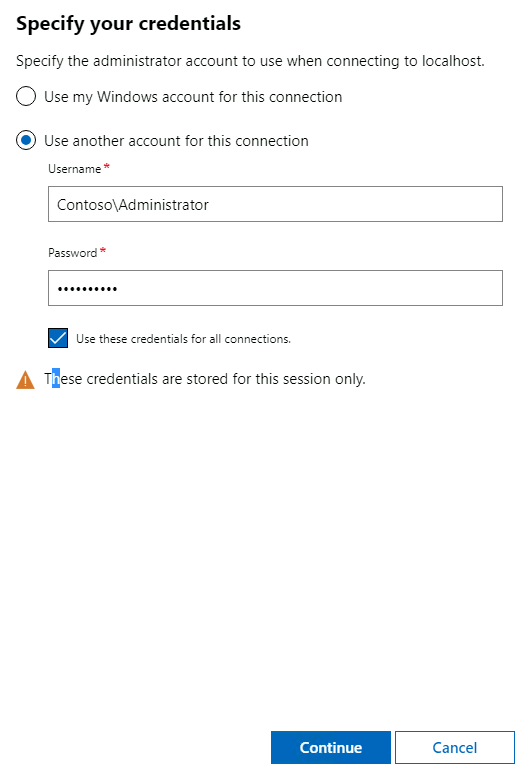

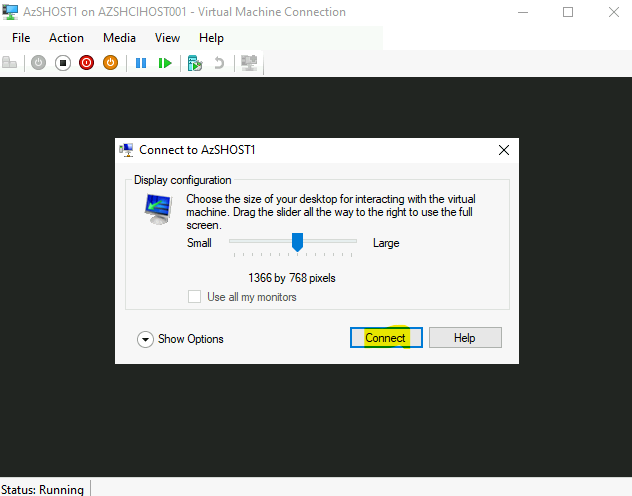

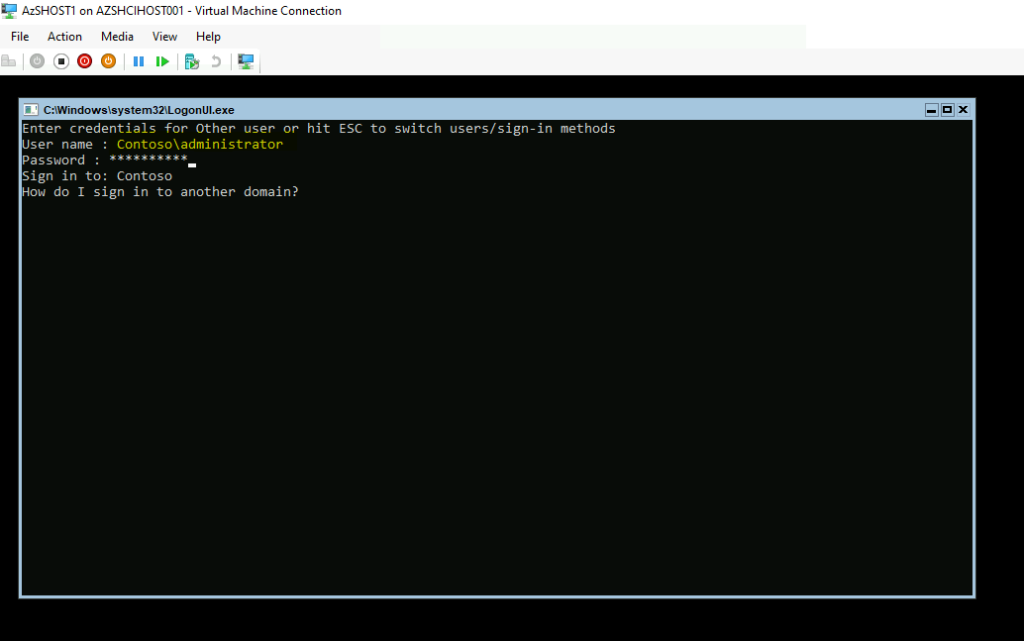

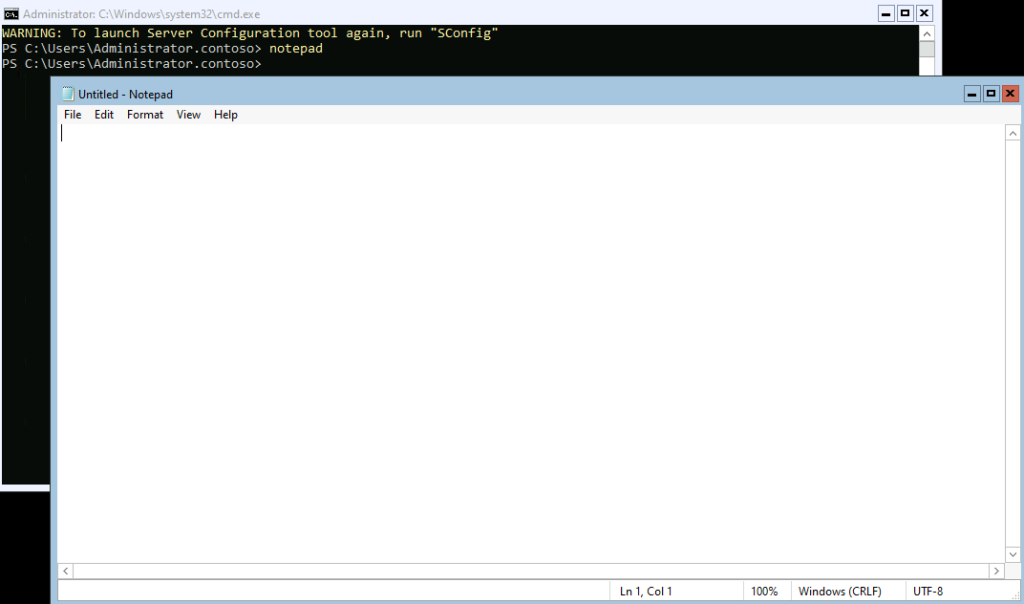

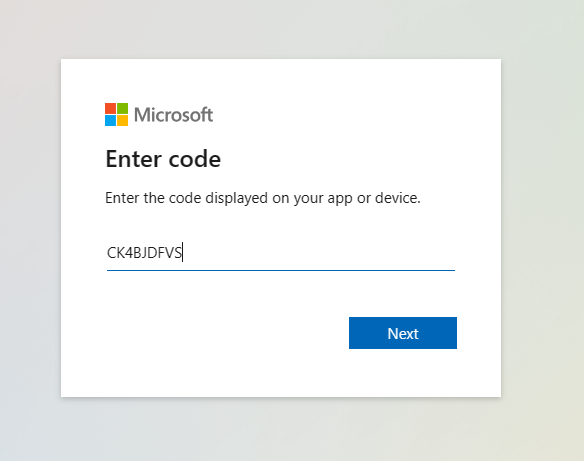

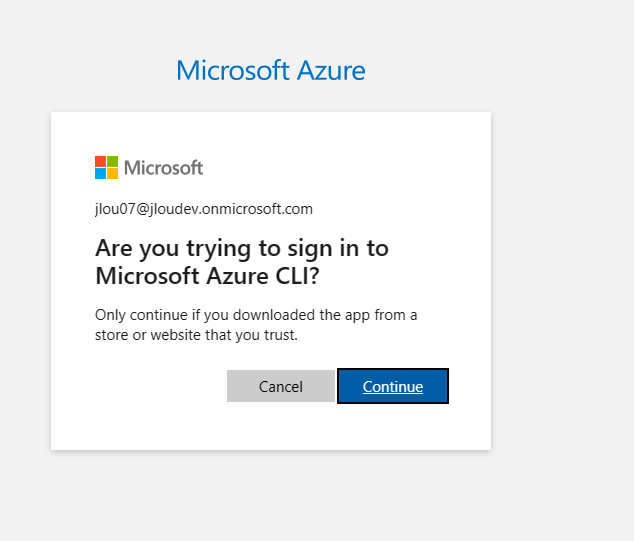

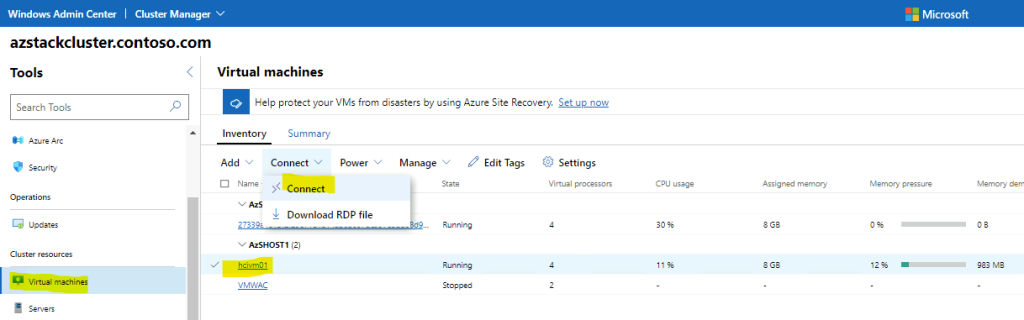

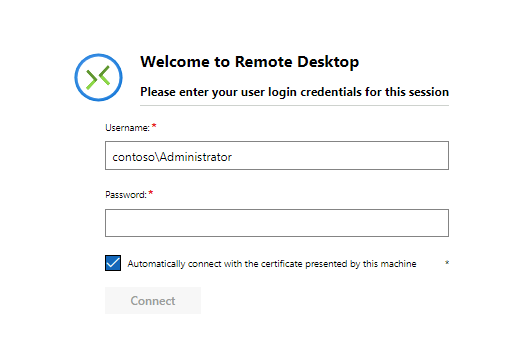

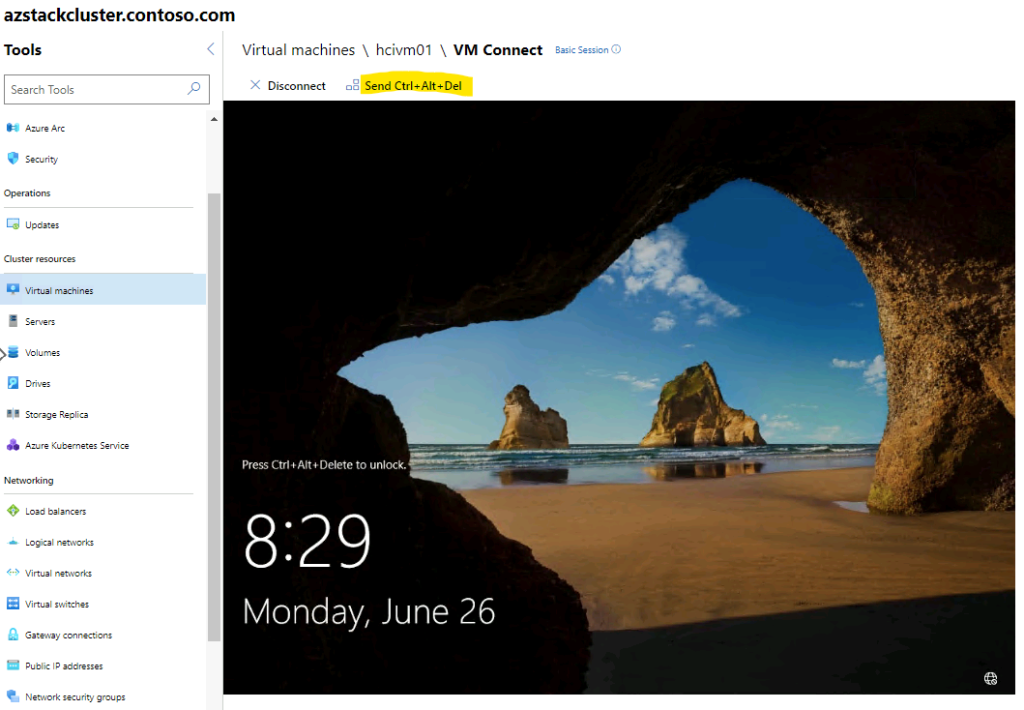

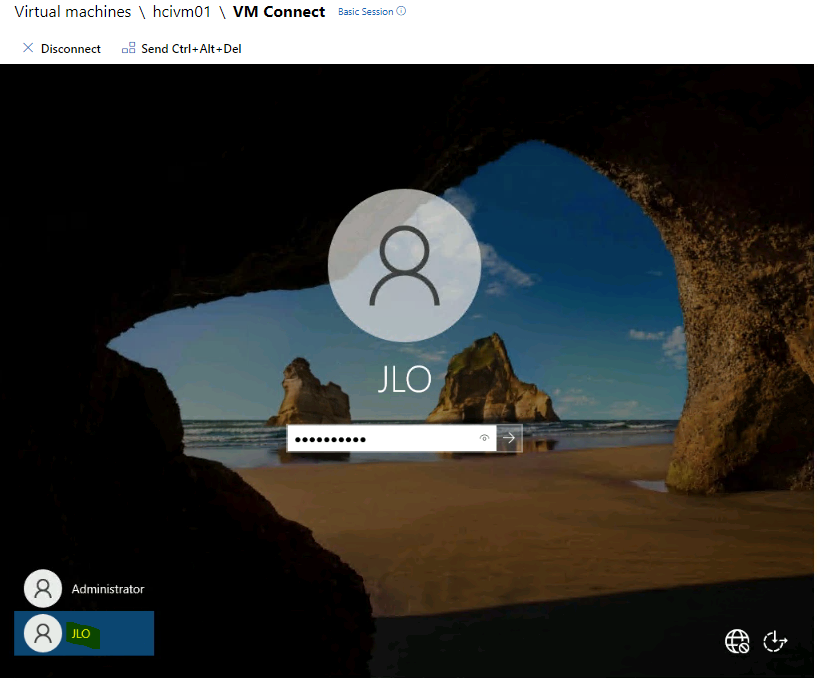

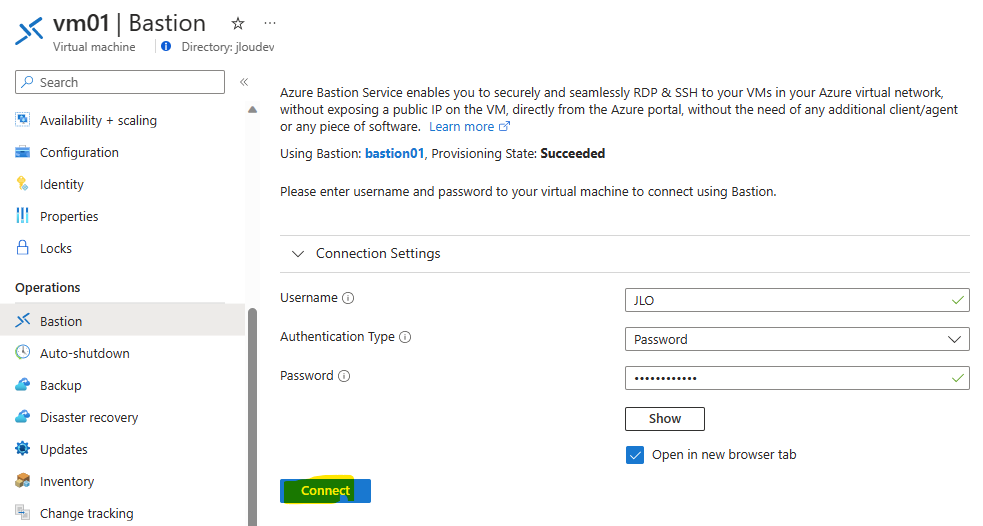

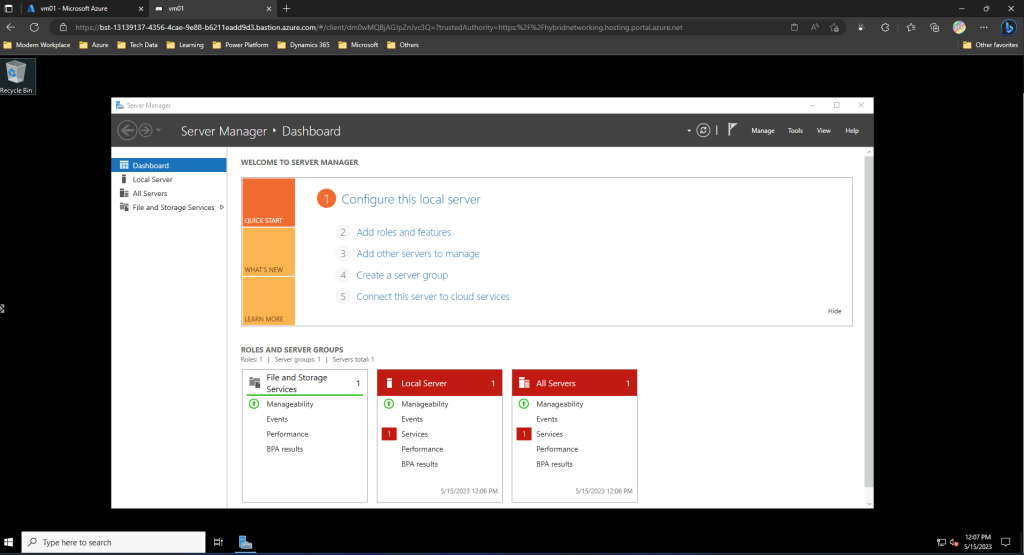

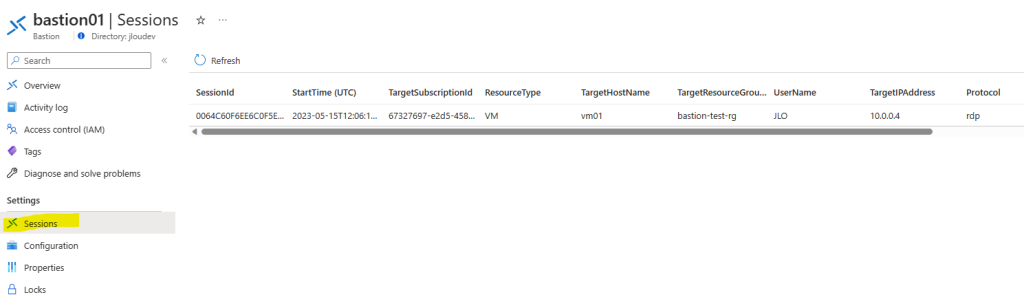

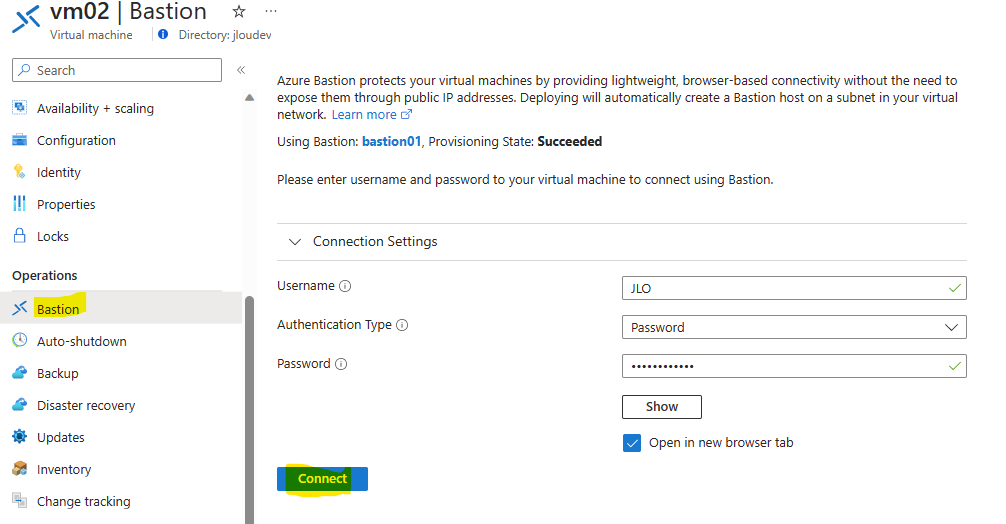

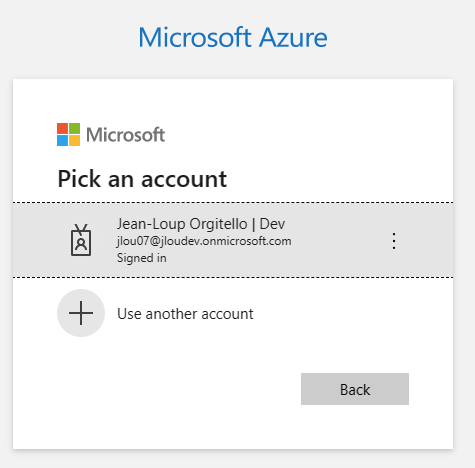

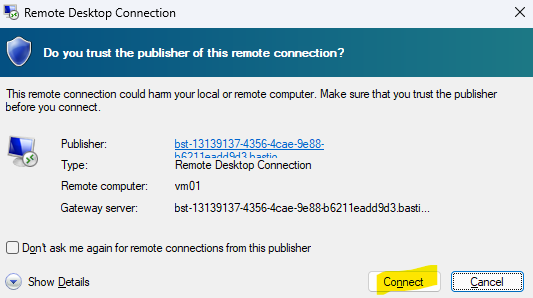

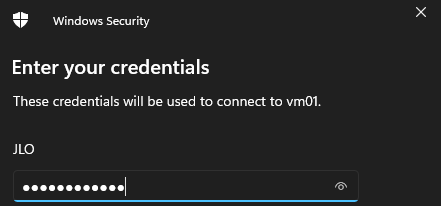

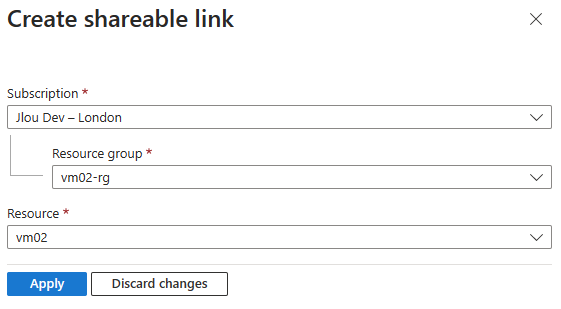

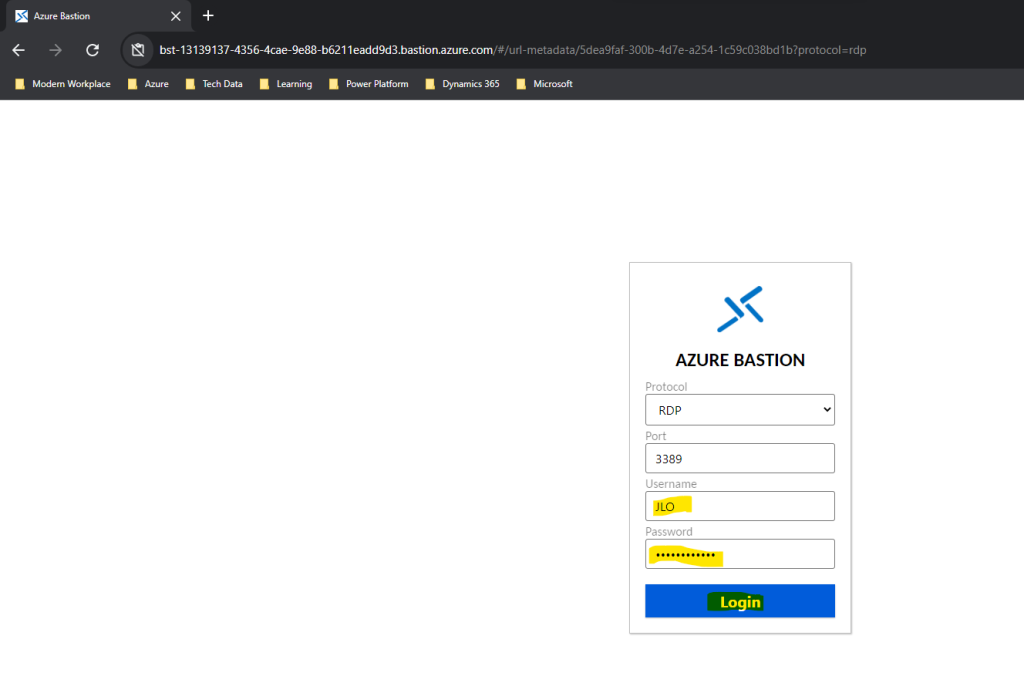

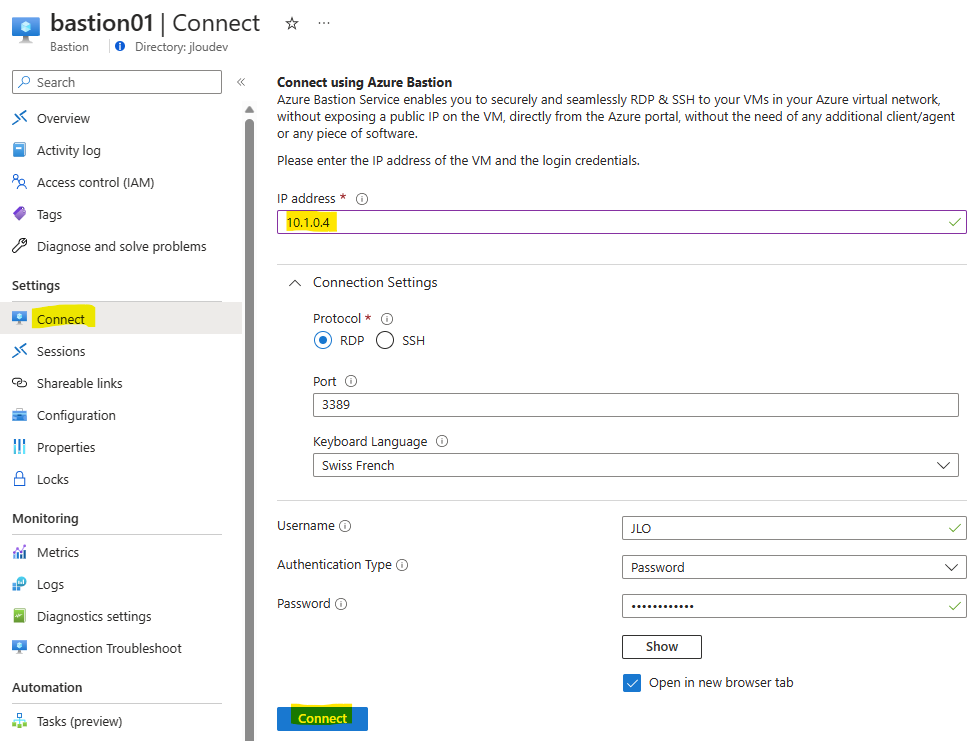

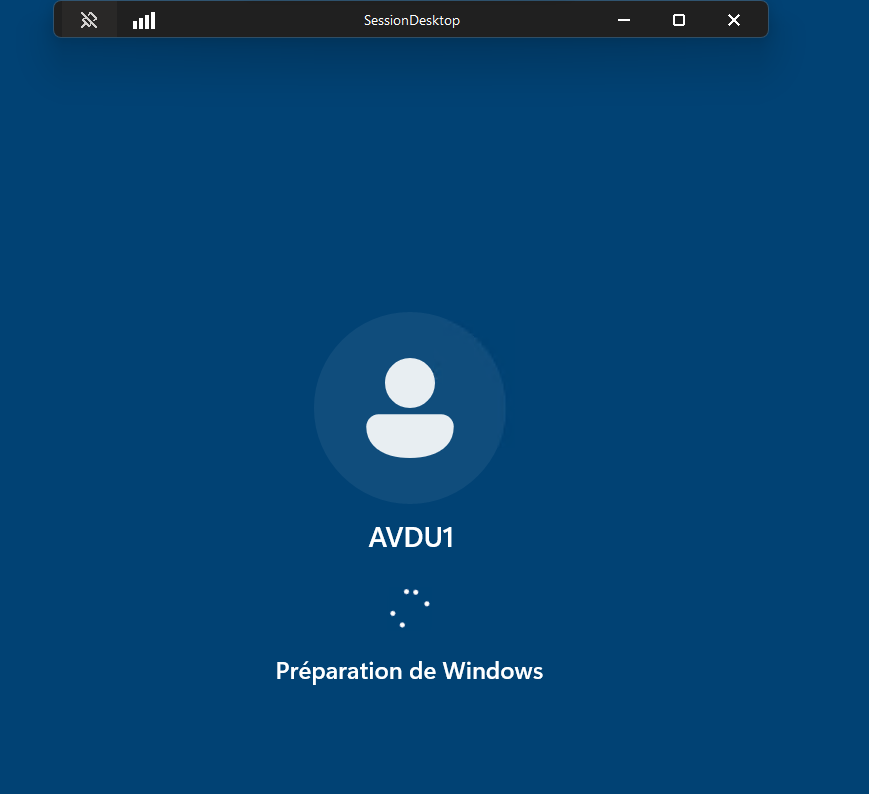

Ouvrez une session à distance via le service Azure Bastion en utilisant le compte administrateur local renseigné lors de la création de la VM :

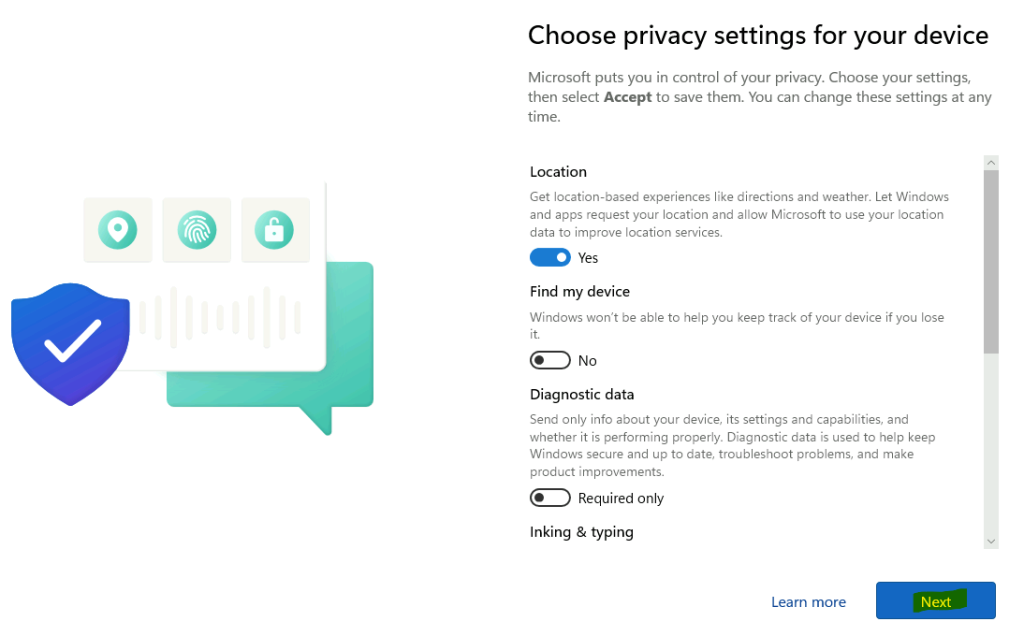

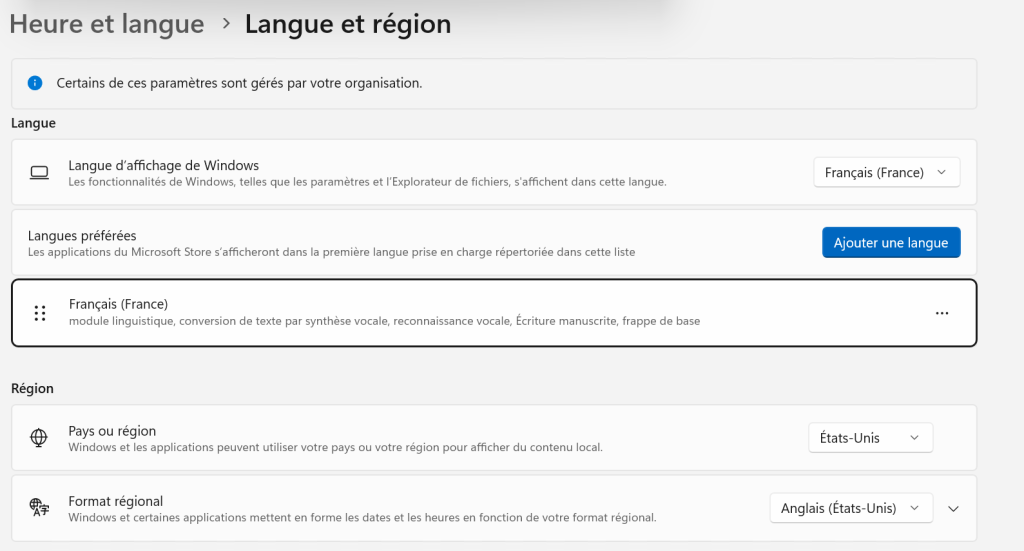

Cliquez sur Suivant pour terminer la configuration de Windows 11 :

Modifiez si besoin les options listées, puis cliquez sur Accepter :

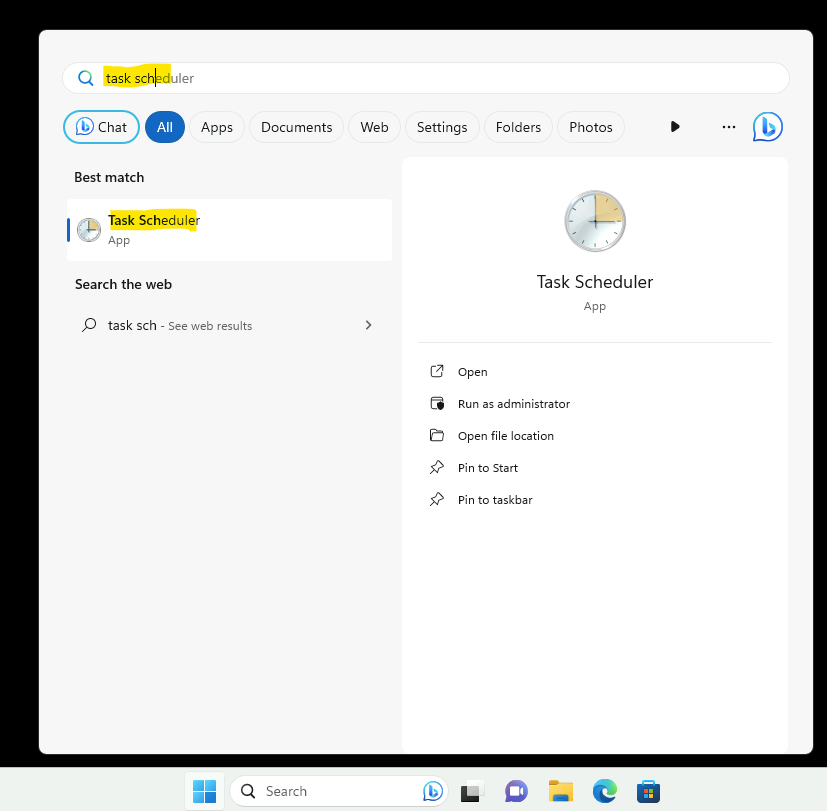

Ouvrez le Planificateur de tâche Windows depuis le menu Démarrer :

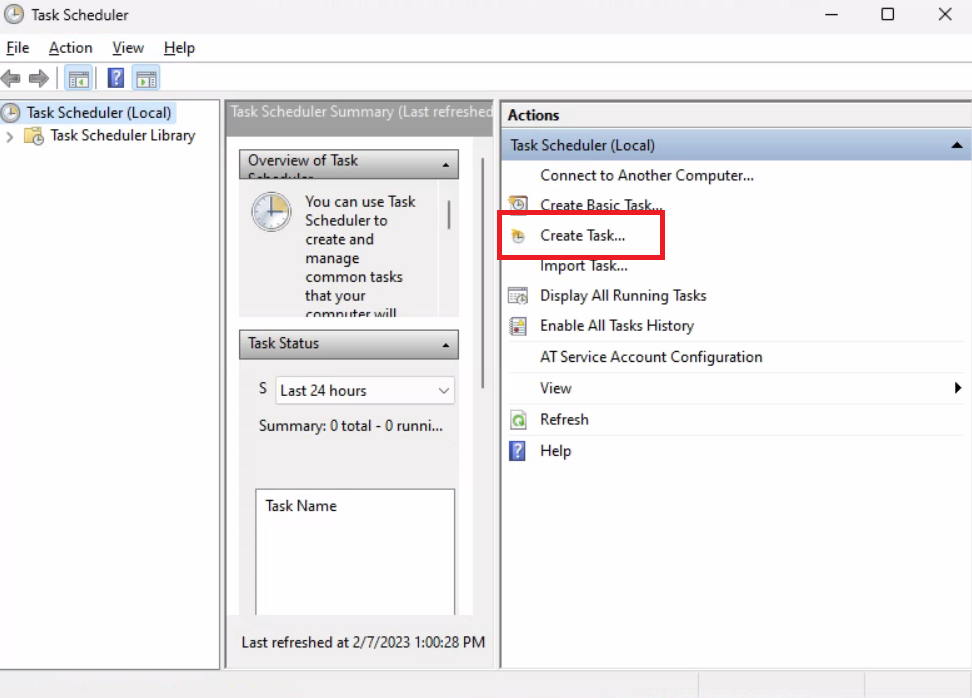

Créez une nouvelle Tâche planifiée :

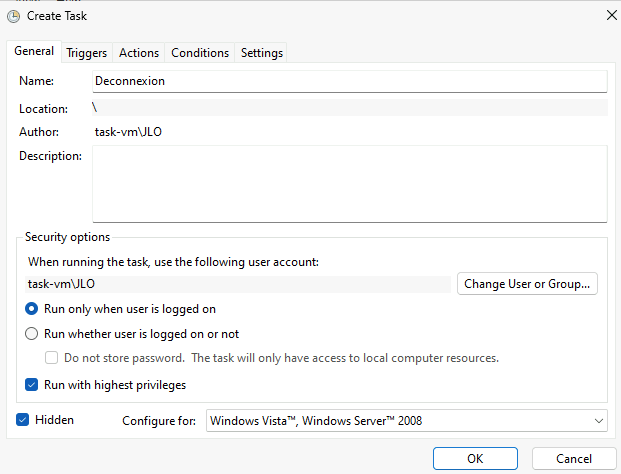

Nommez votre Tâche planifiée, cochez les cases suivantes, puis passez sur le second onglet :

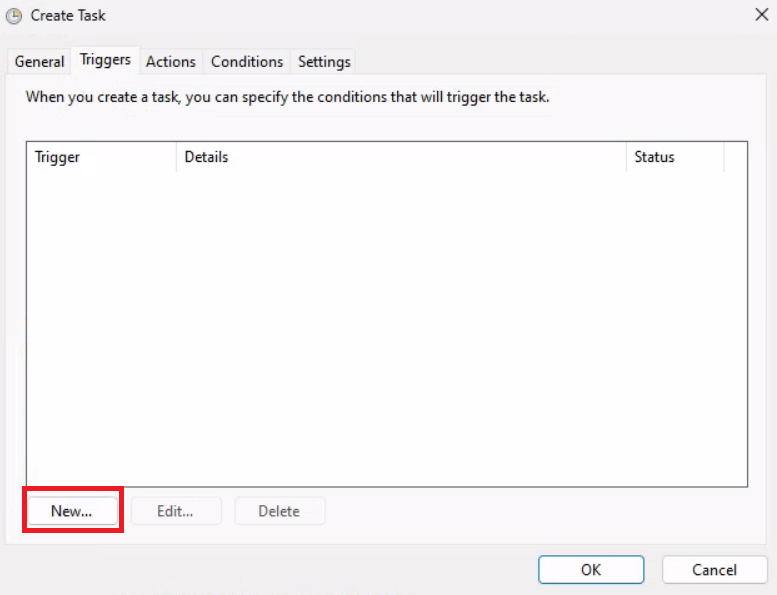

Ajoutez-y un déclencheur :

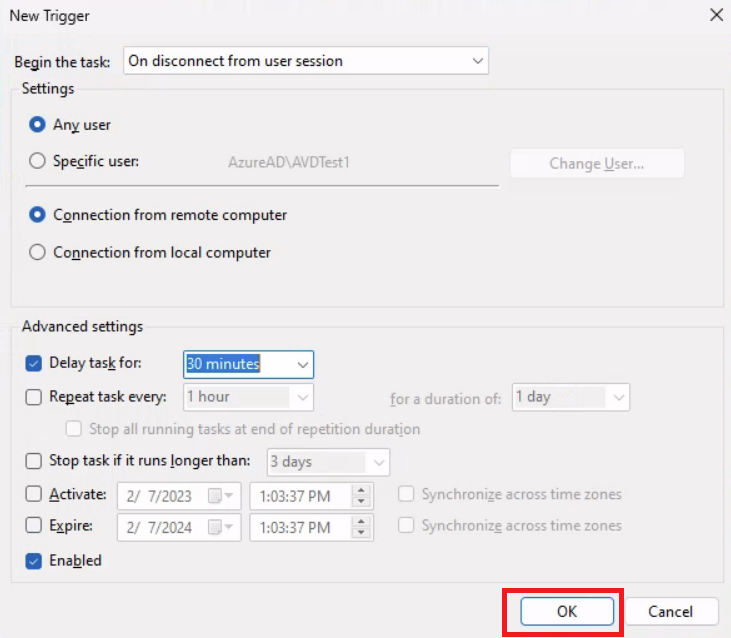

Choisissez le motif de déconnexion avec un délai de 30 minutes, ou moins si besoin, puis passez sur l’onglet suivant :

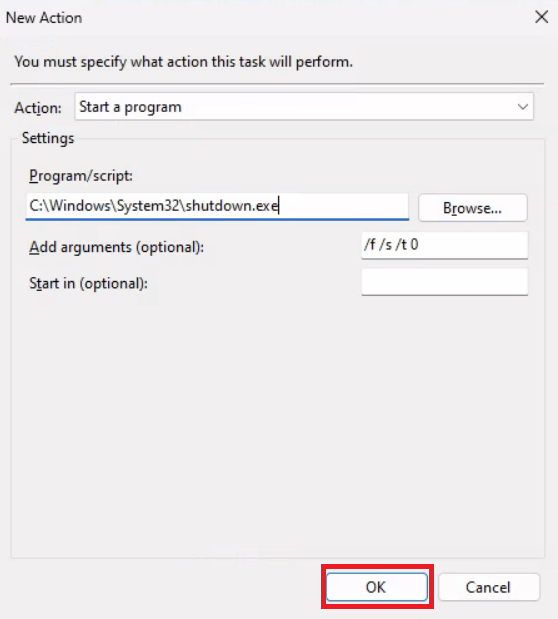

Sur l’onglet des actions, ajoutez le lancement du programme Shutdown, avec les arguments suivants :

/f /s /t 0Validez la création de la Tâche planifiée en cliquant sur OK :

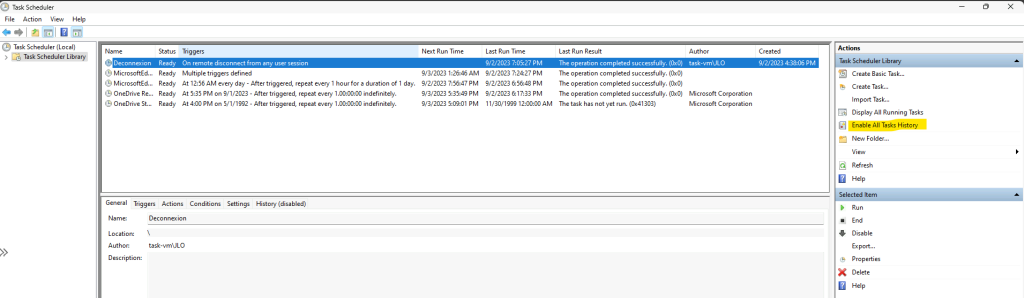

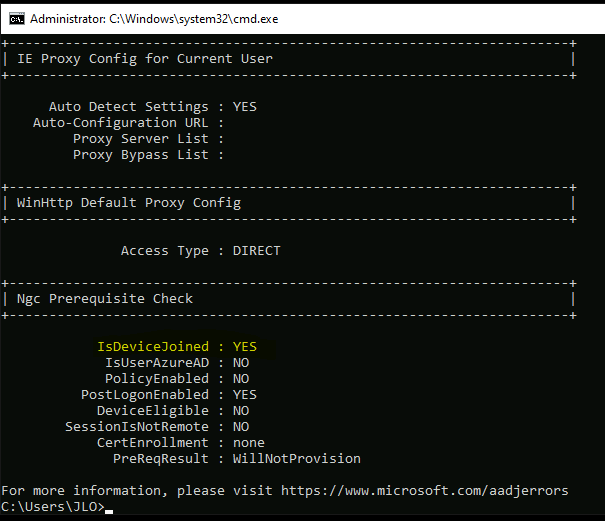

Activez l’historique des tâches planifiées afin de faire remonter l’information dans les journaux d’évènements de Windows :

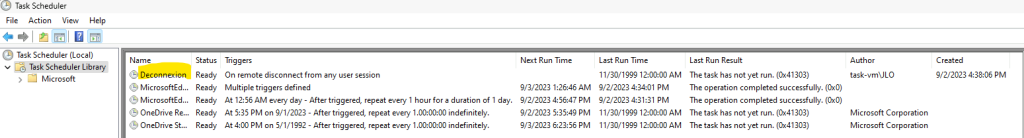

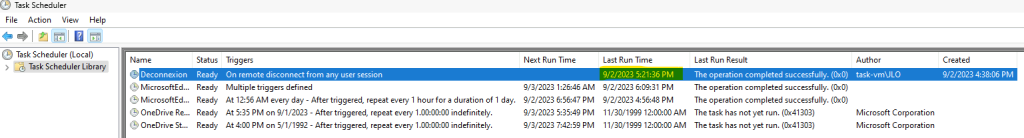

Vérifiez que votre nouvelle tâche planifiée est bien présente dans la liste, et est active :

Notre environnement de départ est maintenant en place. Nous pouvons vérifier que notre tâche planifiée s’exécute correctement en :

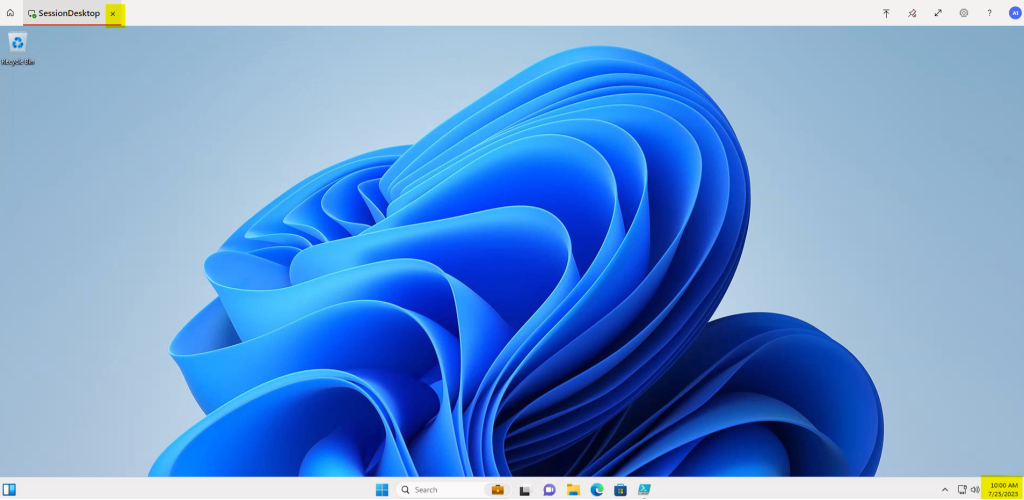

- Attendant quelques minutes que la session de bureau à distance ouverte via Azure Bastion déconnecte l’utilisateur pour cause d’inactivité.

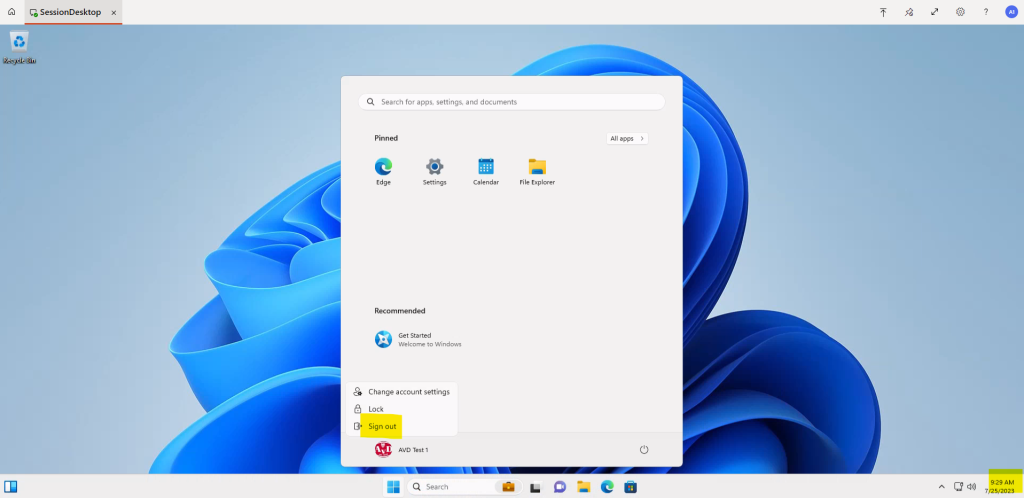

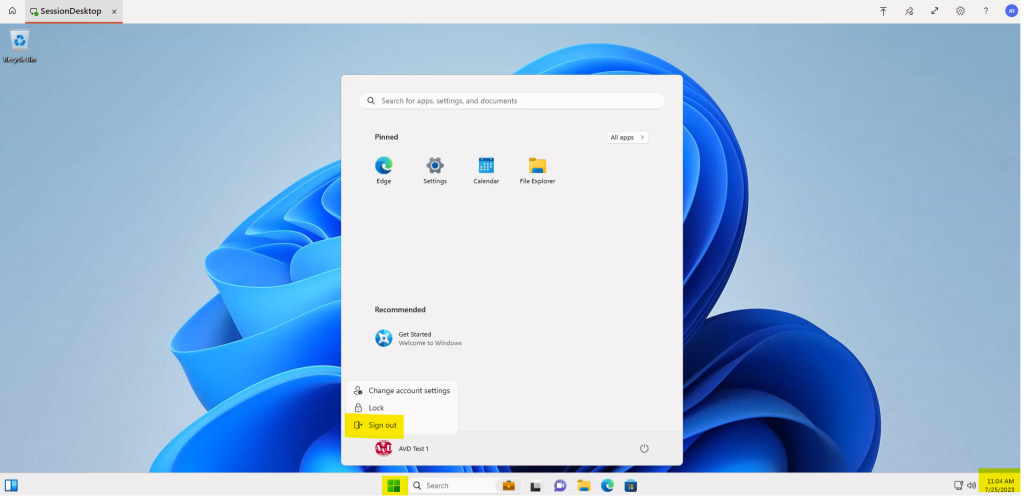

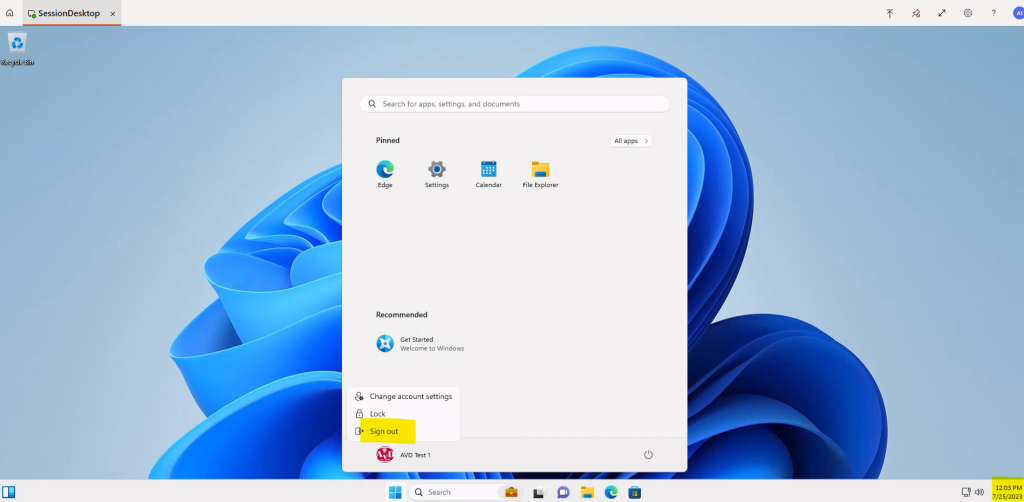

- Déconnectant directement votre utilisateur de test depuis le menu Démarrer.

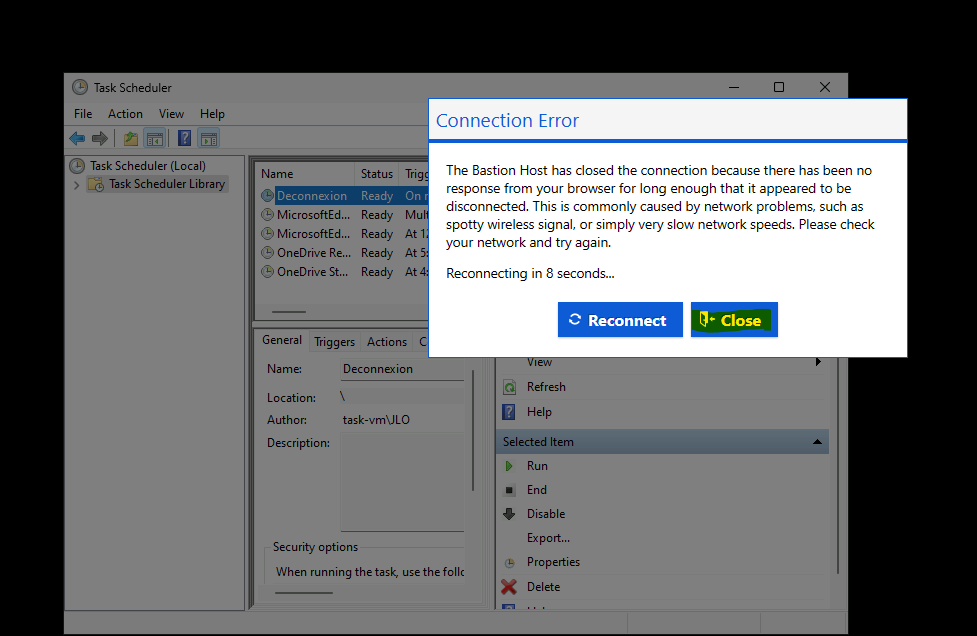

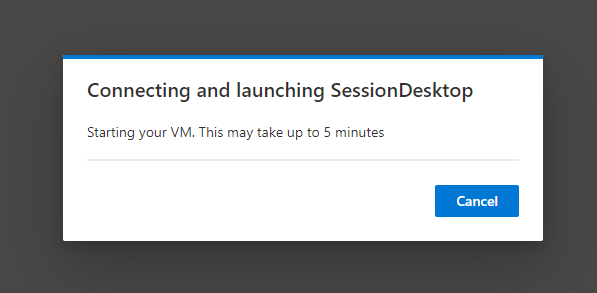

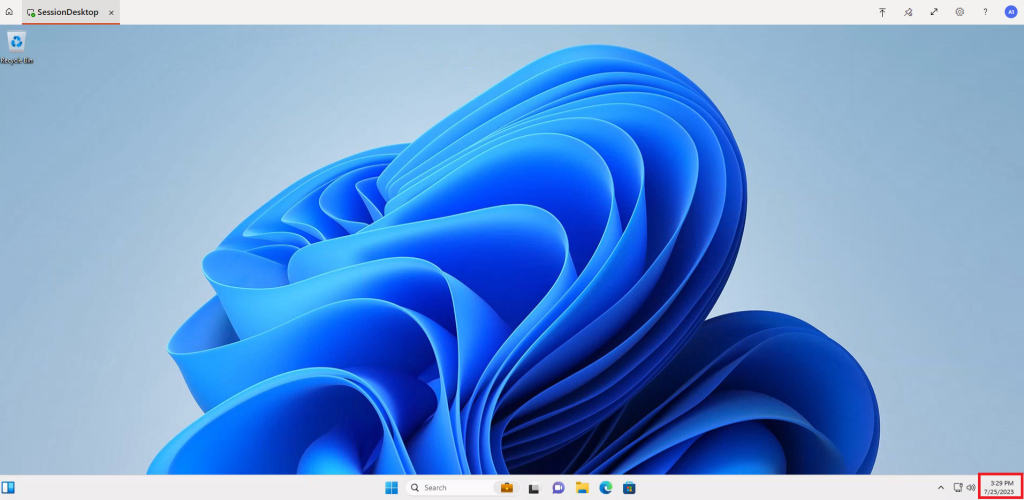

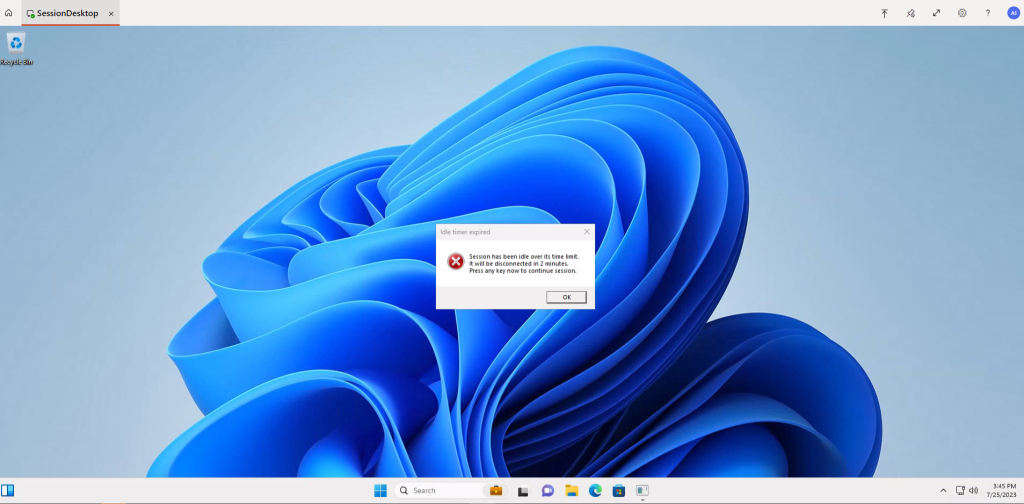

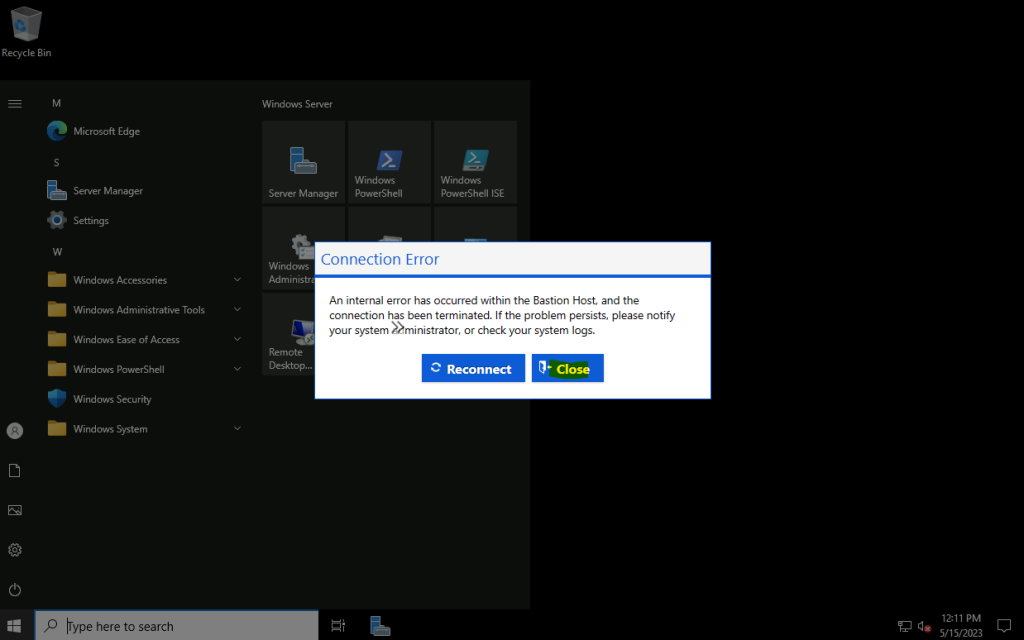

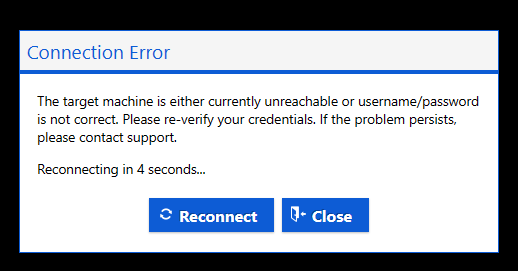

Dans mon cas, j’attends que Bastion fasse le travaille à ma place :

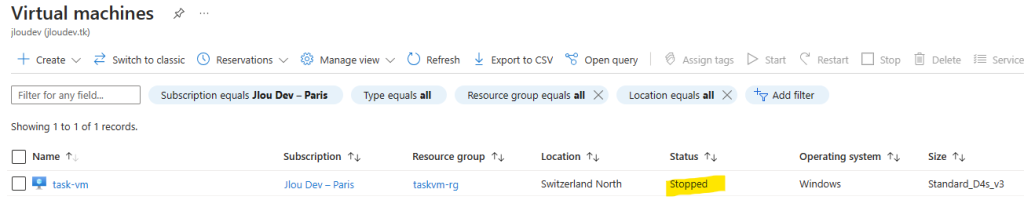

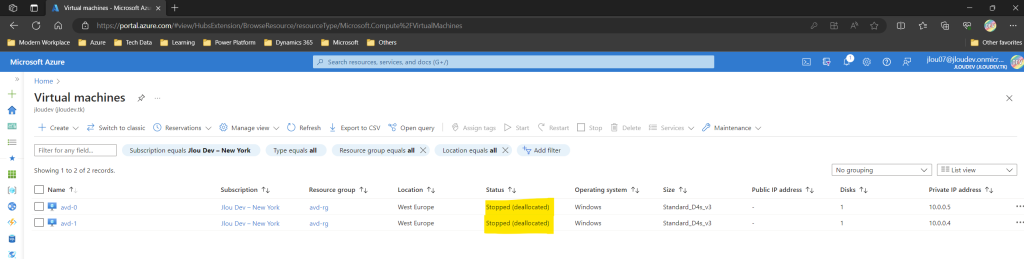

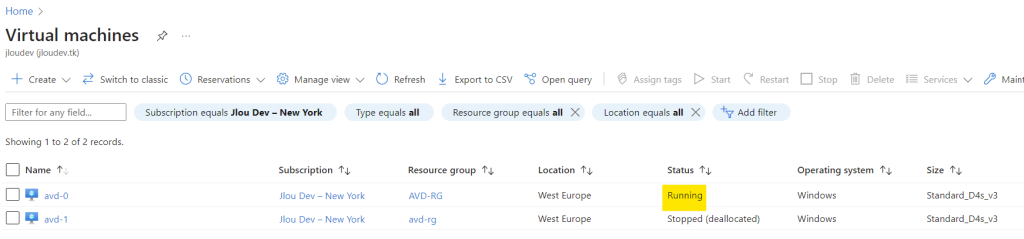

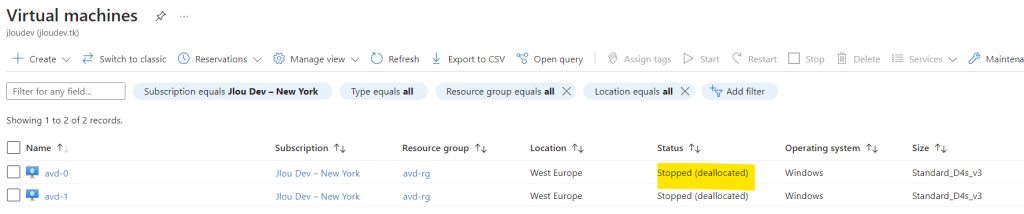

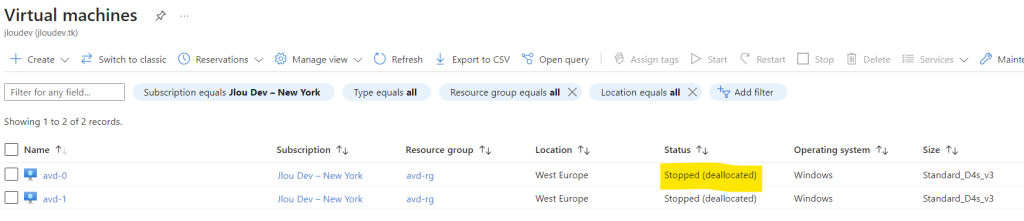

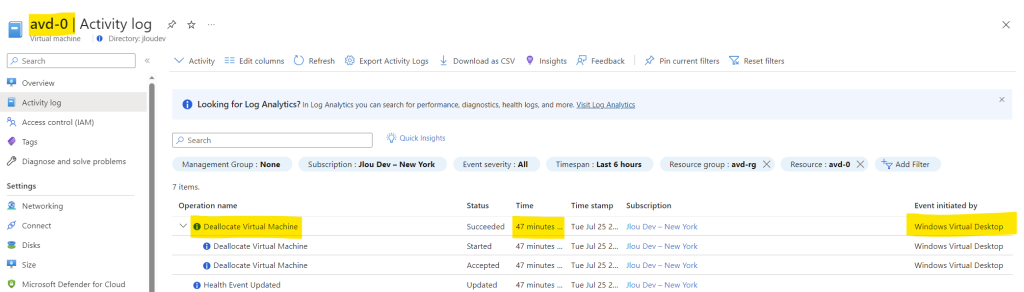

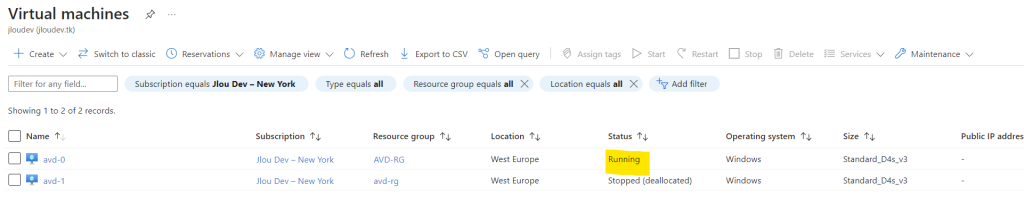

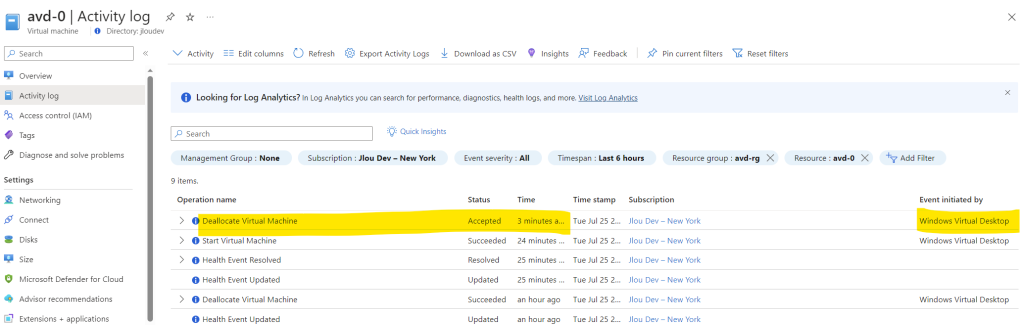

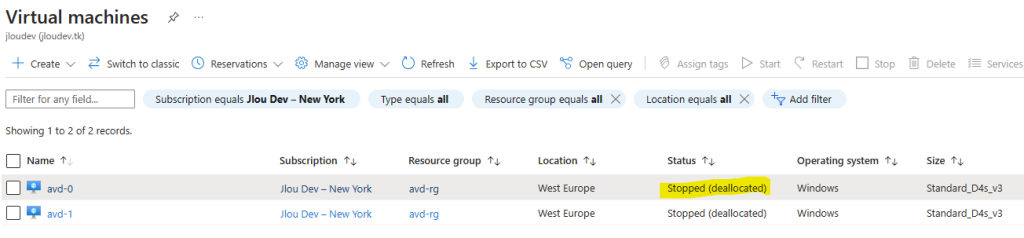

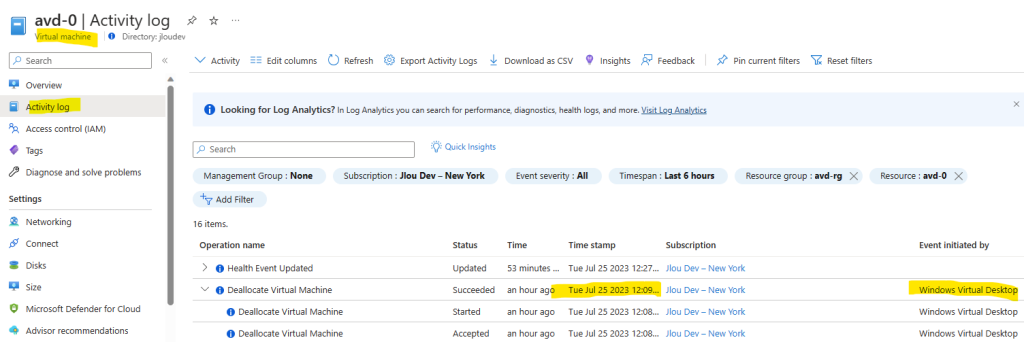

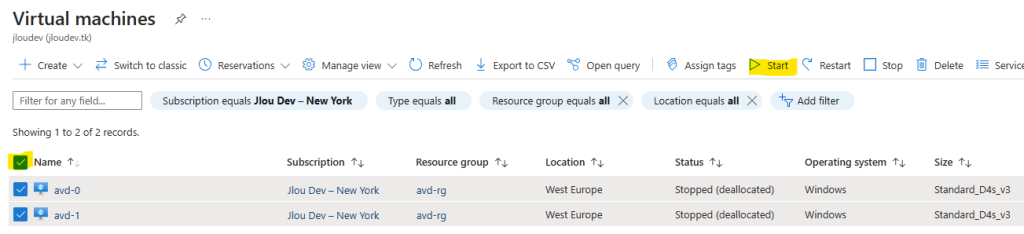

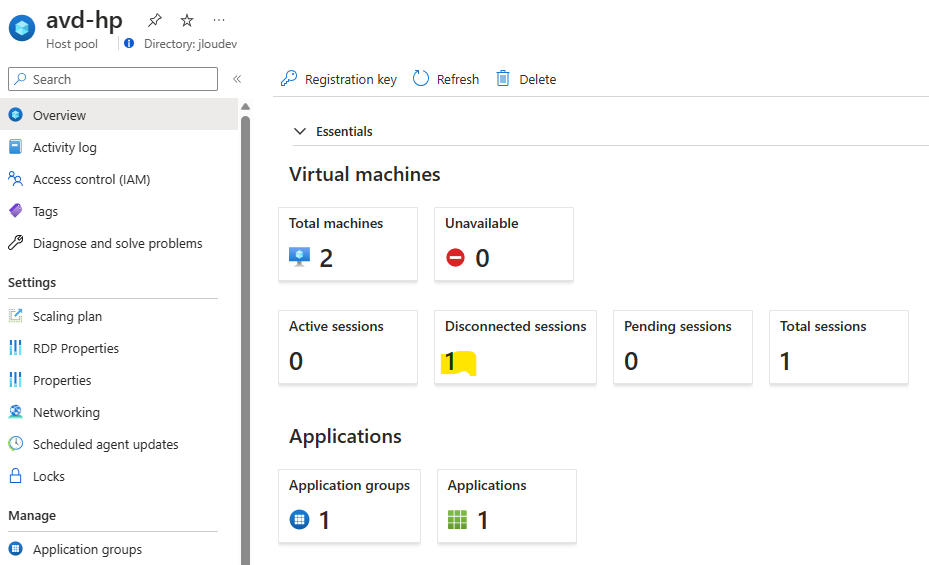

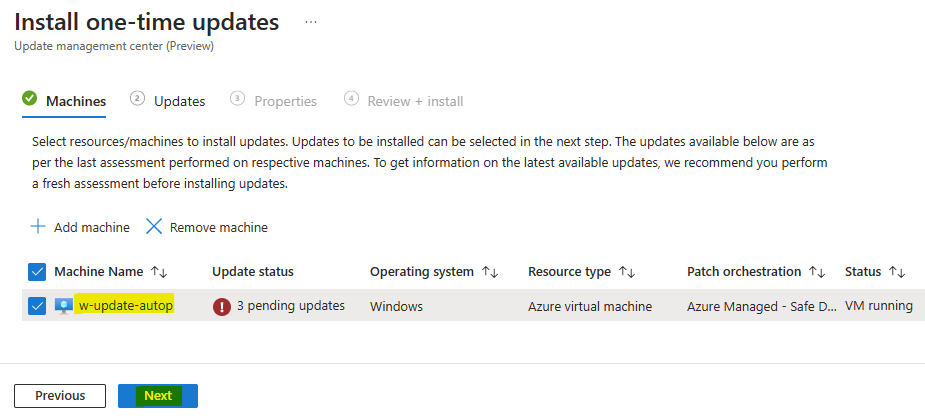

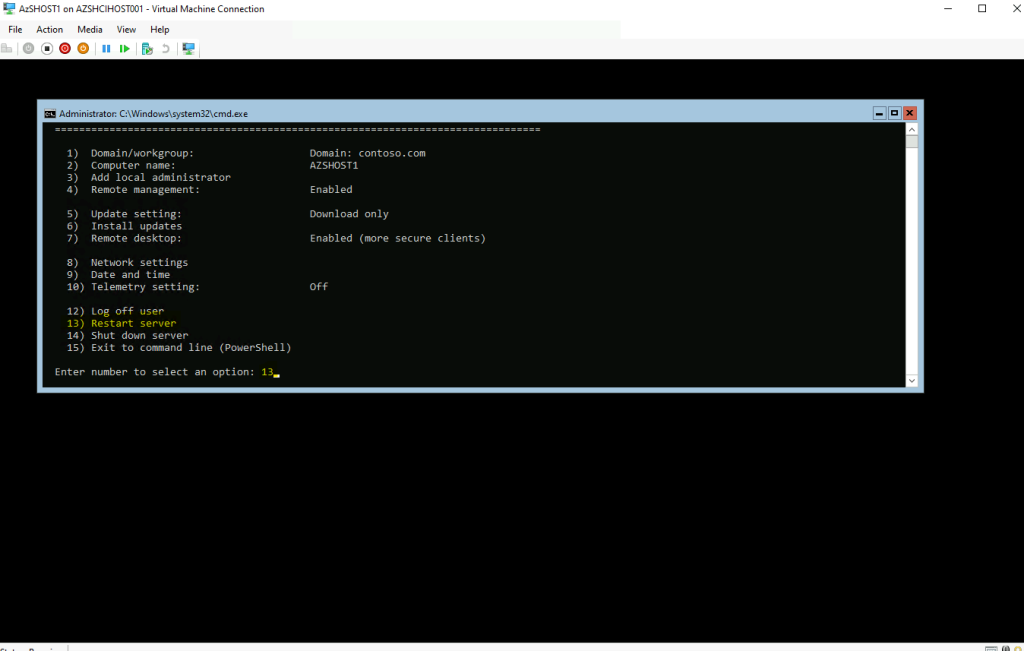

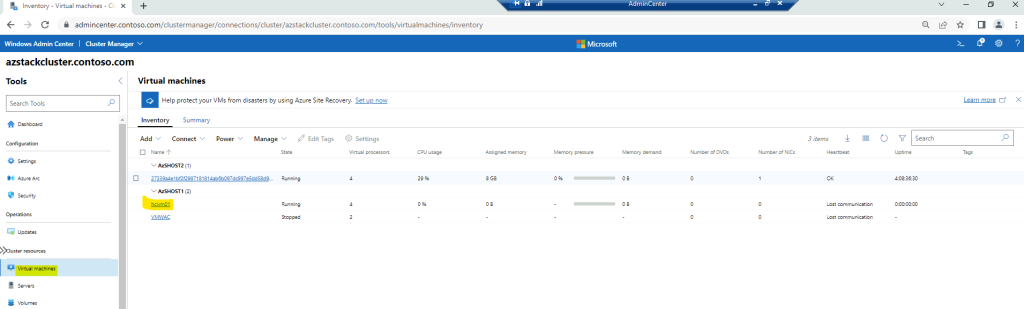

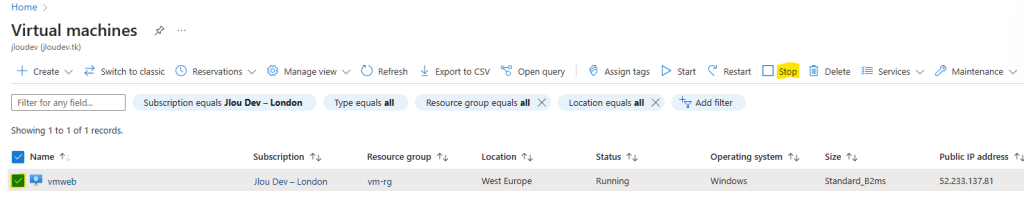

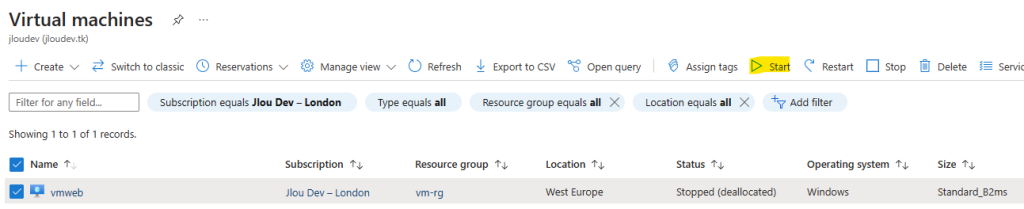

Une fois la session déconnectée, retournez sur la liste de vos machines virtuelles Azure afin de vérifier le changement de statut de celle-ci :

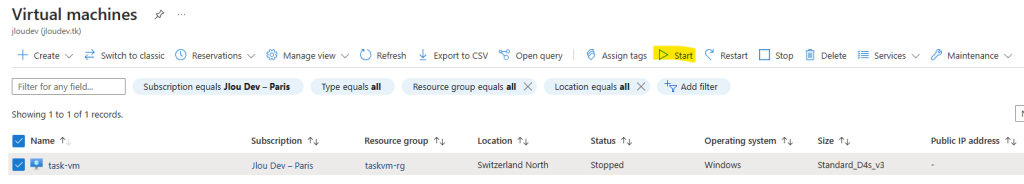

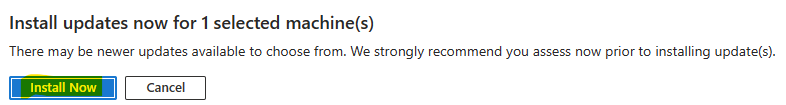

Démarrez votre machine virtuelle afin de vous y reconnecter par la suite :

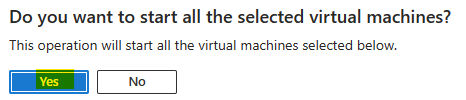

Confirmez votre action en cliquant sur Oui :

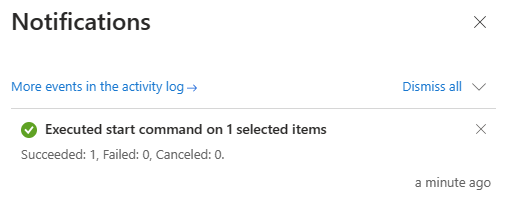

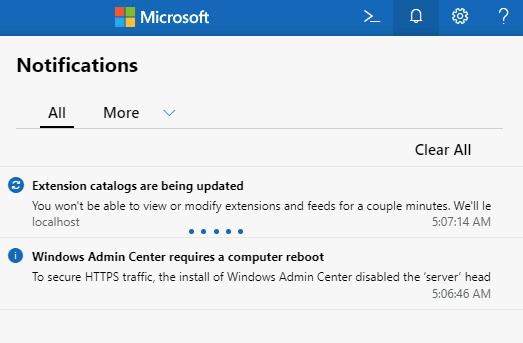

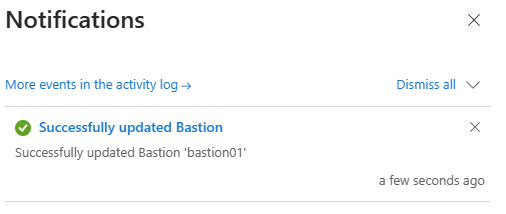

Environ 30 secondes plus tard, la notification Azure suivante vous indique que votre VM est correctement démarrée :

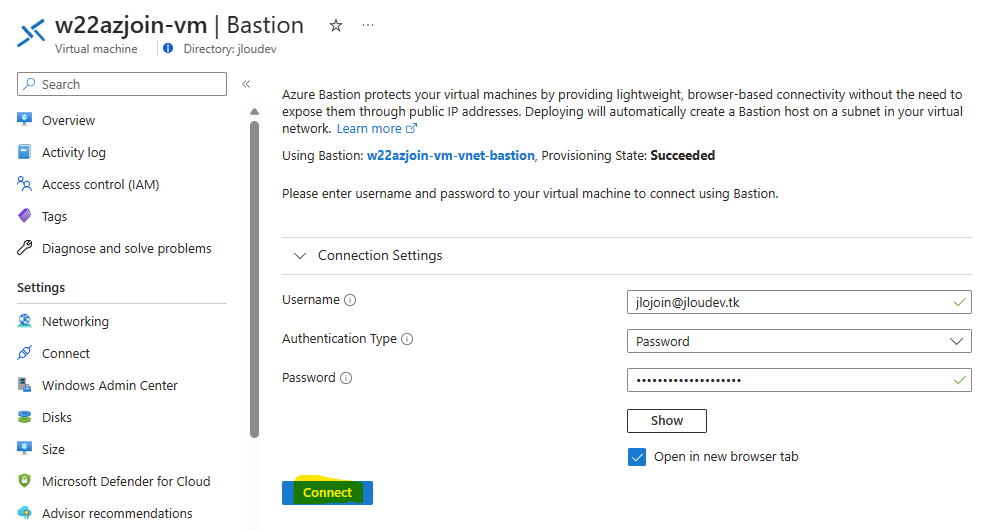

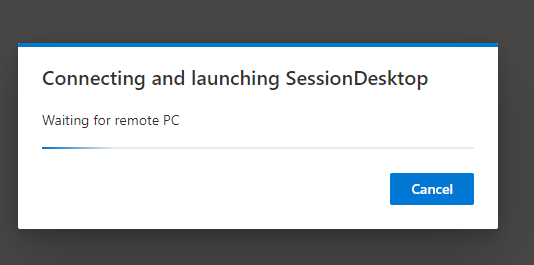

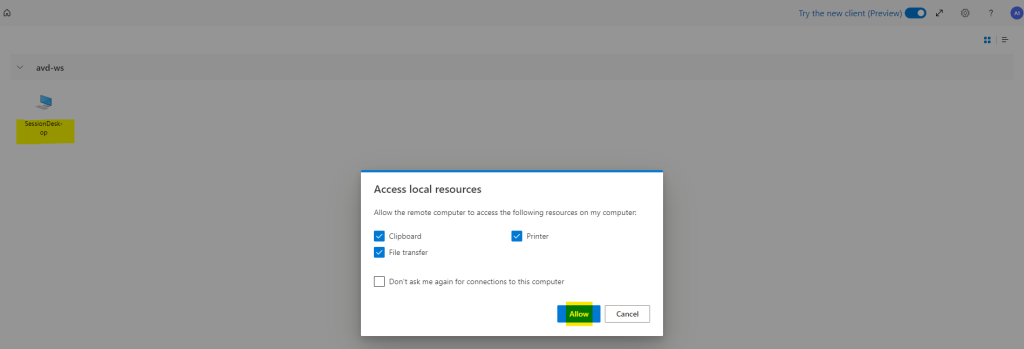

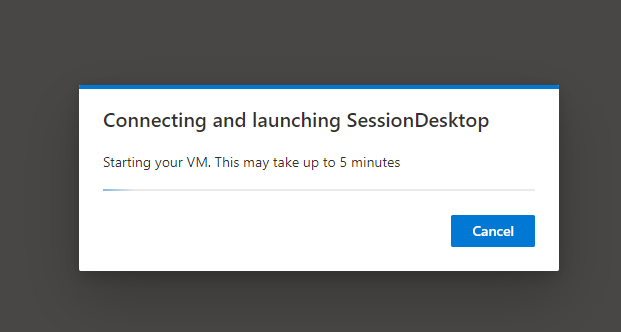

Relancez votre session Windows via Azure Bastion :

Confirmez la bonne exécution de votre tâche planifiée grâce à l’information Dernier lancement :

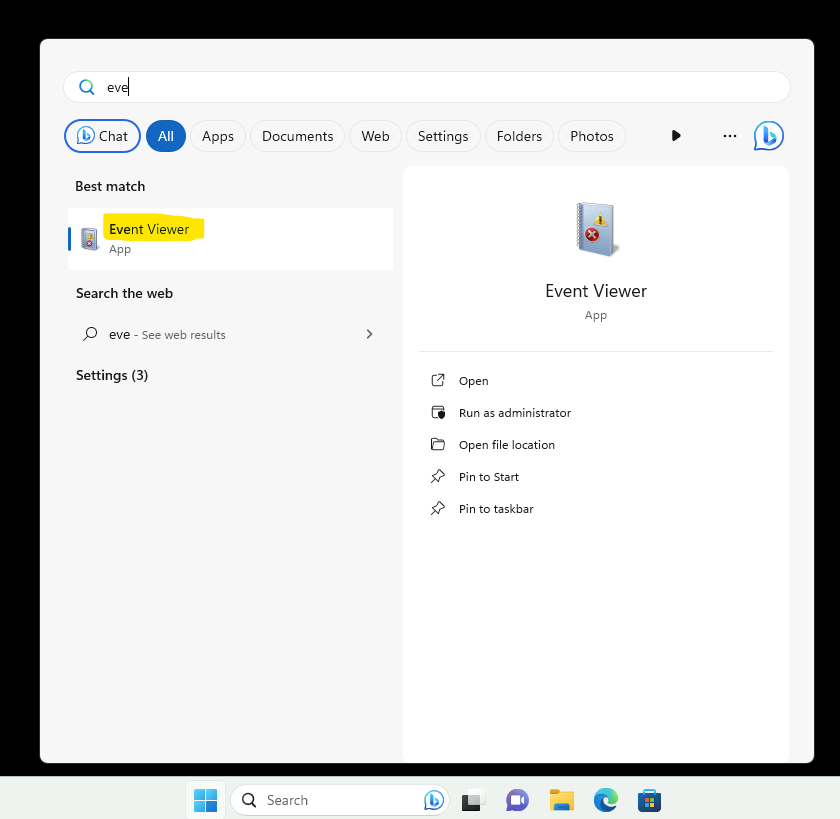

Ouvrez également les journaux d’évènements Windows :

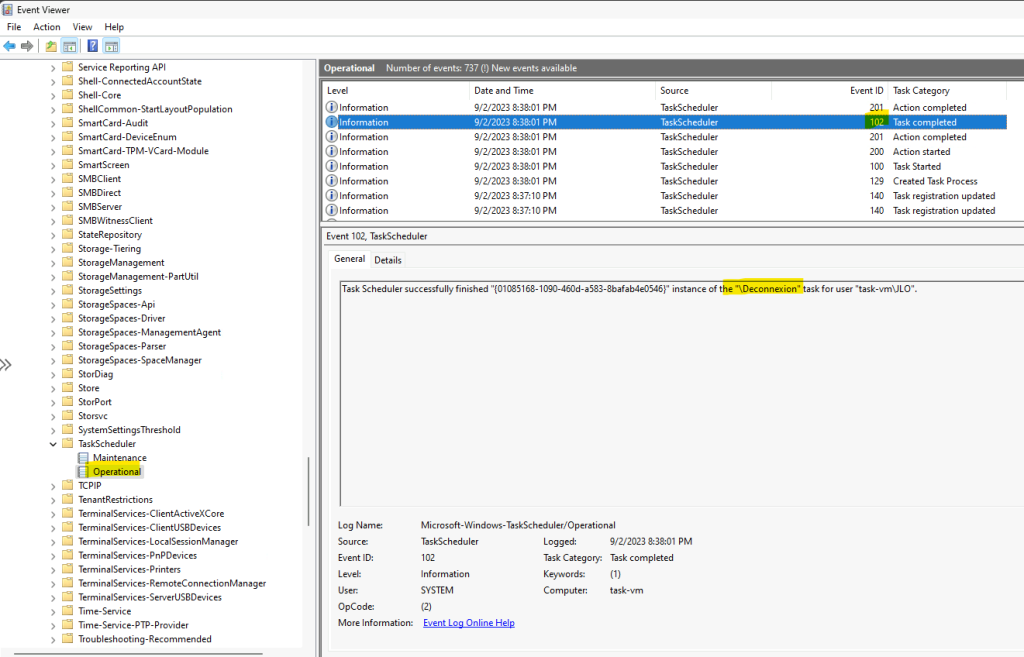

Parcourez l’arborescence suivante pour constater l’historisation de votre tâche planifiée :

- Applications and Services Logs

- Microsoft

- Windows

- TaskScheduler

- Operational

- TaskScheduler

- Windows

- Microsoft

Votre environnement de test Windows est maintenant configuré.

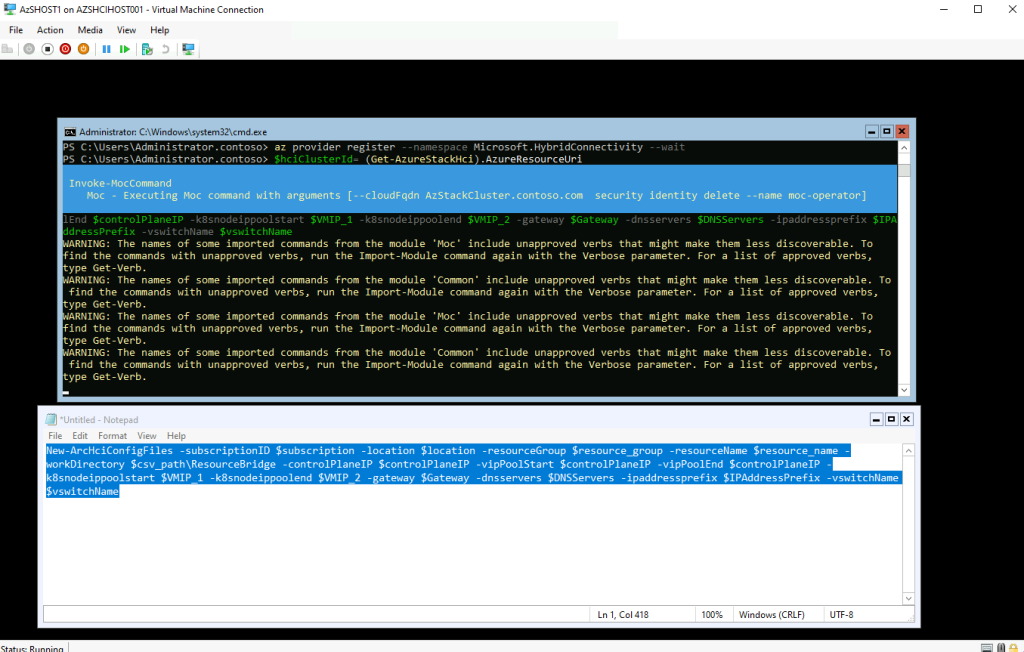

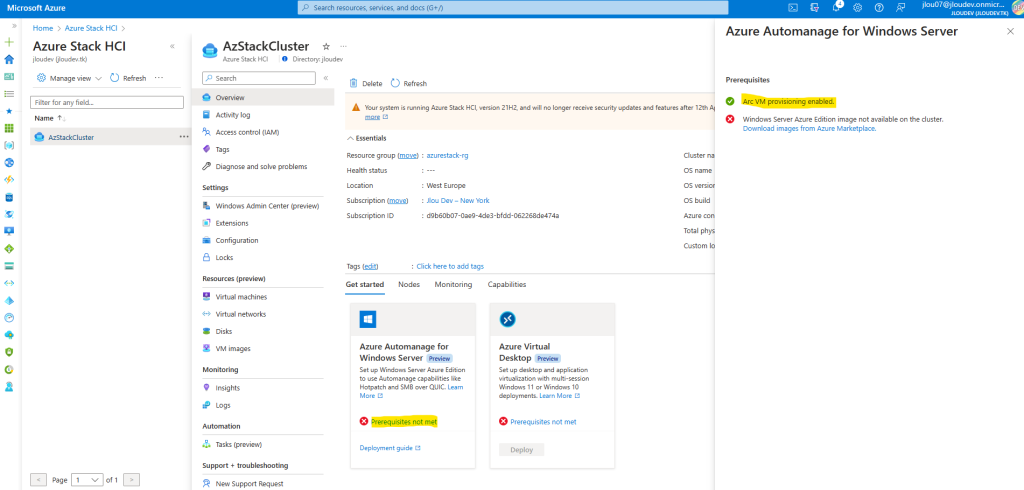

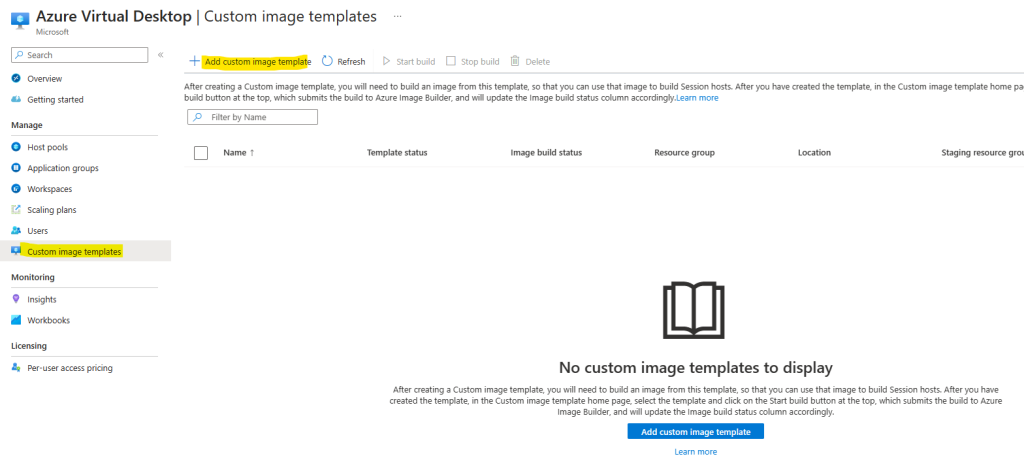

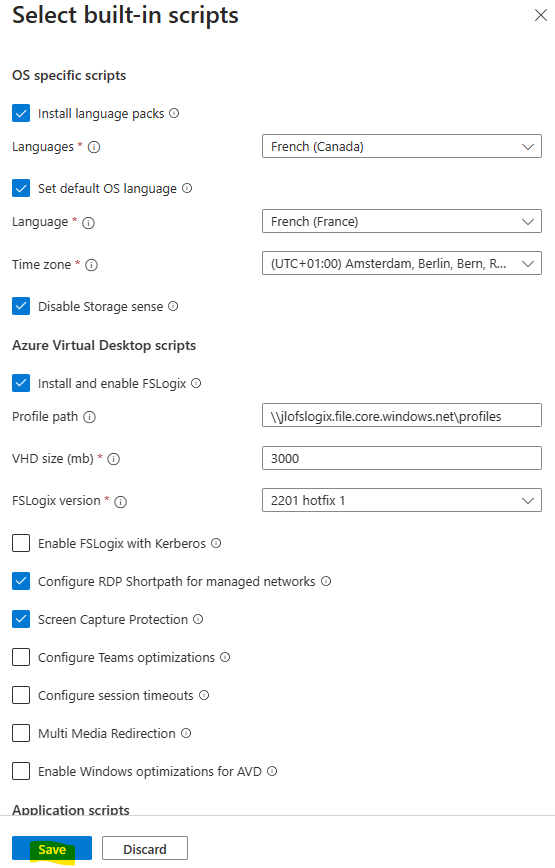

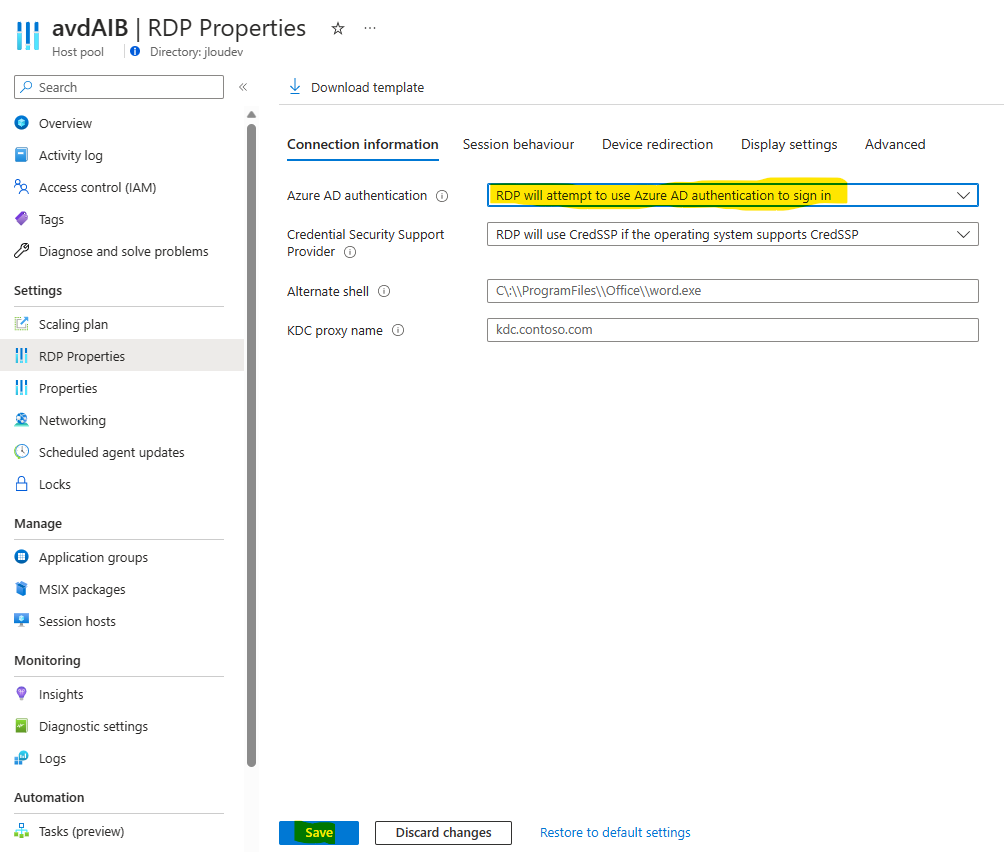

Pour qu’Azure Monitor vous alerte sur l’exécution (ou l’absence d’exécution) de la tâche planifiée, il est nécessaire de remonter une partie des journaux d’évènements Windows dans Azure.

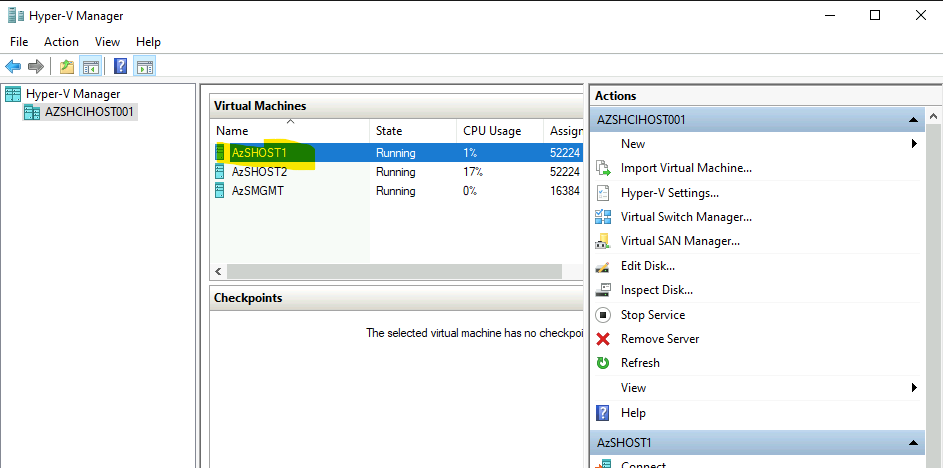

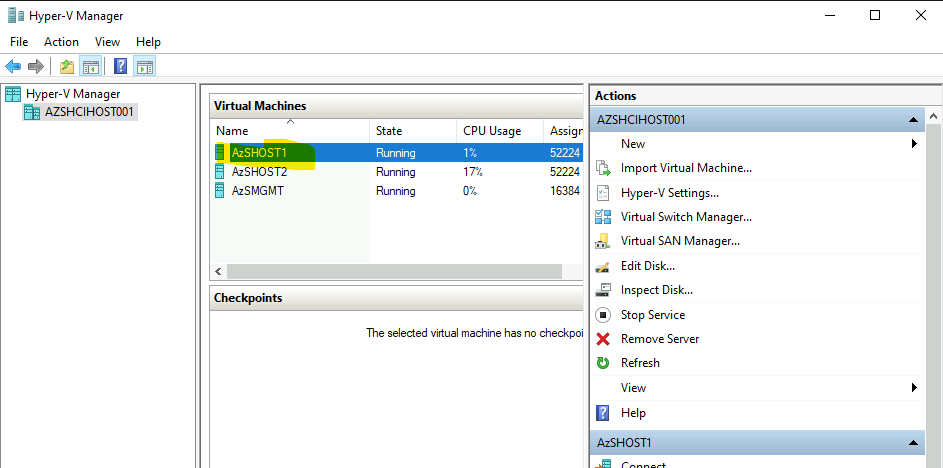

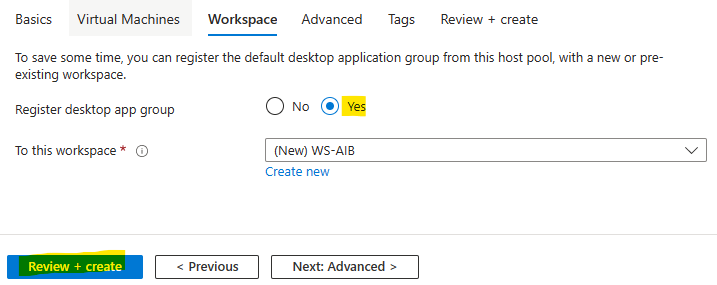

Etape III – Paramétrez la remontée de journaux Windows :

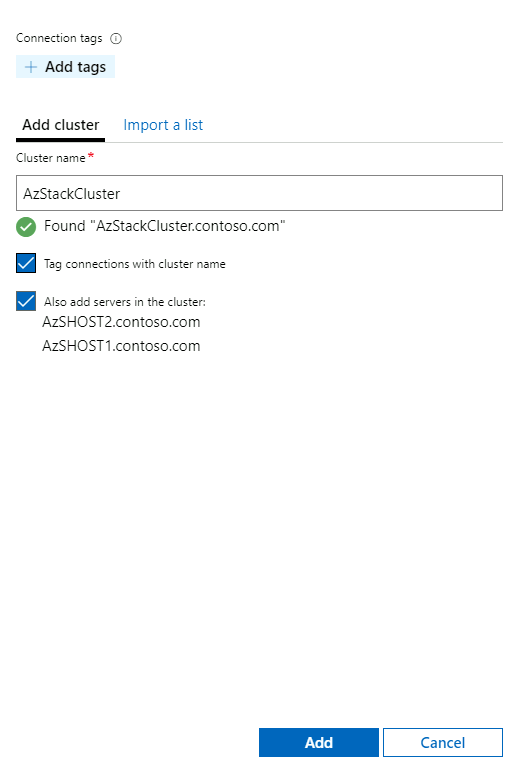

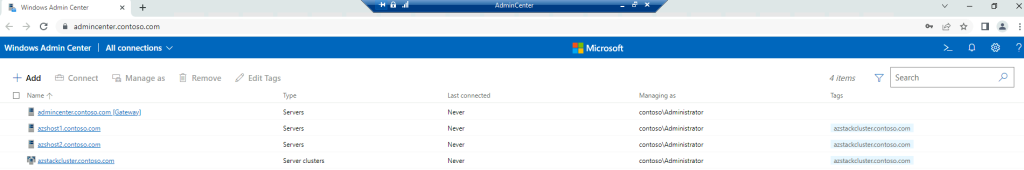

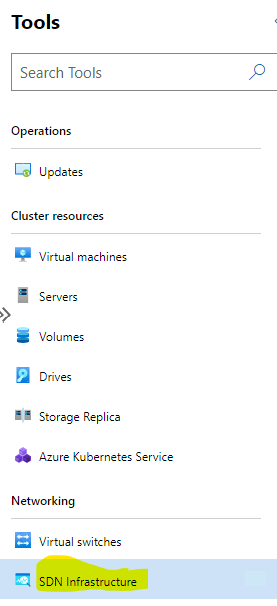

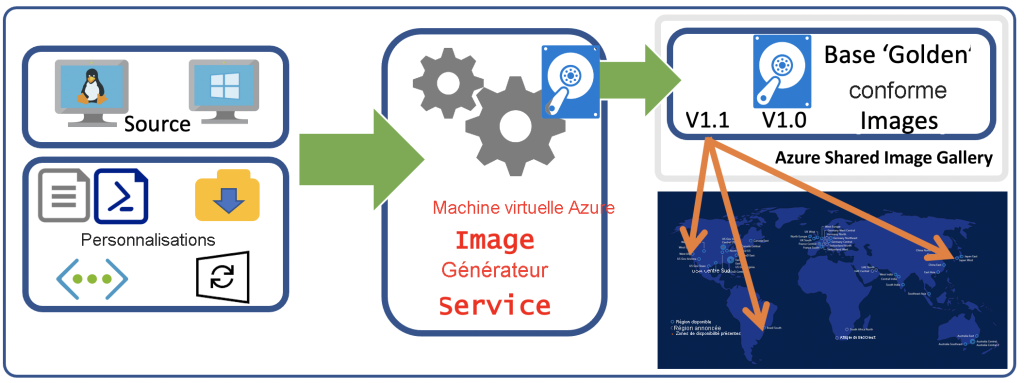

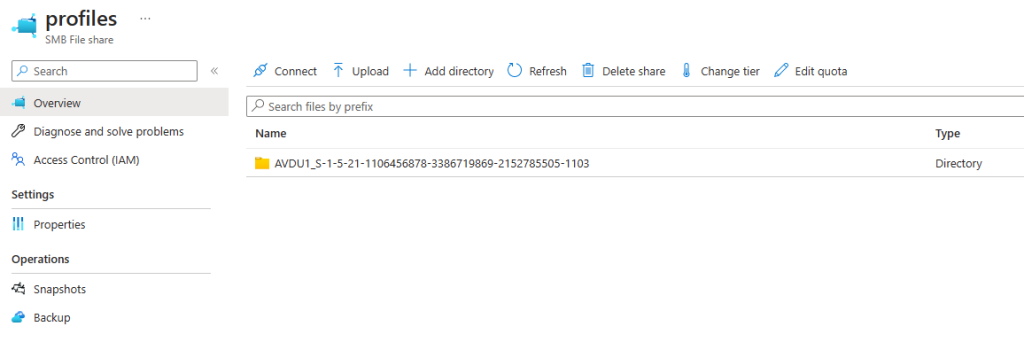

Pour créer notre alerte Azure, nous devons commencer par stocker les informations liées à notre tâche planifiée Windows. Il nous faut donc les stocker, quelque part dans Azure, et les alimenter par les journaux d’évènements Windows.

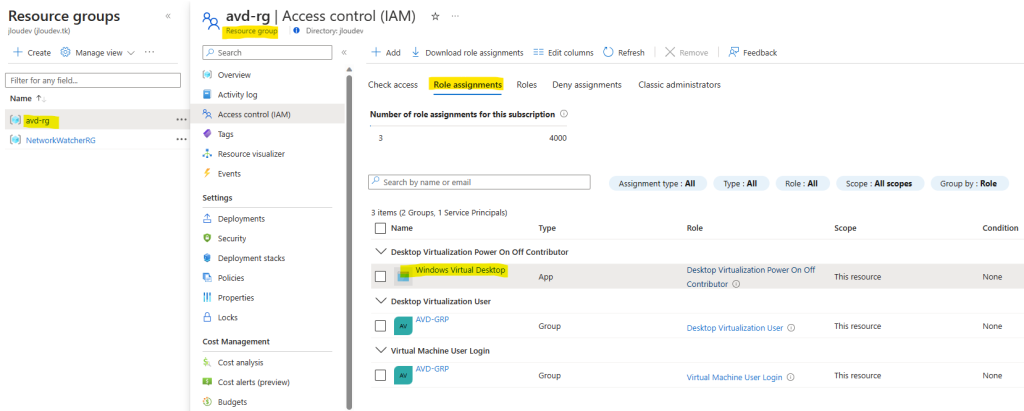

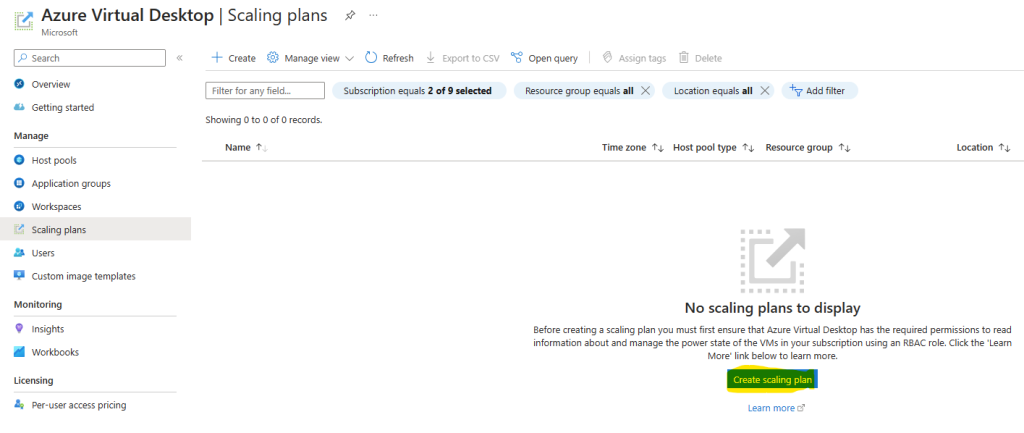

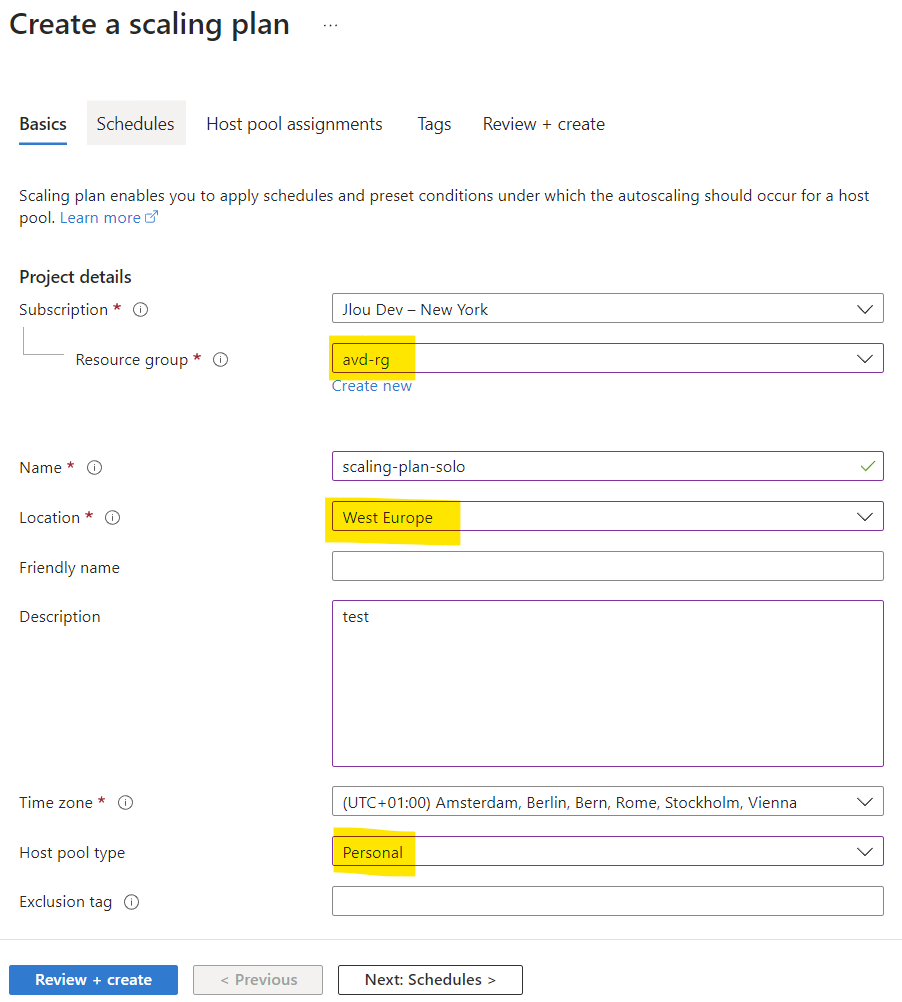

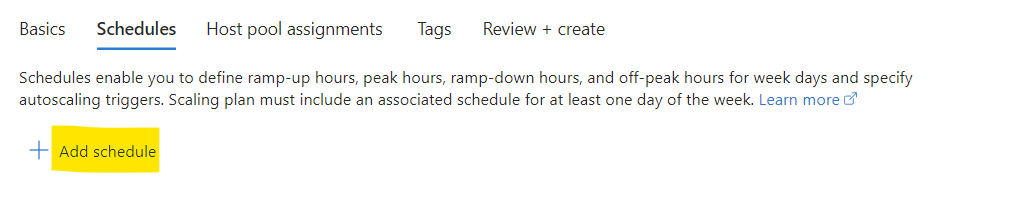

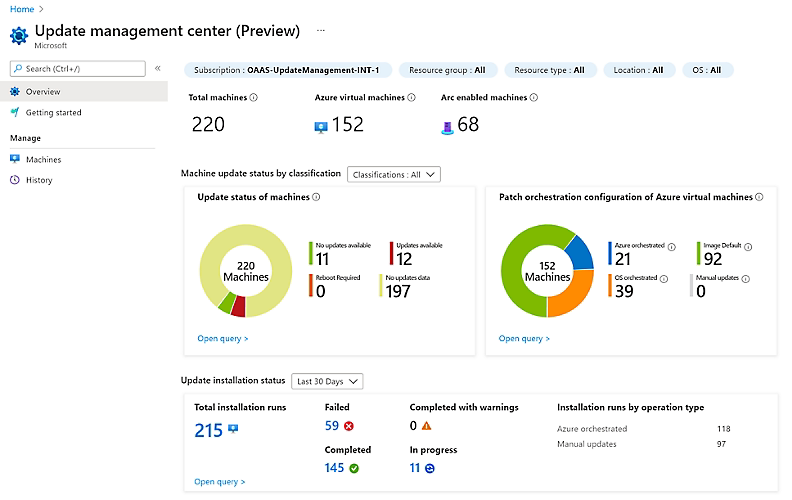

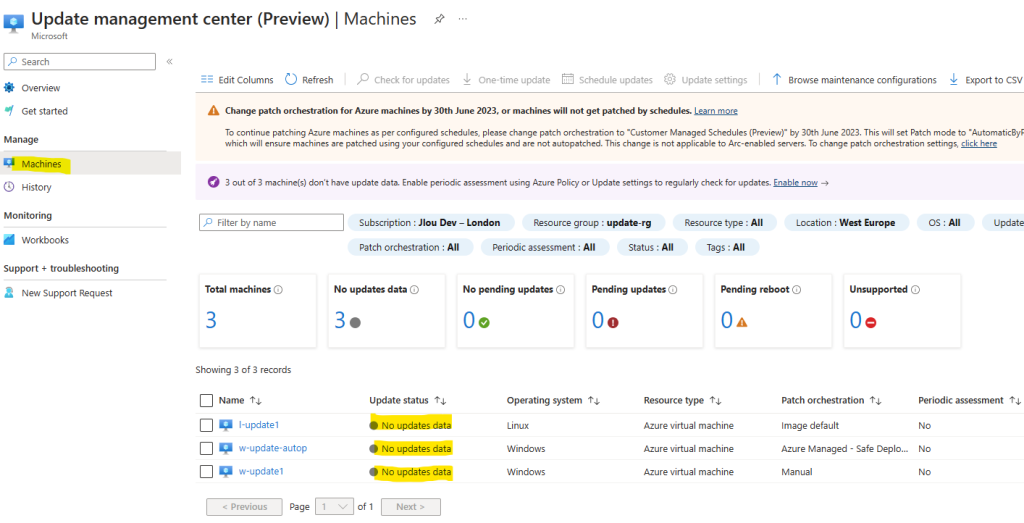

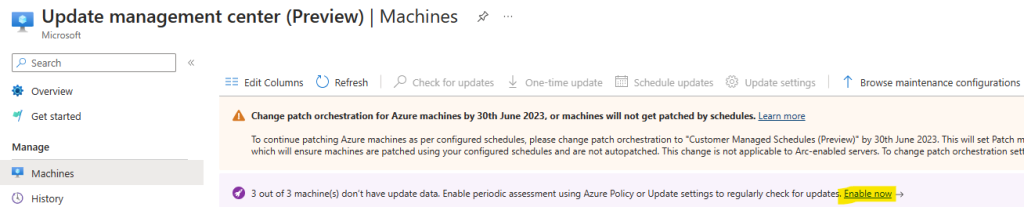

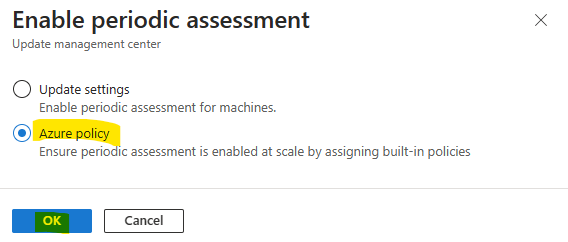

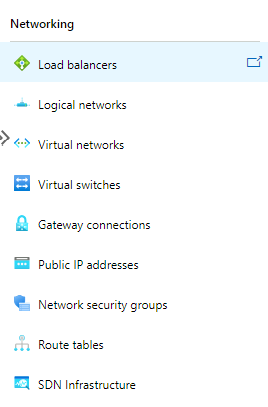

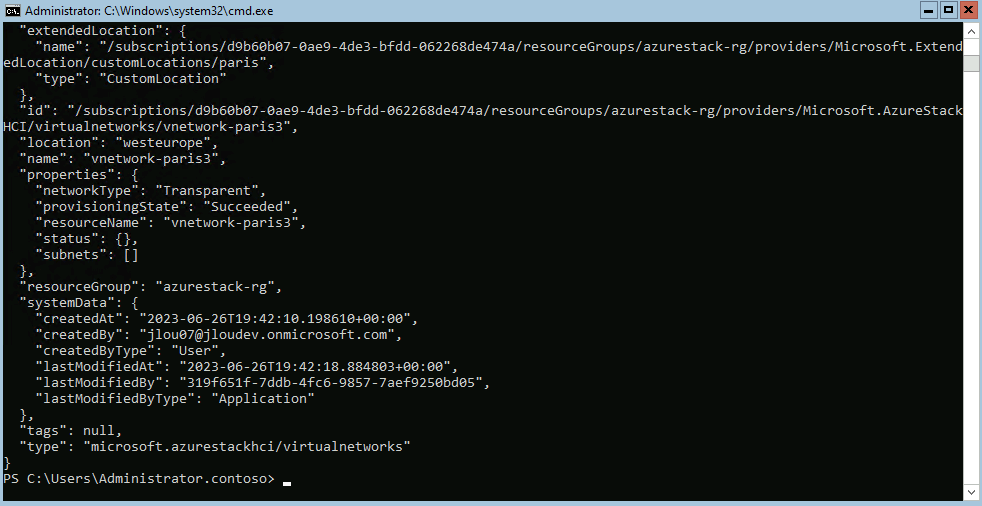

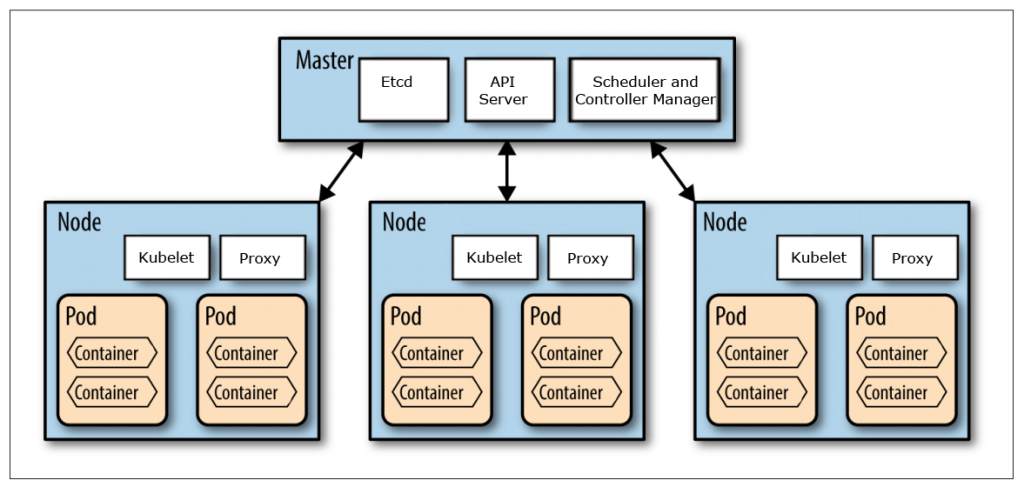

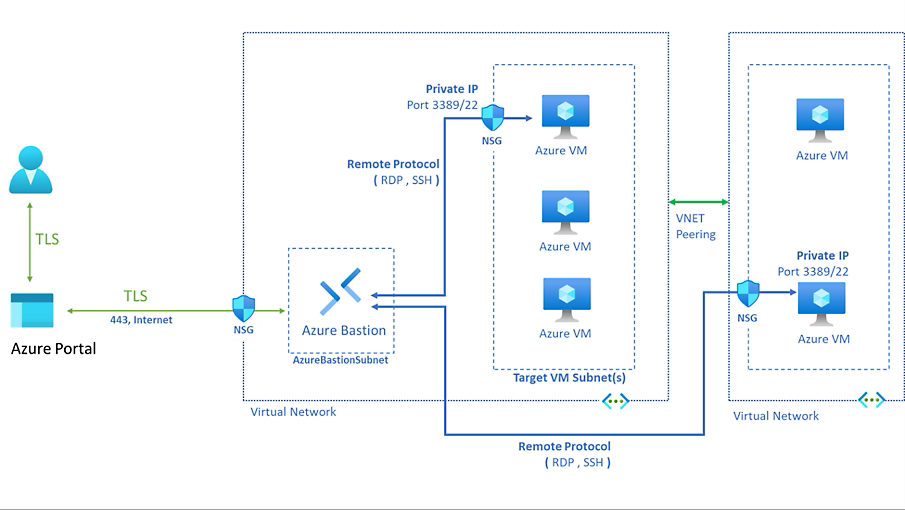

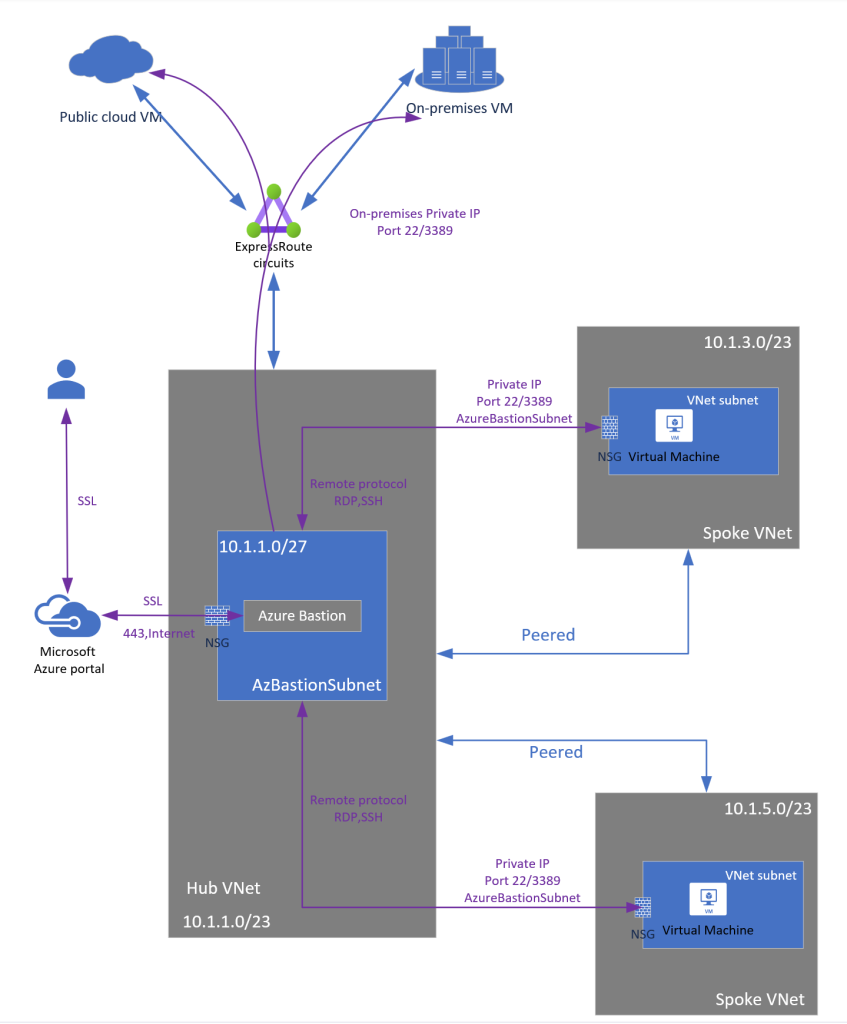

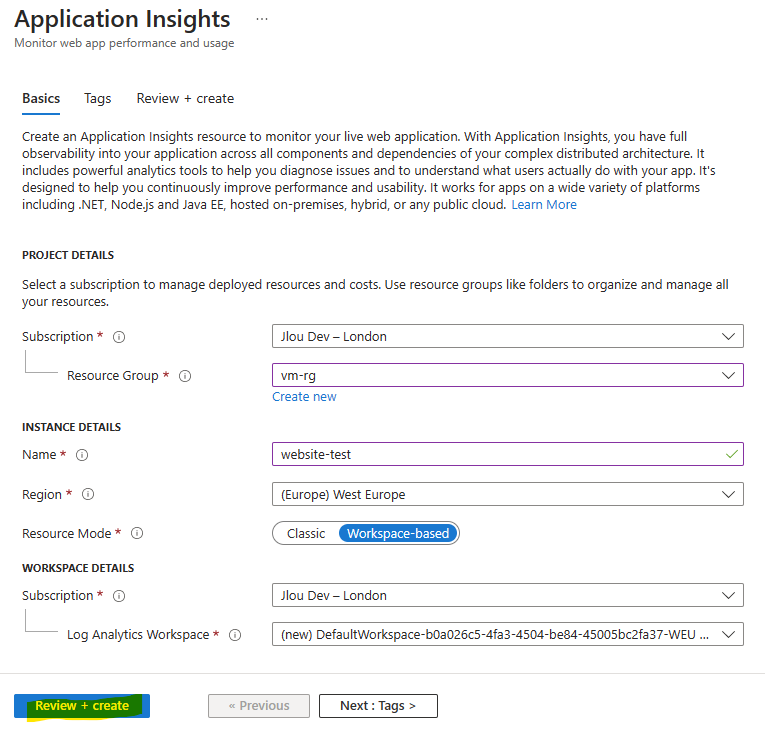

Nous allons avoir donc besoin d’un espace de travail Log Analytics :

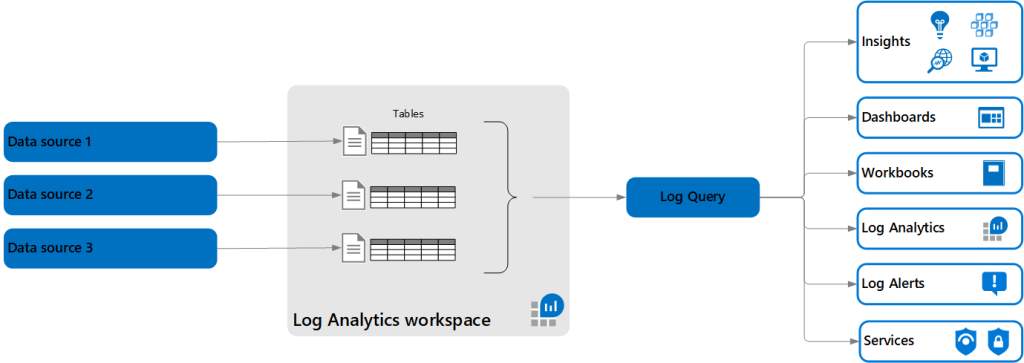

Un espace de travail Log Analytics constitue un environnement unique pour les données de journaux provenant d’Azure Monitor et d’autres services Azure, comme Microsoft Sentinel et Microsoft Defender pour le cloud. Chaque espace de travail possède son propre référentiel de données et sa propre configuration, mais peut combiner des données provenant de plusieurs services.

Microsoft Learn

Le schéma ci-dessous montre de façon assez simple le fonctionnement des services Azure, piochant les données stockées dans des tables, elles-mêmes stockées dans l’espace de travail Log Analytics :

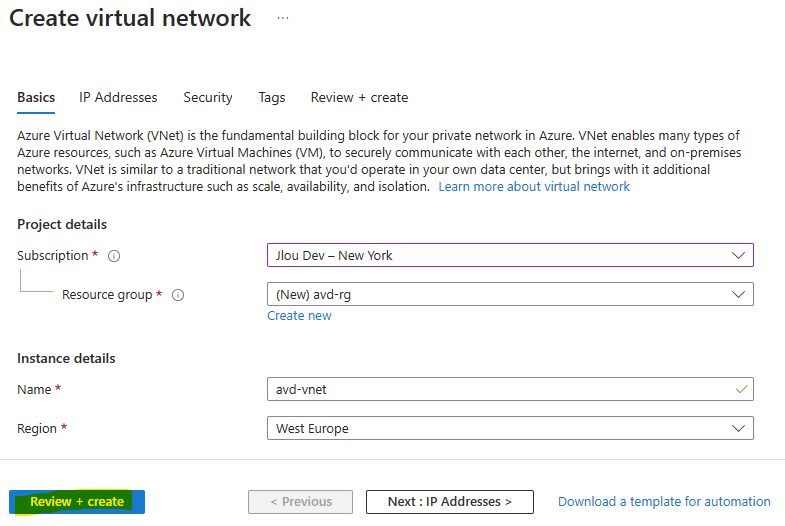

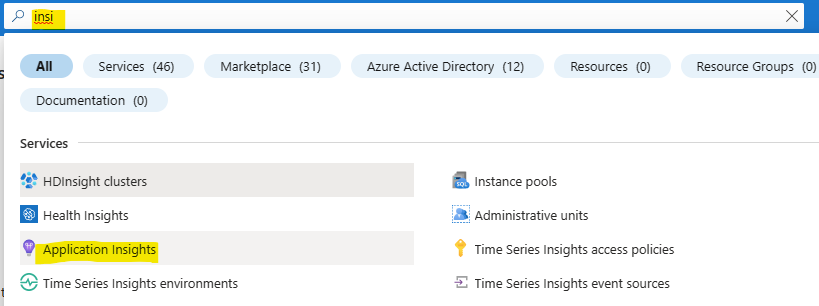

Pour cela, retournez sur le portail d’Azure et utilisez la barre de recherche :

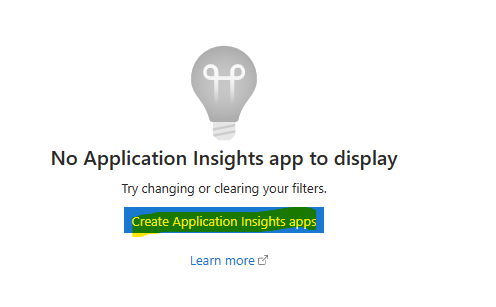

Cliquez-ici pour créer votre premier espace de travail Log Analytics :

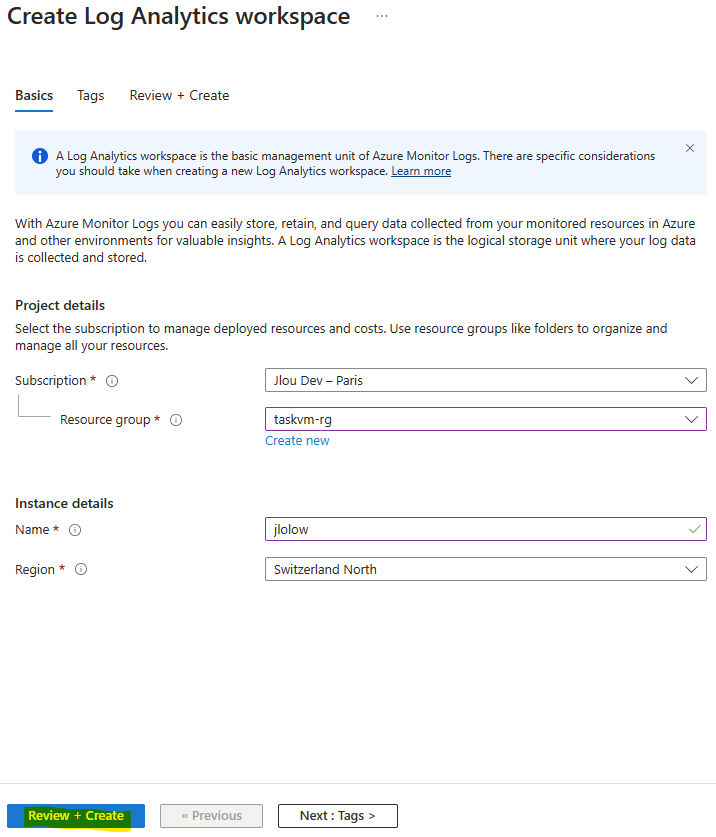

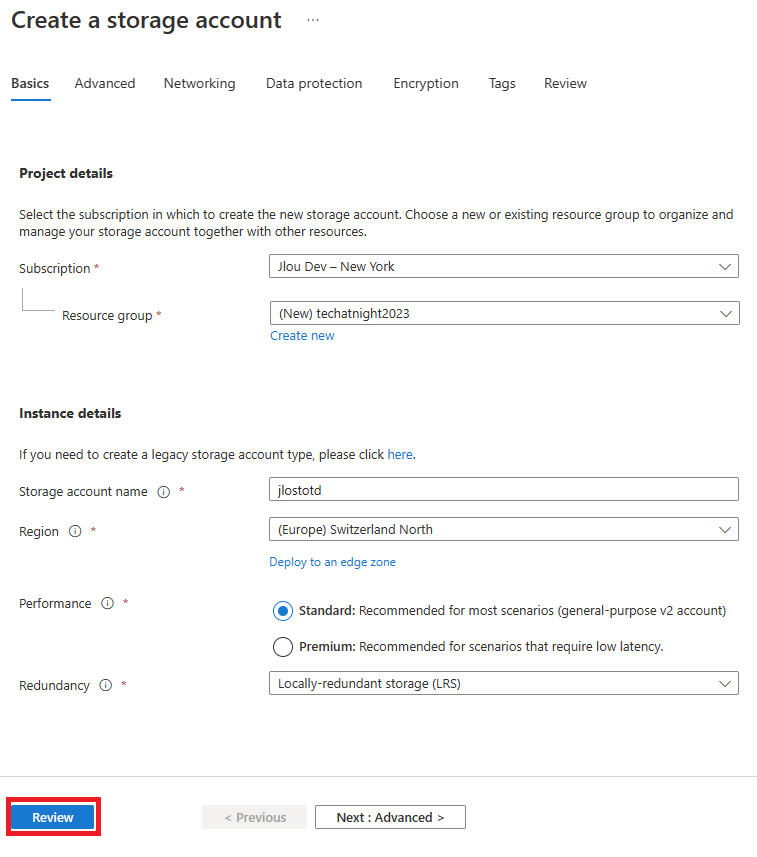

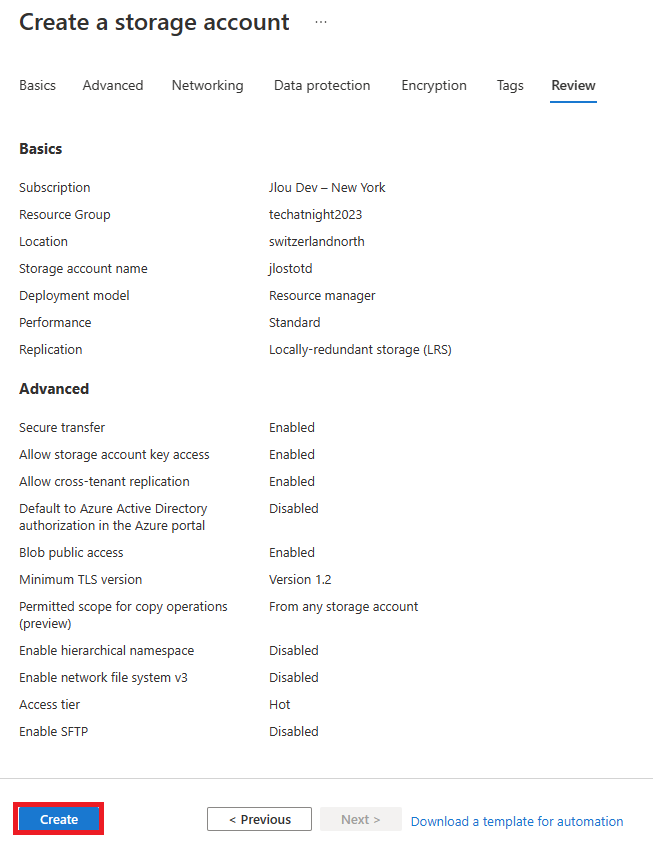

Renseignez les informations de base, puis lancez la validation Azure :

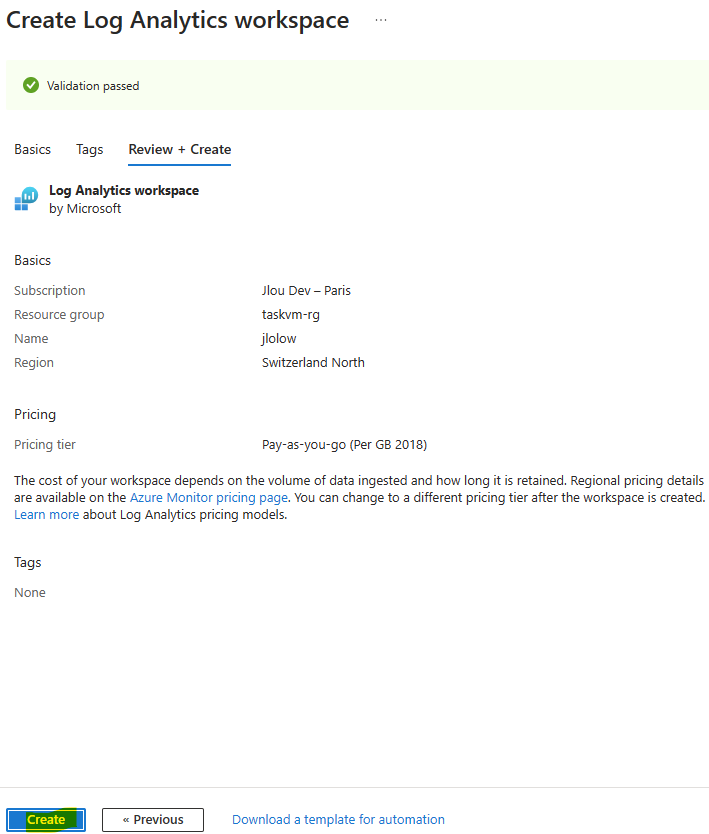

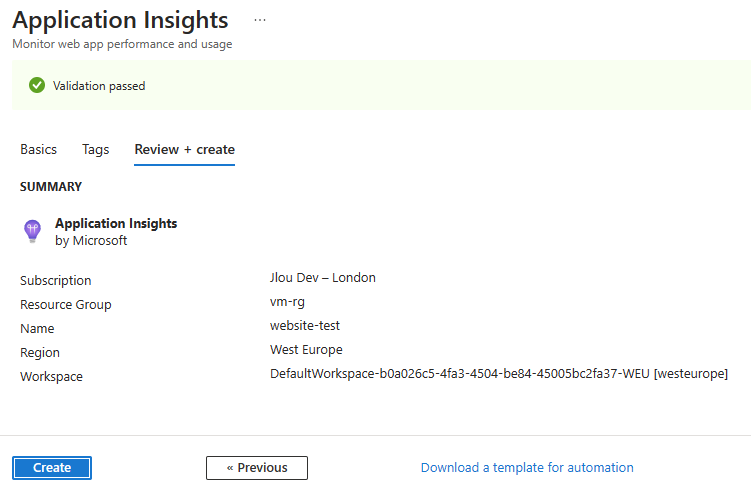

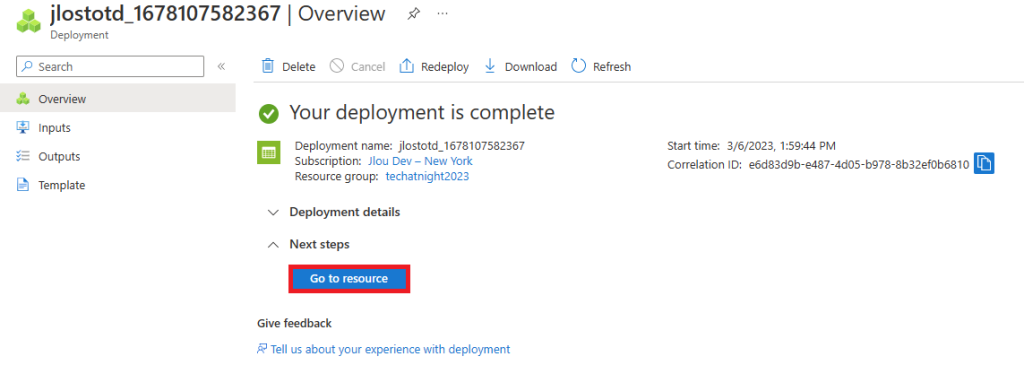

Une fois la validation Azure réussie, lancez la création de la ressource, puis attendez environ 2 minutes :

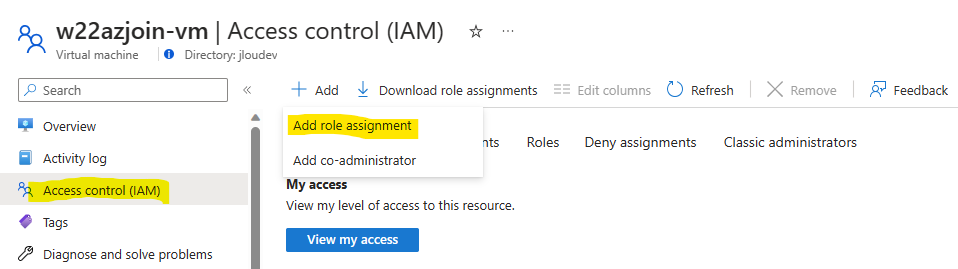

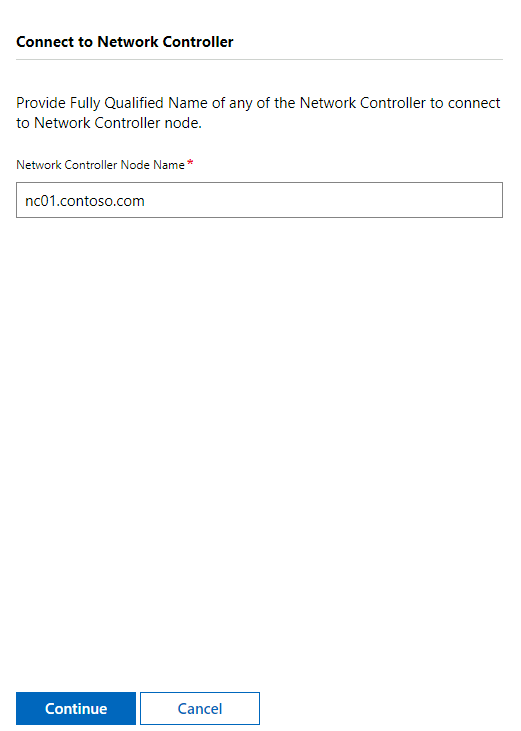

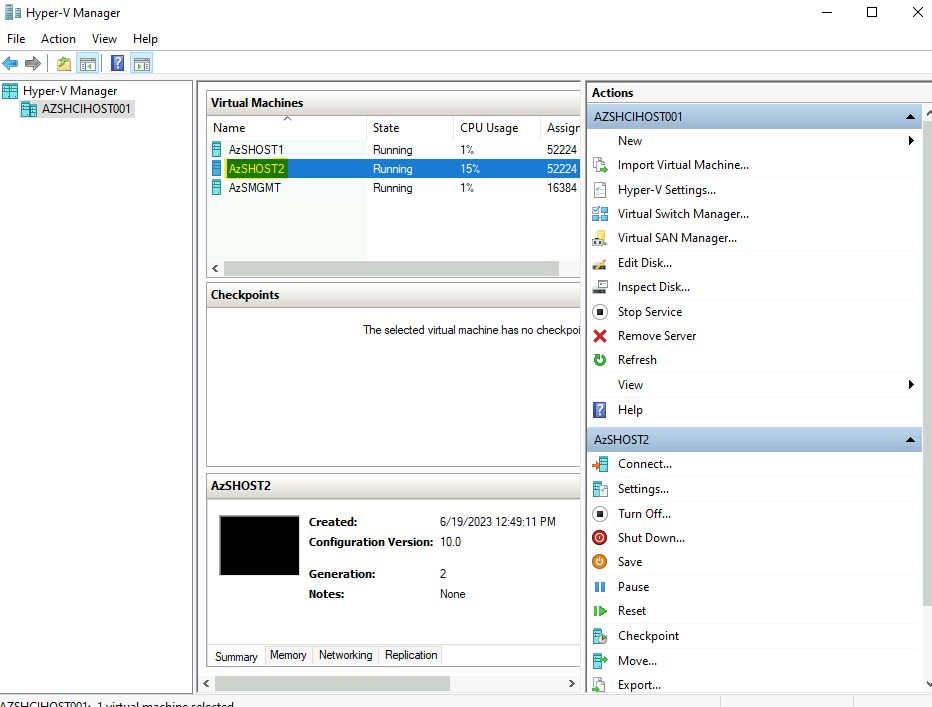

Une fois le déploiement terminé, cliquez-ici pour mettre en place la connexion avec votre VM Windows :

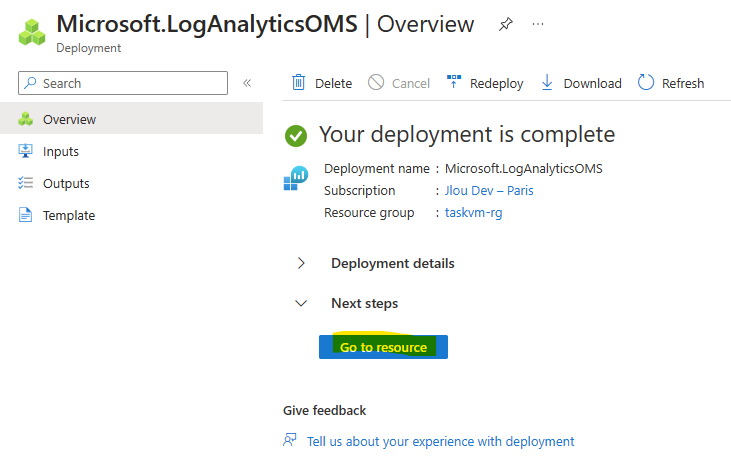

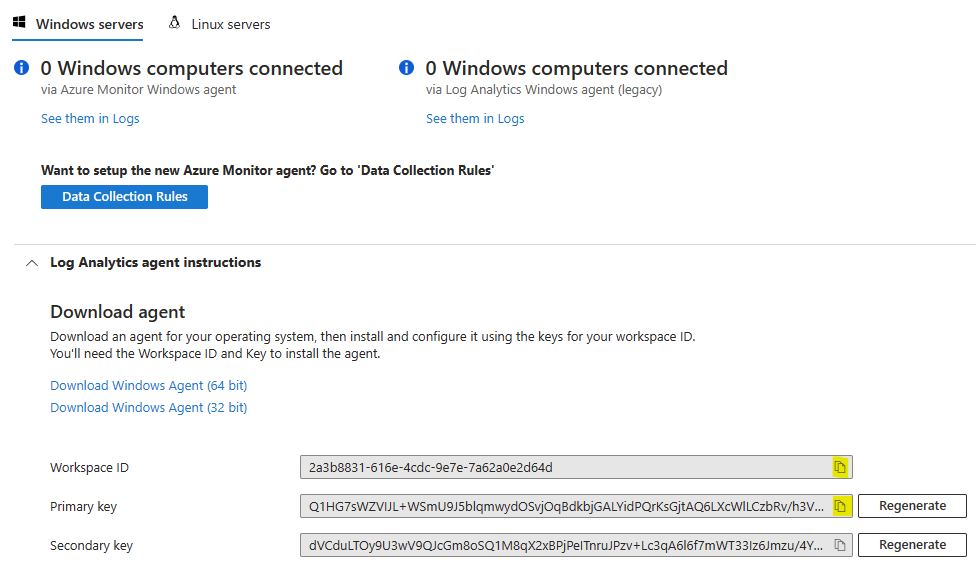

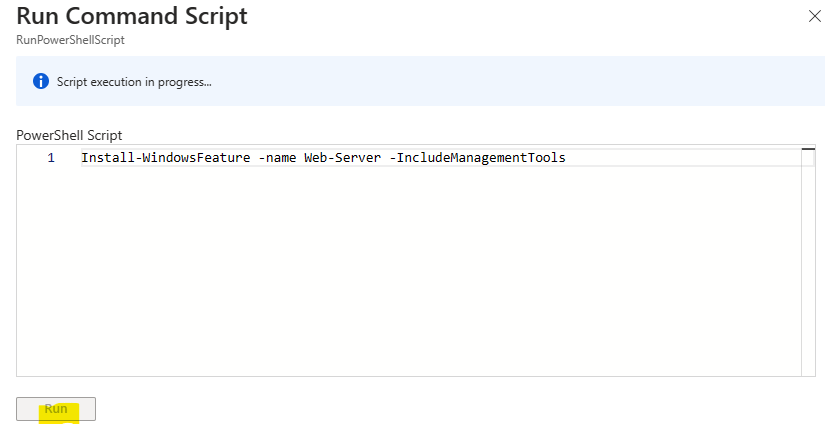

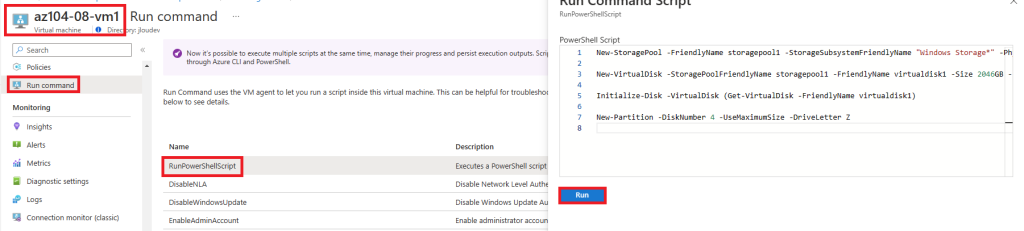

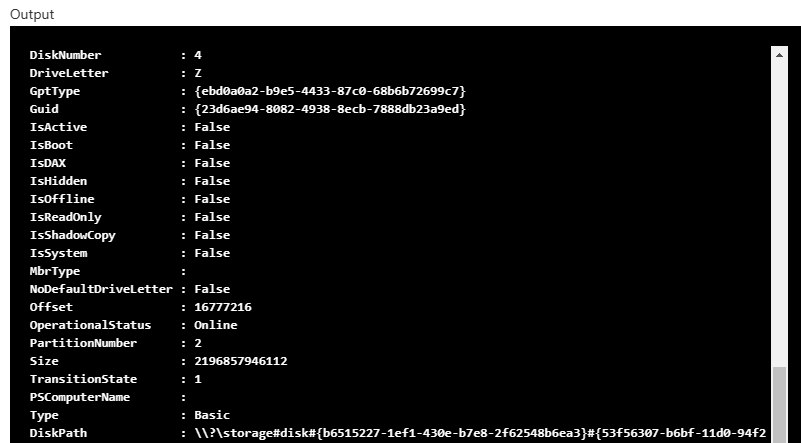

Dans la section des Agents, copiez le lien web pointant vers l’agent Windows en version 64 bits :

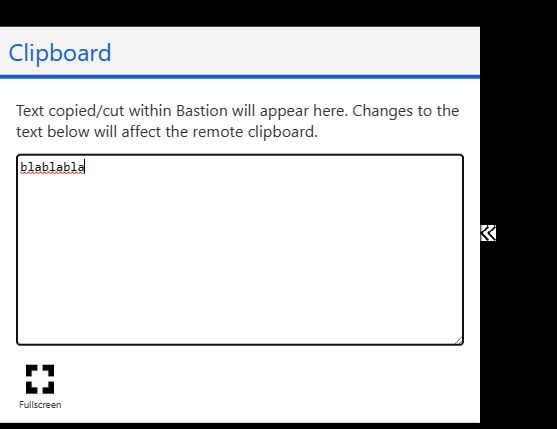

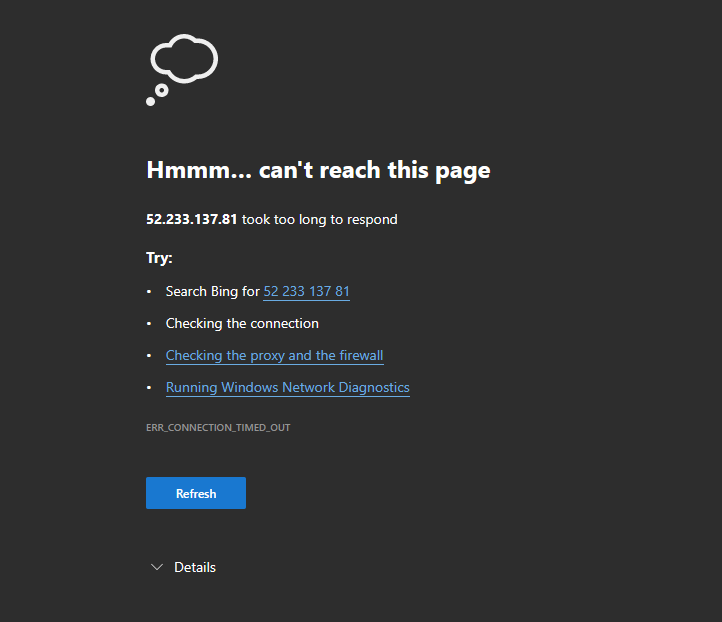

Retournez sur la session de bureau à distance de votre VM, puis collez le lien web dans Edge :

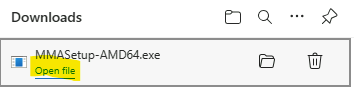

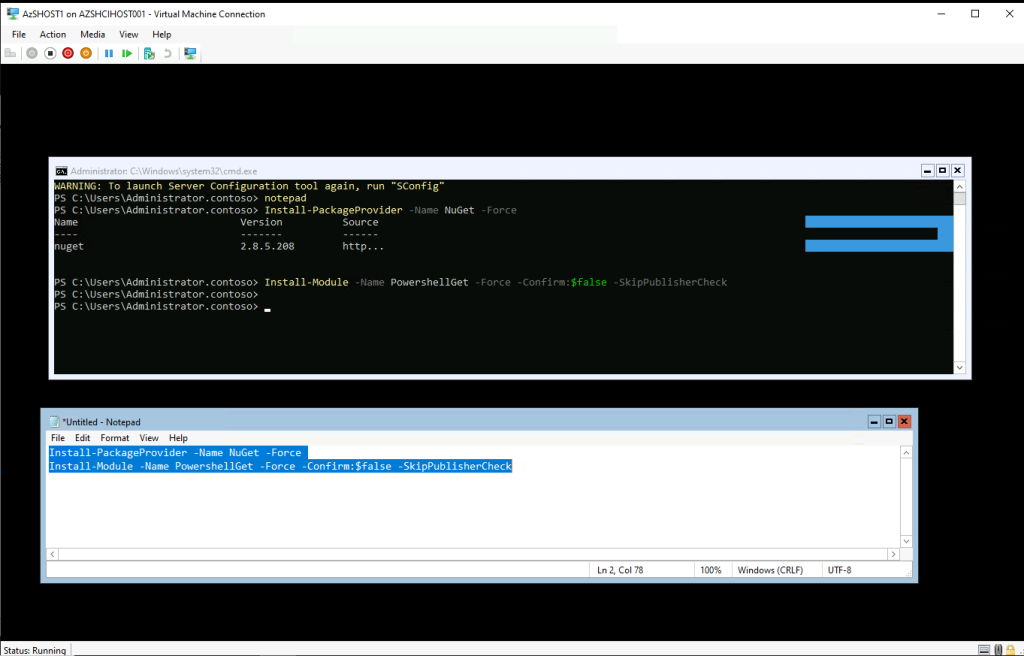

Attendez que l’agent MMA (Microsoft Monitoring Agent) se télécharge, puis cliquez-ici pour lancer son installation :

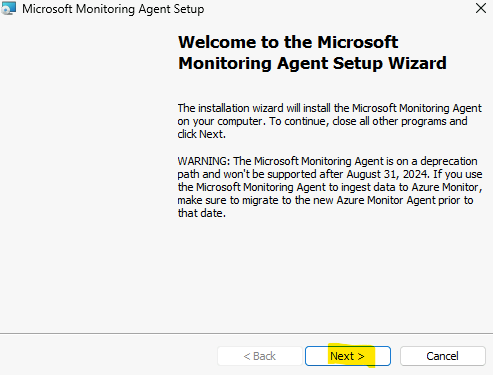

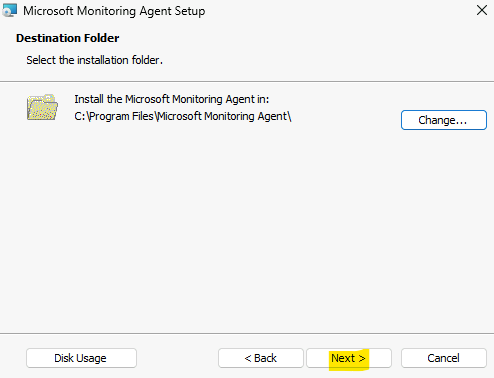

Cliquez sur Suivant :

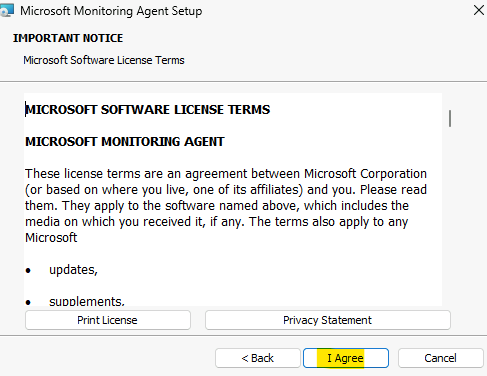

Cliquez sur Accepter :

Cliquez sur Suivant :

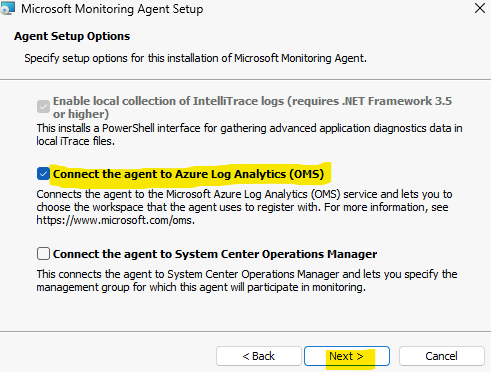

Cochez la première case, puis cliquez sur Suivant :

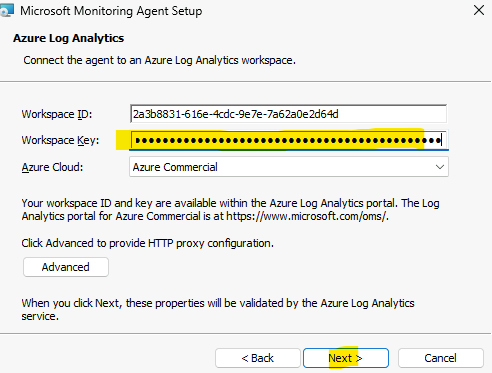

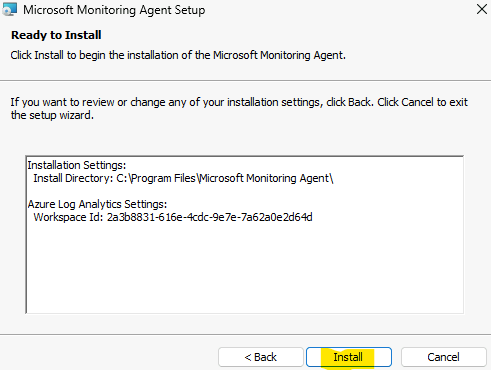

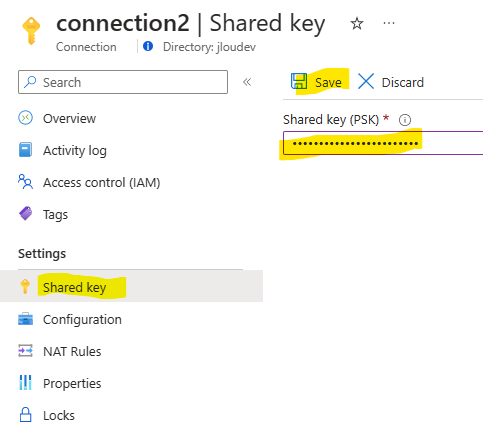

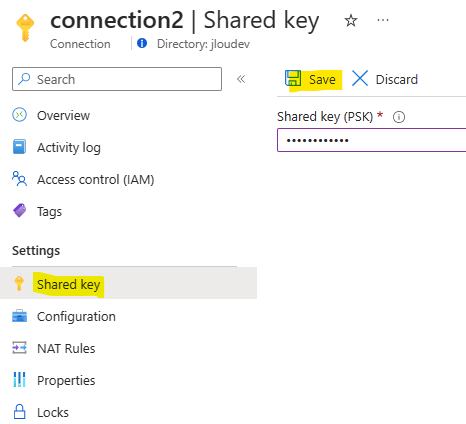

Sur la page de votre LAW (espace de travail Log Analytics), copiez l’ID de votre espace et une des deux clefs :

Collez ces deux informations dans les champs correspondants, puis cliquez sur Suivant :

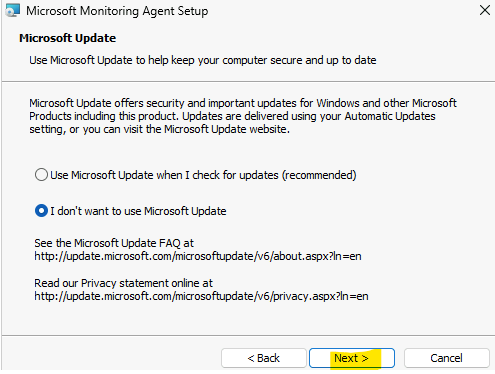

Cliquez sur Suivant :

Cliquez sur Installer :

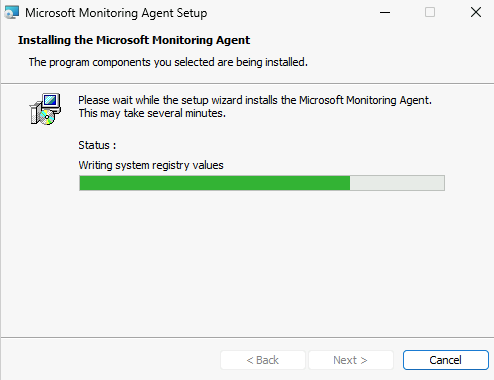

Attendez environ une minute que l’installation se termine :

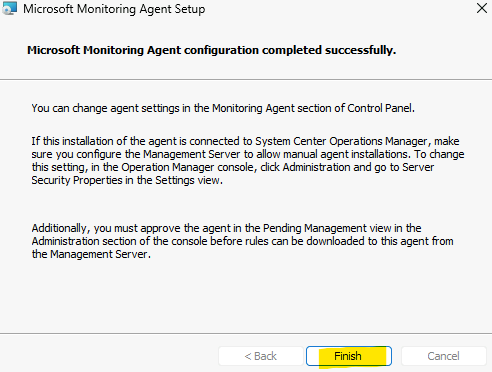

Cliquez sur Terminer pour refermer l’installation :

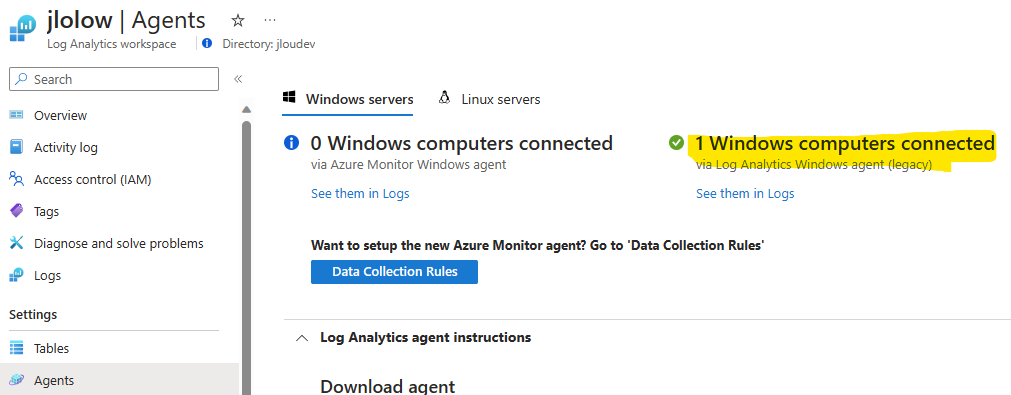

Attendez quelques minutes, puis rafraichissez la page suivante plusieurs fois afin de voir la bonne connection entre notre LAW et notre machine virtuelle de test :

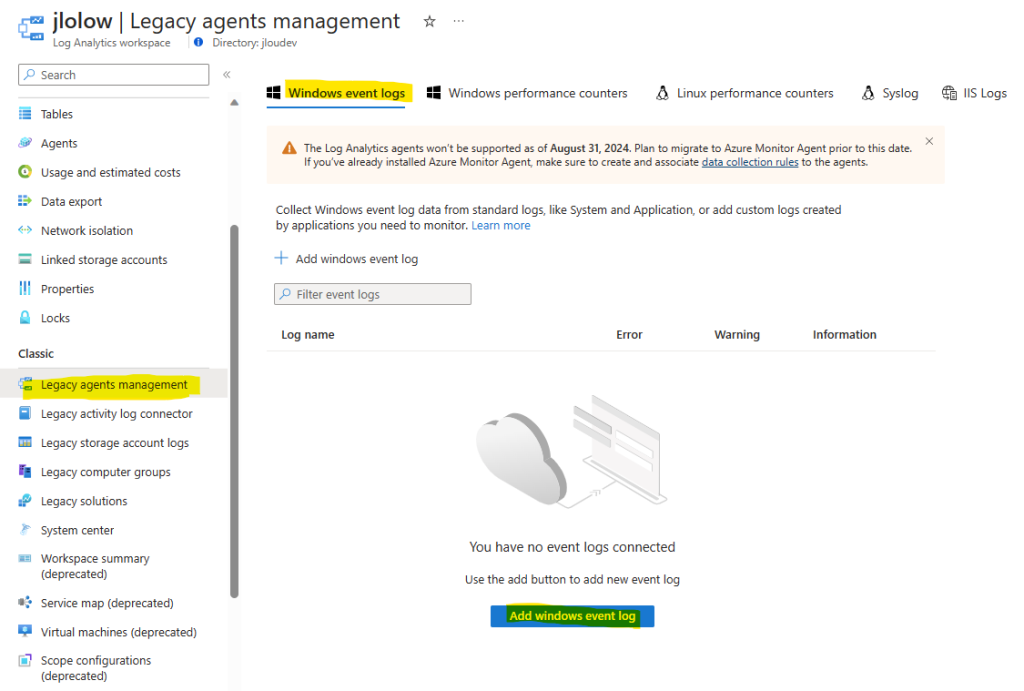

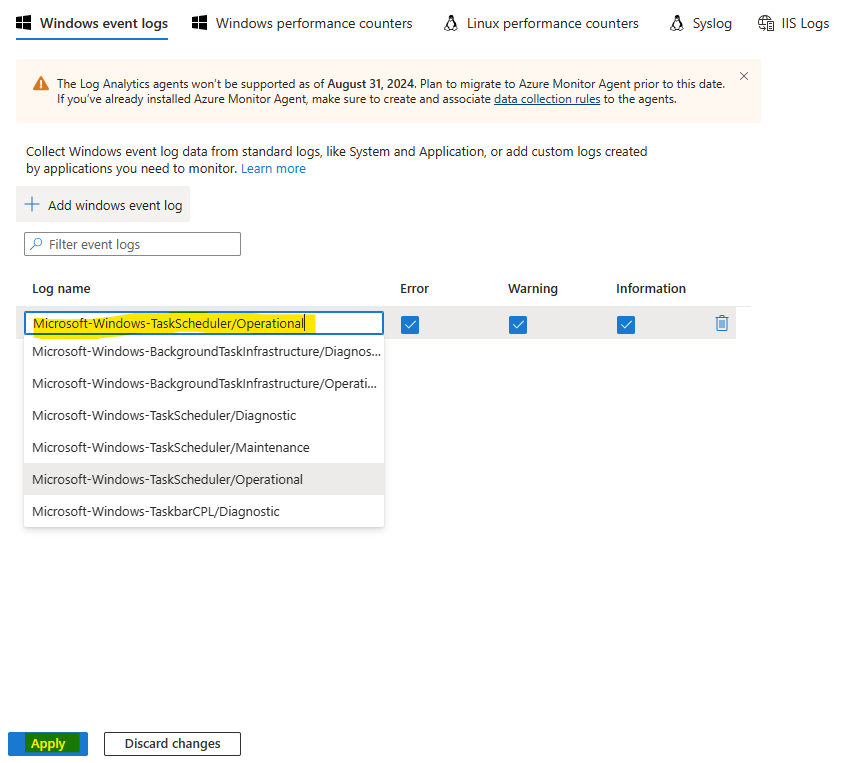

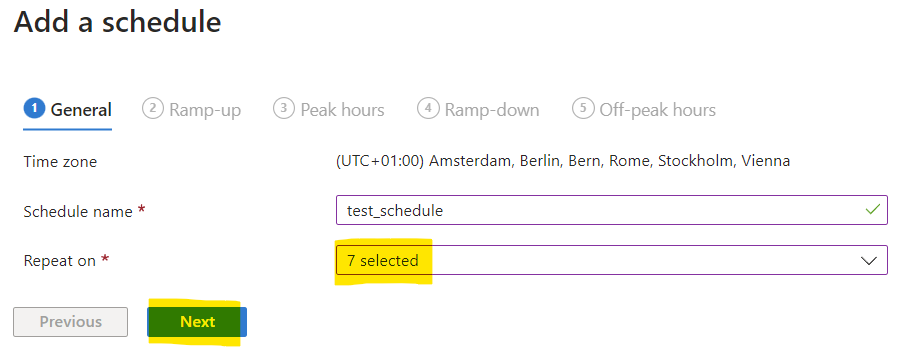

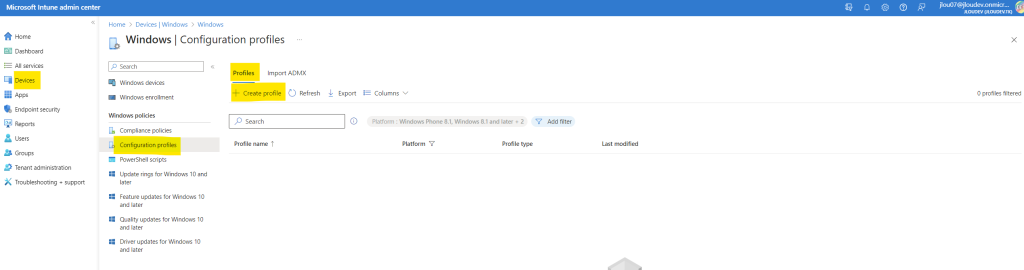

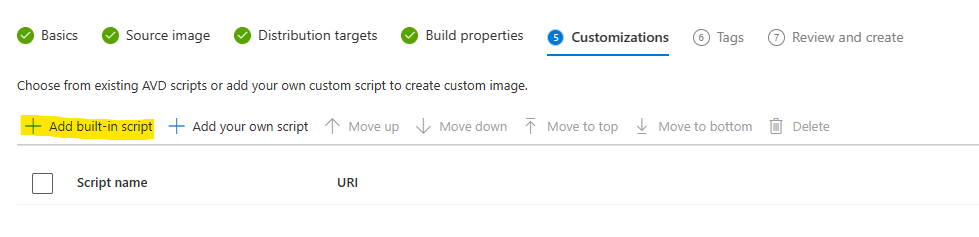

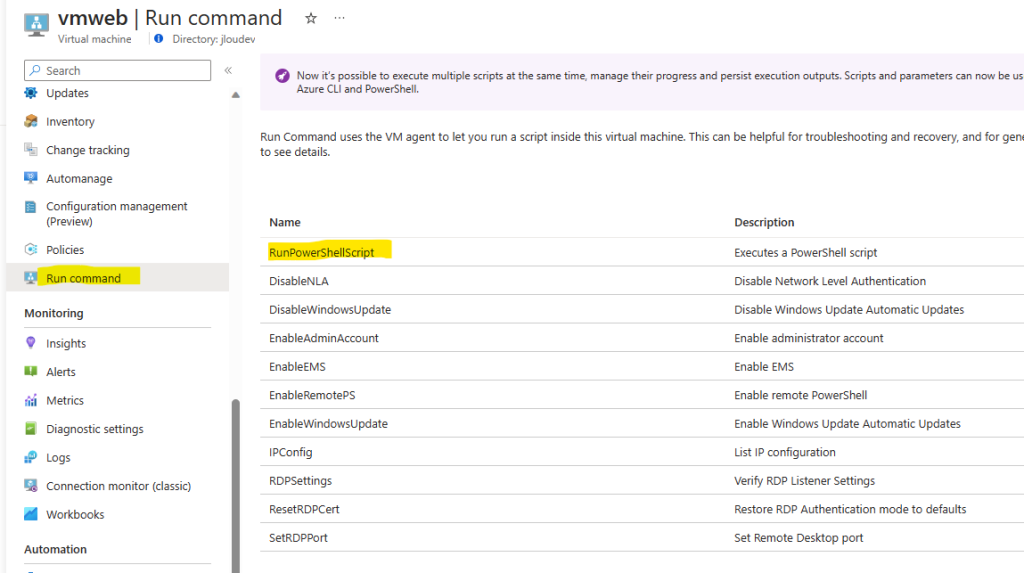

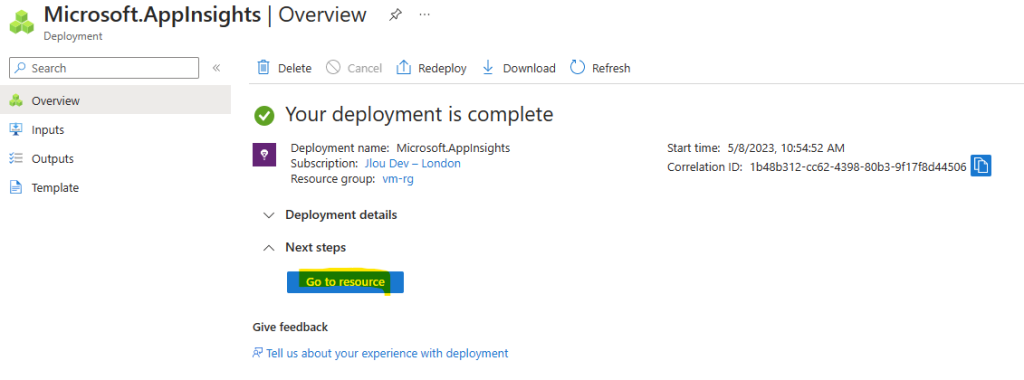

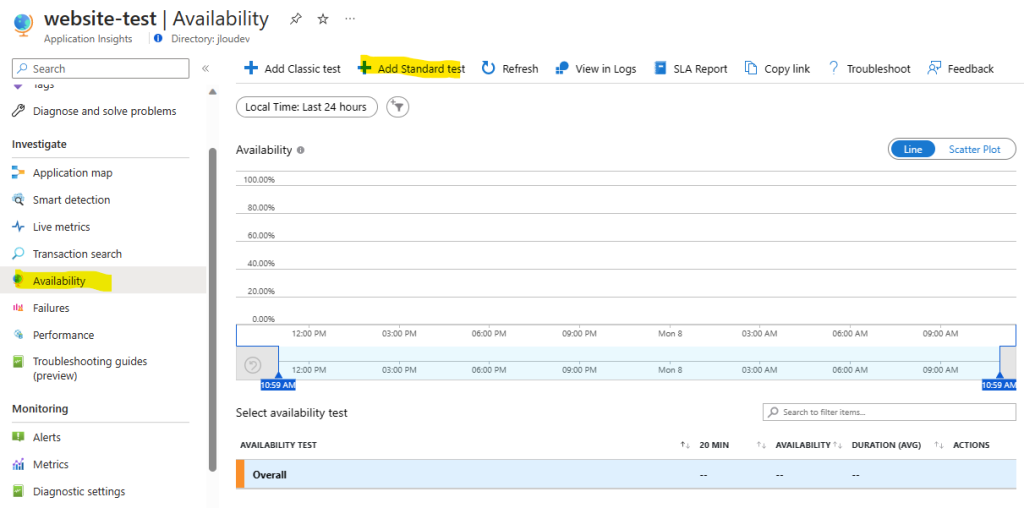

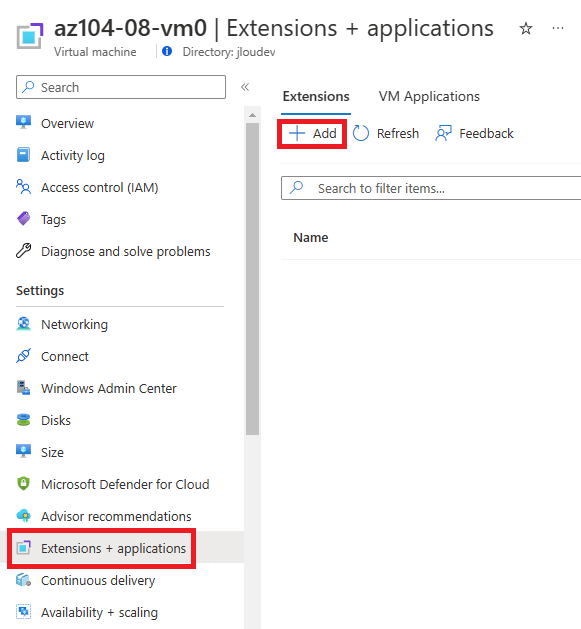

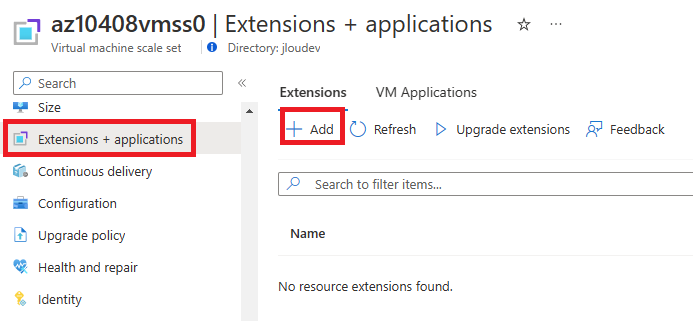

Cliquez sur le bouton suivant afin d’ajouter le journal d’évènement relatif aux tâches planifiées Windows dans les remontées LAW :

Recherchez dans la liste le journal suivant, cochez toutes les cases, puis sauvegardez la configuration :

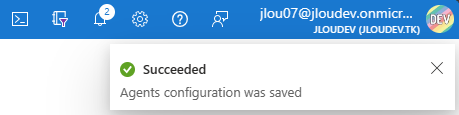

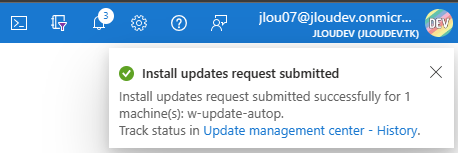

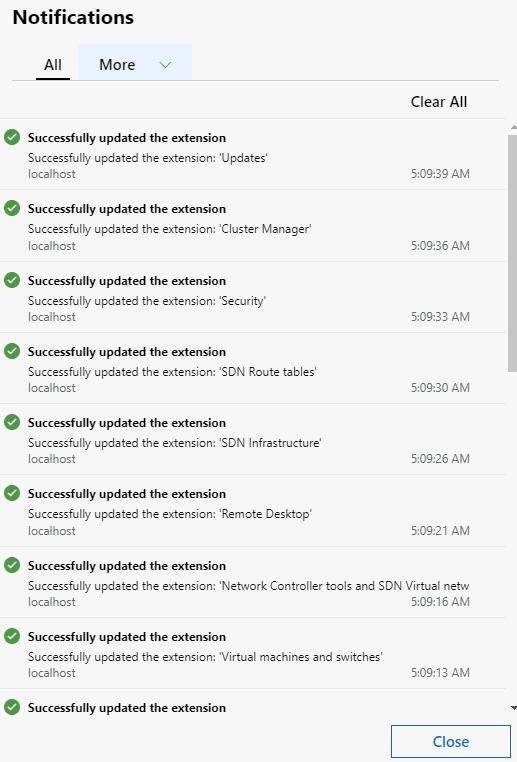

Microsoft-Windows-TaskScheduler/OperationalLa notification Azure suivante vous indique la bonne prise en compte de ce journal :

La connexion entre notre tâche planifiée Windows et Azure est maintenant correctement établie.

Maintenant, il va nous falloir patienter plusieurs minutes afin que les prochaines remontées relatives à notre tâche planifiée de test se fassent correctement.

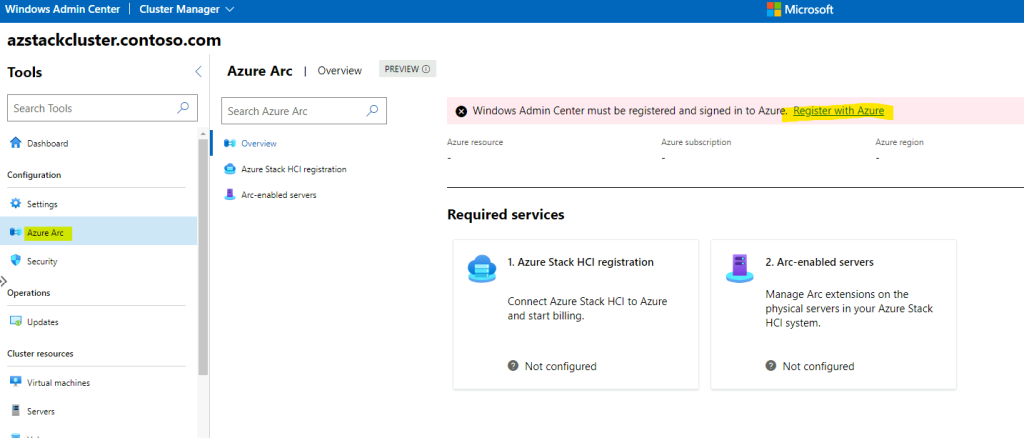

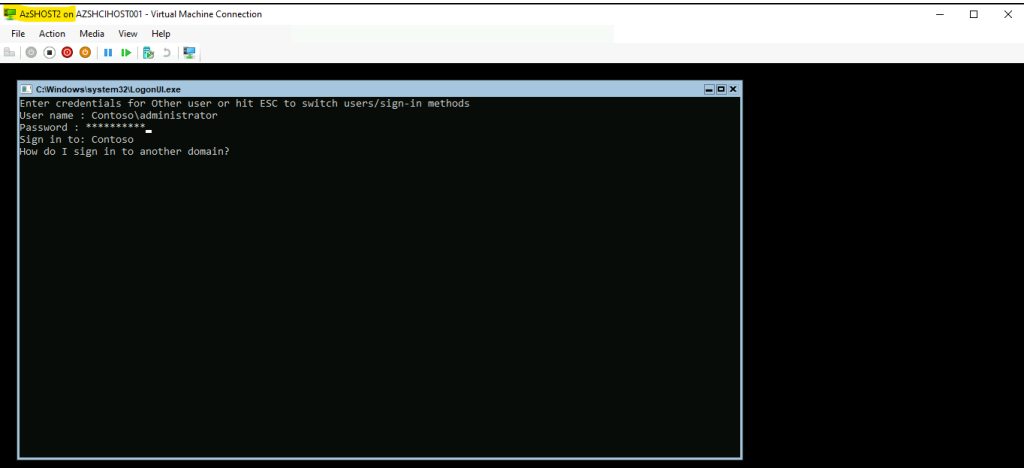

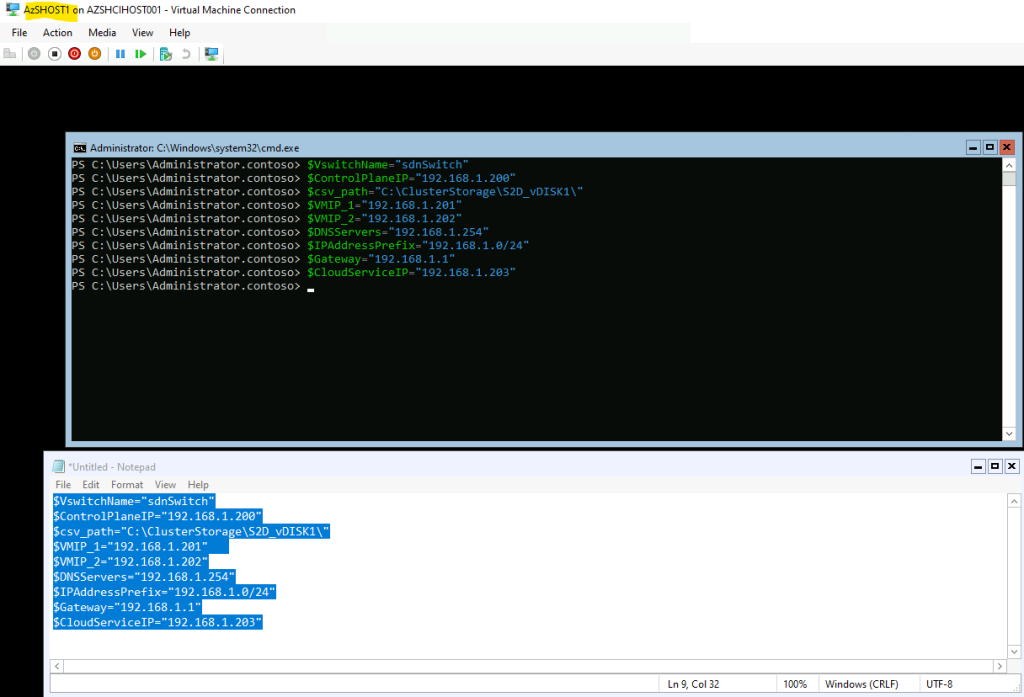

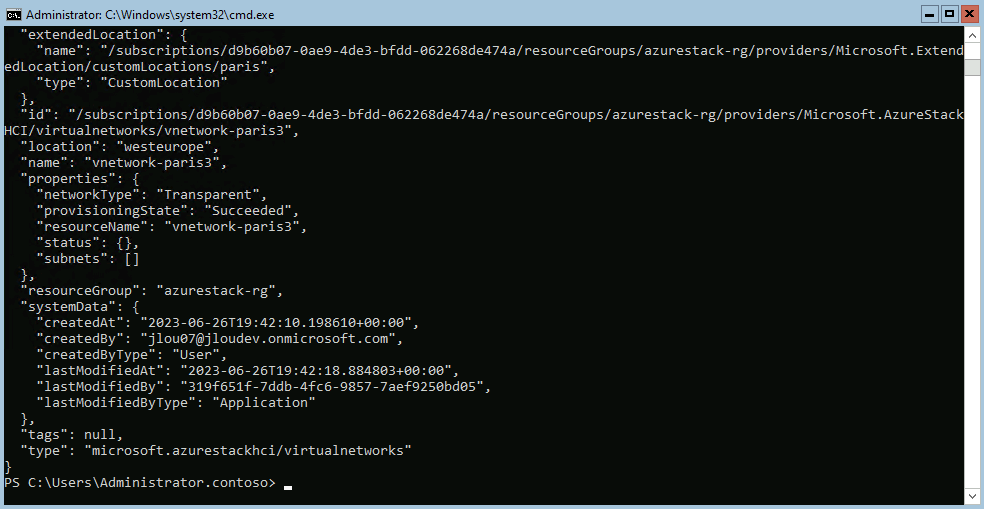

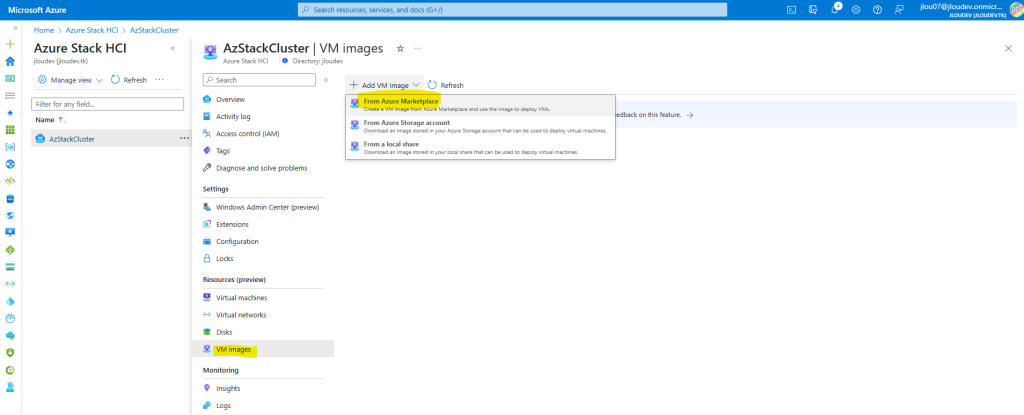

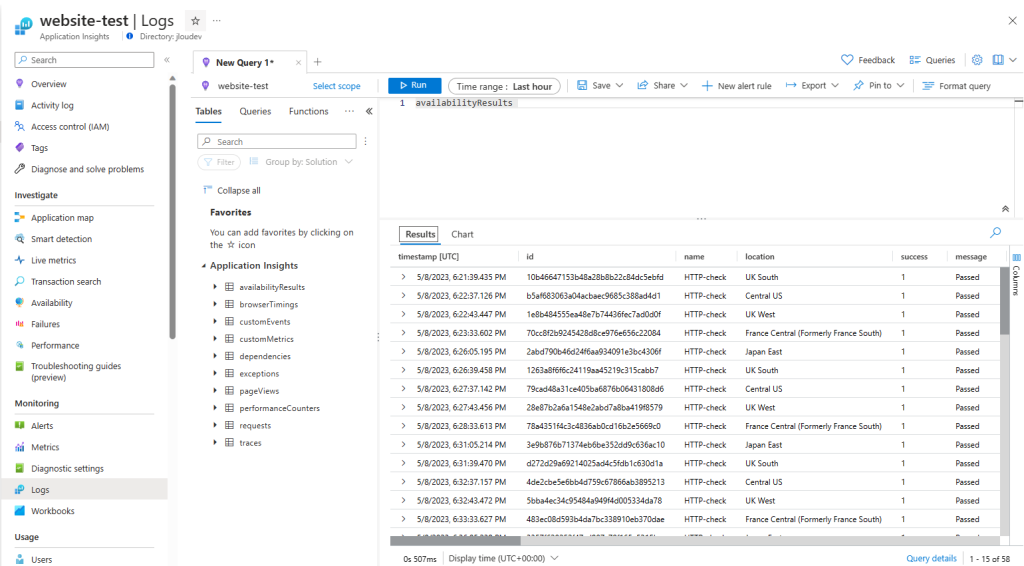

Etape IV – Testez votre remontée grâce à Azure KQL :

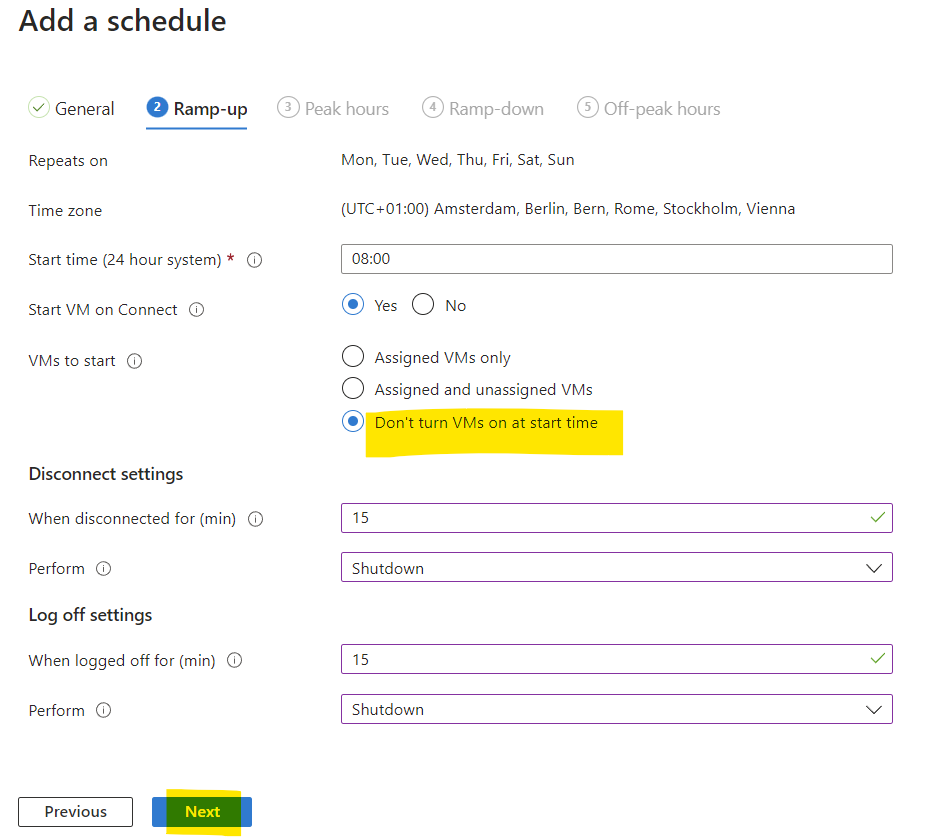

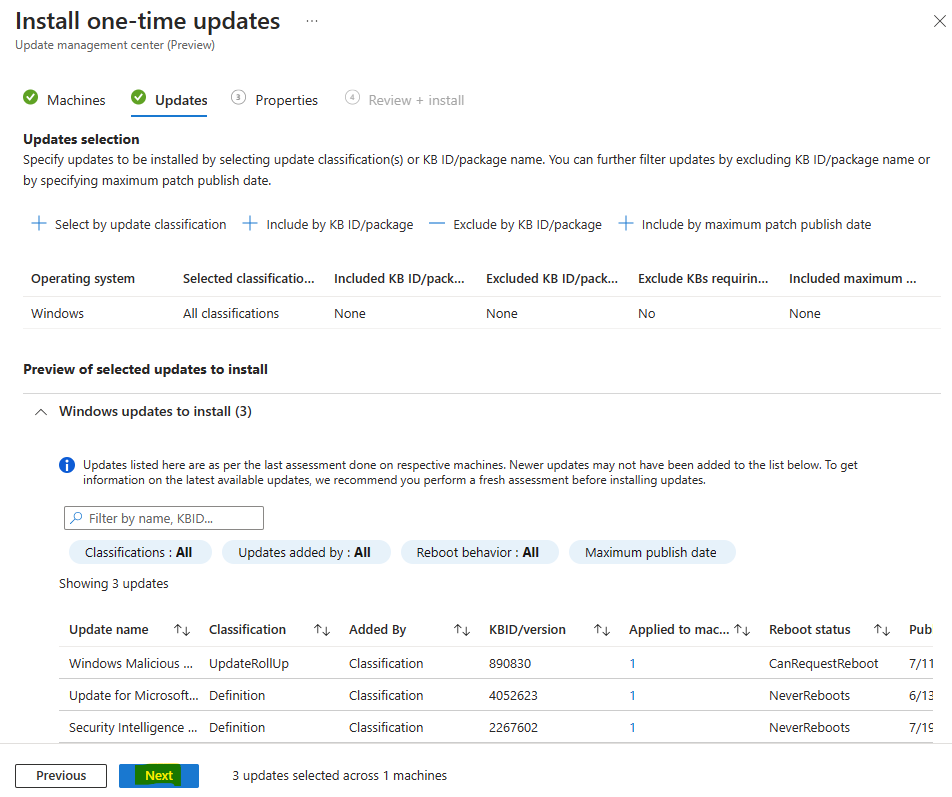

Avant de configurer l’alerte dans Azure Monitor, il est nécessaire de vérifier la présence de données dans LAW. Pour cela, nous allons utiliser le langage KQL dans notre requête sur LAW.

Le langage de requête Kusto (KQL) est un outil permettant d’explorer vos données et d’y découvrir des modèles, d’identifier des anomalies et des valeurs hors norme, de créer une modélisation statistique, etc. La requête utilise des entités de schéma organisées dans une hiérarchie similaire aux SQL : bases de données, tables et colonnes.

Microsoft Learn

Il est possible de faire des requêtes KQL directement depuis votre espace de travail Log Analytics.

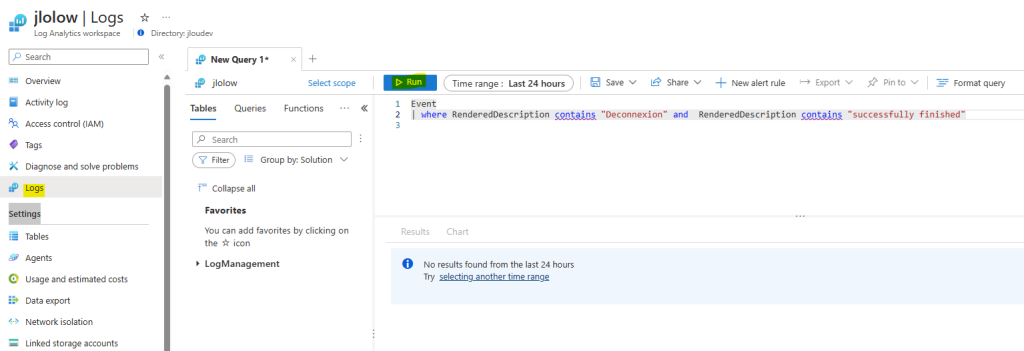

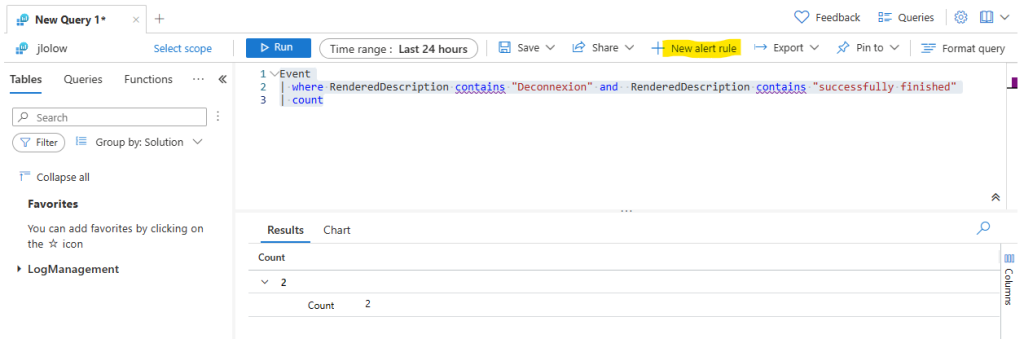

Recherchez la section Logs, saisissez la requête KQL suivante afin de rechercher une trace antérieure de notre tâche planifiée Windows :

Event

| where RenderedDescription contains "Deconnexion" and RenderedDescription contains "successfully finished"Le résultat de notre requête sera bien évidement vide, puisque la configuration de l’agent MMA a été faite après le premier test de notre tâche planifiée :

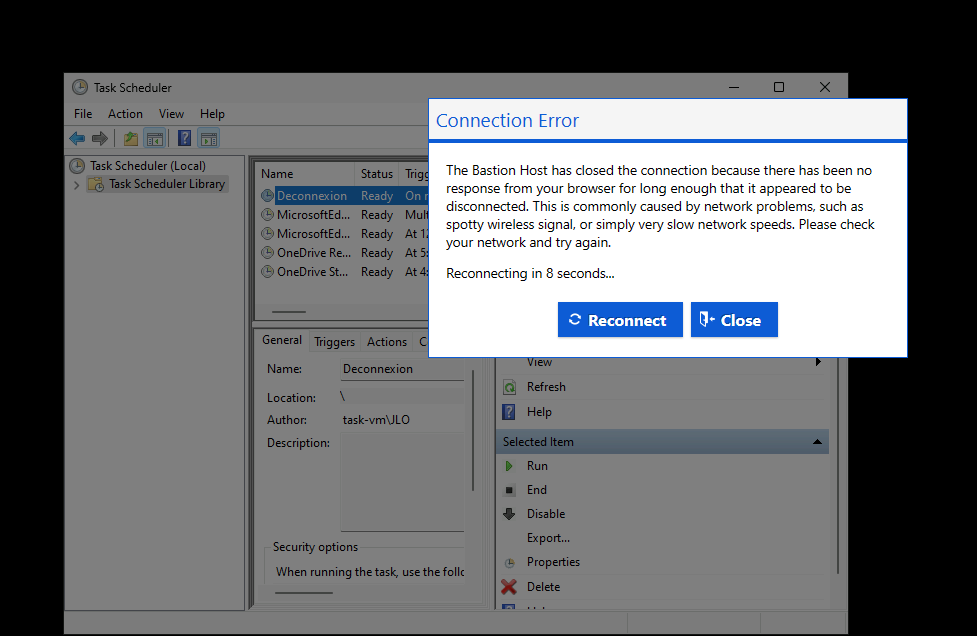

Attendez quelques minutes que la session de bureau à distance via Azure Bastion vous déconnecte pour cause d’inactivité :

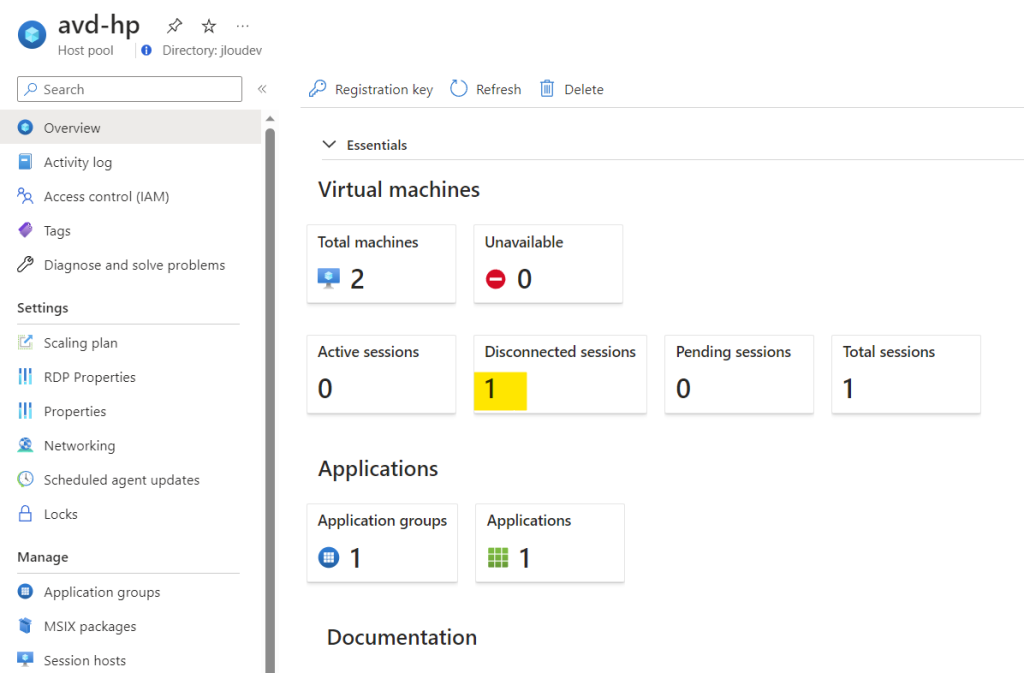

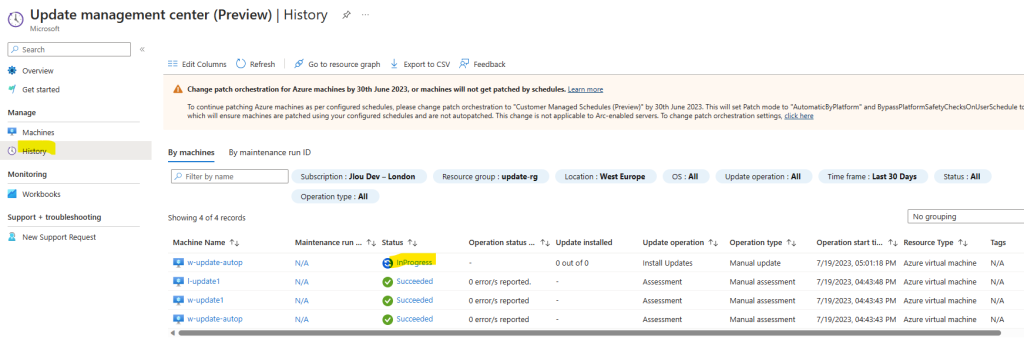

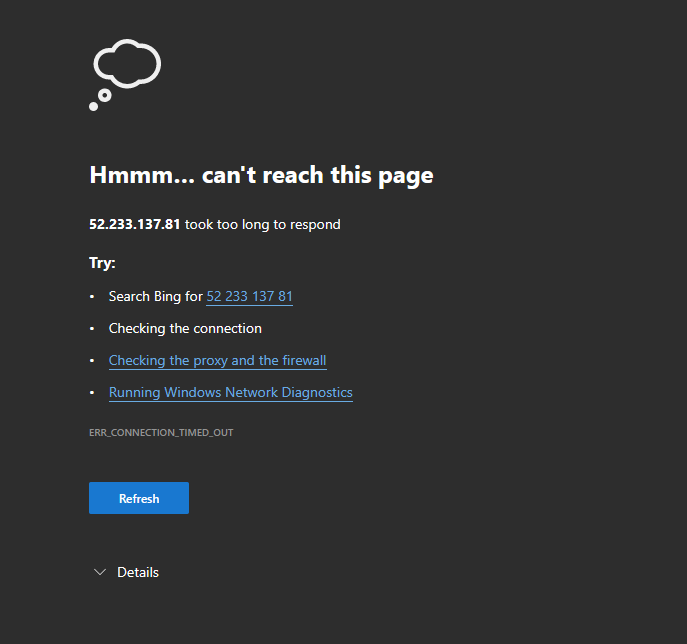

30 minutes après la déconnexion de votre utilisateur, la machine virtuelle devrait s’éteindre au niveau OS.

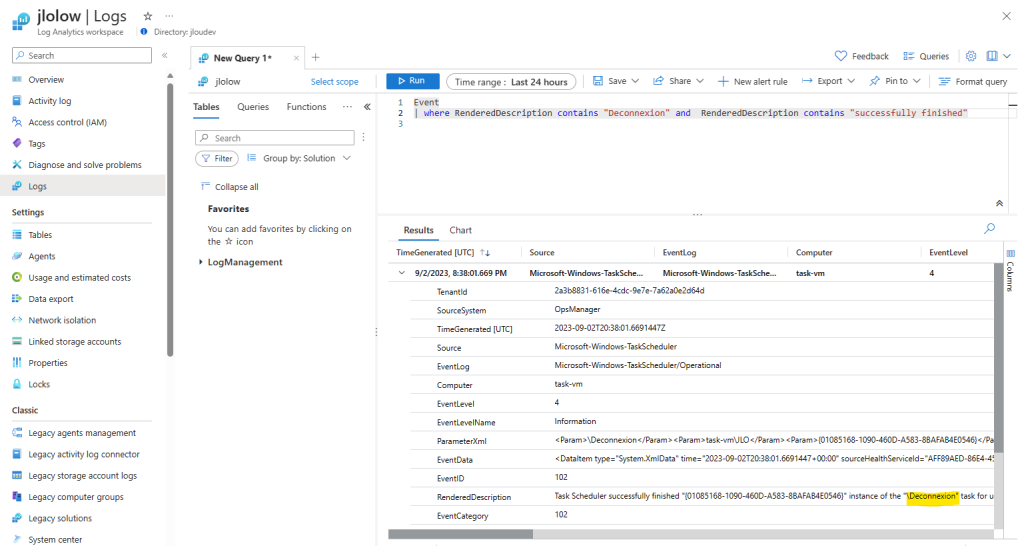

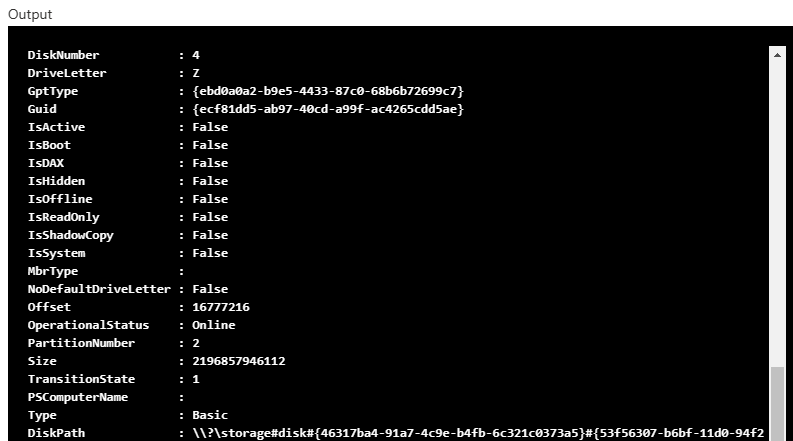

Et quelques minutes plus tard, la requête KQL lancée précédemment devrait donner cette fois ci un résultat :

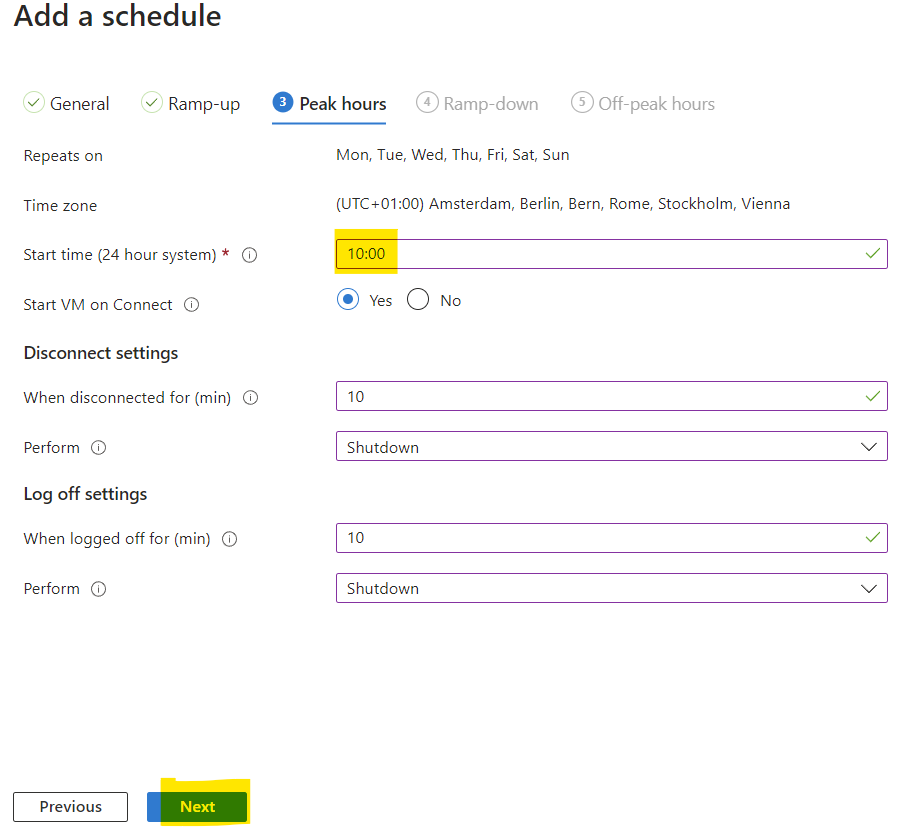

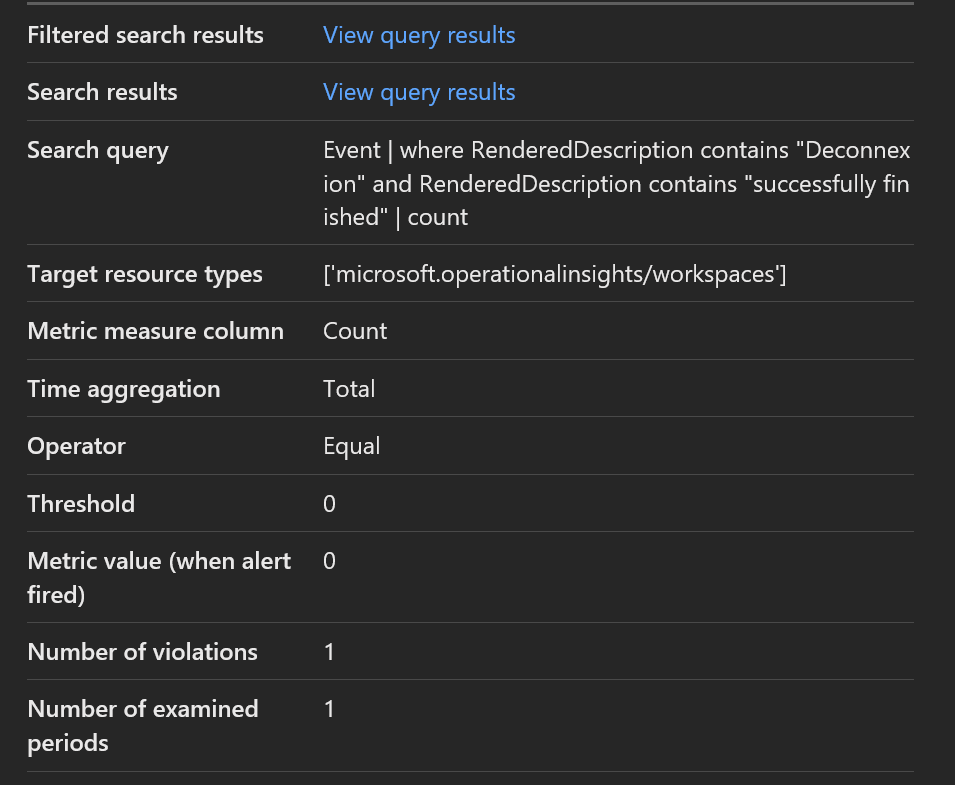

Afin de configurer notre alerte Azure, il est nécessaire de convertir le résultat de cette requête KQL en nombre (compteur).

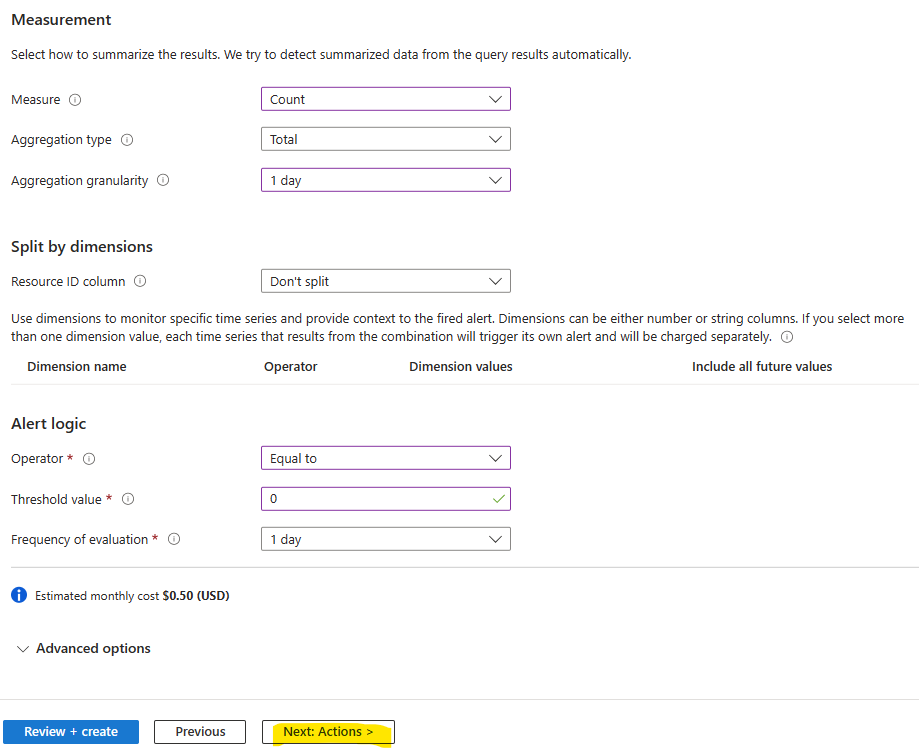

En effet, dans notre exemple, notre alerte Azure doit nous informer si la machine virtuelle ne s’est pas éteinte de la journée (0).

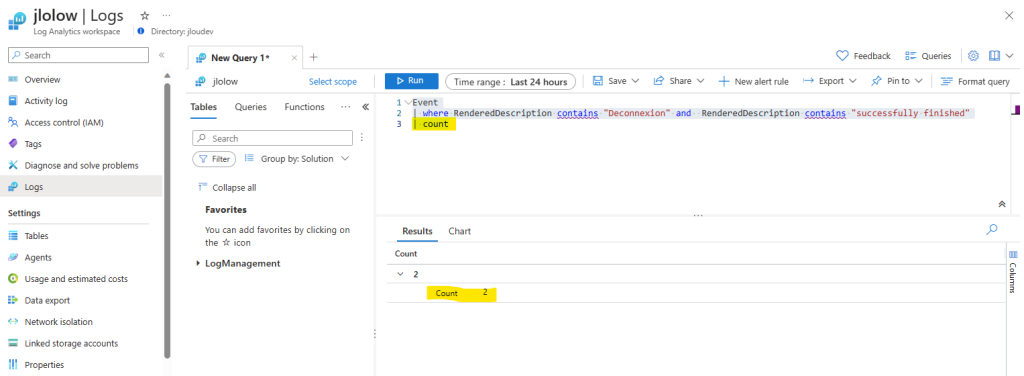

Modifiez la requête KQL précédente comme ceci :

Event

| where RenderedDescription contains "Deconnexion" and RenderedDescription contains "successfully finished"

| countDans mon environnement, la tâche planifiée Deconnexion a bien été exécutée déjà 2 fois :

Tout est maintenant prêt pour configurer notre alerte Azure.

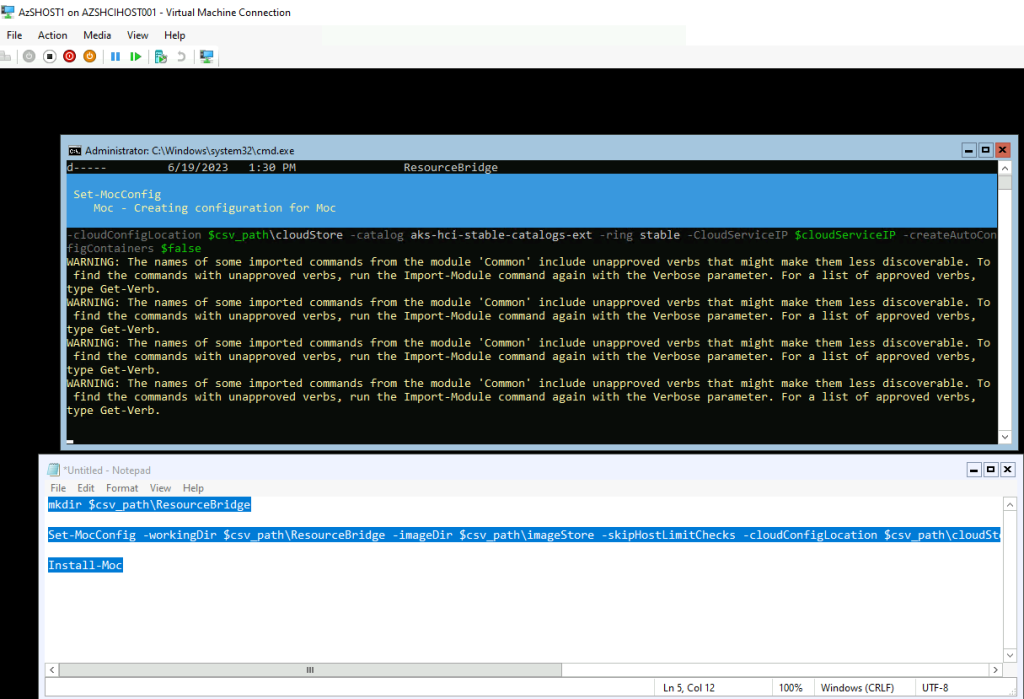

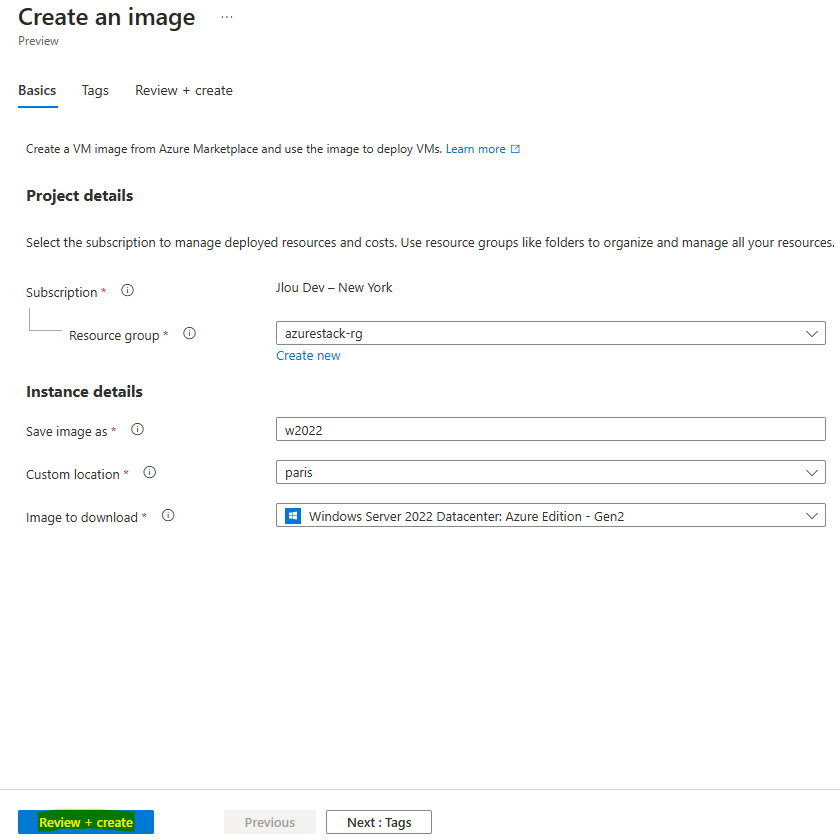

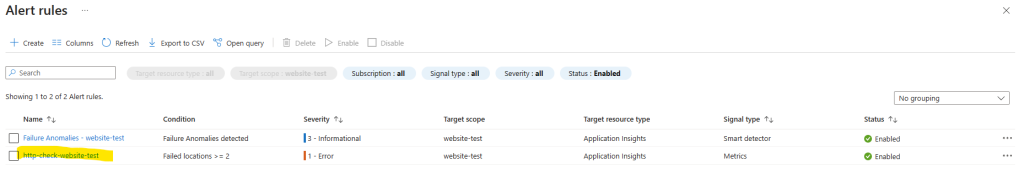

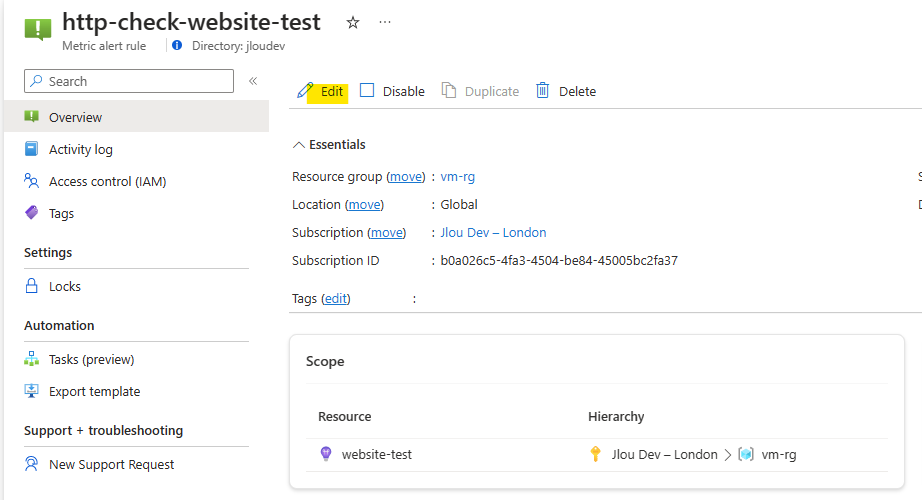

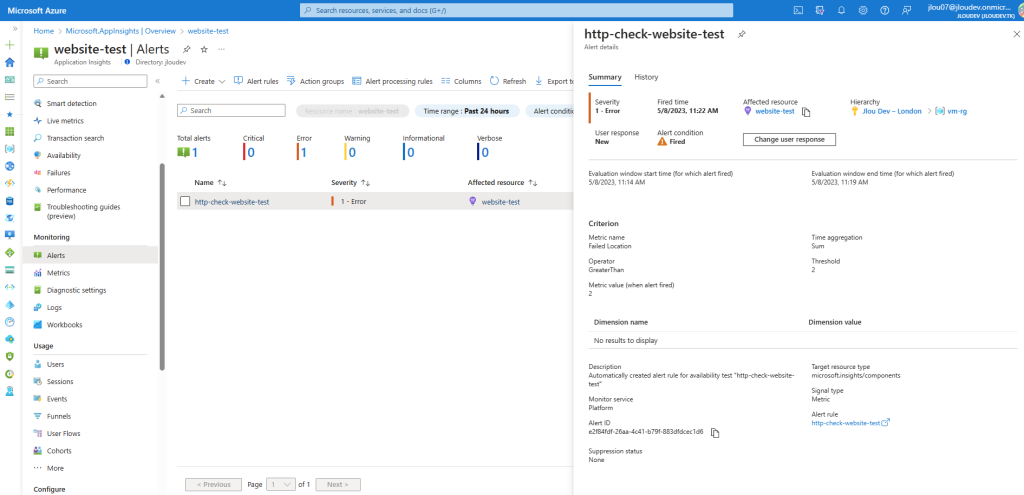

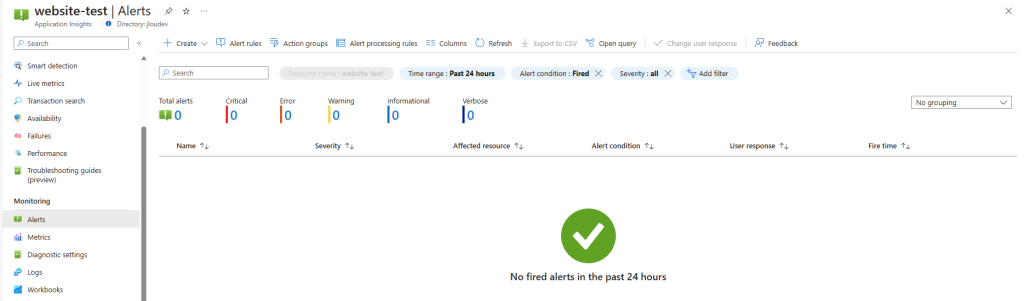

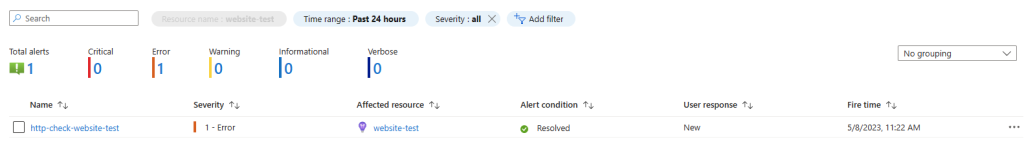

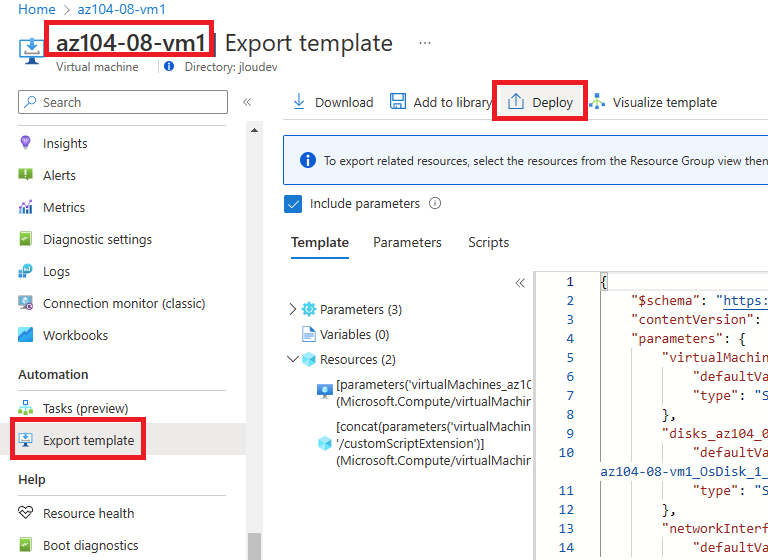

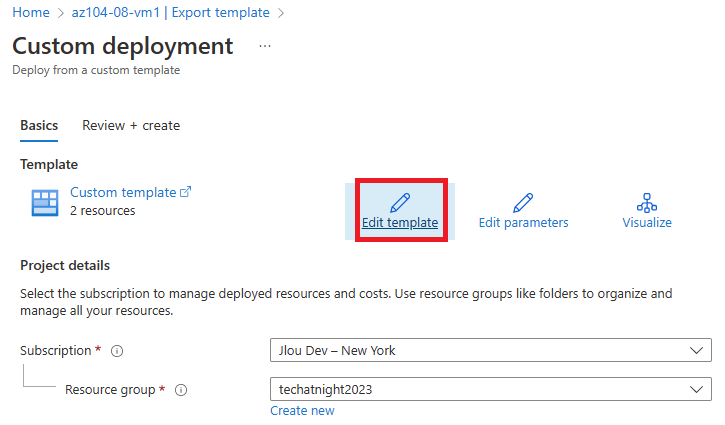

Etape V – Créez votre alerte sur Azure Monitor :

Les alertes vous permettre de détecter et de résoudre des problèmes avant que les utilisateurs ne les remarquent en vous informant de manière proactive quand les données Azure Monitor indiquent qu’il peut y avoir un problème avec votre infrastructure ou votre application.

Vous pouvez définir une alerte sur n’importe quelle source de données de métrique ou de journal dans la plateforme de données Azure Monitor.

Microsoft Learn

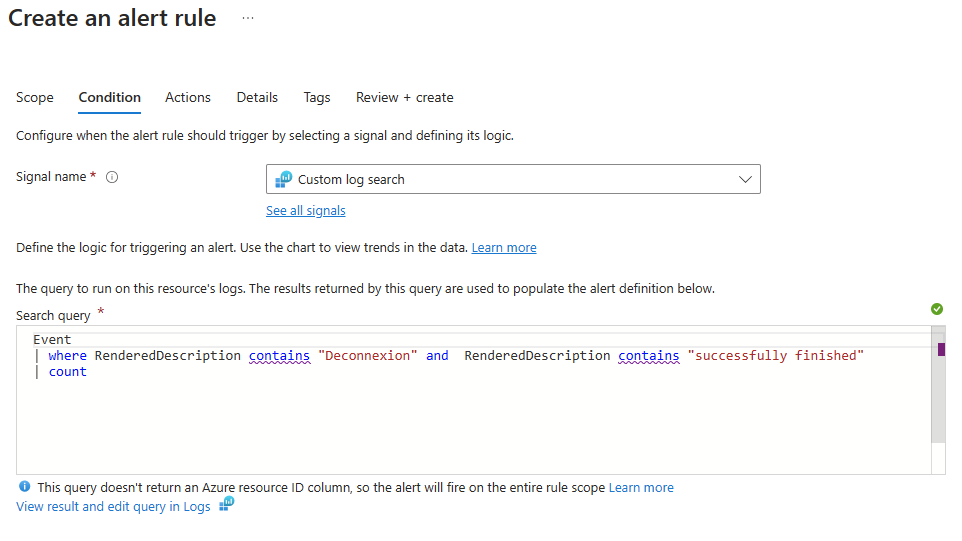

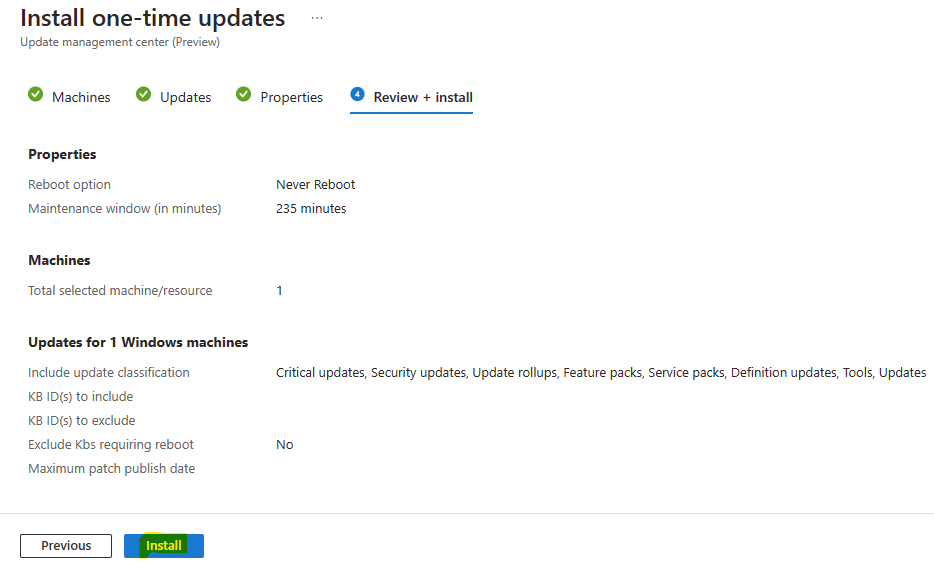

Depuis votre fenêtre de requête KQL, cliquez-ici pour créer votre Alerte Azure :

La nouvelle fenêtre reprend la requête KQL précédemment affichée :

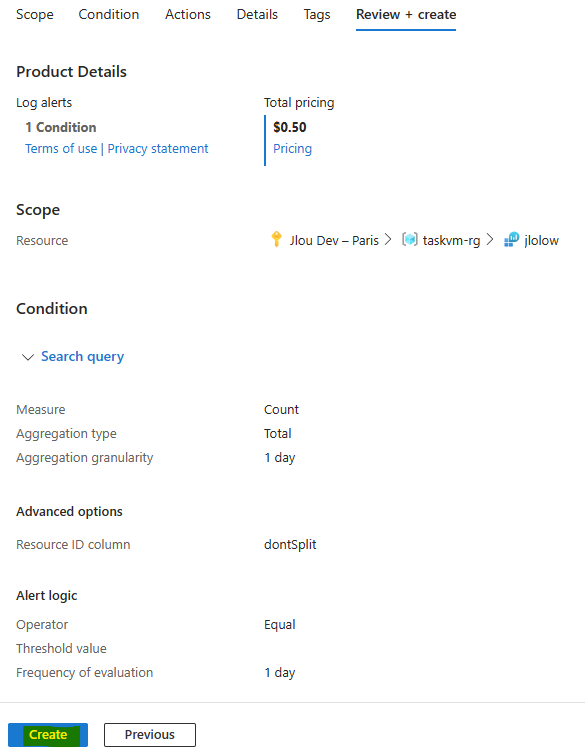

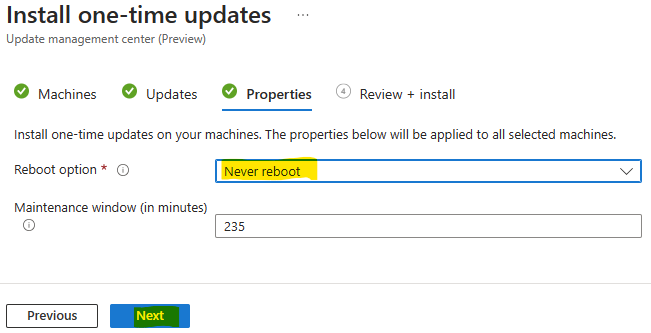

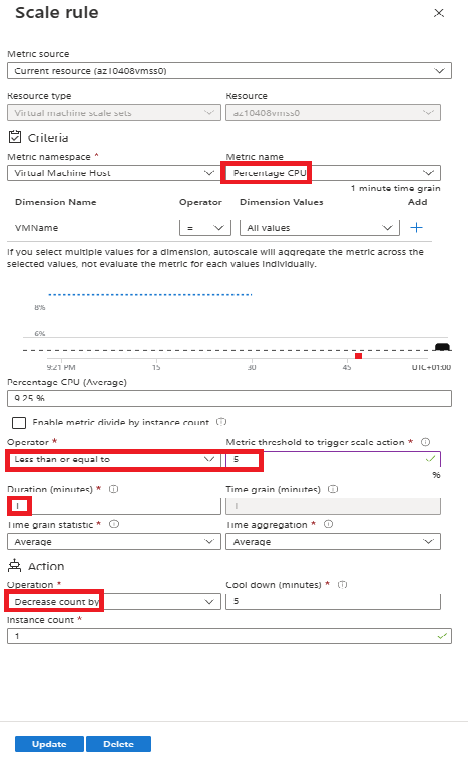

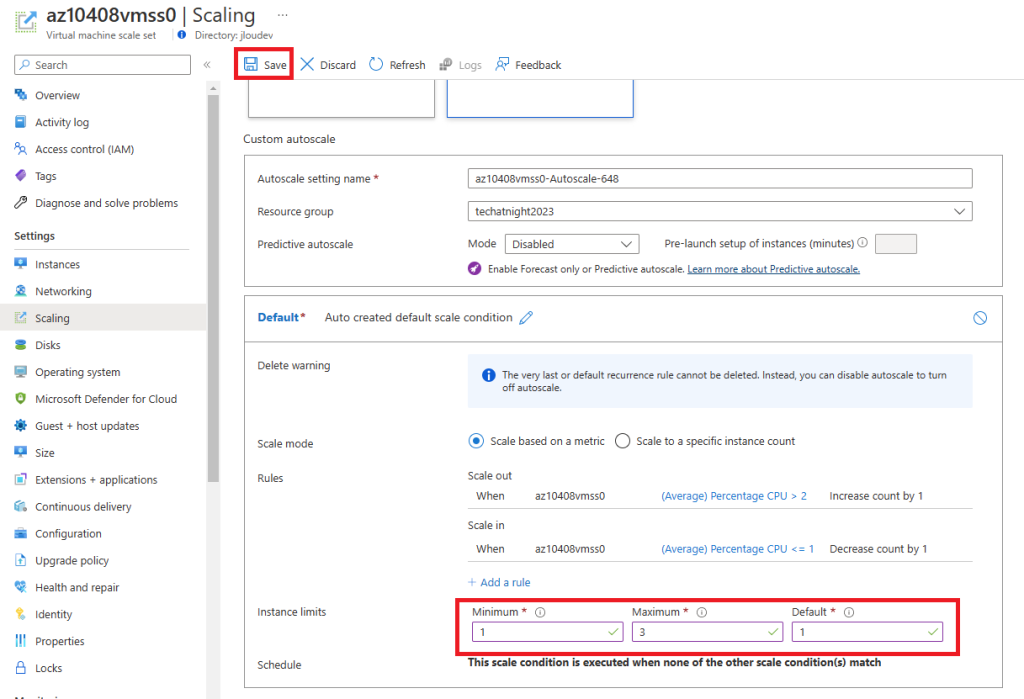

Définissez la méthode d’analyse de cette nouvelle alerte et aussi son seuil de déclenchement, puis cliquez sur Suivant :

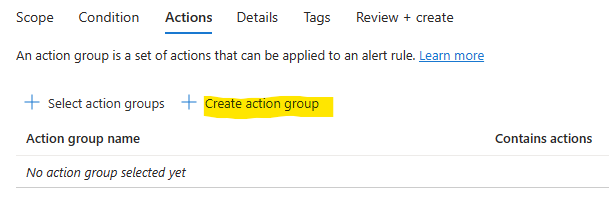

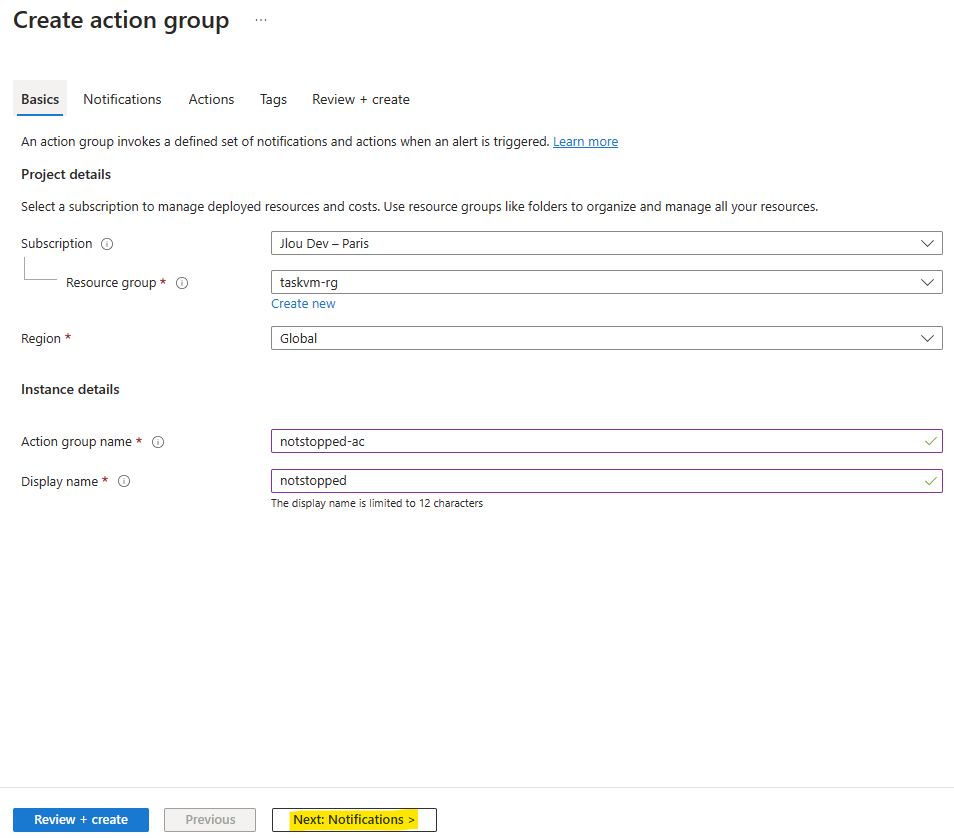

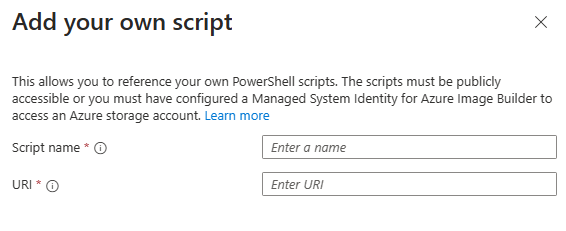

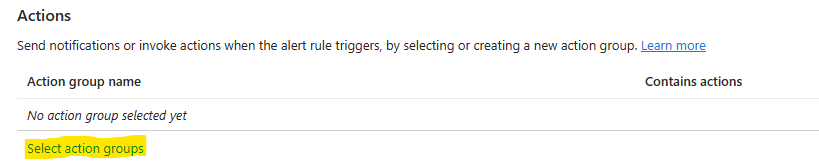

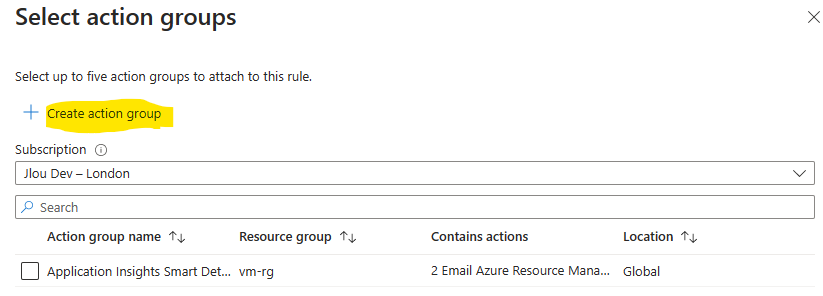

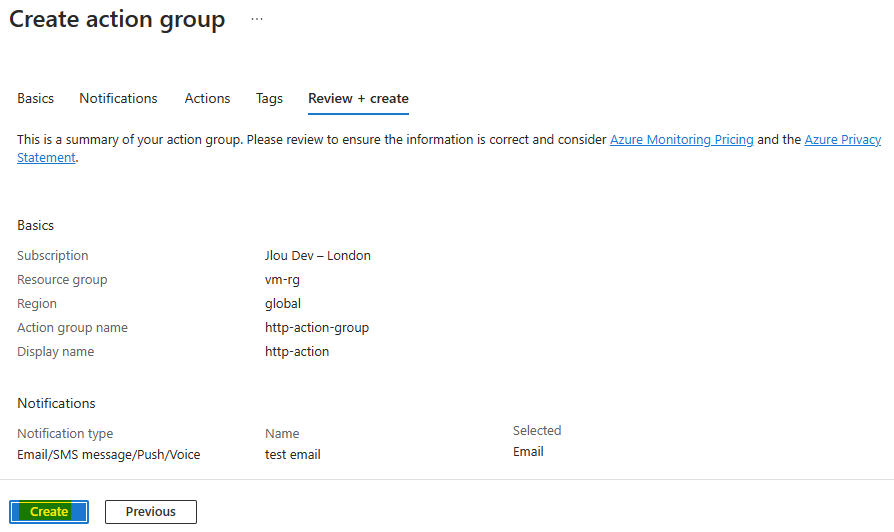

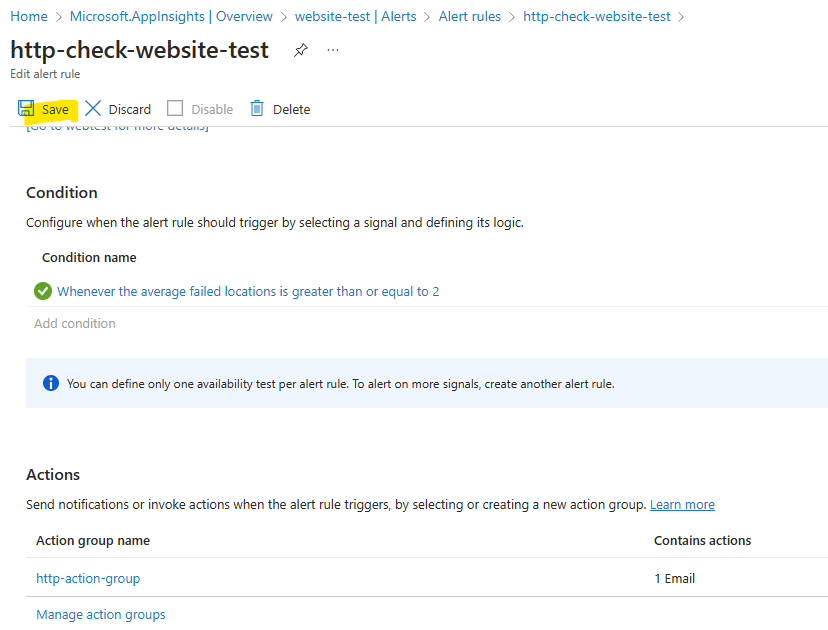

Sous la section des Actions, cliquez-ci dessous pour créer un groupe d’actions :

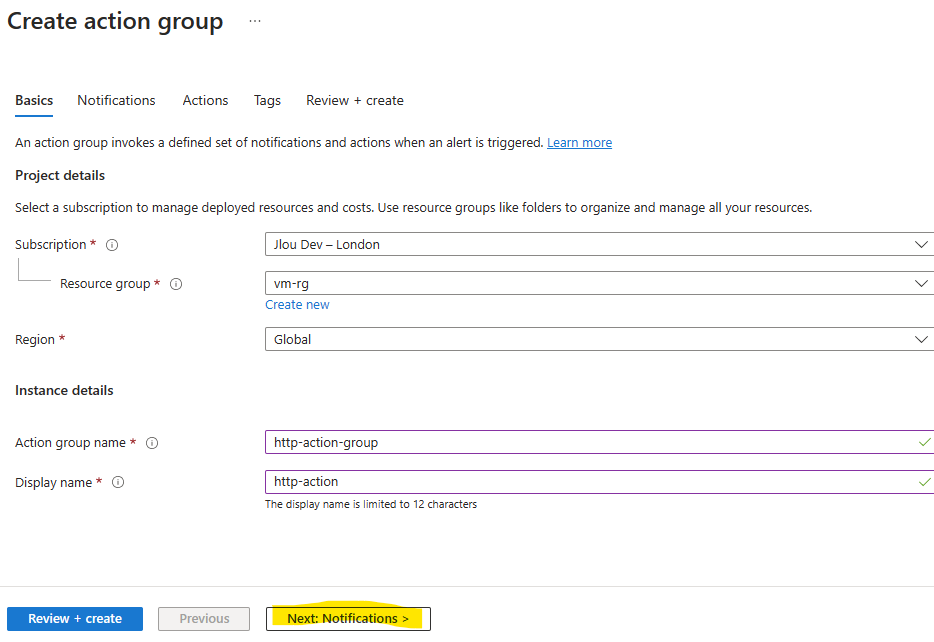

Nommez-le, puis passer sur l’onglet suivant :

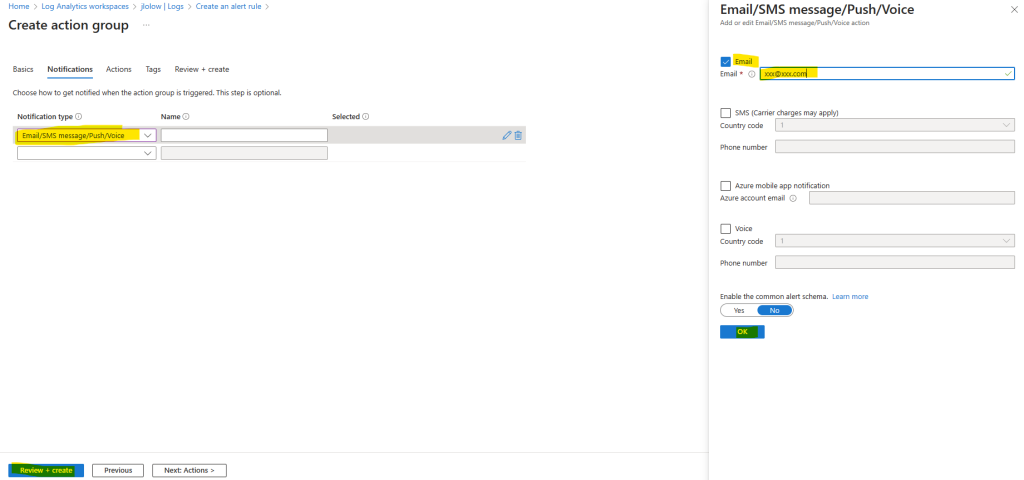

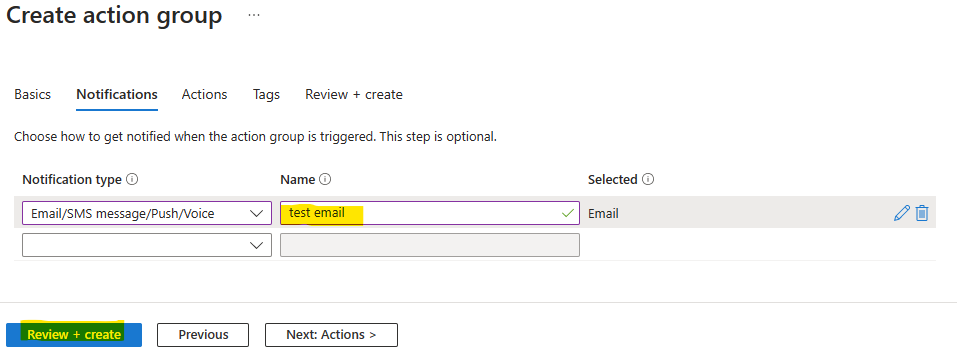

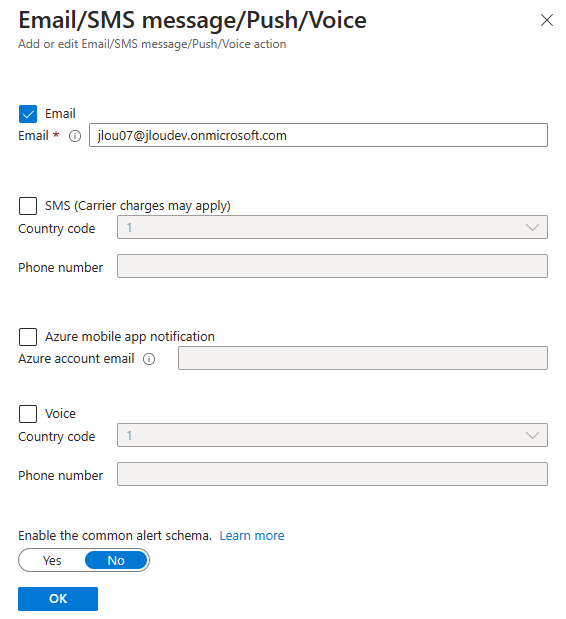

Dans l’onglet Notifications, définissez un type de notification Email, nommez-le également, puis renseignez une adresse email à cibler :

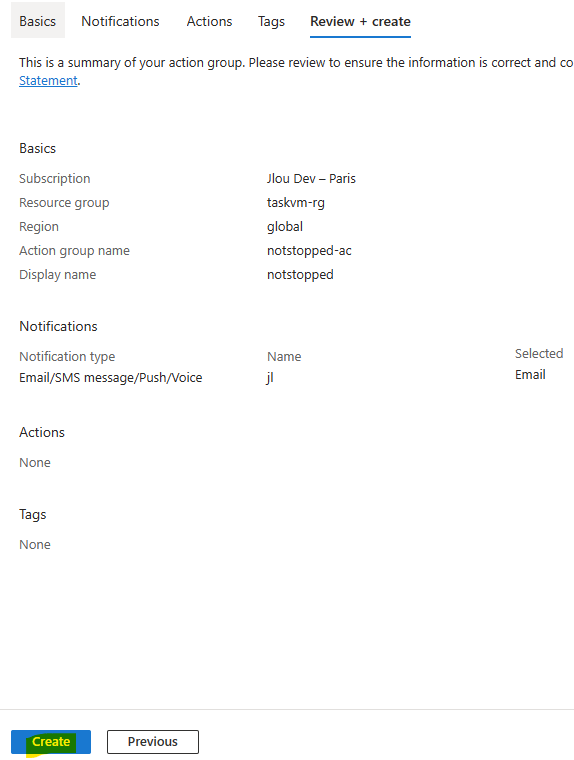

Cliquez sur Créer votre groupe d’actions :

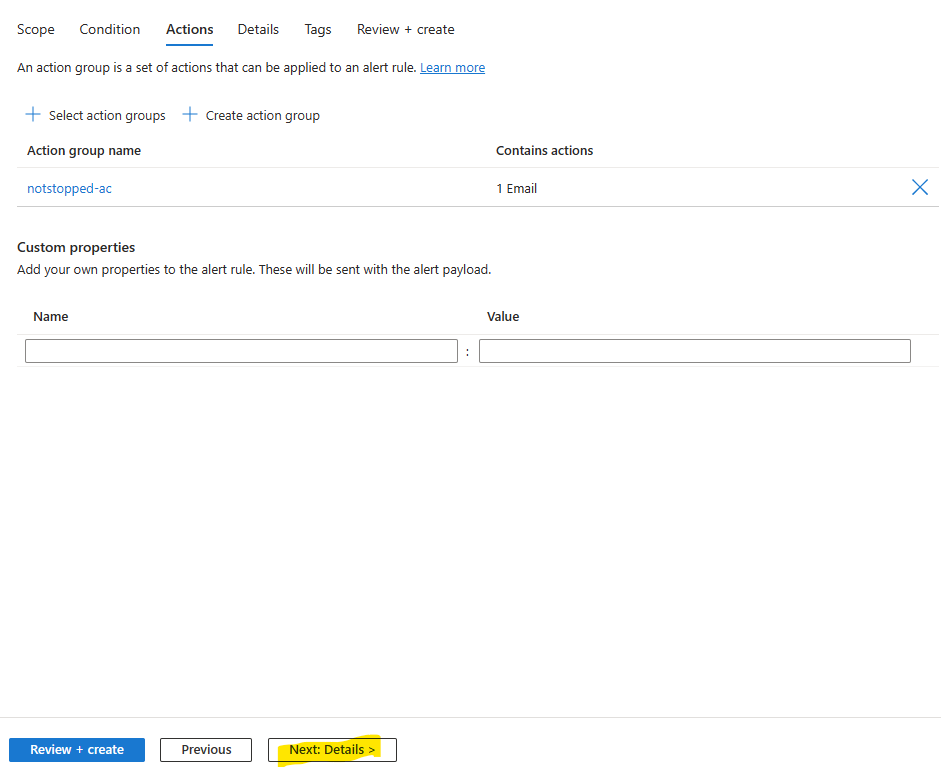

De retour sur votre règle d’alerte, cliquez sur Suivant :

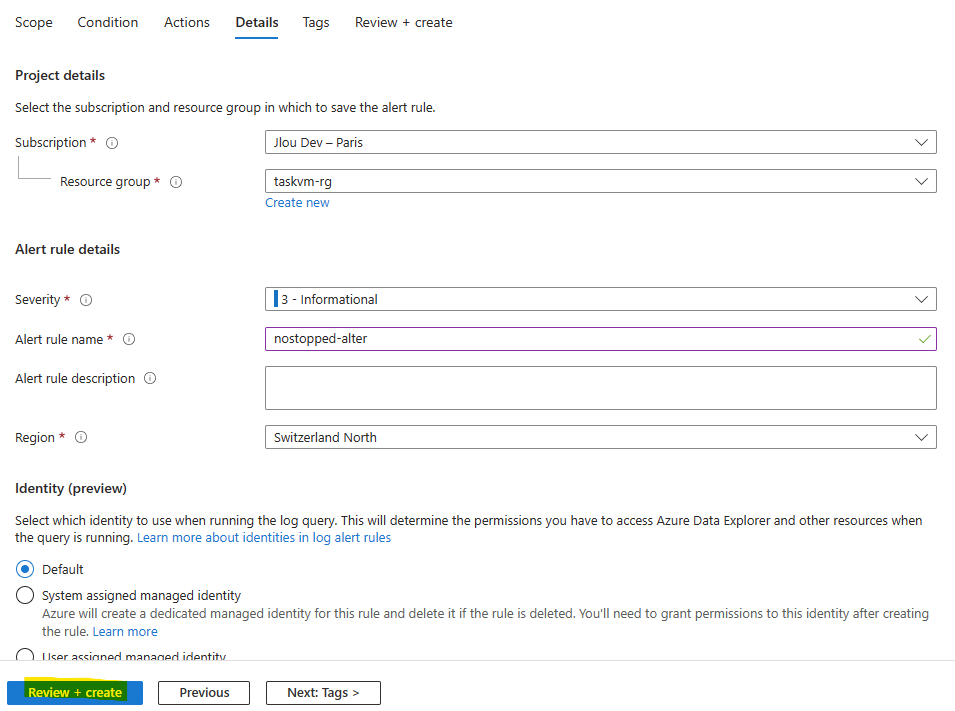

Nommez votre règle d’alerte Azure, puis cliquez sur Suivant :

Une fois la validation Azure réussie, lancez la création de l’alerte :

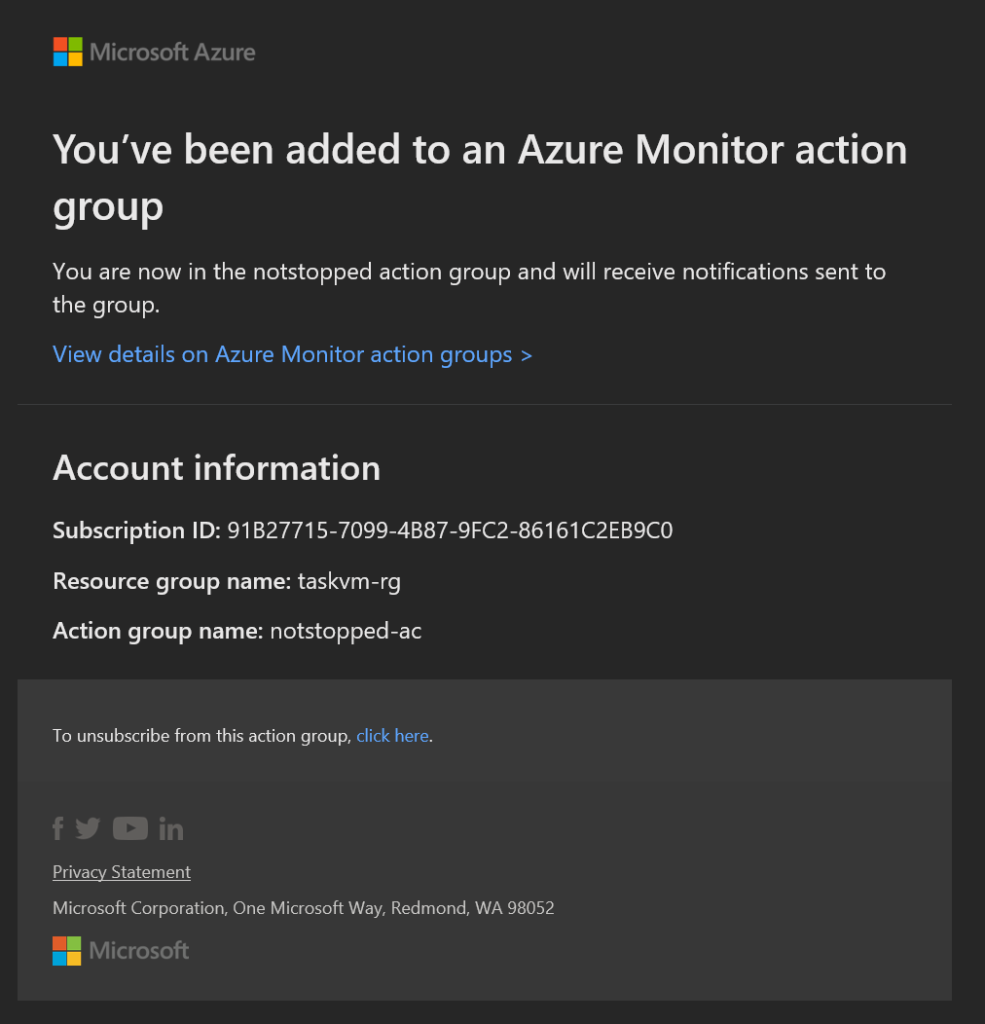

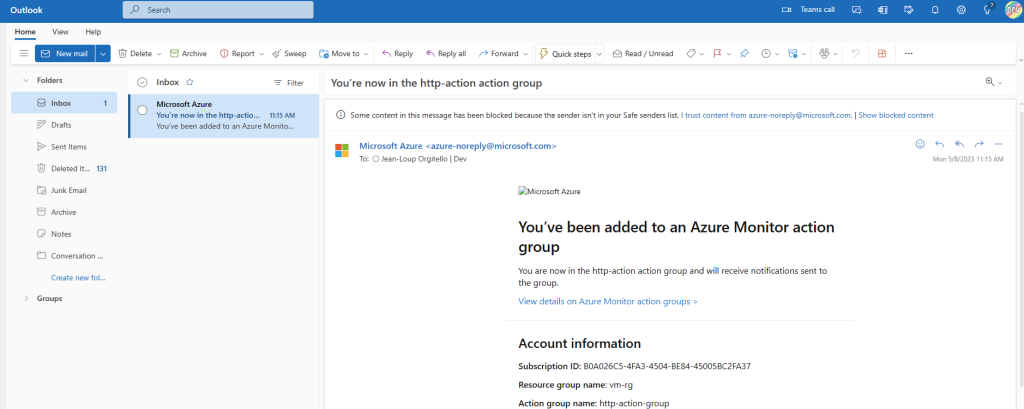

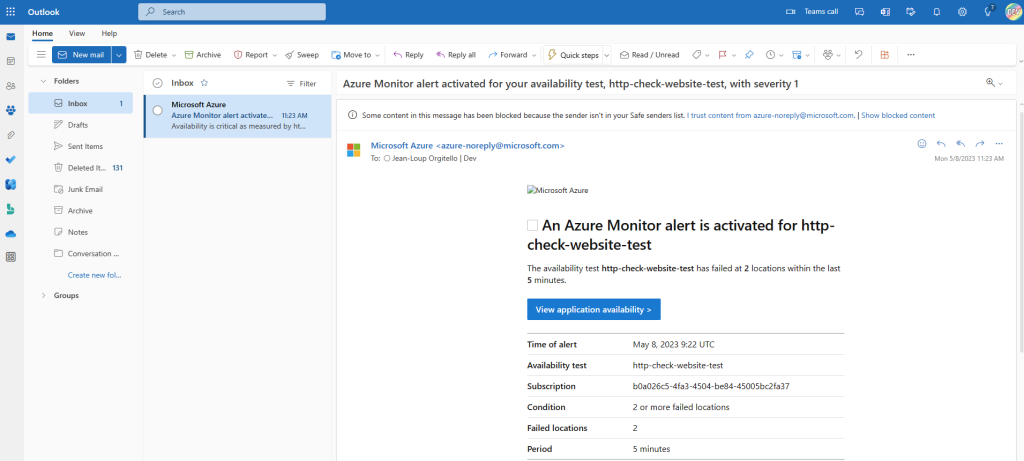

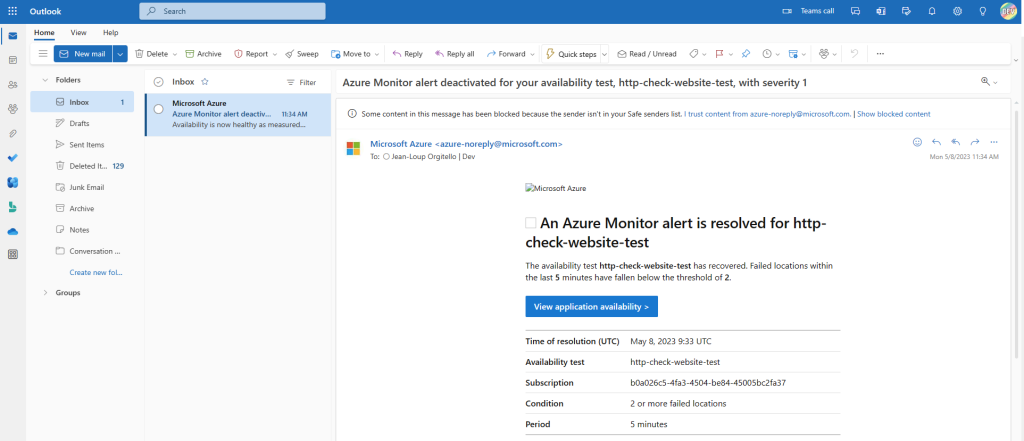

La création d’une alerte Azure entraine l’envoi immédiat d’un premier email informant la mise en place de celle-ci aux destinataires présents dans le groupe d’actions associé :

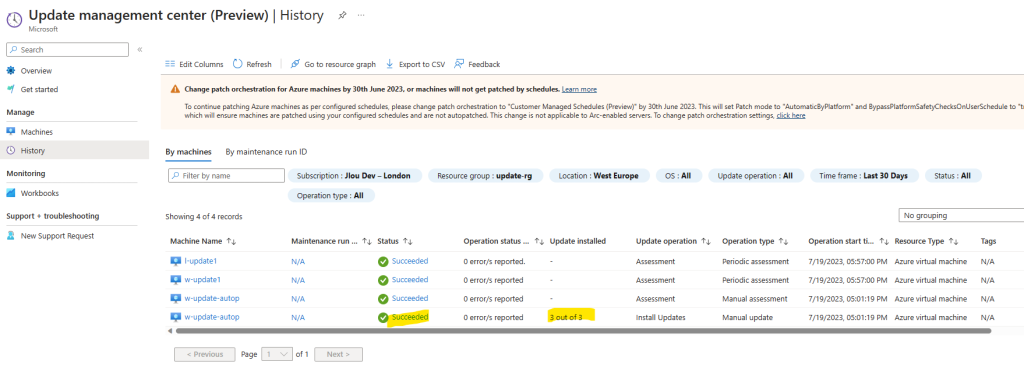

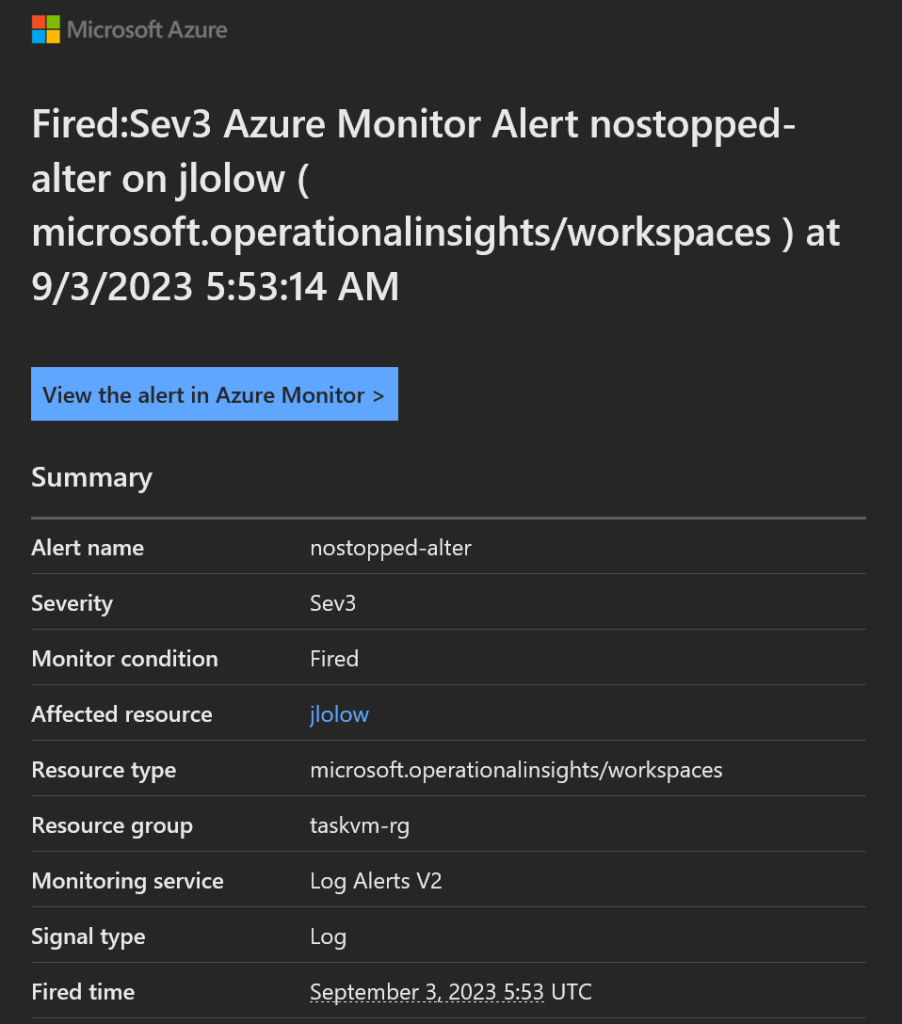

Comme notre alerte Azure est configurée par intervalle d’analyse de 24 heures, j’ai attendu quelques peu avant de recevoir le second email suivant :

Le contenu du second email nous indique bien que la tâche planifiée sur notre machine Windows n’a pas été exécutée durant la période donnée :

En effet, l’exécution de la tâche planifiée est journalisée dans Windows, lui-même connecté à notre Log Analytics workspace. La valeur à zéro de la requête KQL indique donc l’absence de lancement, et correspond surtout le seuil d’alerte configuré.

Conclusion

Ce petit exercice nous a montré le véritable potentiel des règles d’alerte d’Azure Monitor, et l’intérêt de stocker les évènements et les métriques de nos ressources Cloud ou sur site.

Afin d’aller plus loin sur ce sujet, je ne peux que vous conseiller de regarder cette autre vidéo, dédiée aux Règles de traitement des alertes :